+

همان طور که در [فصل اول](/course/chapter1) دیدید، مدلهای ترنسفورمر معمولا بسیار بزرگ هستند. با داشتن میلیونها یا حتی دهها میلیارد پارامتر، تعلیم و بکارگیری این مدلها کار بسیار پیچیدهای است. علاوه بر این، تقریبا هر روز مدلهای جدیدی عرضه میشوند که هرکدام شیوه پیادهسازی خود را دارند و امتحان کردن تمام آنها کار آسانی نیست.

کتابخانه ترنسفومرهای هاگینگفِیس برای حل این مشکل تولید شده است. هدف آن، ارائه یک API واحد برای بارگذاری، تعلیم و ذخیرهسازی مدلهای ترنسفورمر است. ویژگی های اصلی این کتابخانه از این قرار است:

diff --git a/chapters/fa/chapter2/2.mdx b/chapters/fa/chapter2/2.mdx

index 71abc5e16..9ae1d64e2 100644

--- a/chapters/fa/chapter2/2.mdx

+++ b/chapters/fa/chapter2/2.mdx

@@ -5,18 +5,18 @@

{#if fw === 'pt'}

-

diff --git a/chapters/fa/chapter2/3.mdx b/chapters/fa/chapter2/3.mdx

index 0155c5634..eace2dc12 100644

--- a/chapters/fa/chapter2/3.mdx

+++ b/chapters/fa/chapter2/3.mdx

@@ -5,18 +5,18 @@

{#if fw === 'pt'}

-

diff --git a/chapters/fa/chapter3/1.mdx b/chapters/fa/chapter3/1.mdx

index b3f520423..cf96cdbf8 100644

--- a/chapters/fa/chapter3/1.mdx

+++ b/chapters/fa/chapter3/1.mdx

@@ -4,6 +4,11 @@

# مقدمه

+

+

در [فصل ۲](/course/chapter2) نحوه استفاده از توکِنایزرها و مدلهای از پیش تعلیم دیده را جهت انجام پیشبینیهای جدید بررسی کردیم. اما چگونه میتوانید یک مدل از پیش تعلیم دیده را خودتان کوک کنید؟

{#if fw === 'pt'}

diff --git a/chapters/fa/chapter3/2.mdx b/chapters/fa/chapter3/2.mdx

index 092a92b30..deabbc5f0 100644

--- a/chapters/fa/chapter3/2.mdx

+++ b/chapters/fa/chapter3/2.mdx

@@ -6,18 +6,18 @@

{#if fw === 'pt'}

-

diff --git a/chapters/fa/chapter4/1.mdx b/chapters/fa/chapter4/1.mdx

index b071b63df..7f6995ac0 100644

--- a/chapters/fa/chapter4/1.mdx

+++ b/chapters/fa/chapter4/1.mdx

@@ -1,6 +1,11 @@

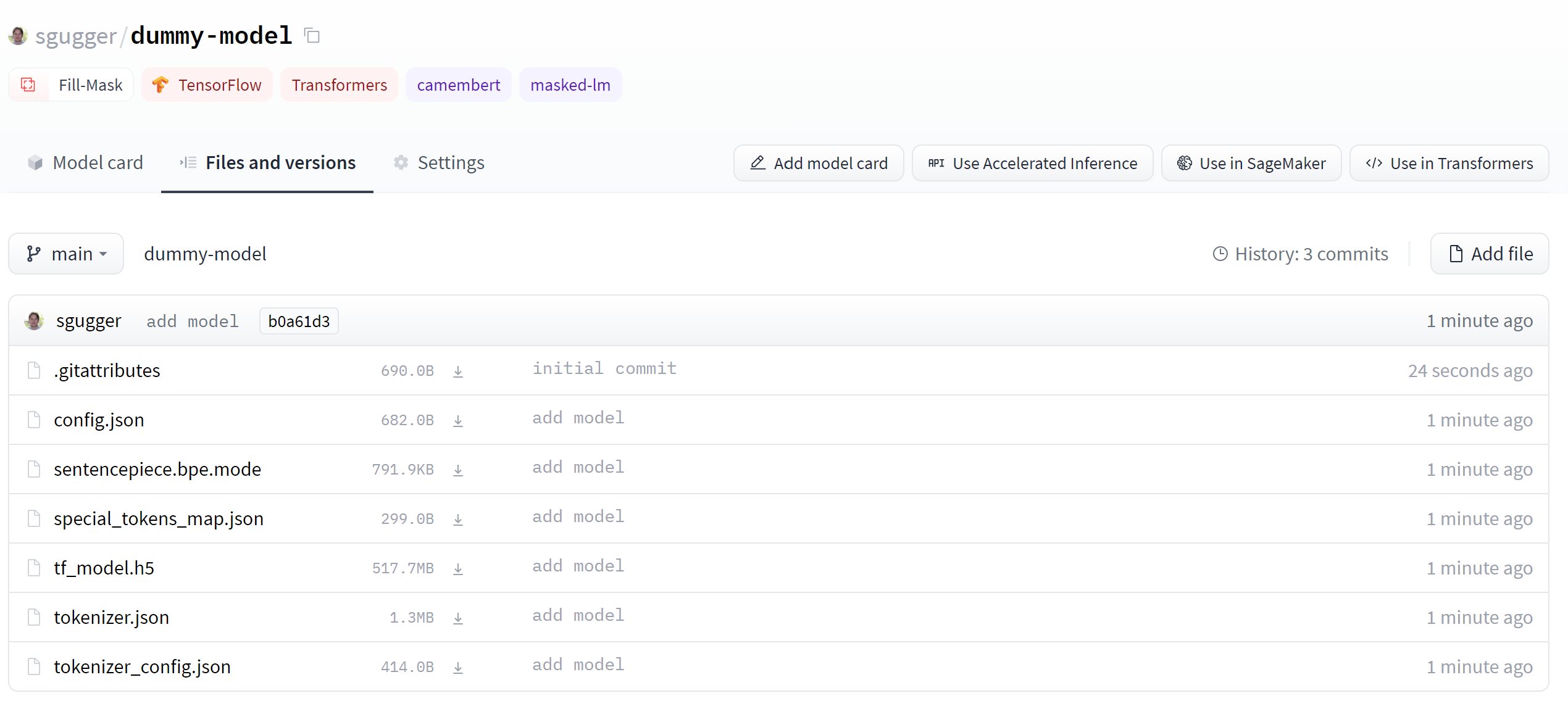

# هاب هاگینگفِیس

+

+

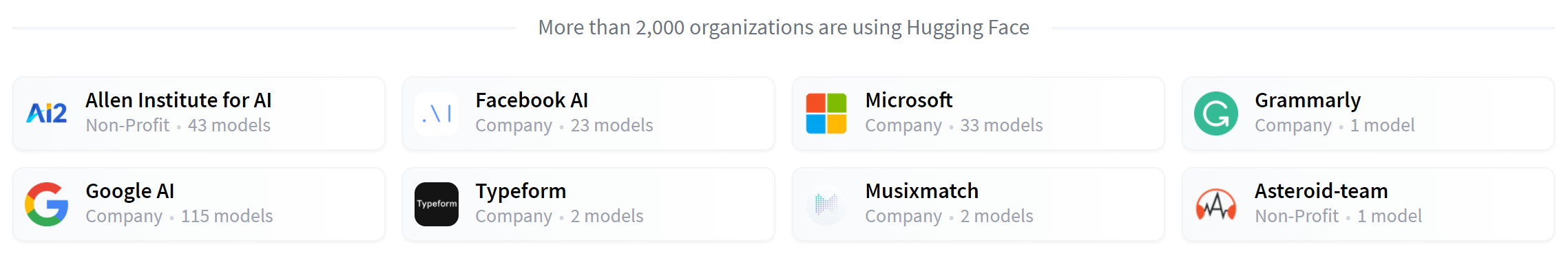

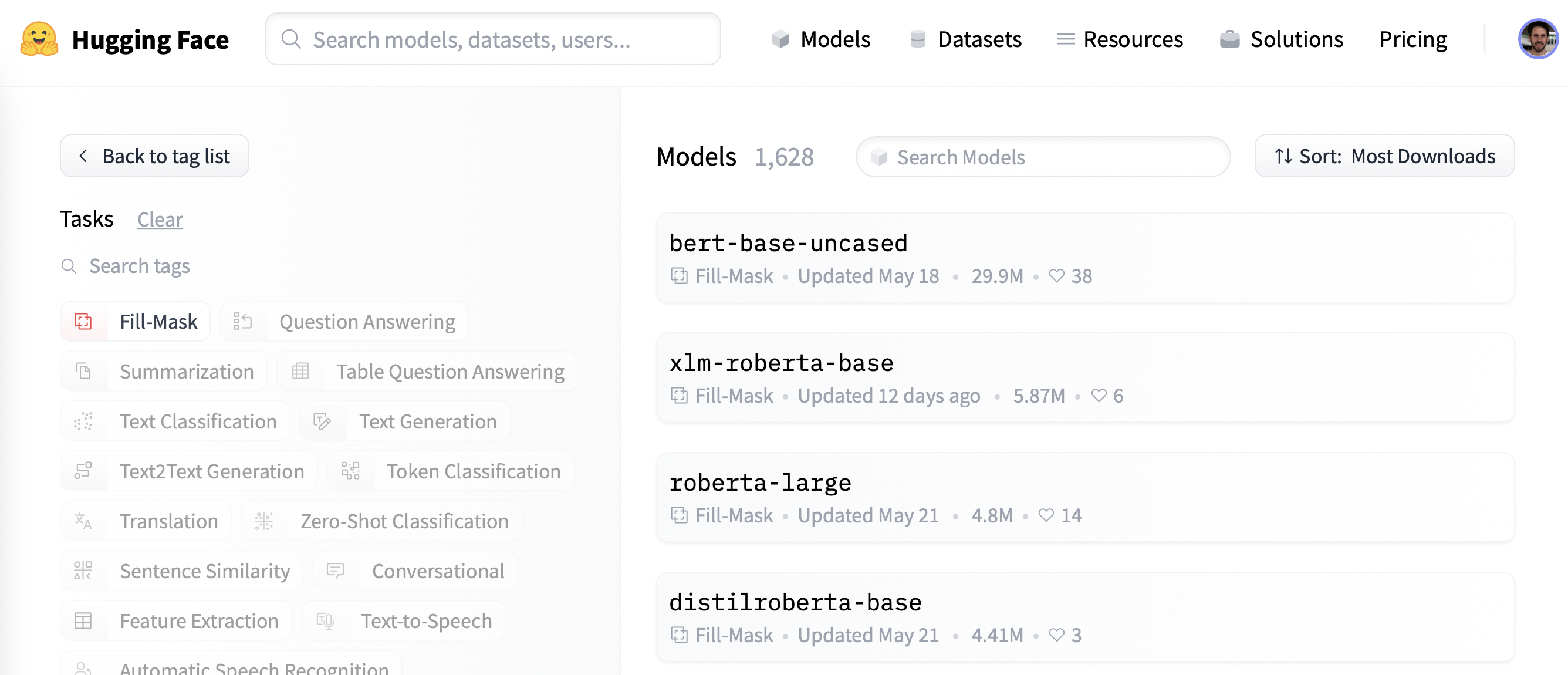

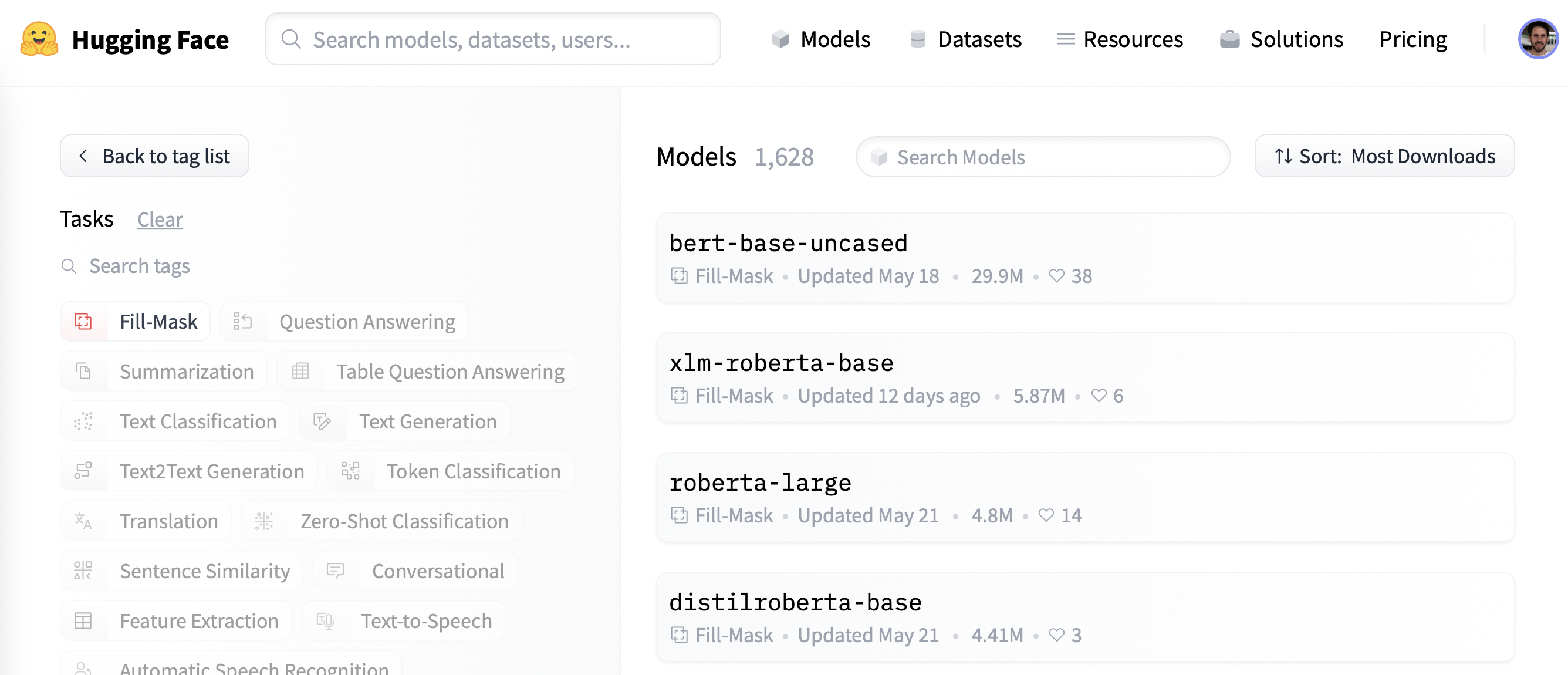

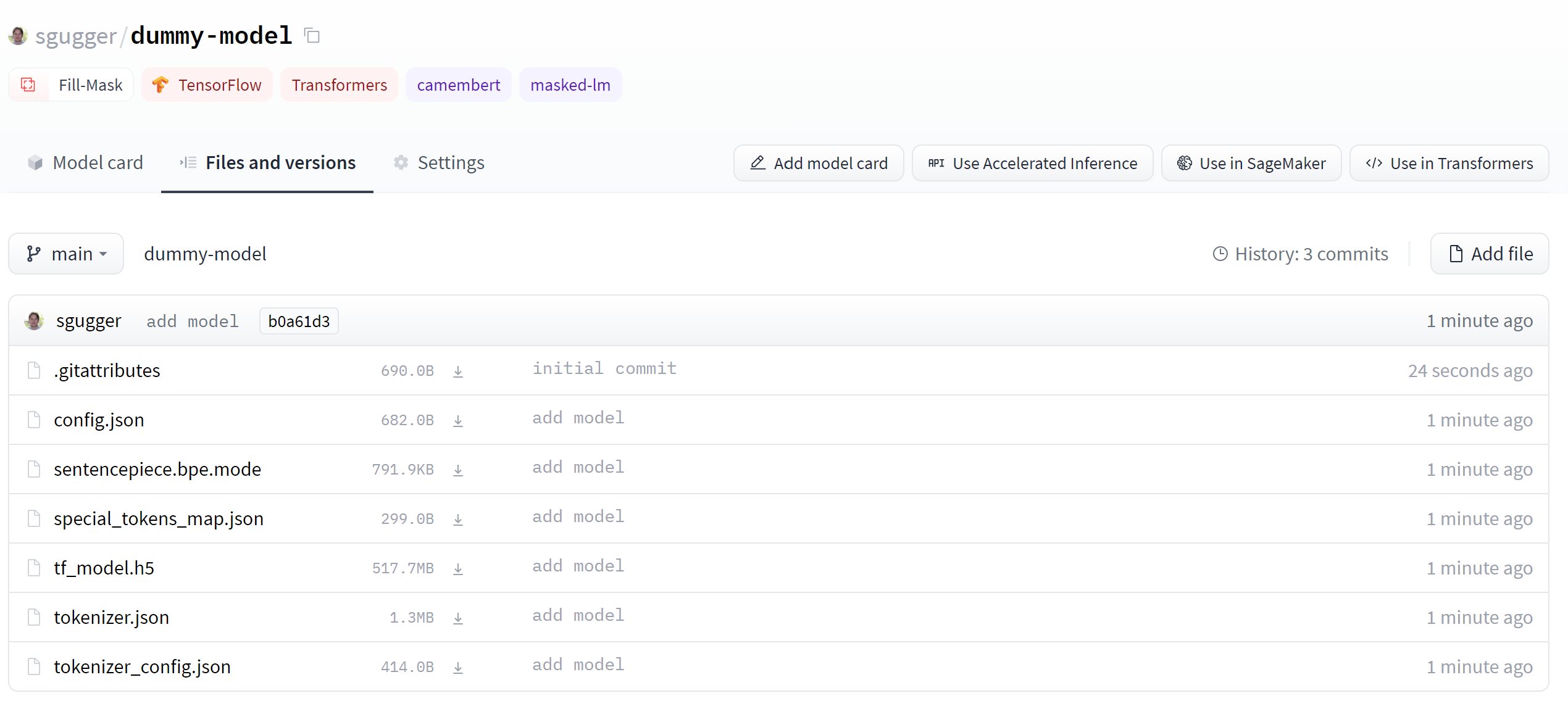

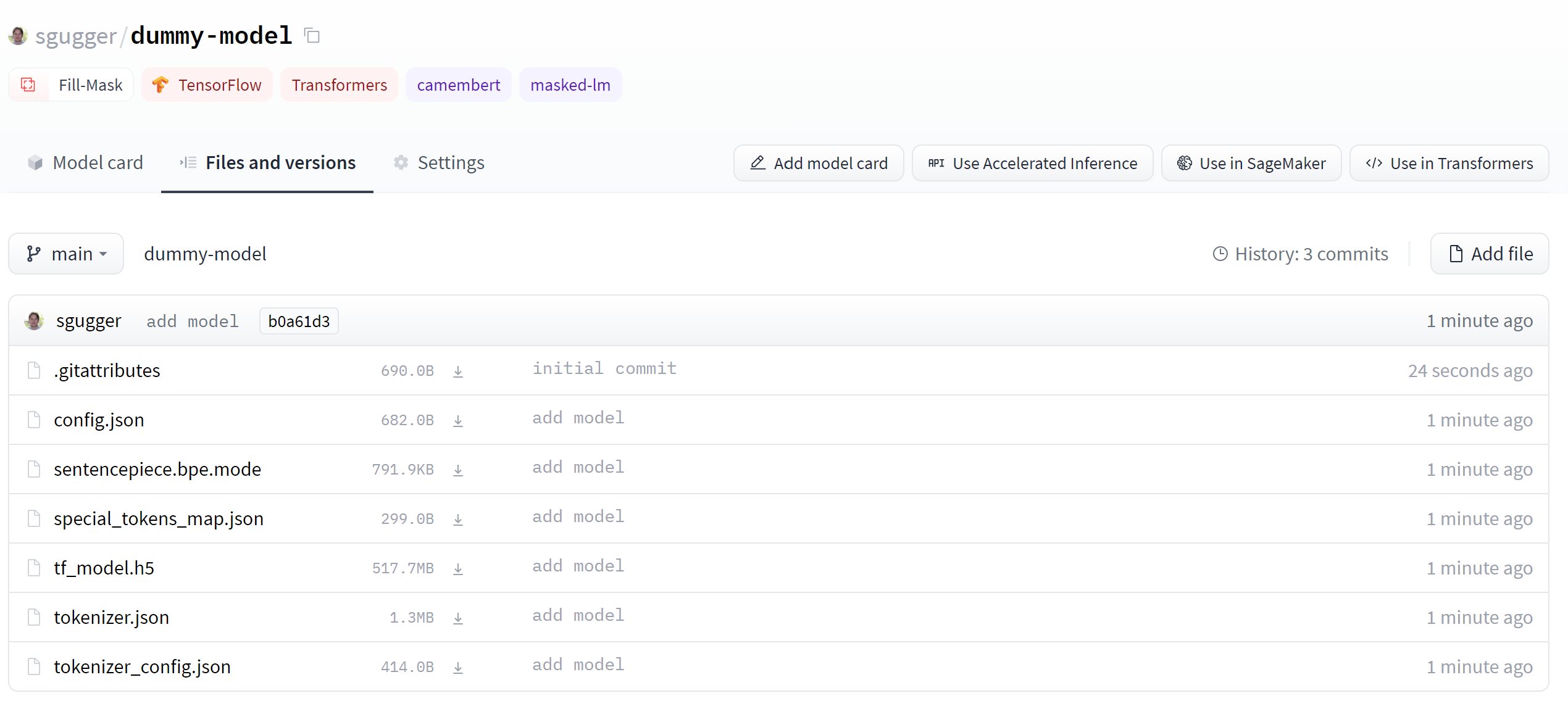

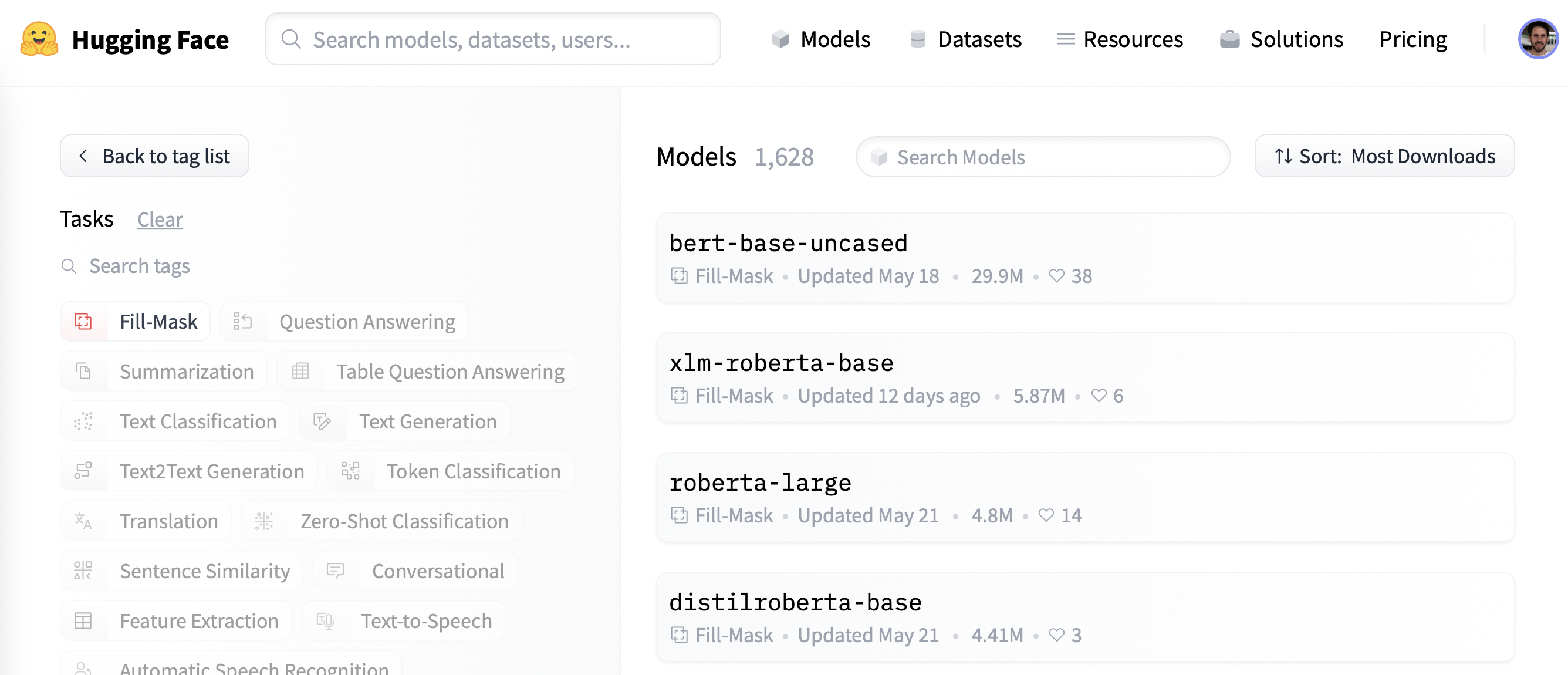

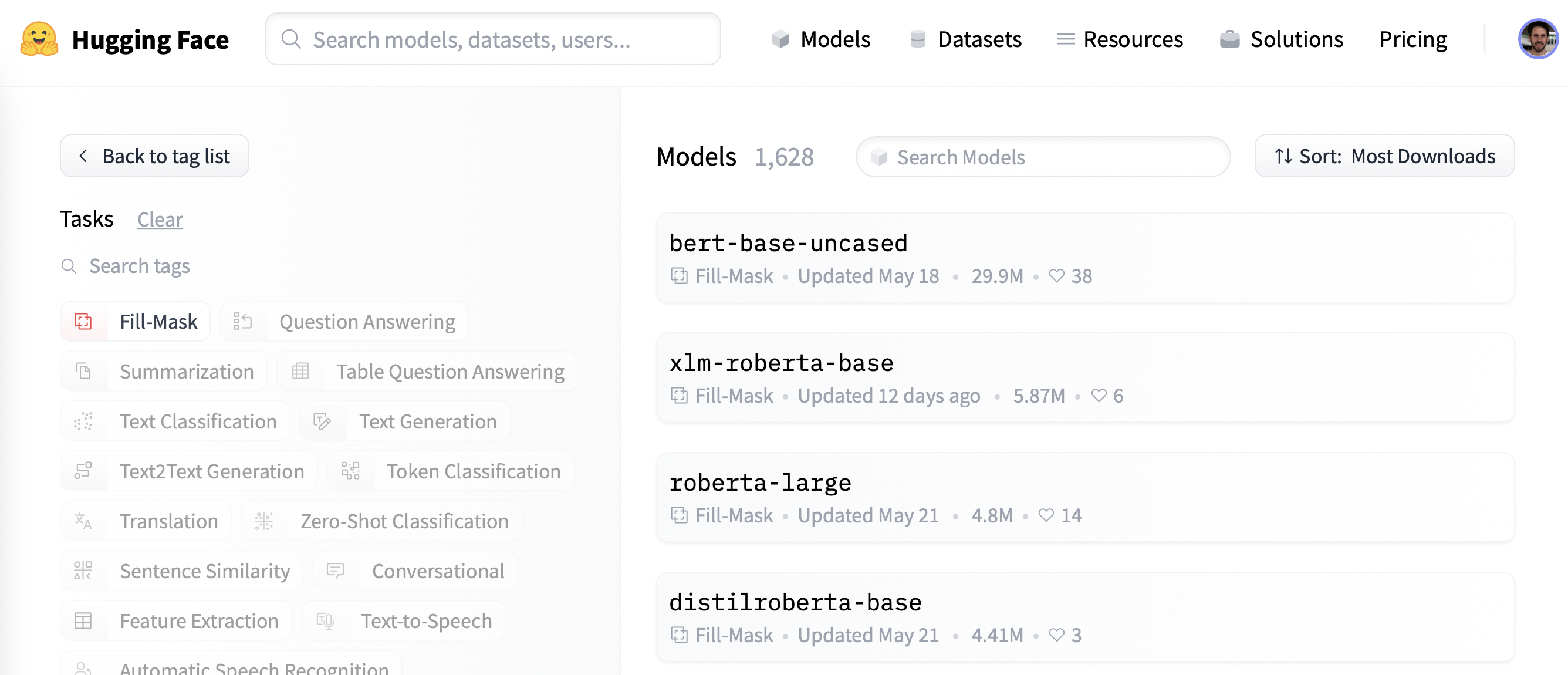

[هاب هاگینگفِیس](https://huggingface.co/) –- وبسایت اصلی ما –- پلتفرمی مرکزی است که به همه امکان مشارکت، کشف و استفاده از جدیدترین و بهترین مدلها و دیتاسِتها را میدهد. این هاب طیف گستردهای از مدلها را در خود جای داده، که بالغ بر ۱۰ هزار مورد از آنها در دسترس عموم قرار دارد. در این فصل بر روی مدلها متمرکز شده و در فصل ۵ نیز نگاهی به دیتاسِتها خواهیم داشت.

مدلهای موجود در هاب، محدود به ترنسفورمرهای هاگینگفِیس یا حتی NLP نیستند. از جمله آنها میتوان مدلهایی از قبیل [Flair](https://github.com/flairNLP/flair) و [AllenNLP](https://github.com/allenai/allennlp) برای پردازش زبان طبیعی، [Asteroid](https://github.com/asteroid-team/asteroid) و [pyannote](https://github.com/pyannote/pyannote-audio) برای پردازش گفتار، و [timm](https://github.com/rwightman/pytorch-image-models) را برای پردازش تصویر برشمرد.

diff --git a/chapters/fa/chapter4/2.mdx b/chapters/fa/chapter4/2.mdx

index 01960357d..2514c1849 100644

--- a/chapters/fa/chapter4/2.mdx

+++ b/chapters/fa/chapter4/2.mdx

@@ -5,18 +5,18 @@

{#if fw === 'pt'}

-

{:else}

-

diff --git a/chapters/fr/chapter1/1.mdx b/chapters/fr/chapter1/1.mdx

index a0ff68898..6dd1423c5 100644

--- a/chapters/fr/chapter1/1.mdx

+++ b/chapters/fr/chapter1/1.mdx

@@ -1,55 +1,60 @@

-# Introduction

-

-## Bienvenue au cours 🤗 !

-

-

-

-Ce cours vous apprendra à utiliser les bibliothèques de NLP de l'écosystème [Hugging Face](https://huggingface.co/) : [🤗 *Transformers*](https://github.com/huggingface/transformers), [🤗 *Datasets*](https://github.com/huggingface/datasets), [🤗 *Tokenizers*](https://github.com/huggingface/tokenizers) et [🤗 *Accelerate*](https://github.com/huggingface/accelerate), ainsi que le [*Hub*](https://huggingface.co/models). C'est totalement gratuit et sans publicité.

-

-## À quoi s'attendre ?

-

-Voici un bref aperçu du cours :

-

-

-

-

-

-

-- Les chapitres 1 à 4 présentent les principaux concepts de la bibliothèque 🤗 *Transformers*. À la fin de ce chapitre, vous serez familier avec le fonctionnement des *transformers* et vous saurez comment utiliser un modèle présent sur le [*Hub*](https://huggingface.co/models), le *finetuner* sur un jeu de données, et partager vos résultats sur le *Hub* !

-- Les chapitres 5 à 8 présentent les bases des librairies 🤗 *Datasets* et 🤗 *Tokenizers* ainsi qu'une découverte des problèmes classiques de NLP. À la fin de ce chapitre, vous serez capable de résoudre les problèmes de NLP les plus communs par vous-même.

-- Les chapitres 9 à 12 proposent d'aller plus loin et d'explorer comment les *transformers* peuvent être utilisés pour résoudre des problèmes de traitement de la parole et de vision par ordinateur. En suivant ces chapitres, vous apprendrez à construire et à partager vos modèles via des démonstrateurs, et vous serez capable d'optimiser ces modèles pour des environnements de production. Enfin, vous serez prêt à appliquer 🤗 *Transformers* à (presque) n'importe quel problème d'apprentissage automatique !

-

-Ce cours :

-

-* requiert un bon niveau en Python,

-* se comprend mieux si vous avez déjà suivi un cours d'introduction à l'apprentissage profond comme [fast.ai's](https://www.fast.ai/), [*Practical Deep Learning for Coders*](https://course.fast.ai/) ou un des cours développés par [*DeepLearning.AI*](https://www.deeplearning.ai/),

-* n'attend pas une connaissance appronfondie de [PyTorch](https://pytorch.org/) ou de [TensorFlow](https://www.tensorflow.org/), bien qu'être familiarisé avec l'un d'entre eux peut aider.

-

-Après avoir terminé ce cours, nous vous recommandons de suivre la [Spécialisation en NLP](https://www.coursera.org/specializations/natural-language-processing?utm_source=deeplearning-ai&utm_medium=institutions&utm_campaign=20211011-nlp-2-hugging_face-page-nlp-refresh) dispensée par DeepLearning.AI, qui couvre une grande partie des modèles traditionnels de NLP comme le Bayésien naïf et les LSTMs qui sont importants à connaître!

-

-## Qui sommes-nous ?

-

-À propos des auteurs de ce cours :

-

-*Abubakar Abid** a obtenu son doctorat à Stanford en apprentissage automatique appliqué. Pendant son doctorat, il a fondé [Gradio](https://github.com/gradio-app/gradio), une bibliothèque Python open-source qui a été utilisée pour construire plus de 600 000 démos d'apprentissage automatique. Gradio a été rachetée par Hugging Face, où Abubakar occupe désormais le poste de responsable de l'équipe d'apprentissage automatique.

-

-**Matthew Carrigan** est ingénieur en apprentissage machine chez Hugging Face. Il vit à Dublin en Irlande. Il a travaillé auparavant comme ingénieur en apprentissage machine chez Parse.ly et avant cela comme chercheur postdoctoral au Trinity College Dublin. Il ne croit pas que nous arrivions à l'*AGI* en mettant à l'échelle les architectures existantes mais a tout de même beaucoup d'espoir dans l'immortalité des robots.

-

-**Lysandre Debut** est ingénieur en apprentissage machine chez Hugging Face et a travaillé sur la bibliothèque 🤗 *Transformers* depuis les premières phases de développement. Son but est de rendre le NLP accessible à tous en développant des outils disposant d'une API très simple.

-

-**Sylvain Gugger** est ingénieur recherche chez Hugging Face et un des principaux responsables de la bibliothèque 🤗 *Transformers*. Avant cela, il était chercheur en en apprentissage machine chez fast.ai et a écrit le livre [*Deep Learning for Coders with fastai and PyTorch*](https://learning.oreilly.com/library/view/deep-learning-for/9781492045519/) avec Jeremy Howard. Son but est de rendre l'apprentissage profond plus accessible, en développant et en améliorant des techniques permettant aux modèles d'apprendre rapidement sur des ressources limitées.

-

-**Dawood Khan** est un ingénieur en apprentissage automatique chez Hugging Face. Il vient de New York et est diplômé de l'Université de New York en informatique. Après avoir travaillé comme ingénieur iOS pendant quelques années, Dawood a quitté son poste pour créer Gradio avec ses cofondateurs. Gradio a finalement été acquis par Hugging Face.

-

-**Merve Noyan** est développeuse *advocate* chez Hugging Face et travaille à la création d'outils et de contenus visant à démocratiser l'apprentissage machine pour tous.

-

-**Lucile Saulnier** est ingénieure en apprentissage machine chez Hugging Face et travaille au développement et à l'implémentation de nombreux outils *open source*. Elle est également activement impliquée dans de nombreux projets de recherche dans le domaine du NLP comme l'entraînement collaboratif de modèles et le projet BigScience.

-

-**Lewis Tunstall** est ingénieur en apprentissage machine chez Hugging Face et dévoué au développement d'outils open source avec la volonté de les rendre accessibles à une communauté plus large. Il est également co-auteur du livre [*Natural Language Processing with Transformers*](https://www.oreilly.com/library/view/natural-language-processing/9781098103231/).

-

-**Leandro von Werra** est ingénieur en apprentissage machine dans l'équipe *open source* d'Hugging Face et également co-auteur du livre [*Natural Language Processing with Transformers*](https://www.oreilly.com/library/view/natural-language-processing/9781098103231/). Il a plusieurs années d'expérience dans l'industrie où il a pu déployer des projets de NLP en production et travailler sur toutes les étapes clefs du déploiement.

-

-Êtes-vous prêt à commencer ? Dans ce chapitre, vous apprendrez :

-* à utiliser la fonction `pipeline()` pour résoudre des problèmes de NLP comme la génération de texte et la classification,

-* l'architecture d'un *transformer*,

-* comment faire la distinction entre les différentes architectures d'encodeur, de décodeur et d'encodeur-décodeur ainsi que leurs différents cas d'usage.

+# Introduction

+

+

+

+## Bienvenue au cours 🤗 !

+

+

+

+Ce cours vous apprendra à utiliser les bibliothèques de NLP de l'écosystème [Hugging Face](https://huggingface.co/) : [🤗 *Transformers*](https://github.com/huggingface/transformers), [🤗 *Datasets*](https://github.com/huggingface/datasets), [🤗 *Tokenizers*](https://github.com/huggingface/tokenizers) et [🤗 *Accelerate*](https://github.com/huggingface/accelerate), ainsi que le [*Hub*](https://huggingface.co/models). C'est totalement gratuit et sans publicité.

+

+## À quoi s'attendre ?

+

+Voici un bref aperçu du cours :

+

+

+

+

+

+

+- Les chapitres 1 à 4 présentent les principaux concepts de la bibliothèque 🤗 *Transformers*. À la fin de ce chapitre, vous serez familier avec le fonctionnement des *transformers* et vous saurez comment utiliser un modèle présent sur le [*Hub*](https://huggingface.co/models), le *finetuner* sur un jeu de données, et partager vos résultats sur le *Hub* !

+- Les chapitres 5 à 8 présentent les bases des librairies 🤗 *Datasets* et 🤗 *Tokenizers* ainsi qu'une découverte des problèmes classiques de NLP. À la fin de ce chapitre, vous serez capable de résoudre les problèmes de NLP les plus communs par vous-même.

+- Les chapitres 9 à 12 proposent d'aller plus loin et d'explorer comment les *transformers* peuvent être utilisés pour résoudre des problèmes de traitement de la parole et de vision par ordinateur. En suivant ces chapitres, vous apprendrez à construire et à partager vos modèles via des démonstrateurs, et vous serez capable d'optimiser ces modèles pour des environnements de production. Enfin, vous serez prêt à appliquer 🤗 *Transformers* à (presque) n'importe quel problème d'apprentissage automatique !

+

+Ce cours :

+

+* requiert un bon niveau en Python,

+* se comprend mieux si vous avez déjà suivi un cours d'introduction à l'apprentissage profond comme [fast.ai's](https://www.fast.ai/), [*Practical Deep Learning for Coders*](https://course.fast.ai/) ou un des cours développés par [*DeepLearning.AI*](https://www.deeplearning.ai/),

+* n'attend pas une connaissance appronfondie de [PyTorch](https://pytorch.org/) ou de [TensorFlow](https://www.tensorflow.org/), bien qu'être familiarisé avec l'un d'entre eux peut aider.

+

+Après avoir terminé ce cours, nous vous recommandons de suivre la [Spécialisation en NLP](https://www.coursera.org/specializations/natural-language-processing?utm_source=deeplearning-ai&utm_medium=institutions&utm_campaign=20211011-nlp-2-hugging_face-page-nlp-refresh) dispensée par DeepLearning.AI, qui couvre une grande partie des modèles traditionnels de NLP comme le Bayésien naïf et les LSTMs qui sont importants à connaître!

+

+## Qui sommes-nous ?

+

+À propos des auteurs de ce cours :

+

+*Abubakar Abid** a obtenu son doctorat à Stanford en apprentissage automatique appliqué. Pendant son doctorat, il a fondé [Gradio](https://github.com/gradio-app/gradio), une bibliothèque Python open-source qui a été utilisée pour construire plus de 600 000 démos d'apprentissage automatique. Gradio a été rachetée par Hugging Face, où Abubakar occupe désormais le poste de responsable de l'équipe d'apprentissage automatique.

+

+**Matthew Carrigan** est ingénieur en apprentissage machine chez Hugging Face. Il vit à Dublin en Irlande. Il a travaillé auparavant comme ingénieur en apprentissage machine chez Parse.ly et avant cela comme chercheur postdoctoral au Trinity College Dublin. Il ne croit pas que nous arrivions à l'*AGI* en mettant à l'échelle les architectures existantes mais a tout de même beaucoup d'espoir dans l'immortalité des robots.

+

+**Lysandre Debut** est ingénieur en apprentissage machine chez Hugging Face et a travaillé sur la bibliothèque 🤗 *Transformers* depuis les premières phases de développement. Son but est de rendre le NLP accessible à tous en développant des outils disposant d'une API très simple.

+

+**Sylvain Gugger** est ingénieur recherche chez Hugging Face et un des principaux responsables de la bibliothèque 🤗 *Transformers*. Avant cela, il était chercheur en en apprentissage machine chez fast.ai et a écrit le livre [*Deep Learning for Coders with fastai and PyTorch*](https://learning.oreilly.com/library/view/deep-learning-for/9781492045519/) avec Jeremy Howard. Son but est de rendre l'apprentissage profond plus accessible, en développant et en améliorant des techniques permettant aux modèles d'apprendre rapidement sur des ressources limitées.

+

+**Dawood Khan** est un ingénieur en apprentissage automatique chez Hugging Face. Il vient de New York et est diplômé de l'Université de New York en informatique. Après avoir travaillé comme ingénieur iOS pendant quelques années, Dawood a quitté son poste pour créer Gradio avec ses cofondateurs. Gradio a finalement été acquis par Hugging Face.

+

+**Merve Noyan** est développeuse *advocate* chez Hugging Face et travaille à la création d'outils et de contenus visant à démocratiser l'apprentissage machine pour tous.

+

+**Lucile Saulnier** est ingénieure en apprentissage machine chez Hugging Face et travaille au développement et à l'implémentation de nombreux outils *open source*. Elle est également activement impliquée dans de nombreux projets de recherche dans le domaine du NLP comme l'entraînement collaboratif de modèles et le projet BigScience.

+

+**Lewis Tunstall** est ingénieur en apprentissage machine chez Hugging Face et dévoué au développement d'outils open source avec la volonté de les rendre accessibles à une communauté plus large. Il est également co-auteur du livre [*Natural Language Processing with Transformers*](https://www.oreilly.com/library/view/natural-language-processing/9781098103231/).

+

+**Leandro von Werra** est ingénieur en apprentissage machine dans l'équipe *open source* d'Hugging Face et également co-auteur du livre [*Natural Language Processing with Transformers*](https://www.oreilly.com/library/view/natural-language-processing/9781098103231/). Il a plusieurs années d'expérience dans l'industrie où il a pu déployer des projets de NLP en production et travailler sur toutes les étapes clefs du déploiement.

+

+Êtes-vous prêt à commencer ? Dans ce chapitre, vous apprendrez :

+* à utiliser la fonction `pipeline()` pour résoudre des problèmes de NLP comme la génération de texte et la classification,

+* l'architecture d'un *transformer*,

+* comment faire la distinction entre les différentes architectures d'encodeur, de décodeur et d'encodeur-décodeur ainsi que leurs différents cas d'usage.

diff --git a/chapters/fr/chapter1/10.mdx b/chapters/fr/chapter1/10.mdx

index d48d06003..889612715 100644

--- a/chapters/fr/chapter1/10.mdx

+++ b/chapters/fr/chapter1/10.mdx

@@ -1,258 +1,263 @@

-

-

-# Quiz de fin de chapitre

-

-Ce chapitre a couvert un grand nombre de notions ! Ne vous inquiétez pas si vous n'avez pas compris tous les détails, les chapitres suivants vous aideront à comprendre comment les choses fonctionnent concrètement.

-

-Mais avant d'aller plus loin, prenons un instant pour voir ce que vous avez appris dans ce chapitre !

-

-

-### 1. Explorez le *Hub* et cherchez le modèle `roberta-large-mnli`. Quelle tâche accomplit-il ?

-

-

-

page roberta-large-mnli."

- },

- {

- text: "Classification de texte",

- explain: "Pour être plus précis, il classifie si deux phrases sont logiquement liées entre elles parmis trois possibilités (contradiction, neutre, lien). Il s'agit d'une tâche aussi appelée inference de langage naturel.",

- correct: true

- },

- {

- text: "Génération de texte",

- explain: "Regardez à nouveau sur la page roberta-large-mnli."

- }

- ]}

-/>

-

-### 2. Que renvoie le code suivant ?

-

-```py

-from transformers import pipeline

-

-ner = pipeline("ner", grouped_entities=True)

-ner(

- "My name is Sylvain and I work at Hugging Face in Brooklyn."

-) # Je m'appelle Sylvain et je travaille à Hugging Face à Brooklyn.

-```

-

-d'analyse de sentiment (sentiment-analysis dans la documentation d'Hugging-Face)."

- },

- {

- text: "Il renvoie un texte généré qui complète cette phrase.",

- explain: "Cela correspondrait au pipeline de génération de texte (text-generation dans la documentation d'Hugging-Face)."

- },

- {

- text: "Il renvoie les entités nommées dans cette phrase, telles que les personnes, les organisations ou lieux.",

- explain: "De plus, avec grouped_entities=True, cela regroupe les mots appartenant à la même entité, comme par exemple \"Hugging Face\".",

- correct: true

- }

- ]}

-/>

-

-### 3. Que remplace « ... » dans ce code ?

-

-```py

-from transformers import pipeline

-

-filler = pipeline("fill-mask", model="bert-base-cased")

-result = filler("...")

-```

-

- has been waiting for you. # Ce <mask> vous attend.",

- explain: "Regardez la description du modèle bert-base-cased et essayez de trouver votre erreur."

- },

- {

- text: "This [MASK] has been waiting for you. # Ce [MASK] vous attend.",

- explain: "Le modèle utilise [MASK] comme mot-masque.",

- correct: true

- },

- {

- text: "This man has been waiting for you. # Cet homme vous attend.",

- explain: "Ce pipeline permet de remplacer les mot manquants donc il a besoin d'un mot-masque."

- }

- ]}

-/>

-

-### 4. Pourquoi ce code ne fonctionne-t-il pas ?

-

-```py

-from transformers import pipeline

-

-classifier = pipeline("zero-shot-classification")

-result = classifier(

- "This is a course about the Transformers library"

-) # C'est un cours sur la bibliothèque Transformers

-```

-

-candidate_labels=[...].",

- correct: true

- },

- {

- text: "Ce pipeline nécessite que des phrases soient données, pas juste une phrase.",

- explain: "Bien que ce pipeline puisse prendre une liste de phrases à traiter (comme tous les autres pipelines)."

- },

- {

- text: "La bibliothèque 🤗 Transformers est cassée, comme d'habitude.",

- explain: "Nous n'avons aucun commentaire pour cette réponse !",

- },

- {

- text: "Ce pipeline nécessite des phrases plus longues, celle-ci est trop courte.",

- explain: "Notez que si un texte est très long, il est tronqué par le pipeline."

- }

- ]}

-/>

-

-### 5. Que signifie « apprentissage par transfert » ?

-

-

-

-### 6. Vrai ou faux ? Un modèle de langage n'a généralement pas besoin d'étiquettes pour son pré-entraînement.

-

-

-autosupervisé, ce qui signifie que les étiquettes sont créées automatiquement à partir des données d'entrée (comme prédire le mot suivant ou remplacer des mots masqués).",

- correct: true

- },

- {

- text: "Faux",

- explain: "Ce n'est pas la bonne réponse."

- }

- ]}

-/>

-

-### 7. Sélectionnez la phrase qui décrit le mieux les termes « modèle », « architecture » et « poids ».

-

-

-

-

-### 8. Parmi ces types de modèles, quel est le plus approprié pour générer du texte à partir d'une instruction (*prompt*) ?

-

-

-

-### 9. Parmi ces types de modèles, quel est le plus approprié pour le résumé de texte ?

-

-

-

-### 10. Quel type de modèle utiliseriez-vous pour classifier des entrées de texte en fonction de certains labels ?

-

-

-

-### 11. De quelle source possible peut être le biais observé dans un modèle ?

-

-finetunée d'un modèle pré-entraîné et il a conservé ses biais.",

- explain: "Avec l'apprentissage par transfert, les biais du modèle pré-entraîné perdurent dans le modèle finetuné.",

- correct: true

- },

- {

- text: "Le modèle a été entraîné sur des données qui sont biaisées.",

- explain: "Ceci représente la source de biais la plus évidente mais n'est pas la seule possible.",

- correct: true

- },

- {

- text: "La métrique optimisée lors de l'entraînement du modèle est biaisée.",

- explain: "Une source moins évidente est la façon dont le modèle est entraîné. Votre modèle va de façon aveugle optimiser la métrique que vous avez sélectionnée, sans prendre aucun recul.",

- correct: true

- }

- ]}

-/>

+

+

+# Quiz de fin de chapitre

+

+

+

+Ce chapitre a couvert un grand nombre de notions ! Ne vous inquiétez pas si vous n'avez pas compris tous les détails, les chapitres suivants vous aideront à comprendre comment les choses fonctionnent concrètement.

+

+Mais avant d'aller plus loin, prenons un instant pour voir ce que vous avez appris dans ce chapitre !

+

+

+### 1. Explorez le *Hub* et cherchez le modèle `roberta-large-mnli`. Quelle tâche accomplit-il ?

+

+

+page roberta-large-mnli."

+ },

+ {

+ text: "Classification de texte",

+ explain: "Pour être plus précis, il classifie si deux phrases sont logiquement liées entre elles parmis trois possibilités (contradiction, neutre, lien). Il s'agit d'une tâche aussi appelée inference de langage naturel.",

+ correct: true

+ },

+ {

+ text: "Génération de texte",

+ explain: "Regardez à nouveau sur la page roberta-large-mnli."

+ }

+ ]}

+/>

+

+### 2. Que renvoie le code suivant ?

+

+```py

+from transformers import pipeline

+

+ner = pipeline("ner", grouped_entities=True)

+ner(

+ "My name is Sylvain and I work at Hugging Face in Brooklyn."

+) # Je m'appelle Sylvain et je travaille à Hugging Face à Brooklyn.

+```

+

+d'analyse de sentiment (sentiment-analysis dans la documentation d'Hugging-Face)."

+ },

+ {

+ text: "Il renvoie un texte généré qui complète cette phrase.",

+ explain: "Cela correspondrait au pipeline de génération de texte (text-generation dans la documentation d'Hugging-Face)."

+ },

+ {

+ text: "Il renvoie les entités nommées dans cette phrase, telles que les personnes, les organisations ou lieux.",

+ explain: "De plus, avec grouped_entities=True, cela regroupe les mots appartenant à la même entité, comme par exemple \"Hugging Face\".",

+ correct: true

+ }

+ ]}

+/>

+

+### 3. Que remplace « ... » dans ce code ?

+

+```py

+from transformers import pipeline

+

+filler = pipeline("fill-mask", model="bert-base-cased")

+result = filler("...")

+```

+

+ has been waiting for you. # Ce <mask> vous attend.",

+ explain: "Regardez la description du modèle bert-base-cased et essayez de trouver votre erreur."

+ },

+ {

+ text: "This [MASK] has been waiting for you. # Ce [MASK] vous attend.",

+ explain: "Le modèle utilise [MASK] comme mot-masque.",

+ correct: true

+ },

+ {

+ text: "This man has been waiting for you. # Cet homme vous attend.",

+ explain: "Ce pipeline permet de remplacer les mot manquants donc il a besoin d'un mot-masque."

+ }

+ ]}

+/>

+

+### 4. Pourquoi ce code ne fonctionne-t-il pas ?

+

+```py

+from transformers import pipeline

+

+classifier = pipeline("zero-shot-classification")

+result = classifier(

+ "This is a course about the Transformers library"

+) # C'est un cours sur la bibliothèque Transformers

+```

+

+candidate_labels=[...].",

+ correct: true

+ },

+ {

+ text: "Ce pipeline nécessite que des phrases soient données, pas juste une phrase.",

+ explain: "Bien que ce pipeline puisse prendre une liste de phrases à traiter (comme tous les autres pipelines)."

+ },

+ {

+ text: "La bibliothèque 🤗 Transformers est cassée, comme d'habitude.",

+ explain: "Nous n'avons aucun commentaire pour cette réponse !",

+ },

+ {

+ text: "Ce pipeline nécessite des phrases plus longues, celle-ci est trop courte.",

+ explain: "Notez que si un texte est très long, il est tronqué par le pipeline."

+ }

+ ]}

+/>

+

+### 5. Que signifie « apprentissage par transfert » ?

+

+

+

+### 6. Vrai ou faux ? Un modèle de langage n'a généralement pas besoin d'étiquettes pour son pré-entraînement.

+

+

+autosupervisé, ce qui signifie que les étiquettes sont créées automatiquement à partir des données d'entrée (comme prédire le mot suivant ou remplacer des mots masqués).",

+ correct: true

+ },

+ {

+ text: "Faux",

+ explain: "Ce n'est pas la bonne réponse."

+ }

+ ]}

+/>

+

+### 7. Sélectionnez la phrase qui décrit le mieux les termes « modèle », « architecture » et « poids ».

+

+

+

+

+### 8. Parmi ces types de modèles, quel est le plus approprié pour générer du texte à partir d'une instruction (*prompt*) ?

+

+

+

+### 9. Parmi ces types de modèles, quel est le plus approprié pour le résumé de texte ?

+

+

+

+### 10. Quel type de modèle utiliseriez-vous pour classifier des entrées de texte en fonction de certains labels ?

+

+

+

+### 11. De quelle source possible peut être le biais observé dans un modèle ?

+

+finetunée d'un modèle pré-entraîné et il a conservé ses biais.",

+ explain: "Avec l'apprentissage par transfert, les biais du modèle pré-entraîné perdurent dans le modèle finetuné.",

+ correct: true

+ },

+ {

+ text: "Le modèle a été entraîné sur des données qui sont biaisées.",

+ explain: "Ceci représente la source de biais la plus évidente mais n'est pas la seule possible.",

+ correct: true

+ },

+ {

+ text: "La métrique optimisée lors de l'entraînement du modèle est biaisée.",

+ explain: "Une source moins évidente est la façon dont le modèle est entraîné. Votre modèle va de façon aveugle optimiser la métrique que vous avez sélectionnée, sans prendre aucun recul.",

+ correct: true

+ }

+ ]}

+/>

diff --git a/chapters/fr/chapter1/2.mdx b/chapters/fr/chapter1/2.mdx

index ef5803d79..c3b8db6ac 100644

--- a/chapters/fr/chapter1/2.mdx

+++ b/chapters/fr/chapter1/2.mdx

@@ -1,21 +1,26 @@

-# Traitement du langage naturel (NLP pour Natural Language Processing)

-

-Avant de commencer avec les *transformers*, voyons succinctement ce qu'est le traitement du langage naturel et pourquoi il est important.

-

-## Le NLP, qu'est-ce que c'est ?

-

-Le traitement du langage naturel est un domaine de linguistique et d'apprentissage automatique se concentrant sur la compréhension de tout ce qui est lié à la langue humaine. L'objectif des tâches de NLP est non seulement de comprendre individuellement chaque mot, mais aussi de comprendre le contexte associé à l'utilisation de ces mots.

-

-La liste suivante regroupe les tâches de NLP les plus courantes, avec pour chacune quelques exemples :

-

-- **Classification de phrases entières** : analyser le sentiment d'un avis, détecter si un email est un spam, déterminer si une phrase est grammaticalement correcte, déterminer si deux phrases sont logiquement reliées ou non, etc.

-- **Classification de chaque mot d'une phrase** : identifier les composants grammaticaux d'une phrase (nom, verbe, adjectif), identifier les entités nommées (personne, lieu, organisation), etc.

-- **Génération de texte** : compléter le début d'un texte avec un texte généré automatiquement, remplacer les mots manquants ou masqués dans un texte, etc.

-- **Extraction d'une réponse à partir d'un texte** : étant donné une question et un contexte extraire la réponse à la question en fonction des informations fournies par le contexte, etc.

-- **Génération de nouvelles phrases à partir d'un texte** : traduire un texte dans une autre langue, faire le résumé d'un texte, etc.

-

-Le traitement du langage naturel ne se limite pas qu'à la compréhension du texte. Il s'intéresse aussi aux problèmes complexes de reconnaissance de la parole et de vision par ordinateur tels que la génération d'une transcription à partir d'un échantillon audio ou la description d'une image.

-

-## Pourquoi est-ce difficile ?

-

-Les ordinateurs ne traitent pas les informations de la même manière que les humains. Par exemple, lorsque nous lisons la phrase « j'ai faim », nous comprenons très facilement son sens. De même, lorsque nous lisons deux phrases telles que « j'ai faim » et « je suis triste », nous pouvons facilement déterminer s'il existe des similitudes entre elles. Pour les modèles d'apprentissage automatique, ces tâches sont plus difficiles. Le texte doit être traité de manière à permettre au modèle d'apprendre. Et parce que le langage est complexe, nous devons prendre soin de réfléchir à la meilleure façon de faire ce traitement. Il y a eu beaucoup de recherches sur la façon de représenter le texte et nous allons voir quelques-unes de ces méthodes dans le chapitre suivant.

+# Traitement du langage naturel (NLP pour Natural Language Processing)

+

+

+

+Avant de commencer avec les *transformers*, voyons succinctement ce qu'est le traitement du langage naturel et pourquoi il est important.

+

+## Le NLP, qu'est-ce que c'est ?

+

+Le traitement du langage naturel est un domaine de linguistique et d'apprentissage automatique se concentrant sur la compréhension de tout ce qui est lié à la langue humaine. L'objectif des tâches de NLP est non seulement de comprendre individuellement chaque mot, mais aussi de comprendre le contexte associé à l'utilisation de ces mots.

+

+La liste suivante regroupe les tâches de NLP les plus courantes, avec pour chacune quelques exemples :

+

+- **Classification de phrases entières** : analyser le sentiment d'un avis, détecter si un email est un spam, déterminer si une phrase est grammaticalement correcte, déterminer si deux phrases sont logiquement reliées ou non, etc.

+- **Classification de chaque mot d'une phrase** : identifier les composants grammaticaux d'une phrase (nom, verbe, adjectif), identifier les entités nommées (personne, lieu, organisation), etc.

+- **Génération de texte** : compléter le début d'un texte avec un texte généré automatiquement, remplacer les mots manquants ou masqués dans un texte, etc.

+- **Extraction d'une réponse à partir d'un texte** : étant donné une question et un contexte extraire la réponse à la question en fonction des informations fournies par le contexte, etc.

+- **Génération de nouvelles phrases à partir d'un texte** : traduire un texte dans une autre langue, faire le résumé d'un texte, etc.

+

+Le traitement du langage naturel ne se limite pas qu'à la compréhension du texte. Il s'intéresse aussi aux problèmes complexes de reconnaissance de la parole et de vision par ordinateur tels que la génération d'une transcription à partir d'un échantillon audio ou la description d'une image.

+

+## Pourquoi est-ce difficile ?

+

+Les ordinateurs ne traitent pas les informations de la même manière que les humains. Par exemple, lorsque nous lisons la phrase « j'ai faim », nous comprenons très facilement son sens. De même, lorsque nous lisons deux phrases telles que « j'ai faim » et « je suis triste », nous pouvons facilement déterminer s'il existe des similitudes entre elles. Pour les modèles d'apprentissage automatique, ces tâches sont plus difficiles. Le texte doit être traité de manière à permettre au modèle d'apprendre. Et parce que le langage est complexe, nous devons prendre soin de réfléchir à la meilleure façon de faire ce traitement. Il y a eu beaucoup de recherches sur la façon de représenter le texte et nous allons voir quelques-unes de ces méthodes dans le chapitre suivant.

diff --git a/chapters/fr/chapter1/3.mdx b/chapters/fr/chapter1/3.mdx

index 5428aff2b..d10b714e2 100644

--- a/chapters/fr/chapter1/3.mdx

+++ b/chapters/fr/chapter1/3.mdx

@@ -1,381 +1,381 @@

-# Que peuvent faire les transformers ?

-

-

-

-Dans cette section, nous allons voir ce que peuvent faire les *transformers* et utiliser notre premier outil de la bibliothèque 🤗 *Transformers* : la fonction `pipeline()`.

-

-

-👀 Vous voyez ce bouton Open in Colab en haut à droite ? Cliquez dessus pour ouvrir un notebook Colab avec tous les exemples de code de cette section. Ce bouton sera présent dans n'importe quelle section contenant des exemples de code.

-

-Si vous souhaitez exécuter les codes en local, nous vous recommandons de jeter un œil au chapitre configuration.

-

-

-## Les transformers sont partout !

-

-Les *transformers* sont utilisés pour résoudre toute sorte de tâches de NLP comme celles mentionnées dans la section précédente. Voici quelques-unes des entreprises et organisations qui utilisent Hugging Face, les *transformers* et qui contribuent aussi à la communauté en partageant leurs modèles :

-

- -

-La bibliothèque [🤗 *Transformers*](https://github.com/huggingface/transformers) fournit toutes les fonctionnalités nécessaires pour créer et utiliser les modèles partagés. Le [*Hub*](https://huggingface.co/models) contient des milliers de modèles pré-entraînés que n'importe qui peut télécharger et utiliser. Vous pouvez également transférer vos propres modèles vers le Hub !

-

-

- ⚠️ Le Hub n'est pas limité aux transformers. Tout le monde peut partager n'importe quel modèle ou jeu de données s'il le souhaite ! Créez un compte sur huggingface.co pour bénéficier de toutes les fonctionnalités disponibles !

-

-

-Avant de découvrir en détail comment les *transformers* fonctionnent, nous allons voir quelques exemples de comment ils peuvent être utilisés pour résoudre des problèmes intéressants de NLP.

-

-## Travailler avec les pipelines

-

-

-

-L'outil le plus basique de la bibliothèque 🤗 *Transformers* est la fonction `pipeline()`. Elle relie un modèle avec ses étapes de pré-traitement et de post-traitement, permettant d'entrer n'importe quel texte et d'obtenir une réponse compréhensible :

-

-```python

-from transformers import pipeline

-

-classifier = pipeline("sentiment-analysis")

-classifier(

- "I've been waiting for a HuggingFace course my whole life."

-) # J'ai attendu un cours d'HuggingFace toute ma vie.

-```

-

-```python out

-[{'label': 'POSITIVE', 'score': 0.9598047137260437}]

-```

-

-On peut même passer plusieurs phrases !

-

-```python

-classifier(

- [

- "I've been waiting for a HuggingFace course my whole life.",

- "I hate this so much!",

- ] # « J'ai attendu un cours d'HuggingFace toute ma vie. », « Je déteste tellement ça ! »

-)

-```

-

-```python out

-[{'label': 'POSITIVE', 'score': 0.9598047137260437},

- {'label': 'NEGATIVE', 'score': 0.9994558095932007}]

-```

-

-Par défaut, ce pipeline sélectionne un modèle pré-entraîné qui a été spécifiquement entraîné pour l'analyse de sentiment en anglais. Le modèle est téléchargé et mis en cache lorsque vous créez l'objet `classifier`. Si vous réexécutez la commande, c'est le modèle mis en cache qui sera utilisé et il n'y a pas besoin de télécharger le modèle à nouveau.

-

-Il y a trois étapes principales lorsque vous passez du texte à un pipeline :

-

-1. le texte est prétraité pour qu'il ait un format compréhensible par le modèle,

-2. les données prétraitées sont passées au modèle,

-3. les prédictions du modèle sont post-traitées de sorte que vous puissiez les comprendre.

-

-

-Voici une liste non-exhaustive des [pipelines disponibles](https://huggingface.co/transformers/main_classes/pipelines.html) :

-

-- `feature-extraction` (pour obtenir la représentation vectorielle d'un texte)

-- `fill-mask`

-- `ner` (*named entity recognition* ou reconnaissance d'entités nommées en français)

-- `question-answering`

-- `sentiment-analysis`

-- `summarization`

-- `text-generation`

-- `translation`

-- `zero-shot-classification`

-

-Regardons de plus près certains d'entre eux !

-

-## Zero-shot classification

-

-Nous allons commencer par nous attaquer à une tâche plus difficile où nous devons classer des textes qui n'ont pas été annotés. C'est un scénario très répandu dans les projets réels car l'annotation de textes est généralement longue et nécessite parfois une expertise dans un domaine. Pour ce cas d'usage, le pipeline `zero-shot-classification` est très puissant : il vous permet de spécifier les labels à utiliser pour la classification, de sorte que vous n'ayez pas à vous soucier des labels du modèle pré-entraîné. Nous avons déjà vu comment le modèle peut classer un texte comme positif ou négatif en utilisant ces deux labels mais il peut également classer le texte en utilisant n'importe quel autre ensemble de labels que vous souhaitez.

-

-```python

-from transformers import pipeline

-

-classifier = pipeline("zero-shot-classification")

-classifier(

- "This is a course about the Transformers library",

- # C'est un cours sur la bibliothèque Transformers

- candidate_labels=["education", "politics", "business"],

-)

-```

-

-```python out

-{'sequence': 'This is a course about the Transformers library',

-# C'est un cours sur la bibliothèque Transformers

- 'labels': ['education', 'business', 'politics'],

- 'scores': [0.8445963859558105, 0.111976258456707, 0.043427448719739914]}

-```

-

-Ce pipeline est appelé _zero-shot_ car vous n'avez pas besoin d'entraîner spécifiquement le modèle sur vos données pour l'utiliser. Il peut directement retourner des scores de probabilité pour n'importe quel ensemble de labels que vous choisissez !

-

-

-

-✏️ **Essayez !** Jouez avec vos propres séquences et labels et voyez comment le modèle fonctionne.

-

-

-

-

-## Génération de texte

-

-Maintenant, nous allons voir comment utiliser un pipeline pour générer du texte. L'idée principale ici est que vous fournissez seulement un extrait de texte qui va être complété par du texte généré automatiquement par le modèle. Cette fonction est similaire à la fonction de texte prédictif que l'on trouve sur de nombreux téléphones portables. La génération de texte implique de l'aléatoire, donc il est normal que vous n'obteniez pas les mêmes résultats que ceux présentés ci-dessous.

-

-```python

-from transformers import pipeline

-

-generator = pipeline("text-generation")

-generator(

- "In this course, we will teach you how to"

-) # Dans ce cours, nous vous enseignerons comment

-```

-

-```python out

-[{'generated_text': 'In this course, we will teach you how to understand and use '

- # Dans ce cours, nous vous enseignerons comment comprendre et utiliser

- 'data flow and data interchange when handling user data. We '

- # flux de données et l'échange de données lors de la manipulation des données utilisateur. Nous

- 'will be working with one or more of the most commonly used '

- # travailleront avec un ou plusieurs des plus couramment utilisés

- 'data flows — data flows of various types, as seen by the '

- # flux de données - flux de données de différents types, tels qu'ils sont vus par

- 'HTTP'}] # HTTP

-```

-

-Il est possible de contrôler le nombre de séquences générées avec l'argument `num_return_sequences` et la longueur totale du texte généré avec l'argument `max_length`.

-

-

-

-✏️ **Essayez !** Utilisez les arguments `num_return_sequences` et `max_length` pour générer deux phrases de 15 mots chacune.

-

-

-

-

-## Utiliser n'importe quel modèle du Hub dans un pipeline

-

-Les exemples précédents utilisaient le modèle par défaut pour la tâche en question mais vous pouvez aussi choisir un modèle particulier du *Hub* et l'utiliser dans un pipeline pour une tâche spécifique comme par exemple la génération de texte. Rendez-vous sur le [*Hub*](https://huggingface.co/models) et cliquez sur le *filtre* correspondant sur la gauche pour afficher seulement les modèles supportés pour cette tâche. Vous devriez arriver sur une page comme [celle-ci](https://huggingface.co/models?pipeline_tag=text-generation).

-

-Essayons le modèle [`distilgpt2`](https://huggingface.co/distilgpt2) ! Voici comment charger le modèle dans le même pipeline que précédemment :

-

-```python

-from transformers import pipeline

-

-generator = pipeline("text-generation", model="distilgpt2")

-generator(

- "In this course, we will teach you how to",

- # Dans ce cours, nous vous enseignerons comment

- max_length=30,

- num_return_sequences=2,

-)

-```

-

-```python out

-[{'generated_text': 'In this course, we will teach you how to manipulate the world and '

- # Dans ce cours, nous vous enseignerons comment manipuler le monde et

- 'move your mental and physical capabilities to your advantage.'},

- # utiliser vos capacités mentales et physiques à votre avantage.

- {'generated_text': 'In this course, we will teach you how to become an expert and '

- # Dans ce cours, nous vous apprendrons comment devenir un expert et

- 'practice realtime, and with a hands on experience on both real '

- # pratique en temps réel, et avec une expérience pratique à la fois sur de vrais

- 'time and real'}]

- # temps et réel

-```

-

-Vous pouvez améliorer votre recherche de modèle en cliquant sur les *filtres* de langue et choisir un modèle qui génère du texte dans une autre langue. Le *Hub* contient également des *checkpoints* pour des modèles multilingues qui supportent plusieurs langues.

-

-Une fois que vous avez choisi un modèle, vous verrez que vous pouvez tester son fonctionnement en ligne directement. Cela vous permet de tester rapidement les capacités du modèle avant de le télécharger.

-

-

-

-✏️ **Essayez !** Utilisez les filtres pour trouver un modèle de génération de texte pour une autre langue. N'hésitez pas à jouer avec le *widget* et l'utiliser dans un pipeline !

-

-

-

-### L'API d'inférence

-

-Tous les modèles peuvent être testé directement depuis votre navigateur en utilisant l'API d'inférence qui est disponible sur le site [Hugging Face](https://huggingface.co/). Vous pouvez jouer avec le modèle directement sur sa page en entrant du texte personnalisé et en regardant le modèle traiter les données d'entrée.

-

-L'API d'inférence qui est utilisée par le *widget* est également disponible en tant que produit payant si vous avez besoin de l'API pour votre travail. Consultez la [page des prix](https://huggingface.co/pricing) pour plus de détails.

-

-## Remplacement des mots manquants

-

-Le prochain pipeline que vous allez essayer est celui de `fill-mask`. L'idée de cette tâche est de remplir les mots manquants d'un texte donné :

-

-```python

-from transformers import pipeline

-

-unmasker = pipeline("fill-mask")

-unmasker("This course will teach you all about models.", top_k=2)

-```

-

-```python out

-[{'sequence': 'This course will teach you all about mathematical models.',

-# Ce cours vous apprendra tout sur les modèles mathématiques.

- 'score': 0.19619831442832947,

- 'token': 30412,

- 'token_str': ' mathematical'},

- {'sequence': 'This course will teach you all about computational models.',

- # Ce cours vous apprendra tout sur les modèles mathématiques.

- 'score': 0.04052725434303284,

- 'token': 38163,

- 'token_str': ' computational'}]

-```

-

-L'argument `top_k` permet de contrôler le nombre de possibilités que vous souhaitez afficher. Notez que dans ce cas, le modèle remplace le mot spécial ``, qui est souvent appelé un *mot masqué*. D'autres modèles permettant de remplacer les mots manquants peuvent avoir des mots masqués différents, donc il est toujours bon de vérifier le mot masqué approprié lorsque vous comparez d'autres modèles. Une façon de le vérifier est de regarder le mot masqué utilisé dans l'outil de test de la page du modèle.

-

-

-

-✏️ **Essayez !** Recherchez le modèle `bert-base-cased` sur le *Hub* et identifiez le mot masqué dans l'outil d'inférence. Que prédit le modèle pour la phrase dans notre exemple de pipeline au-dessus ?

-

-

-

-## Reconnaissance d'entités nommées

-

-La reconnaissance d'entités nommées ou NER (pour *Named Entity Recognition*) est une tâche où le modèle doit trouver les parties du texte d'entrée qui correspondent à des entités telles que des personnes, des lieux ou des organisations. Voyons un exemple :

-

-```python

-from transformers import pipeline

-

-ner = pipeline("ner", grouped_entities=True)

-ner(

- "My name is Sylvain and I work at Hugging Face in Brooklyn."

-) # Je m'appelle Sylvain et je travaille à Hugging Face à Brooklyn.

-```

-

-```python out

-[{'entity_group': 'PER', 'score': 0.99816, 'word': 'Sylvain', 'start': 11, 'end': 18},

- {'entity_group': 'ORG', 'score': 0.97960, 'word': 'Hugging Face', 'start': 33, 'end': 45},

- {'entity_group': 'LOC', 'score': 0.99321, 'word': 'Brooklyn', 'start': 49, 'end': 57}

-]

-```

-

-Nous pouvons voir que le modèle a correctement identifié Sylvain comme une personne (PER), Hugging Face comme une organisation (ORG) et Brooklyn comme un lieu (LOC).

-

-Il est possible d'utiliser l'option `grouped_entities=True` lors de la création du pipeline pour regrouper les parties du texte qui correspondent à la même entité : ici le modèle à correctement regroupé `Hugging` et `Face` comme une seule organisation, même si le nom comporte plusieurs mots. En effet, comme nous allons voir dans le prochain chapitre, la prétraitement du texte sépare parfois certains mots en plus petites parties. Par exemple, `Sylvain` est séparé en quatre morceaux : `S`, `##yl`, `##va`, et `##in`. Dans l'étape de post-traitement, le pipeline a réussi à regrouper ces morceaux.

-

-

-

-✏️ **Essayez !** Recherchez sur le *Hub* un modèle capable de reconnaître les différentes parties du langage (généralement abrégé en POS pour *Part-of-speech*) en anglais. Que prédit le modèle pour la phrase dans notre exemple du pipeline au-dessus ?

-

-

-

-## Réponse à des questions

-

-Le pipeline `question-answering` répond à des questions en utilisant des informations données en contexte :

-

-```python

-from transformers import pipeline

-

-question_answerer = pipeline("question-answering")

-question_answerer(

- question="Where do I work?", # Où est-ce que je travaille ?

- context="My name is Sylvain and I work at Hugging Face in Brooklyn",

- # Je m'appelle Sylvain et je travaille à Hugging Face à Brooklyn.

-)

-```

-

-```python out

-{'score': 0.6385916471481323, 'start': 33, 'end': 45, 'answer': 'Hugging Face'}

-```

-

-Notez que ce pipeline fonctionne par extraction d'information depuis le contexte fourni, il ne génère pas la réponse.

-

-## Résumé

-

-Le résumé est une tâche de réduction d'un texte en un texte plus court, tout en gardant tous (ou presque tous) les aspects importants référencés dans le texte. Voici un exemple :

-

-```python

-from transformers import pipeline

-

-summarizer = pipeline("summarization")

-summarizer(

- """

- America has changed dramatically during recent years. Not only has the number of

- graduates in traditional engineering disciplines such as mechanical, civil,

- electrical, chemical, and aeronautical engineering declined, but in most of

- the premier American universities engineering curricula now concentrate on

- and encourage largely the study of engineering science. As a result, there

- are declining offerings in engineering subjects dealing with infrastructure,

- the environment, and related issues, and greater concentration on high

- technology subjects, largely supporting increasingly complex scientific

- developments. While the latter is important, it should not be at the expense

- of more traditional engineering.

-

- Rapidly developing economies such as China and India, as well as other

- industrial countries in Europe and Asia, continue to encourage and advance

- the teaching of engineering. Both China and India, respectively, graduate

- six and eight times as many traditional engineers as does the United States.

- Other industrial countries at minimum maintain their output, while America

- suffers an increasingly serious decline in the number of engineering graduates

- and a lack of well-educated engineers.

-"""

-)

-

-"""

- L'Amérique a changé de façon spectaculaire au cours des dernières années. Non seulement le nombre de

- diplômés dans les disciplines traditionnelles de l'ingénierie telles que le génie mécanique, civil,

- l'électricité, la chimie et l'aéronautique a diminué, mais dans la plupart

- des grandes universités américaines, les programmes d'études d'ingénierie se concentrent désormais sur

- et encouragent largement l'étude des sciences de l'ingénieur. Par conséquent, il y a

- de moins en moins d'offres dans les sujets d'ingénierie traitant de l'infrastructure,

- l'environnement et les questions connexes, et une plus grande concentration sur les sujets de haute

- technologie, qui soutiennent en grande partie des développements scientifiques de plus en plus

- complexes. Si cette dernière est importante, elle ne doit pas se faire au détriment

- de l'ingénierie plus traditionnelle.

-

- Les économies en développement rapide telles que la Chine et l'Inde, ainsi que d'autres

- pays industrialisés d'Europe et d'Asie, continuent d'encourager et de promouvoir

- l'enseignement de l'ingénierie. La Chine et l'Inde, respectivement, diplôment

- six et huit fois plus d'ingénieurs traditionnels que les États-Unis.

- Les autres pays industriels maintiennent au minimum leur production, tandis que l'Amérique

- souffre d'une baisse de plus en plus importante du nombre de diplômés en ingénierie

- et un manque d'ingénieurs bien formés.

-"""

-```

-

-```python out

-[{'summary_text': ' America has changed dramatically during recent years . The '

- # L'Amérique a changé de façon spectaculaire au cours des dernières années. Le

- 'number of engineering graduates in the U.S. has declined in '

- # nombre de diplômés en ingénierie aux États-Unis a diminué dans

- 'traditional engineering disciplines such as mechanical, civil '

- # dans les disciplines traditionnelles de l'ingénierie, telles que le génie mécanique, civil

- ', electrical, chemical, and aeronautical engineering . Rapidly '

- # l'électricité, la chimie et l'aéronautique. Les économies

- 'developing economies such as China and India, as well as other '

- # en développement rapide comme la Chine et l'Inde, ainsi que d'autres

- 'industrial countries in Europe and Asia, continue to encourage '

- # pays industriels d'Europe et d'Asie, continuent d'encourager

- 'and advance engineering.'}]

- # et à faire progresser l'ingénierie.

-```

-

-Comme pour la génération de texte, vous pouvez spécifier une `max_length` (longueur maximale) ou une `min_length` (longueur minimale) pour le résultat.

-

-

-## Traduction

-

-Pour la traduction, vous pouvez utiliser un modèle par défaut si vous fournissez un couple de langues dans le nom de la tâche (comme `"translation_en_to_fr"`), mais le plus simple reste d'utiliser un modèle adéquat disponible sur le [*Hub*](https://huggingface.co/models). Ici, nous allons essayer de traduire du français en anglais :

-

-```python

-from transformers import pipeline

-

-translator = pipeline("translation", model="Helsinki-NLP/opus-mt-fr-en")

-translator("Ce cours est produit par Hugging Face.")

-```

-

-```python out

-[{'translation_text': 'This course is produced by Hugging Face.'}]

-```

-

-Comme pour la génération de texte et le résumé de texte, il est possible de spécifier une `max_length` (longueur maximale) ou une `min_length` (longueur minimale) pour le résultat.

-

-

-

-✏️ **Essayez !** Recherchez d'autres modèles de traduction sur le Hub et essayez de traduire la phrase précédente en plusieurs langues différentes.

-

-

-

-Les pipelines présentés jusqu'ici sont principalement destinés à des fins de démonstration. Ils ont été programmés pour des tâches spécifiques et ne peuvent pas effectuer de variations de celles-ci. Dans le chapitre suivant, vous apprendrez ce qu'il y a dans un `pipeline()` et comment modifier son comportement.

+# Que peuvent faire les transformers ?

+

+

+

+Dans cette section, nous allons voir ce que peuvent faire les *transformers* et utiliser notre premier outil de la bibliothèque 🤗 *Transformers* : la fonction `pipeline()`.

+

+

+👀 Vous voyez ce bouton Open in Colab en haut à droite ? Cliquez dessus pour ouvrir un notebook Colab avec tous les exemples de code de cette section. Ce bouton sera présent dans n'importe quelle section contenant des exemples de code.

+

+Si vous souhaitez exécuter les codes en local, nous vous recommandons de jeter un œil au chapitre configuration.

+

+

+## Les transformers sont partout !

+

+Les *transformers* sont utilisés pour résoudre toute sorte de tâches de NLP comme celles mentionnées dans la section précédente. Voici quelques-unes des entreprises et organisations qui utilisent Hugging Face, les *transformers* et qui contribuent aussi à la communauté en partageant leurs modèles :

+

+

-

-La bibliothèque [🤗 *Transformers*](https://github.com/huggingface/transformers) fournit toutes les fonctionnalités nécessaires pour créer et utiliser les modèles partagés. Le [*Hub*](https://huggingface.co/models) contient des milliers de modèles pré-entraînés que n'importe qui peut télécharger et utiliser. Vous pouvez également transférer vos propres modèles vers le Hub !

-

-

- ⚠️ Le Hub n'est pas limité aux transformers. Tout le monde peut partager n'importe quel modèle ou jeu de données s'il le souhaite ! Créez un compte sur huggingface.co pour bénéficier de toutes les fonctionnalités disponibles !

-

-

-Avant de découvrir en détail comment les *transformers* fonctionnent, nous allons voir quelques exemples de comment ils peuvent être utilisés pour résoudre des problèmes intéressants de NLP.

-

-## Travailler avec les pipelines

-

-

-

-L'outil le plus basique de la bibliothèque 🤗 *Transformers* est la fonction `pipeline()`. Elle relie un modèle avec ses étapes de pré-traitement et de post-traitement, permettant d'entrer n'importe quel texte et d'obtenir une réponse compréhensible :

-

-```python

-from transformers import pipeline

-

-classifier = pipeline("sentiment-analysis")

-classifier(

- "I've been waiting for a HuggingFace course my whole life."

-) # J'ai attendu un cours d'HuggingFace toute ma vie.

-```

-

-```python out

-[{'label': 'POSITIVE', 'score': 0.9598047137260437}]

-```

-

-On peut même passer plusieurs phrases !

-

-```python

-classifier(

- [

- "I've been waiting for a HuggingFace course my whole life.",

- "I hate this so much!",

- ] # « J'ai attendu un cours d'HuggingFace toute ma vie. », « Je déteste tellement ça ! »

-)

-```

-

-```python out

-[{'label': 'POSITIVE', 'score': 0.9598047137260437},

- {'label': 'NEGATIVE', 'score': 0.9994558095932007}]

-```

-

-Par défaut, ce pipeline sélectionne un modèle pré-entraîné qui a été spécifiquement entraîné pour l'analyse de sentiment en anglais. Le modèle est téléchargé et mis en cache lorsque vous créez l'objet `classifier`. Si vous réexécutez la commande, c'est le modèle mis en cache qui sera utilisé et il n'y a pas besoin de télécharger le modèle à nouveau.

-

-Il y a trois étapes principales lorsque vous passez du texte à un pipeline :

-

-1. le texte est prétraité pour qu'il ait un format compréhensible par le modèle,

-2. les données prétraitées sont passées au modèle,

-3. les prédictions du modèle sont post-traitées de sorte que vous puissiez les comprendre.

-

-

-Voici une liste non-exhaustive des [pipelines disponibles](https://huggingface.co/transformers/main_classes/pipelines.html) :

-

-- `feature-extraction` (pour obtenir la représentation vectorielle d'un texte)

-- `fill-mask`

-- `ner` (*named entity recognition* ou reconnaissance d'entités nommées en français)

-- `question-answering`

-- `sentiment-analysis`

-- `summarization`

-- `text-generation`

-- `translation`

-- `zero-shot-classification`

-

-Regardons de plus près certains d'entre eux !

-

-## Zero-shot classification

-

-Nous allons commencer par nous attaquer à une tâche plus difficile où nous devons classer des textes qui n'ont pas été annotés. C'est un scénario très répandu dans les projets réels car l'annotation de textes est généralement longue et nécessite parfois une expertise dans un domaine. Pour ce cas d'usage, le pipeline `zero-shot-classification` est très puissant : il vous permet de spécifier les labels à utiliser pour la classification, de sorte que vous n'ayez pas à vous soucier des labels du modèle pré-entraîné. Nous avons déjà vu comment le modèle peut classer un texte comme positif ou négatif en utilisant ces deux labels mais il peut également classer le texte en utilisant n'importe quel autre ensemble de labels que vous souhaitez.

-

-```python

-from transformers import pipeline

-

-classifier = pipeline("zero-shot-classification")

-classifier(

- "This is a course about the Transformers library",

- # C'est un cours sur la bibliothèque Transformers

- candidate_labels=["education", "politics", "business"],

-)

-```

-

-```python out

-{'sequence': 'This is a course about the Transformers library',

-# C'est un cours sur la bibliothèque Transformers

- 'labels': ['education', 'business', 'politics'],

- 'scores': [0.8445963859558105, 0.111976258456707, 0.043427448719739914]}

-```

-

-Ce pipeline est appelé _zero-shot_ car vous n'avez pas besoin d'entraîner spécifiquement le modèle sur vos données pour l'utiliser. Il peut directement retourner des scores de probabilité pour n'importe quel ensemble de labels que vous choisissez !

-

-

-

-✏️ **Essayez !** Jouez avec vos propres séquences et labels et voyez comment le modèle fonctionne.

-

-

-

-

-## Génération de texte

-

-Maintenant, nous allons voir comment utiliser un pipeline pour générer du texte. L'idée principale ici est que vous fournissez seulement un extrait de texte qui va être complété par du texte généré automatiquement par le modèle. Cette fonction est similaire à la fonction de texte prédictif que l'on trouve sur de nombreux téléphones portables. La génération de texte implique de l'aléatoire, donc il est normal que vous n'obteniez pas les mêmes résultats que ceux présentés ci-dessous.

-

-```python

-from transformers import pipeline

-

-generator = pipeline("text-generation")

-generator(

- "In this course, we will teach you how to"

-) # Dans ce cours, nous vous enseignerons comment

-```

-

-```python out

-[{'generated_text': 'In this course, we will teach you how to understand and use '

- # Dans ce cours, nous vous enseignerons comment comprendre et utiliser

- 'data flow and data interchange when handling user data. We '

- # flux de données et l'échange de données lors de la manipulation des données utilisateur. Nous

- 'will be working with one or more of the most commonly used '

- # travailleront avec un ou plusieurs des plus couramment utilisés

- 'data flows — data flows of various types, as seen by the '

- # flux de données - flux de données de différents types, tels qu'ils sont vus par

- 'HTTP'}] # HTTP

-```

-

-Il est possible de contrôler le nombre de séquences générées avec l'argument `num_return_sequences` et la longueur totale du texte généré avec l'argument `max_length`.

-

-

-

-✏️ **Essayez !** Utilisez les arguments `num_return_sequences` et `max_length` pour générer deux phrases de 15 mots chacune.

-

-

-

-

-## Utiliser n'importe quel modèle du Hub dans un pipeline

-

-Les exemples précédents utilisaient le modèle par défaut pour la tâche en question mais vous pouvez aussi choisir un modèle particulier du *Hub* et l'utiliser dans un pipeline pour une tâche spécifique comme par exemple la génération de texte. Rendez-vous sur le [*Hub*](https://huggingface.co/models) et cliquez sur le *filtre* correspondant sur la gauche pour afficher seulement les modèles supportés pour cette tâche. Vous devriez arriver sur une page comme [celle-ci](https://huggingface.co/models?pipeline_tag=text-generation).

-

-Essayons le modèle [`distilgpt2`](https://huggingface.co/distilgpt2) ! Voici comment charger le modèle dans le même pipeline que précédemment :

-

-```python

-from transformers import pipeline

-

-generator = pipeline("text-generation", model="distilgpt2")

-generator(

- "In this course, we will teach you how to",

- # Dans ce cours, nous vous enseignerons comment

- max_length=30,

- num_return_sequences=2,

-)

-```

-

-```python out

-[{'generated_text': 'In this course, we will teach you how to manipulate the world and '

- # Dans ce cours, nous vous enseignerons comment manipuler le monde et

- 'move your mental and physical capabilities to your advantage.'},

- # utiliser vos capacités mentales et physiques à votre avantage.

- {'generated_text': 'In this course, we will teach you how to become an expert and '

- # Dans ce cours, nous vous apprendrons comment devenir un expert et

- 'practice realtime, and with a hands on experience on both real '

- # pratique en temps réel, et avec une expérience pratique à la fois sur de vrais

- 'time and real'}]

- # temps et réel

-```

-

-Vous pouvez améliorer votre recherche de modèle en cliquant sur les *filtres* de langue et choisir un modèle qui génère du texte dans une autre langue. Le *Hub* contient également des *checkpoints* pour des modèles multilingues qui supportent plusieurs langues.

-

-Une fois que vous avez choisi un modèle, vous verrez que vous pouvez tester son fonctionnement en ligne directement. Cela vous permet de tester rapidement les capacités du modèle avant de le télécharger.

-

-

-

-✏️ **Essayez !** Utilisez les filtres pour trouver un modèle de génération de texte pour une autre langue. N'hésitez pas à jouer avec le *widget* et l'utiliser dans un pipeline !

-

-

-

-### L'API d'inférence

-

-Tous les modèles peuvent être testé directement depuis votre navigateur en utilisant l'API d'inférence qui est disponible sur le site [Hugging Face](https://huggingface.co/). Vous pouvez jouer avec le modèle directement sur sa page en entrant du texte personnalisé et en regardant le modèle traiter les données d'entrée.

-

-L'API d'inférence qui est utilisée par le *widget* est également disponible en tant que produit payant si vous avez besoin de l'API pour votre travail. Consultez la [page des prix](https://huggingface.co/pricing) pour plus de détails.

-

-## Remplacement des mots manquants

-

-Le prochain pipeline que vous allez essayer est celui de `fill-mask`. L'idée de cette tâche est de remplir les mots manquants d'un texte donné :

-

-```python

-from transformers import pipeline

-

-unmasker = pipeline("fill-mask")

-unmasker("This course will teach you all about models.", top_k=2)

-```

-

-```python out

-[{'sequence': 'This course will teach you all about mathematical models.',

-# Ce cours vous apprendra tout sur les modèles mathématiques.

- 'score': 0.19619831442832947,

- 'token': 30412,

- 'token_str': ' mathematical'},

- {'sequence': 'This course will teach you all about computational models.',

- # Ce cours vous apprendra tout sur les modèles mathématiques.

- 'score': 0.04052725434303284,

- 'token': 38163,

- 'token_str': ' computational'}]

-```

-

-L'argument `top_k` permet de contrôler le nombre de possibilités que vous souhaitez afficher. Notez que dans ce cas, le modèle remplace le mot spécial ``, qui est souvent appelé un *mot masqué*. D'autres modèles permettant de remplacer les mots manquants peuvent avoir des mots masqués différents, donc il est toujours bon de vérifier le mot masqué approprié lorsque vous comparez d'autres modèles. Une façon de le vérifier est de regarder le mot masqué utilisé dans l'outil de test de la page du modèle.

-

-

-

-✏️ **Essayez !** Recherchez le modèle `bert-base-cased` sur le *Hub* et identifiez le mot masqué dans l'outil d'inférence. Que prédit le modèle pour la phrase dans notre exemple de pipeline au-dessus ?

-

-

-

-## Reconnaissance d'entités nommées

-

-La reconnaissance d'entités nommées ou NER (pour *Named Entity Recognition*) est une tâche où le modèle doit trouver les parties du texte d'entrée qui correspondent à des entités telles que des personnes, des lieux ou des organisations. Voyons un exemple :

-

-```python

-from transformers import pipeline

-

-ner = pipeline("ner", grouped_entities=True)

-ner(

- "My name is Sylvain and I work at Hugging Face in Brooklyn."

-) # Je m'appelle Sylvain et je travaille à Hugging Face à Brooklyn.

-```

-

-```python out

-[{'entity_group': 'PER', 'score': 0.99816, 'word': 'Sylvain', 'start': 11, 'end': 18},

- {'entity_group': 'ORG', 'score': 0.97960, 'word': 'Hugging Face', 'start': 33, 'end': 45},

- {'entity_group': 'LOC', 'score': 0.99321, 'word': 'Brooklyn', 'start': 49, 'end': 57}

-]

-```

-

-Nous pouvons voir que le modèle a correctement identifié Sylvain comme une personne (PER), Hugging Face comme une organisation (ORG) et Brooklyn comme un lieu (LOC).

-

-Il est possible d'utiliser l'option `grouped_entities=True` lors de la création du pipeline pour regrouper les parties du texte qui correspondent à la même entité : ici le modèle à correctement regroupé `Hugging` et `Face` comme une seule organisation, même si le nom comporte plusieurs mots. En effet, comme nous allons voir dans le prochain chapitre, la prétraitement du texte sépare parfois certains mots en plus petites parties. Par exemple, `Sylvain` est séparé en quatre morceaux : `S`, `##yl`, `##va`, et `##in`. Dans l'étape de post-traitement, le pipeline a réussi à regrouper ces morceaux.

-

-

-

-✏️ **Essayez !** Recherchez sur le *Hub* un modèle capable de reconnaître les différentes parties du langage (généralement abrégé en POS pour *Part-of-speech*) en anglais. Que prédit le modèle pour la phrase dans notre exemple du pipeline au-dessus ?

-

-

-

-## Réponse à des questions

-

-Le pipeline `question-answering` répond à des questions en utilisant des informations données en contexte :

-

-```python

-from transformers import pipeline

-

-question_answerer = pipeline("question-answering")

-question_answerer(

- question="Where do I work?", # Où est-ce que je travaille ?

- context="My name is Sylvain and I work at Hugging Face in Brooklyn",

- # Je m'appelle Sylvain et je travaille à Hugging Face à Brooklyn.

-)

-```

-

-```python out

-{'score': 0.6385916471481323, 'start': 33, 'end': 45, 'answer': 'Hugging Face'}

-```

-

-Notez que ce pipeline fonctionne par extraction d'information depuis le contexte fourni, il ne génère pas la réponse.

-

-## Résumé

-

-Le résumé est une tâche de réduction d'un texte en un texte plus court, tout en gardant tous (ou presque tous) les aspects importants référencés dans le texte. Voici un exemple :

-

-```python

-from transformers import pipeline

-

-summarizer = pipeline("summarization")

-summarizer(

- """

- America has changed dramatically during recent years. Not only has the number of

- graduates in traditional engineering disciplines such as mechanical, civil,

- electrical, chemical, and aeronautical engineering declined, but in most of

- the premier American universities engineering curricula now concentrate on

- and encourage largely the study of engineering science. As a result, there

- are declining offerings in engineering subjects dealing with infrastructure,

- the environment, and related issues, and greater concentration on high

- technology subjects, largely supporting increasingly complex scientific

- developments. While the latter is important, it should not be at the expense

- of more traditional engineering.

-

- Rapidly developing economies such as China and India, as well as other

- industrial countries in Europe and Asia, continue to encourage and advance

- the teaching of engineering. Both China and India, respectively, graduate

- six and eight times as many traditional engineers as does the United States.

- Other industrial countries at minimum maintain their output, while America

- suffers an increasingly serious decline in the number of engineering graduates

- and a lack of well-educated engineers.

-"""

-)

-

-"""

- L'Amérique a changé de façon spectaculaire au cours des dernières années. Non seulement le nombre de

- diplômés dans les disciplines traditionnelles de l'ingénierie telles que le génie mécanique, civil,

- l'électricité, la chimie et l'aéronautique a diminué, mais dans la plupart

- des grandes universités américaines, les programmes d'études d'ingénierie se concentrent désormais sur

- et encouragent largement l'étude des sciences de l'ingénieur. Par conséquent, il y a

- de moins en moins d'offres dans les sujets d'ingénierie traitant de l'infrastructure,

- l'environnement et les questions connexes, et une plus grande concentration sur les sujets de haute

- technologie, qui soutiennent en grande partie des développements scientifiques de plus en plus

- complexes. Si cette dernière est importante, elle ne doit pas se faire au détriment

- de l'ingénierie plus traditionnelle.

-

- Les économies en développement rapide telles que la Chine et l'Inde, ainsi que d'autres

- pays industrialisés d'Europe et d'Asie, continuent d'encourager et de promouvoir

- l'enseignement de l'ingénierie. La Chine et l'Inde, respectivement, diplôment

- six et huit fois plus d'ingénieurs traditionnels que les États-Unis.

- Les autres pays industriels maintiennent au minimum leur production, tandis que l'Amérique

- souffre d'une baisse de plus en plus importante du nombre de diplômés en ingénierie

- et un manque d'ingénieurs bien formés.

-"""

-```

-

-```python out

-[{'summary_text': ' America has changed dramatically during recent years . The '

- # L'Amérique a changé de façon spectaculaire au cours des dernières années. Le

- 'number of engineering graduates in the U.S. has declined in '

- # nombre de diplômés en ingénierie aux États-Unis a diminué dans

- 'traditional engineering disciplines such as mechanical, civil '

- # dans les disciplines traditionnelles de l'ingénierie, telles que le génie mécanique, civil

- ', electrical, chemical, and aeronautical engineering . Rapidly '

- # l'électricité, la chimie et l'aéronautique. Les économies

- 'developing economies such as China and India, as well as other '

- # en développement rapide comme la Chine et l'Inde, ainsi que d'autres

- 'industrial countries in Europe and Asia, continue to encourage '

- # pays industriels d'Europe et d'Asie, continuent d'encourager

- 'and advance engineering.'}]

- # et à faire progresser l'ingénierie.

-```

-

-Comme pour la génération de texte, vous pouvez spécifier une `max_length` (longueur maximale) ou une `min_length` (longueur minimale) pour le résultat.

-

-

-## Traduction

-

-Pour la traduction, vous pouvez utiliser un modèle par défaut si vous fournissez un couple de langues dans le nom de la tâche (comme `"translation_en_to_fr"`), mais le plus simple reste d'utiliser un modèle adéquat disponible sur le [*Hub*](https://huggingface.co/models). Ici, nous allons essayer de traduire du français en anglais :

-

-```python

-from transformers import pipeline

-

-translator = pipeline("translation", model="Helsinki-NLP/opus-mt-fr-en")

-translator("Ce cours est produit par Hugging Face.")

-```

-

-```python out

-[{'translation_text': 'This course is produced by Hugging Face.'}]

-```

-

-Comme pour la génération de texte et le résumé de texte, il est possible de spécifier une `max_length` (longueur maximale) ou une `min_length` (longueur minimale) pour le résultat.

-

-

-

-✏️ **Essayez !** Recherchez d'autres modèles de traduction sur le Hub et essayez de traduire la phrase précédente en plusieurs langues différentes.

-

-

-

-Les pipelines présentés jusqu'ici sont principalement destinés à des fins de démonstration. Ils ont été programmés pour des tâches spécifiques et ne peuvent pas effectuer de variations de celles-ci. Dans le chapitre suivant, vous apprendrez ce qu'il y a dans un `pipeline()` et comment modifier son comportement.

+# Que peuvent faire les transformers ?

+

+

+

+Dans cette section, nous allons voir ce que peuvent faire les *transformers* et utiliser notre premier outil de la bibliothèque 🤗 *Transformers* : la fonction `pipeline()`.

+

+

+👀 Vous voyez ce bouton Open in Colab en haut à droite ? Cliquez dessus pour ouvrir un notebook Colab avec tous les exemples de code de cette section. Ce bouton sera présent dans n'importe quelle section contenant des exemples de code.

+

+Si vous souhaitez exécuter les codes en local, nous vous recommandons de jeter un œil au chapitre configuration.

+

+

+## Les transformers sont partout !

+