-

Notifications

You must be signed in to change notification settings - Fork 3

HDFハンズオン 0: NiFi, Kafka, Stormを組み合わせて利用する

本チュートリアルではHortonworks DataFlow(HDF)で利用可能なOSSプロダクトを少しずつ触りながら、HDFを利用するとどんなシステムが構築できるのかを学習していきます。

Hortonworks DataFlow (HDF)とは、高速なストリーミング分析を容易に実現し、データ収集、キュレーション、分析、デリバリをリアルタイムで、オンプレミスでもクラウドでも実行可能な、Apache NiFi、Kafka、Stormが統合されたソリューションです。

早速手を動かしながらチュートリアルを進めていきましょう。まずはAmbariにログインします。

本ハンズオンではシングルノードのHDFクラスタを使用します。1台のサーバ上でAmbari Server, Ambari Agent、およびAmbariからインストールしたHDFスタック (NiFi, Storm, Kafka)を起動しています。

Ambari管理画面にログインするには、お使いのPCのWebブラウザから、http://<host>:8080/へアクセスします。host部にはハンズオン講師から渡されたIPアドレスを利用してください。User/Passwordはどちらもadminです:

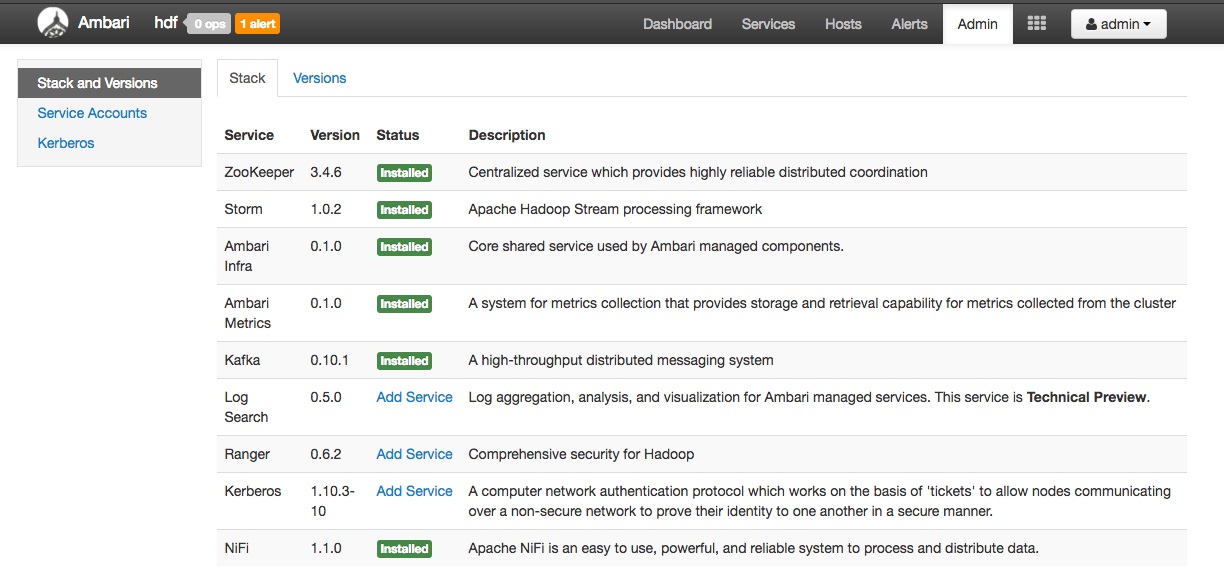

AdminのStack and Versionsをクリックすると、HDFスタックとしてAmbariに登録されているサービスの一覧、バージョン、インストール状況などが確認できます。

Hostsをクリックすると、HDFクラスタに参加しているノードの一覧が確認できます。Ambariから新しいホストを追加すると、そのホスト上でAmbari Agentがインストールされます。その後、HDFの任意のサービスをデプロイします。

NiFiはデータフローオーケストレーションツールとして、各種プロトコル、フォーマットでデータを収集するデータフローの構築、運用に便利です。Stormはリアルタイムストリーミング分析を得意としています。本ハンズオンでは、次のようなデータアプリケーションを作成します:

- NiFiを利用してHTTPプロトコルでデータを受信し、Kafkaトピックへとメッセージを登録

- StormでKafkaのメッセージを受信し、リアルタイム分析を行い、結果を別のKafkaトピックへと登録

- NiFiで結果のKafkaトピックからデータを受信し、ファイルシステムへ保存