-

Notifications

You must be signed in to change notification settings - Fork 1

Chương 2_Bài tập số 1_Dùng Python xử lý số liệu Excel, CSV và dùng thuật toán để làm sạch, thay đổi và phân tích cấu trúc Khoa học Dữ liệu N1,N2

import numpy as np

import pandas as pd

#pd.__version__

import seaborn as sns

from matplotlib import pyplot as plt

from statsmodels.tsa.api import ExponentialSmoothing, SimpleExpSmoothing, Holt

from sklearn.linear_model import LinearRegression

import warnings

warnings.filterwarnings('ignore')df = pd.read_csv(r"C:\Python311\workspaces\m6B45.csv")

pd.set_option("display.max_rows",df.shape[0]+1)

pd.set_option("display.max_columns",60)

df.dataframe tbody tr th {

vertical-align: top;

}

.dataframe thead th {

text-align: right;

}

| Date | S01 | S02 | S03 | S04 | S05 | S06 | S07 | S08 | S09 | S10 | S11 | S12 | S13 | S14 | S15 | S16 | S17 | S18 | S19 | S20 | S21 | S22 | S23 | S24 | S25 | S26 | S27 | S28 | S29 | S30 | S31 | S32 | S33 | S34 | S35 | S36 | S37 | S38 | S39 | S40 | S41 | S42 | S43 | S44 | S45 | ST | Link | Type | BD | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 24/9/2023 | 151 | 137 | 136 | 160 | 159 | 158 | 157 | 143 | 140 | 158 | 145 | 138 | 151 | 132 | 132 | 146 | 136 | 151 | 167 | 145 | 143 | 150 | 143 | 162 | 150 | 141 | 152 | 148 | 139 | 161 | 144 | 137 | 149 | 136 | 156 | 135 | 162 | 132 | 136 | 144 | 149 | 132 | 137 | 168 | 140 | 146.400000 | https://vietlott/vn/vi/choi/mega-6-45/thong-ke... | M6B45 | 18/07/2016 |

| 1 | 27/9/2023 | 151 | 137 | 137 | 161 | 159 | 158 | 157 | 144 | 140 | 158 | 145 | 139 | 151 | 132 | 132 | 146 | 136 | 151 | 167 | 145 | 143 | 151 | 144 | 162 | 150 | 141 | 153 | 148 | 139 | 163 | 144 | 137 | 149 | 136 | 156 | 136 | 163 | 132 | 137 | 144 | 149 | 132 | 137 | 168 | 140 | 146.670000 | NaN | NaN | NaN |

| 2 | 29/9/2023 | 151 | 138 | 137 | 161 | 159 | 158 | 157 | 145 | 140 | 158 | 145 | 139 | 151 | 132 | 132 | 146 | 136 | 151 | 167 | 145 | 143 | 151 | 144 | 163 | 150 | 141 | 154 | 148 | 139 | 164 | 144 | 137 | 149 | 136 | 156 | 136 | 163 | 132 | 137 | 144 | 149 | 132 | 138 | 168 | 140 | 146.800000 | NaN | NaN | NaN |

| 3 | 1/10/2023 | 151 | 139 | 137 | 161 | 159 | 158 | 157 | 145 | 140 | 158 | 146 | 139 | 152 | 132 | 132 | 147 | 136 | 151 | 167 | 145 | 143 | 151 | 144 | 163 | 150 | 141 | 154 | 148 | 139 | 164 | 144 | 137 | 149 | 136 | 156 | 136 | 163 | 132 | 137 | 144 | 150 | 132 | 139 | 168 | 140 | 146.930000 | NaN | NaN | NaN |

| 4 | 4/10/2023 | 151 | 139 | 137 | 161 | 159 | 158 | 158 | 145 | 140 | 158 | 146 | 139 | 152 | 132 | 132 | 147 | 137 | 151 | 167 | 145 | 144 | 151 | 144 | 163 | 150 | 141 | 154 | 148 | 139 | 164 | 144 | 138 | 149 | 136 | 156 | 136 | 163 | 132 | 137 | 145 | 150 | 132 | 139 | 168 | 141 | 147.070000 | NaN | NaN | NaN |

| 5 | 6/10/2023 | 151 | 139 | 137 | 161 | 159 | 158 | 158 | 145 | 140 | 158 | 146 | 139 | 152 | 132 | 132 | 147 | 137 | 152 | 168 | 145 | 144 | 151 | 144 | 164 | 150 | 141 | 154 | 149 | 139 | 164 | 144 | 138 | 150 | 136 | 156 | 136 | 163 | 132 | 137 | 146 | 150 | 132 | 139 | 168 | 141 | 147.200000 | NaN | NaN | NaN |

| 6 | 8/10/2023 | 151 | 139 | 137 | 162 | 159 | 158 | 158 | 145 | 140 | 158 | 146 | 139 | 152 | 132 | 132 | 148 | 137 | 152 | 168 | 145 | 144 | 152 | 144 | 164 | 150 | 141 | 154 | 150 | 139 | 164 | 144 | 138 | 151 | 136 | 156 | 136 | 163 | 132 | 138 | 146 | 150 | 132 | 139 | 168 | 141 | 147.330000 | NaN | NaN | NaN |

| 7 | 13/10/2023 | 152 | 139 | 137 | 162 | 160 | 158 | 158 | 145 | 140 | 159 | 147 | 139 | 152 | 132 | 132 | 149 | 137 | 152 | 168 | 145 | 144 | 152 | 144 | 164 | 150 | 141 | 154 | 150 | 139 | 165 | 144 | 138 | 151 | 136 | 156 | 136 | 163 | 132 | 139 | 148 | 150 | 132 | 139 | 169 | 143 | 147.600000 | NaN | NaN | NaN |

| 8 | 15/10/2023 | 152 | 139 | 137 | 163 | 161 | 158 | 158 | 145 | 141 | 159 | 147 | 139 | 152 | 132 | 132 | 149 | 137 | 152 | 168 | 145 | 144 | 152 | 144 | 164 | 150 | 141 | 155 | 150 | 139 | 165 | 144 | 138 | 151 | 137 | 156 | 136 | 163 | 132 | 140 | 148 | 150 | 132 | 139 | 169 | 143 | 147.730000 | NaN | NaN | NaN |

| 9 | 18/10/2023 | 152 | 140 | 137 | 163 | 161 | 158 | 159 | 145 | 141 | 159 | 147 | 139 | 152 | 132 | 132 | 149 | 137 | 153 | 168 | 146 | 144 | 152 | 144 | 165 | 150 | 141 | 155 | 150 | 140 | 165 | 144 | 138 | 151 | 137 | 156 | 136 | 163 | 132 | 140 | 148 | 150 | 132 | 139 | 169 | 143 | 147.870000 | NaN | NaN | NaN |

| 10 | 20/10/2023 | 152 | 140 | 137 | 164 | 161 | 158 | 159 | 145 | 141 | 159 | 147 | 139 | 152 | 132 | 132 | 150 | 137 | 153 | 168 | 146 | 145 | 152 | 144 | 166 | 150 | 142 | 155 | 150 | 140 | 165 | 144 | 138 | 151 | 137 | 156 | 136 | 164 | 132 | 140 | 148 | 150 | 132 | 139 | 169 | 143 | 148.000000 | NaN | NaN | NaN |

| 11 | 22/10/2023 | 152 | 140 | 137 | 164 | 161 | 158 | 159 | 145 | 141 | 160 | 147 | 139 | 153 | 133 | 132 | 150 | 137 | 153 | 169 | 146 | 145 | 152 | 144 | 166 | 150 | 142 | 155 | 150 | 140 | 165 | 144 | 138 | 151 | 137 | 157 | 136 | 164 | 132 | 140 | 149 | 150 | 132 | 139 | 169 | 143 | 148.130000 | NaN | NaN | NaN |

| 12 | 25/10/2023 | 152 | 140 | 137 | 165 | 161 | 159 | 159 | 145 | 141 | 160 | 147 | 139 | 154 | 133 | 132 | 150 | 137 | 153 | 169 | 146 | 145 | 152 | 144 | 166 | 151 | 142 | 155 | 150 | 140 | 165 | 145 | 138 | 151 | 137 | 157 | 136 | 164 | 132 | 140 | 149 | 151 | 132 | 139 | 169 | 143 | 148.270000 | NaN | NaN | NaN |

| 13 | 27/10/2023 | 152 | 140 | 137 | 165 | 161 | 159 | 160 | 145 | 141 | 161 | 147 | 139 | 154 | 134 | 132 | 150 | 137 | 153 | 169 | 146 | 146 | 152 | 144 | 166 | 151 | 143 | 155 | 150 | 140 | 165 | 145 | 138 | 151 | 137 | 157 | 136 | 165 | 132 | 140 | 149 | 151 | 132 | 139 | 169 | 143 | 148.400000 | NaN | NaN | NaN |

| 14 | 29/10/2023 | 152 | 140 | 137 | 165 | 162 | 159 | 161 | 145 | 141 | 161 | 147 | 139 | 154 | 134 | 133 | 150 | 137 | 153 | 169 | 146 | 147 | 152 | 144 | 166 | 151 | 143 | 155 | 150 | 140 | 165 | 145 | 139 | 151 | 137 | 157 | 136 | 165 | 132 | 140 | 149 | 151 | 132 | 139 | 169 | 144 | 148.530000 | NaN | NaN | NaN |

| 15 | 1/11/2023 | 153 | 140 | 138 | 165 | 162 | 159 | 161 | 145 | 141 | 161 | 147 | 139 | 154 | 134 | 134 | 151 | 137 | 153 | 169 | 146 | 147 | 152 | 145 | 166 | 151 | 143 | 155 | 151 | 140 | 165 | 145 | 139 | 151 | 137 | 157 | 136 | 165 | 132 | 140 | 149 | 151 | 132 | 139 | 169 | 144 | 148.670000 | NaN | NaN | NaN |

| 16 | 3/11/2023 | 153 | 141 | 138 | 165 | 162 | 159 | 162 | 145 | 142 | 161 | 147 | 139 | 155 | 134 | 134 | 151 | 137 | 153 | 169 | 146 | 147 | 153 | 145 | 166 | 151 | 143 | 155 | 151 | 140 | 165 | 145 | 139 | 151 | 137 | 157 | 136 | 165 | 133 | 140 | 149 | 151 | 132 | 139 | 169 | 144 | 148.800000 | NaN | NaN | NaN |

| 17 | 5/11/2023 | 154 | 141 | 138 | 165 | 162 | 159 | 162 | 145 | 142 | 161 | 147 | 139 | 156 | 134 | 134 | 152 | 137 | 154 | 169 | 146 | 147 | 153 | 146 | 166 | 152 | 143 | 155 | 151 | 140 | 165 | 145 | 139 | 151 | 137 | 157 | 136 | 165 | 133 | 140 | 149 | 151 | 132 | 139 | 169 | 144 | 148.933333 | NaN | NaN | NaN |

| 18 | 8/11/2023 | 154 | 141 | 138 | 165 | 162 | 159 | 163 | 145 | 142 | 161 | 147 | 139 | 156 | 134 | 134 | 152 | 137 | 154 | 169 | 147 | 147 | 153 | 147 | 166 | 152 | 143 | 156 | 151 | 140 | 165 | 146 | 139 | 152 | 137 | 157 | 136 | 165 | 133 | 140 | 149 | 151 | 132 | 139 | 169 | 144 | 149.070000 | NaN | NaN | NaN |

| 19 | 10/11/2023 | 155 | 141 | 138 | 166 | 162 | 159 | 163 | 145 | 142 | 162 | 147 | 139 | 157 | 135 | 134 | 152 | 137 | 154 | 169 | 147 | 147 | 153 | 147 | 166 | 152 | 143 | 156 | 151 | 140 | 165 | 146 | 139 | 152 | 137 | 157 | 136 | 165 | 133 | 140 | 149 | 151 | 132 | 139 | 170 | 144 | 149.200000 | NaN | NaN | NaN |

| 20 | 12/11/2023 | 155 | 142 | 138 | 167 | 162 | 159 | 163 | 145 | 142 | 163 | 147 | 139 | 157 | 135 | 135 | 152 | 137 | 154 | 169 | 147 | 147 | 153 | 147 | 166 | 152 | 143 | 157 | 151 | 140 | 165 | 147 | 139 | 152 | 137 | 157 | 136 | 165 | 133 | 140 | 149 | 151 | 132 | 139 | 170 | 144 | 149.330000 | NaN | NaN | NaN |

| 21 | 15/11/2023 | 155 | 143 | 139 | 167 | 162 | 159 | 163 | 145 | 142 | 163 | 147 | 140 | 157 | 135 | 135 | 153 | 137 | 154 | 169 | 147 | 147 | 153 | 147 | 166 | 152 | 143 | 157 | 151 | 140 | 166 | 147 | 139 | 152 | 137 | 157 | 136 | 166 | 133 | 140 | 149 | 151 | 132 | 139 | 170 | 144 | 149.466667 | NaN | NaN | NaN |

| 22 | 17/11/2023 | 155 | 143 | 139 | 167 | 162 | 159 | 163 | 145 | 142 | 163 | 147 | 140 | 157 | 135 | 135 | 154 | 137 | 154 | 169 | 148 | 147 | 153 | 147 | 166 | 153 | 144 | 157 | 151 | 140 | 166 | 147 | 139 | 152 | 137 | 157 | 137 | 166 | 133 | 140 | 149 | 152 | 132 | 139 | 170 | 144 | 149.600000 | NaN | NaN | NaN |

| 23 | 19/11/2023 | 156 | 143 | 140 | 167 | 162 | 159 | 163 | 145 | 142 | 163 | 147 | 140 | 157 | 135 | 135 | 154 | 137 | 154 | 170 | 149 | 147 | 153 | 147 | 166 | 153 | 145 | 157 | 151 | 140 | 166 | 147 | 139 | 152 | 138 | 157 | 137 | 166 | 133 | 140 | 149 | 152 | 132 | 139 | 170 | 144 | 149.733333 | NaN | NaN | NaN |

| 24 | 22/11/2023 | 156 | 143 | 140 | 167 | 162 | 159 | 163 | 145 | 142 | 163 | 147 | 140 | 157 | 135 | 136 | 154 | 137 | 155 | 170 | 150 | 147 | 153 | 148 | 166 | 153 | 145 | 157 | 151 | 140 | 166 | 147 | 139 | 152 | 138 | 157 | 137 | 167 | 133 | 141 | 149 | 152 | 132 | 139 | 170 | 144 | 149.866667 | NaN | NaN | NaN |

| 25 | 24/11/2023 | 156 | 143 | 140 | 167 | 163 | 159 | 163 | 145 | 142 | 163 | 147 | 140 | 157 | 135 | 136 | 154 | 137 | 156 | 170 | 150 | 147 | 154 | 148 | 166 | 153 | 145 | 157 | 151 | 140 | 166 | 147 | 139 | 152 | 139 | 157 | 137 | 167 | 133 | 141 | 149 | 153 | 132 | 139 | 170 | 145 | 150.000000 | NaN | NaN | NaN |

| 26 | 26/11/2023 | 156 | 143 | 140 | 168 | 163 | 160 | 163 | 145 | 142 | 163 | 147 | 140 | 157 | 135 | 137 | 154 | 137 | 156 | 170 | 150 | 147 | 154 | 149 | 166 | 154 | 145 | 157 | 151 | 140 | 166 | 147 | 139 | 152 | 139 | 157 | 138 | 167 | 133 | 141 | 149 | 153 | 132 | 139 | 170 | 145 | 150.133333 | NaN | NaN | NaN |

| 27 | 29/11/2023 | 156 | 143 | 140 | 168 | 163 | 160 | 163 | 145 | 143 | 163 | 147 | 140 | 157 | 135 | 137 | 154 | 137 | 156 | 170 | 150 | 147 | 155 | 149 | 167 | 154 | 145 | 157 | 151 | 140 | 166 | 147 | 140 | 152 | 139 | 157 | 138 | 167 | 134 | 142 | 149 | 153 | 132 | 139 | 170 | 145 | 150.266667 | NaN | NaN | NaN |

| 28 | 1/12/2023 | 156 | 143 | 140 | 168 | 164 | 160 | 163 | 145 | 143 | 164 | 147 | 140 | 157 | 136 | 137 | 154 | 137 | 156 | 170 | 150 | 148 | 155 | 149 | 167 | 154 | 145 | 158 | 151 | 140 | 166 | 147 | 141 | 152 | 139 | 157 | 138 | 167 | 134 | 142 | 149 | 153 | 132 | 139 | 170 | 145 | 150.400000 | NaN | NaN | NaN |

| 29 | 3/12/2023 | 156 | 143 | 140 | 168 | 164 | 160 | 163 | 145 | 143 | 164 | 147 | 141 | 157 | 137 | 137 | 155 | 137 | 156 | 170 | 150 | 149 | 155 | 149 | 167 | 154 | 145 | 158 | 151 | 141 | 166 | 147 | 142 | 152 | 139 | 157 | 138 | 167 | 134 | 142 | 149 | 153 | 132 | 139 | 170 | 145 | 150.533333 | NaN | NaN | NaN |

| 30 | 6/12/2023 | 156 | 143 | 140 | 168 | 164 | 160 | 163 | 145 | 143 | 164 | 147 | 141 | 157 | 137 | 137 | 155 | 137 | 157 | 171 | 151 | 149 | 155 | 149 | 167 | 154 | 145 | 158 | 151 | 142 | 166 | 147 | 142 | 152 | 139 | 157 | 138 | 167 | 134 | 142 | 149 | 154 | 133 | 139 | 170 | 145 | 150.666667 | NaN | NaN | NaN |

| 31 | 8/12/2023 | 156 | 143 | 140 | 168 | 164 | 160 | 163 | 145 | 143 | 164 | 148 | 141 | 157 | 137 | 138 | 156 | 138 | 157 | 171 | 151 | 149 | 155 | 149 | 167 | 154 | 145 | 158 | 151 | 142 | 166 | 147 | 142 | 152 | 139 | 157 | 138 | 167 | 134 | 142 | 149 | 154 | 134 | 140 | 170 | 145 | 150.800000 | NaN | NaN | NaN |

| 32 | 10/12/2023 | 156 | 143 | 140 | 168 | 164 | 160 | 163 | 145 | 144 | 165 | 149 | 141 | 157 | 137 | 138 | 156 | 139 | 157 | 171 | 151 | 149 | 155 | 149 | 167 | 154 | 145 | 158 | 151 | 142 | 166 | 147 | 142 | 152 | 139 | 157 | 138 | 167 | 134 | 142 | 149 | 155 | 134 | 140 | 171 | 145 | 150.933333 | NaN | NaN | NaN |

| 33 | 13/12/2023 | 156 | 143 | 141 | 168 | 164 | 160 | 164 | 145 | 144 | 165 | 150 | 141 | 157 | 137 | 138 | 156 | 139 | 157 | 171 | 152 | 149 | 155 | 149 | 167 | 154 | 145 | 158 | 152 | 142 | 166 | 147 | 142 | 152 | 139 | 157 | 138 | 167 | 134 | 142 | 149 | 155 | 134 | 140 | 172 | 145 | 151.066667 | NaN | NaN | NaN |

| 34 | 15/12/2023 | 157 | 143 | 141 | 168 | 165 | 160 | 164 | 145 | 144 | 166 | 151 | 141 | 157 | 137 | 138 | 156 | 139 | 157 | 171 | 153 | 149 | 155 | 149 | 167 | 154 | 145 | 158 | 152 | 142 | 166 | 147 | 142 | 152 | 139 | 157 | 138 | 167 | 134 | 142 | 150 | 155 | 134 | 140 | 172 | 145 | 151.200000 | NaN | NaN | NaN |

| 35 | 17/12/2023 | 157 | 143 | 142 | 168 | 165 | 160 | 165 | 145 | 144 | 166 | 151 | 141 | 157 | 137 | 138 | 156 | 139 | 158 | 171 | 154 | 149 | 155 | 149 | 167 | 154 | 145 | 158 | 152 | 142 | 166 | 148 | 142 | 153 | 139 | 157 | 138 | 167 | 134 | 142 | 150 | 155 | 134 | 140 | 172 | 145 | 151.333333 | NaN | NaN | NaN |

| 36 | 20/12/2023 | 157 | 143 | 142 | 168 | 166 | 160 | 165 | 145 | 144 | 166 | 151 | 141 | 157 | 137 | 139 | 157 | 139 | 158 | 171 | 154 | 150 | 156 | 149 | 167 | 154 | 145 | 158 | 152 | 142 | 166 | 148 | 143 | 153 | 139 | 157 | 138 | 167 | 134 | 142 | 150 | 155 | 134 | 140 | 172 | 145 | 151.466667 | NaN | NaN | NaN |

| 37 | 22/12/2023 | 157 | 144 | 142 | 168 | 166 | 160 | 165 | 145 | 144 | 166 | 151 | 142 | 157 | 138 | 139 | 158 | 139 | 158 | 171 | 154 | 150 | 156 | 149 | 167 | 154 | 145 | 158 | 152 | 142 | 166 | 148 | 143 | 153 | 140 | 157 | 138 | 167 | 135 | 142 | 150 | 155 | 134 | 140 | 172 | 145 | 151.600000 | NaN | NaN | NaN |

| 38 | 24/12/2023 | 158 | 145 | 142 | 168 | 167 | 160 | 165 | 145 | 144 | 166 | 151 | 142 | 157 | 138 | 139 | 158 | 139 | 158 | 171 | 154 | 150 | 156 | 149 | 168 | 154 | 145 | 158 | 152 | 142 | 166 | 148 | 143 | 153 | 140 | 157 | 138 | 167 | 135 | 142 | 151 | 155 | 134 | 141 | 172 | 145 | 151.733333 | NaN | NaN | NaN |

| 39 | 27/12/2023 | 158 | 145 | 142 | 168 | 167 | 160 | 165 | 146 | 144 | 166 | 151 | 142 | 157 | 138 | 139 | 159 | 139 | 158 | 171 | 154 | 150 | 156 | 150 | 168 | 154 | 145 | 158 | 152 | 142 | 166 | 148 | 143 | 153 | 141 | 157 | 139 | 167 | 135 | 143 | 151 | 155 | 134 | 141 | 172 | 145 | 151.866667 | NaN | NaN | NaN |

| 40 | 29/12/2023 | 158 | 145 | 142 | 168 | 167 | 160 | 165 | 146 | 144 | 166 | 151 | 142 | 157 | 138 | 139 | 160 | 139 | 158 | 171 | 155 | 150 | 157 | 150 | 168 | 154 | 145 | 158 | 152 | 142 | 166 | 148 | 143 | 153 | 141 | 158 | 139 | 168 | 135 | 144 | 151 | 155 | 134 | 141 | 172 | 145 | 152.000000 | NaN | NaN | NaN |

| 41 | 31/12/2023 | 158 | 145 | 142 | 168 | 167 | 160 | 165 | 146 | 144 | 166 | 151 | 142 | 158 | 139 | 139 | 160 | 139 | 158 | 171 | 155 | 150 | 157 | 151 | 168 | 155 | 145 | 158 | 152 | 142 | 166 | 148 | 143 | 153 | 142 | 158 | 139 | 168 | 135 | 144 | 151 | 155 | 134 | 141 | 173 | 145 | 152.133333 | NaN | NaN | NaN |

| 42 | 3/1/2024 | 158 | 145 | 142 | 168 | 167 | 160 | 165 | 146 | 145 | 166 | 151 | 142 | 158 | 140 | 139 | 160 | 139 | 158 | 172 | 156 | 150 | 157 | 151 | 168 | 155 | 145 | 158 | 152 | 143 | 166 | 148 | 143 | 153 | 142 | 158 | 139 | 168 | 135 | 144 | 152 | 155 | 134 | 141 | 173 | 145 | 152.266667 | NaN | NaN | NaN |

| 43 | 5/1/2024 | 158 | 145 | 142 | 168 | 167 | 160 | 165 | 146 | 146 | 166 | 151 | 142 | 158 | 140 | 139 | 161 | 139 | 158 | 172 | 156 | 150 | 157 | 151 | 168 | 155 | 145 | 158 | 152 | 144 | 166 | 149 | 143 | 154 | 142 | 158 | 139 | 168 | 135 | 144 | 152 | 155 | 135 | 141 | 173 | 145 | 152.400000 | NaN | NaN | NaN |

| 44 | 7/1/2024 | 158 | 145 | 143 | 169 | 167 | 160 | 165 | 146 | 146 | 166 | 151 | 142 | 158 | 140 | 140 | 161 | 139 | 159 | 172 | 156 | 150 | 157 | 151 | 168 | 155 | 145 | 158 | 152 | 144 | 166 | 149 | 143 | 154 | 142 | 158 | 140 | 168 | 135 | 144 | 152 | 155 | 135 | 141 | 173 | 146 | 152.533333 | NaN | NaN | NaN |

| 45 | 10/1/2024 | 158 | 145 | 143 | 169 | 167 | 160 | 165 | 146 | 146 | 167 | 151 | 143 | 158 | 140 | 140 | 161 | 139 | 160 | 173 | 156 | 150 | 157 | 151 | 168 | 155 | 145 | 158 | 152 | 145 | 166 | 149 | 143 | 154 | 142 | 158 | 140 | 168 | 135 | 144 | 152 | 155 | 135 | 142 | 173 | 146 | 152.666667 | NaN | NaN | NaN |

| 46 | 12/1/2024 | 158 | 145 | 143 | 169 | 167 | 160 | 165 | 146 | 146 | 168 | 152 | 143 | 158 | 140 | 140 | 161 | 139 | 160 | 173 | 157 | 150 | 157 | 151 | 168 | 155 | 145 | 159 | 152 | 145 | 166 | 149 | 143 | 154 | 142 | 158 | 140 | 168 | 135 | 145 | 152 | 155 | 135 | 143 | 173 | 146 | 152.800000 | NaN | NaN | NaN |

| 47 | 14/1/2024 | 158 | 146 | 143 | 169 | 167 | 160 | 165 | 147 | 146 | 168 | 152 | 143 | 158 | 140 | 140 | 161 | 139 | 160 | 174 | 158 | 150 | 157 | 151 | 169 | 155 | 145 | 159 | 152 | 145 | 166 | 149 | 143 | 154 | 142 | 158 | 140 | 168 | 135 | 145 | 152 | 155 | 136 | 143 | 173 | 146 | 152.933333 | NaN | NaN | NaN |

| 48 | 17/1/2024 | 158 | 146 | 143 | 169 | 167 | 160 | 165 | 147 | 146 | 168 | 152 | 143 | 158 | 141 | 140 | 161 | 139 | 160 | 175 | 158 | 151 | 157 | 151 | 169 | 155 | 145 | 159 | 152 | 145 | 166 | 149 | 143 | 154 | 142 | 158 | 141 | 168 | 135 | 145 | 152 | 155 | 136 | 144 | 174 | 146 | 153.066667 | NaN | NaN | NaN |

| 49 | 19/1/2024 | 158 | 146 | 143 | 169 | 167 | 160 | 165 | 148 | 146 | 168 | 152 | 143 | 158 | 141 | 141 | 161 | 139 | 160 | 175 | 159 | 151 | 157 | 151 | 170 | 155 | 145 | 159 | 152 | 145 | 166 | 149 | 143 | 154 | 142 | 158 | 141 | 168 | 135 | 145 | 152 | 155 | 136 | 145 | 175 | 146 | 153.200000 | NaN | NaN | NaN |

| 50 | 21/1/2024 | 158 | 146 | 143 | 169 | 167 | 160 | 165 | 148 | 146 | 168 | 153 | 143 | 158 | 141 | 141 | 161 | 139 | 160 | 175 | 160 | 151 | 158 | 152 | 170 | 155 | 146 | 159 | 152 | 145 | 166 | 150 | 143 | 154 | 142 | 158 | 141 | 168 | 135 | 145 | 152 | 155 | 136 | 145 | 175 | 146 | 153.333333 | NaN | NaN | NaN |

| 51 | 24/1/2024 | 158 | 146 | 143 | 169 | 167 | 160 | 166 | 148 | 146 | 168 | 153 | 143 | 158 | 141 | 141 | 161 | 139 | 160 | 175 | 160 | 151 | 158 | 152 | 170 | 155 | 146 | 160 | 152 | 145 | 167 | 150 | 143 | 154 | 142 | 158 | 142 | 168 | 135 | 146 | 152 | 155 | 136 | 145 | 175 | 147 | 153.466667 | NaN | NaN | NaN |

| 52 | 26/1/2024 | 158 | 146 | 143 | 169 | 167 | 160 | 166 | 149 | 146 | 168 | 153 | 143 | 158 | 141 | 141 | 161 | 139 | 160 | 176 | 160 | 151 | 159 | 152 | 170 | 155 | 146 | 161 | 152 | 145 | 167 | 151 | 143 | 154 | 142 | 159 | 142 | 168 | 135 | 146 | 152 | 155 | 136 | 145 | 175 | 147 | 153.600000 | NaN | NaN | NaN |

| 53 | 28/1/2024 | 158 | 146 | 144 | 169 | 167 | 160 | 166 | 149 | 146 | 168 | 153 | 143 | 158 | 141 | 141 | 161 | 139 | 160 | 176 | 160 | 151 | 159 | 153 | 170 | 156 | 146 | 161 | 152 | 146 | 167 | 151 | 143 | 154 | 142 | 159 | 143 | 168 | 135 | 146 | 152 | 156 | 136 | 146 | 175 | 147 | 153.755556 | NaN | NaN | NaN |

| 54 | 31/1/2024 | 158 | 146 | 144 | 169 | 167 | 160 | 166 | 149 | 147 | 168 | 154 | 143 | 158 | 141 | 142 | 161 | 139 | 160 | 176 | 160 | 151 | 159 | 153 | 170 | 156 | 146 | 161 | 152 | 146 | 167 | 151 | 143 | 154 | 142 | 160 | 143 | 168 | 136 | 146 | 152 | 157 | 136 | 146 | 175 | 147 | 153.888889 | NaN | NaN | NaN |

| 55 | 2/2/2024 | 159 | 146 | 144 | 169 | 167 | 160 | 166 | 149 | 147 | 168 | 154 | 143 | 158 | 141 | 143 | 161 | 139 | 160 | 176 | 160 | 151 | 159 | 153 | 170 | 156 | 146 | 161 | 152 | 147 | 167 | 152 | 144 | 154 | 143 | 160 | 143 | 168 | 136 | 146 | 152 | 157 | 136 | 146 | 175 | 147 | 154.022222 | NaN | NaN | NaN |

| 56 | 4/2/2024 | 159 | 146 | 144 | 169 | 167 | 160 | 166 | 149 | 148 | 168 | 154 | 143 | 158 | 141 | 144 | 161 | 139 | 160 | 176 | 160 | 152 | 159 | 153 | 170 | 156 | 146 | 161 | 152 | 148 | 167 | 152 | 144 | 155 | 143 | 160 | 143 | 168 | 136 | 147 | 152 | 157 | 136 | 146 | 175 | 147 | 154.155556 | NaN | NaN | NaN |

| 57 | 7/2/2024 | 159 | 146 | 144 | 169 | 167 | 160 | 166 | 149 | 148 | 168 | 154 | 143 | 158 | 141 | 144 | 161 | 140 | 160 | 176 | 160 | 153 | 159 | 153 | 171 | 157 | 146 | 161 | 152 | 148 | 167 | 152 | 144 | 155 | 143 | 160 | 143 | 168 | 136 | 148 | 152 | 157 | 137 | 146 | 175 | 147 | 154.288889 | NaN | NaN | NaN |

| 58 | 11/2/2024 | 159 | 146 | 144 | 169 | 167 | 160 | 167 | 149 | 148 | 168 | 154 | 143 | 158 | 141 | 144 | 161 | 140 | 161 | 176 | 160 | 153 | 159 | 153 | 171 | 157 | 146 | 161 | 152 | 148 | 167 | 153 | 144 | 156 | 143 | 161 | 143 | 168 | 136 | 148 | 152 | 158 | 137 | 146 | 175 | 147 | 154.422222 | NaN | NaN | NaN |

| 59 | 14/2/2024 | 159 | 146 | 144 | 169 | 167 | 160 | 167 | 150 | 149 | 168 | 155 | 144 | 158 | 141 | 144 | 161 | 140 | 161 | 176 | 160 | 153 | 159 | 153 | 171 | 157 | 146 | 161 | 152 | 148 | 167 | 153 | 144 | 156 | 143 | 161 | 143 | 168 | 136 | 148 | 153 | 158 | 137 | 146 | 176 | 147 | 154.555556 | NaN | NaN | NaN |

| 60 | 16/2/2024 | 159 | 146 | 144 | 169 | 167 | 161 | 167 | 150 | 149 | 169 | 155 | 144 | 158 | 141 | 144 | 162 | 140 | 161 | 176 | 161 | 153 | 159 | 153 | 171 | 157 | 146 | 161 | 152 | 148 | 167 | 153 | 144 | 156 | 143 | 161 | 143 | 168 | 136 | 148 | 154 | 158 | 138 | 146 | 176 | 147 | 154.688889 | NaN | NaN | NaN |

| 61 | 18/2/2024 | 159 | 146 | 144 | 169 | 168 | 161 | 167 | 150 | 149 | 169 | 155 | 144 | 158 | 141 | 144 | 162 | 140 | 161 | 177 | 162 | 154 | 159 | 153 | 172 | 157 | 146 | 161 | 152 | 148 | 167 | 153 | 144 | 156 | 143 | 161 | 143 | 168 | 136 | 148 | 155 | 158 | 138 | 146 | 176 | 147 | 154.822222 | NaN | NaN | NaN |

| 62 | 21/2/2024 | 159 | 147 | 144 | 169 | 168 | 161 | 167 | 151 | 149 | 169 | 155 | 144 | 158 | 142 | 144 | 162 | 140 | 161 | 178 | 162 | 154 | 159 | 153 | 173 | 157 | 146 | 161 | 152 | 148 | 167 | 153 | 144 | 156 | 143 | 161 | 143 | 168 | 136 | 148 | 155 | 158 | 139 | 146 | 176 | 147 | 154.955556 | NaN | NaN | NaN |

| 63 | 23/2/2024 | 159 | 147 | 144 | 170 | 168 | 161 | 167 | 151 | 149 | 169 | 155 | 144 | 158 | 142 | 144 | 162 | 141 | 161 | 179 | 162 | 154 | 159 | 153 | 173 | 157 | 146 | 162 | 153 | 148 | 167 | 153 | 144 | 156 | 143 | 161 | 144 | 168 | 136 | 148 | 155 | 158 | 139 | 146 | 176 | 147 | 155.088889 | NaN | NaN | NaN |

# Chuyển đổi cột ngày tháng thành định dạng 'yyyy/mm/dd'

df['Date'] = pd.to_datetime(df['Date'], format='%d/%m/%Y')

# Hiển thị DataFrame đã chuyển đổi

print(f"Date range of gold from - {df.loc[:,'Date'][0]} to {df.loc[:,'Date'][len(df)-1]}")

# Tạo DatetimeIndex từ '9/28/2023' đến ngày cuối cùng trong DataFrame df

daterange = pd.date_range(start='9/24/2023', end=df.loc[:, 'Date'].iloc[-1], freq='D')

formatted_date = daterange.strftime('%d/%m/%Y')

# Thay thế ngày cuối cùng bằng ngày trong DataFrame df

print(formatted_date)Date range of gold from - 2023-09-24 00:00:00 to 2024-02-23 00:00:00

Index(['24/09/2023', '25/09/2023', '26/09/2023', '27/09/2023', '28/09/2023',

'29/09/2023', '30/09/2023', '01/10/2023', '02/10/2023', '03/10/2023',

...

'14/02/2024', '15/02/2024', '16/02/2024', '17/02/2024', '18/02/2024',

'19/02/2024', '20/02/2024', '21/02/2024', '22/02/2024', '23/02/2024'],

dtype='object', length=153)

df = df.drop_duplicates()

df.shape(64, 50)

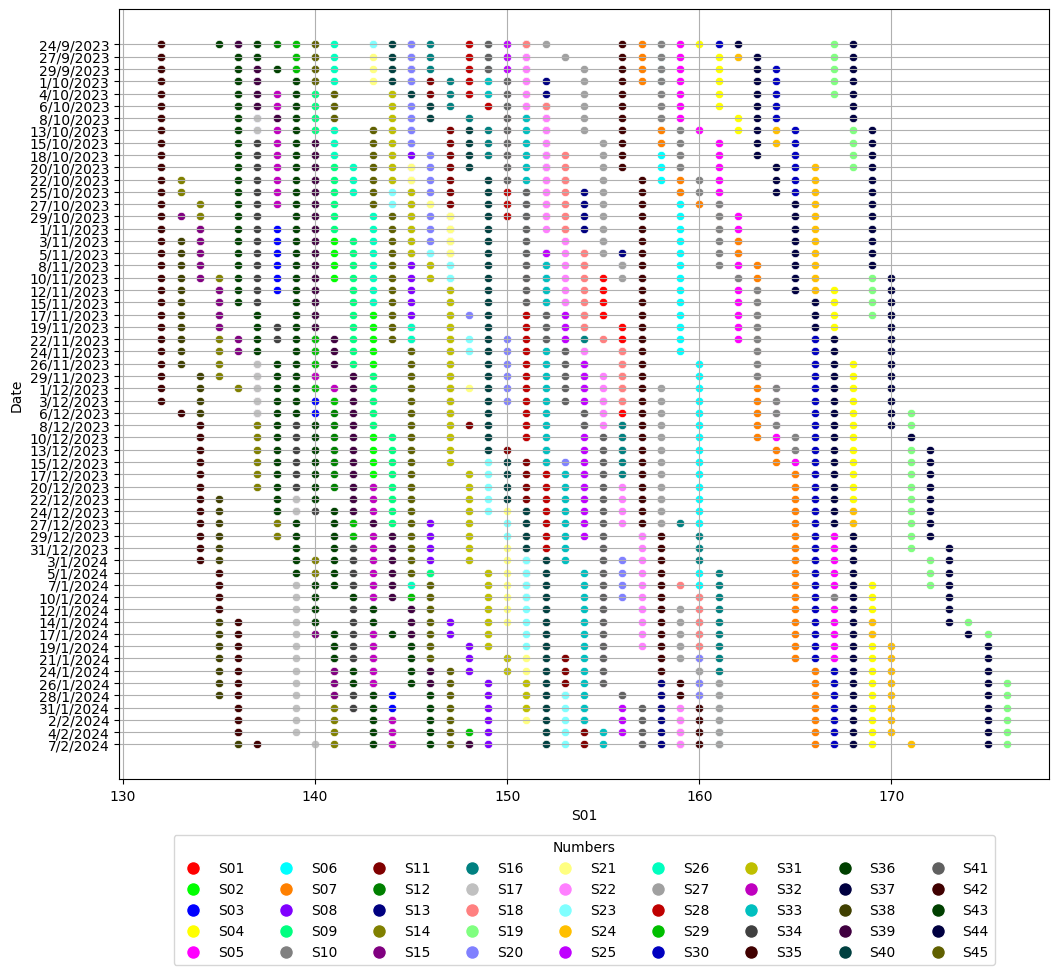

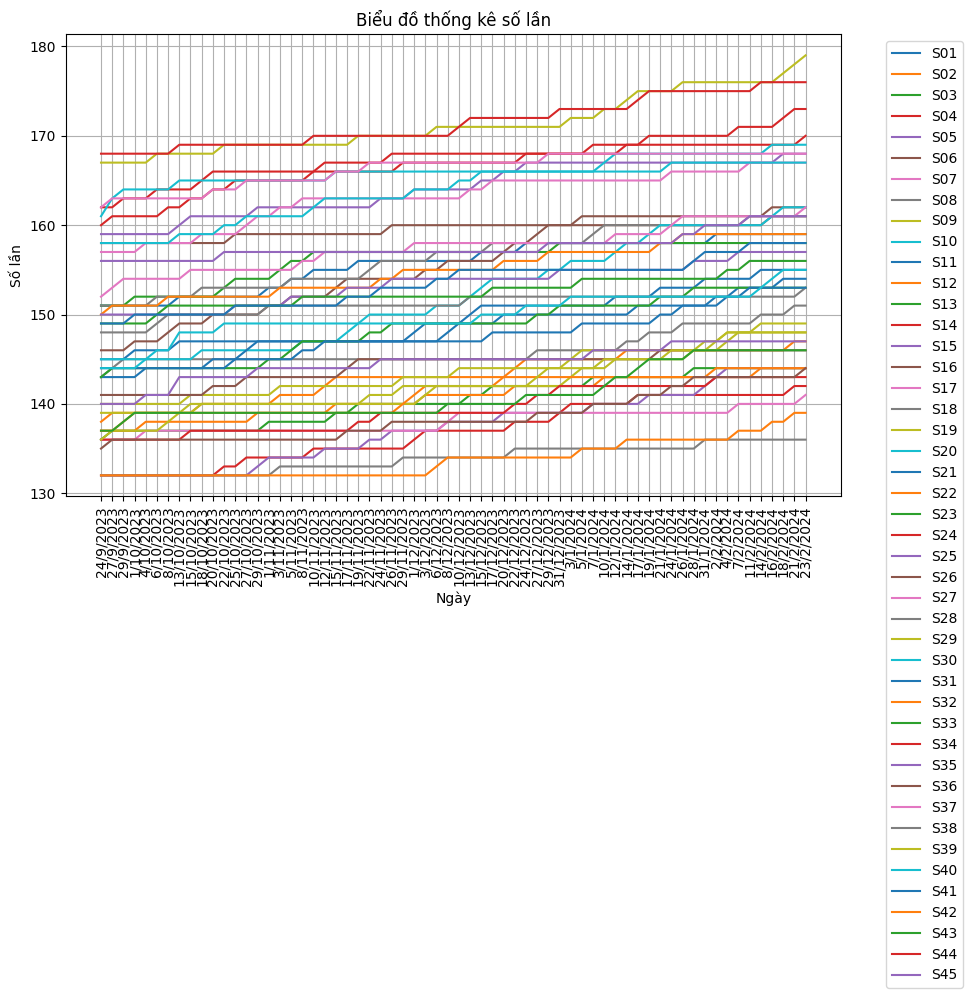

import pandas as pd

import matplotlib.pyplot as plt

# Đọc dữ liệu từ file csv

data = pd.read_csv(r"C:\Python311\workspaces\m6B45.csv")

# Thiết lập kích thước biểu đồ

plt.figure(figsize=(10, 6))

# Vẽ các đường line từ S01 đến S45

for column in data.columns[1:46]:

plt.plot(data['Date'], data[column], label=column)

# Thiết lập tiêu đề và các trục

plt.title('Biểu đồ thống kê số lần')

plt.xlabel('Ngày')

plt.ylabel('Số lần')

# Xoay đứng trục ngày tháng

plt.xticks(rotation='vertical')

# Hiển thị grid

plt.grid(True)

# Hiển thị chú thích

plt.legend(bbox_to_anchor=(1.05, 1), loc='upper left')

# Hiển thị biểu đồ

plt.show()

round(df.describe(),2).dataframe tbody tr th {

vertical-align: top;

}

.dataframe thead th {

text-align: right;

}

| Date | S01 | S02 | S03 | S04 | S05 | S06 | S07 | S08 | S09 | S10 | S11 | S12 | S13 | S14 | S15 | S16 | S17 | S18 | S19 | S20 | S21 | S22 | S23 | S24 | S25 | S26 | S27 | S28 | S29 | S30 | S31 | S32 | S33 | S34 | S35 | S36 | S37 | S38 | S39 | S40 | S41 | S42 | S43 | S44 | S45 | ST | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| count | 64 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.0 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 | 64.00 |

| mean | 2023-12-09 03:00:00 | 155.75 | 143.02 | 140.48 | 166.73 | 164.08 | 159.47 | 163.08 | 146.14 | 143.73 | 164.08 | 149.55 | 141.00 | 156.14 | 136.84 | 137.38 | 155.5 | 138.08 | 156.44 | 171.36 | 152.27 | 148.44 | 155.05 | 148.56 | 167.27 | 153.44 | 144.16 | 157.48 | 151.09 | 142.34 | 165.70 | 147.64 | 140.98 | 152.55 | 139.44 | 157.64 | 138.58 | 166.30 | 133.91 | 142.34 | 149.88 | 153.48 | 133.84 | 141.08 | 171.50 | 144.62 | 150.85 |

| min | 2023-09-24 00:00:00 | 151.00 | 137.00 | 136.00 | 160.00 | 159.00 | 158.00 | 157.00 | 143.00 | 140.00 | 158.00 | 145.00 | 138.00 | 151.00 | 132.00 | 132.00 | 146.0 | 136.00 | 151.00 | 167.00 | 145.00 | 143.00 | 150.00 | 143.00 | 162.00 | 150.00 | 141.00 | 152.00 | 148.00 | 139.00 | 161.00 | 144.00 | 137.00 | 149.00 | 136.00 | 156.00 | 135.00 | 162.00 | 132.00 | 136.00 | 144.00 | 149.00 | 132.00 | 137.00 | 168.00 | 140.00 | 146.40 |

| 25% | 2023-11-02 12:00:00 | 153.00 | 140.75 | 138.00 | 165.00 | 162.00 | 159.00 | 161.75 | 145.00 | 141.75 | 161.00 | 147.00 | 139.00 | 154.75 | 134.00 | 134.00 | 151.0 | 137.00 | 153.00 | 169.00 | 146.00 | 147.00 | 152.75 | 145.00 | 166.00 | 151.00 | 143.00 | 155.00 | 151.00 | 140.00 | 165.00 | 145.00 | 139.00 | 151.00 | 137.00 | 157.00 | 136.00 | 165.00 | 132.75 | 140.00 | 149.00 | 151.00 | 132.00 | 139.00 | 169.00 | 144.00 | 148.77 |

| 50% | 2023-12-09 00:00:00 | 156.00 | 143.00 | 140.00 | 168.00 | 164.00 | 160.00 | 163.00 | 145.00 | 143.50 | 164.50 | 148.50 | 141.00 | 157.00 | 137.00 | 138.00 | 156.0 | 138.50 | 157.00 | 171.00 | 151.00 | 149.00 | 155.00 | 149.00 | 167.00 | 154.00 | 145.00 | 158.00 | 151.00 | 142.00 | 166.00 | 147.00 | 142.00 | 152.00 | 139.00 | 157.00 | 138.00 | 167.00 | 134.00 | 142.00 | 149.00 | 154.50 | 134.00 | 140.00 | 170.50 | 145.00 | 150.87 |

| 75% | 2024-01-14 18:00:00 | 158.00 | 146.00 | 143.00 | 169.00 | 167.00 | 160.00 | 165.00 | 147.00 | 146.00 | 168.00 | 152.00 | 143.00 | 158.00 | 140.25 | 140.00 | 161.0 | 139.00 | 160.00 | 174.25 | 158.00 | 150.25 | 157.00 | 151.00 | 169.00 | 155.00 | 145.00 | 159.00 | 152.00 | 145.00 | 166.00 | 149.00 | 143.00 | 154.00 | 142.00 | 158.00 | 140.25 | 168.00 | 135.00 | 145.00 | 152.00 | 155.00 | 136.00 | 143.25 | 173.25 | 146.00 | 152.97 |

| max | 2024-02-23 00:00:00 | 159.00 | 147.00 | 144.00 | 170.00 | 168.00 | 161.00 | 167.00 | 151.00 | 149.00 | 169.00 | 155.00 | 144.00 | 158.00 | 142.00 | 144.00 | 162.0 | 141.00 | 161.00 | 179.00 | 162.00 | 154.00 | 159.00 | 153.00 | 173.00 | 157.00 | 146.00 | 162.00 | 153.00 | 148.00 | 167.00 | 153.00 | 144.00 | 156.00 | 143.00 | 161.00 | 144.00 | 168.00 | 136.00 | 148.00 | 155.00 | 158.00 | 139.00 | 146.00 | 176.00 | 147.00 | 155.09 |

| std | NaN | 2.77 | 2.75 | 2.67 | 2.69 | 2.97 | 0.87 | 3.03 | 1.88 | 2.76 | 3.63 | 3.13 | 1.81 | 2.33 | 3.41 | 4.05 | 5.2 | 1.26 | 3.30 | 3.18 | 5.89 | 3.03 | 2.78 | 3.29 | 2.52 | 2.29 | 1.75 | 2.42 | 1.20 | 3.04 | 1.09 | 2.82 | 2.43 | 1.85 | 2.53 | 1.47 | 2.65 | 1.88 | 1.44 | 3.27 | 2.55 | 2.72 | 2.08 | 2.86 | 2.64 | 1.94 | 2.51 |

df.columnsIndex(['Date', 'S01', 'S02', 'S03', 'S04', 'S05', 'S06', 'S07', 'S08', 'S09',

'S10', 'S11', 'S12', 'S13', 'S14', 'S15', 'S16', 'S17', 'S18', 'S19',

'S20', 'S21', 'S22', 'S23', 'S24', 'S25', 'S26', 'S27', 'S28', 'S29',

'S30', 'S31', 'S32', 'S33', 'S34', 'S35', 'S36', 'S37', 'S38', 'S39',

'S40', 'S41', 'S42', 'S43', 'S44', 'S45', 'ST', 'Link', 'Type', 'BD'],

dtype='object')

df.info()<class 'pandas.core.frame.DataFrame'>

RangeIndex: 64 entries, 0 to 63

Data columns (total 50 columns):

# Column Non-Null Count Dtype

--- ------ -------------- -----

0 Date 64 non-null datetime64[ns]

1 S01 64 non-null int64

2 S02 64 non-null int64

3 S03 64 non-null int64

4 S04 64 non-null int64

5 S05 64 non-null int64

6 S06 64 non-null int64

7 S07 64 non-null int64

8 S08 64 non-null int64

9 S09 64 non-null int64

10 S10 64 non-null int64

11 S11 64 non-null int64

12 S12 64 non-null int64

13 S13 64 non-null int64

14 S14 64 non-null int64

15 S15 64 non-null int64

16 S16 64 non-null int64

17 S17 64 non-null int64

18 S18 64 non-null int64

19 S19 64 non-null int64

20 S20 64 non-null int64

21 S21 64 non-null int64

22 S22 64 non-null int64

23 S23 64 non-null int64

24 S24 64 non-null int64

25 S25 64 non-null int64

26 S26 64 non-null int64

27 S27 64 non-null int64

28 S28 64 non-null int64

29 S29 64 non-null int64

30 S30 64 non-null int64

31 S31 64 non-null int64

32 S32 64 non-null int64

33 S33 64 non-null int64

34 S34 64 non-null int64

35 S35 64 non-null int64

36 S36 64 non-null int64

37 S37 64 non-null int64

38 S38 64 non-null int64

39 S39 64 non-null int64

40 S40 64 non-null int64

41 S41 64 non-null int64

42 S42 64 non-null int64

43 S43 64 non-null int64

44 S44 64 non-null int64

45 S45 64 non-null int64

46 ST 64 non-null float64

47 Link 1 non-null object

48 Type 1 non-null object

49 BD 1 non-null object

dtypes: datetime64[ns](1), float64(1), int64(45), object(3)

memory usage: 25.1+ KB

df.isnull().sum()Date 0

S01 0

S02 0

S03 0

S04 0

S05 0

S06 0

S07 0

S08 0

S09 0

S10 0

S11 0

S12 0

S13 0

S14 0

S15 0

S16 0

S17 0

S18 0

S19 0

S20 0

S21 0

S22 0

S23 0

S24 0

S25 0

S26 0

S27 0

S28 0

S29 0

S30 0

S31 0

S32 0

S33 0

S34 0

S35 0

S36 0

S37 0

S38 0

S39 0

S40 0

S41 0

S42 0

S43 0

S44 0

S45 0

ST 0

Link 63

Type 63

BD 63

dtype: int64

df.isnull().dataframe tbody tr th {

vertical-align: top;

}

.dataframe thead th {

text-align: right;

}

| Date | S01 | S02 | S03 | S04 | S05 | S06 | S07 | S08 | S09 | S10 | S11 | S12 | S13 | S14 | S15 | S16 | S17 | S18 | S19 | S20 | S21 | S22 | S23 | S24 | S25 | S26 | S27 | S28 | S29 | S30 | S31 | S32 | S33 | S34 | S35 | S36 | S37 | S38 | S39 | S40 | S41 | S42 | S43 | S44 | S45 | ST | Link | Type | BD | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False |

| 1 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 2 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 3 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 4 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 5 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 6 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 7 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 8 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 9 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 10 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 11 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 12 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 13 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 14 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 15 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 16 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 17 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 18 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 19 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 20 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 21 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 22 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 23 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 24 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 25 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 26 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 27 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 28 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 29 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 30 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 31 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 32 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 33 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 34 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 35 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 36 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 37 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 38 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 39 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 40 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 41 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 42 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 43 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 44 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 45 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 46 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 47 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 48 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 49 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 50 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 51 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 52 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 53 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 54 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 55 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 56 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 57 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 58 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 59 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 60 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 61 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 62 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

| 63 | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | False | True | True | True |

df.duplicated().sum()0

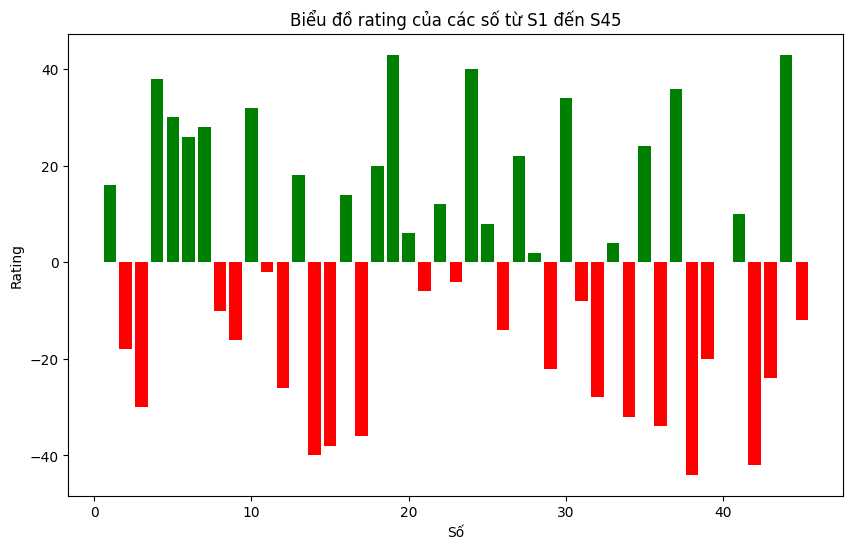

#EDA --> Explorer Data Analysis:

import pandas as pd

# Đặt display.max_rows thành một số lớn hơn số hàng trong DataFrame

pd.set_option("display.max_rows", df.shape[0] + 1)

pd.set_option("display.max_columns", 60)

# Hiển thị mô tả thống kê với tất cả các hàng giá trị

#df.describe()

round(df.describe().T,2)

# Trong hàm df.describe().T, cột "std" đại diện cho độ lệch chuẩn (standard deviation) của dữ liệu trong các cột tương ứng.

# Độ lệch chuẩn là một số đo mô tả mức độ phân tán của dữ liệu xung quanh giá trị trung bình.

# Công thức tính độ lệch chuẩn là căn bậc hai của phương sai (variance), và được tính bằng cách lấy căn bậc hai của trung bình của

# bình phương của độ lệch của mỗi giá trị dữ liệu so với giá trị trung bình. Công thức chính xác như sau:

# std = sqrt(mean((x - x.mean())**2))

# Trong trường hợp của bạn, giá trị "std" là 1.8959 cho một cột và 2.03572 cho cột khác.

# Khi so sánh giá trị độ lệch chuẩn giữa các cột, giá trị lớn hơn có nghĩa là dữ liệu trong cột đó có mức độ phân tán lớn hơn so với cột khác..dataframe tbody tr th {

vertical-align: top;

}

.dataframe thead th {

text-align: right;

}

| count | mean | min | 25% | 50% | 75% | max | std | |

|---|---|---|---|---|---|---|---|---|

| Date | 64 | 2023-12-09 03:00:00 | 2023-09-24 00:00:00 | 2023-11-02 12:00:00 | 2023-12-09 00:00:00 | 2024-01-14 18:00:00 | 2024-02-23 00:00:00 | NaN |

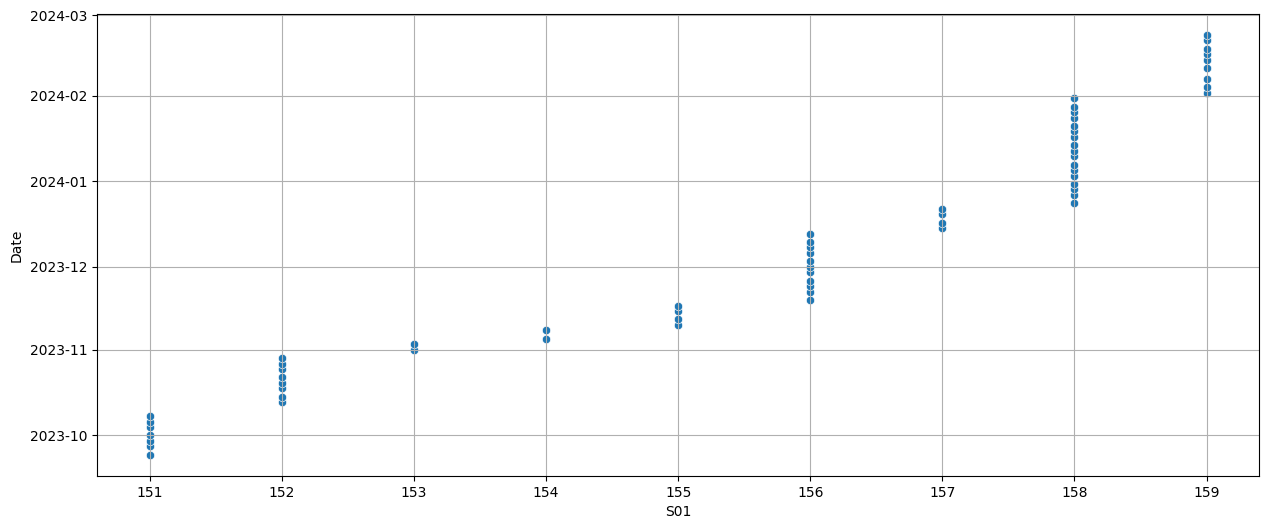

| S01 | 64.0 | 155.75 | 151.0 | 153.0 | 156.0 | 158.0 | 159.0 | 2.766007 |

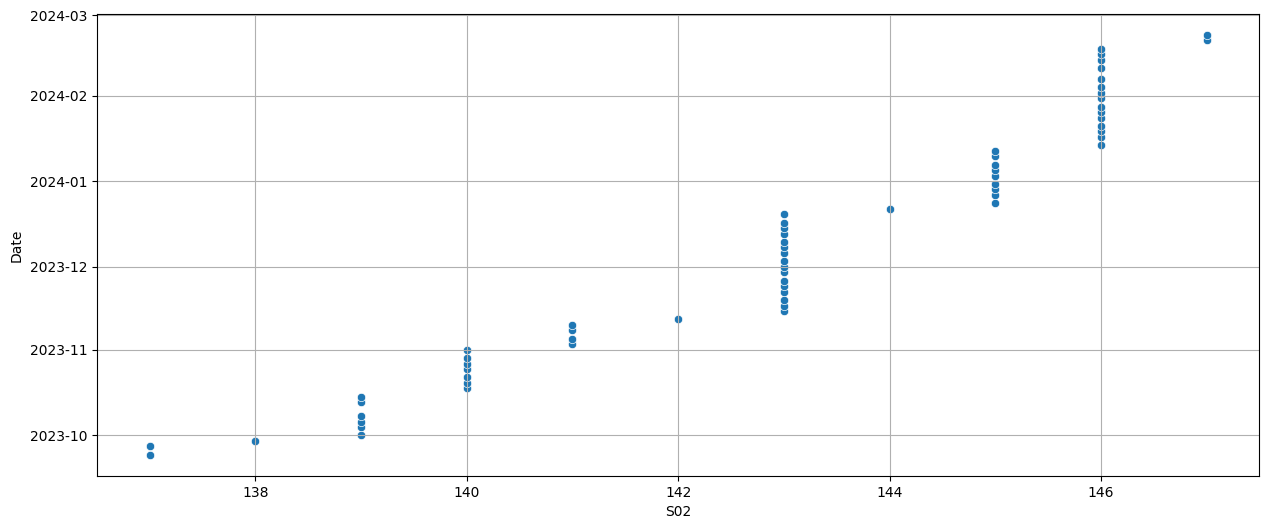

| S02 | 64.0 | 143.015625 | 137.0 | 140.75 | 143.0 | 146.0 | 147.0 | 2.751578 |

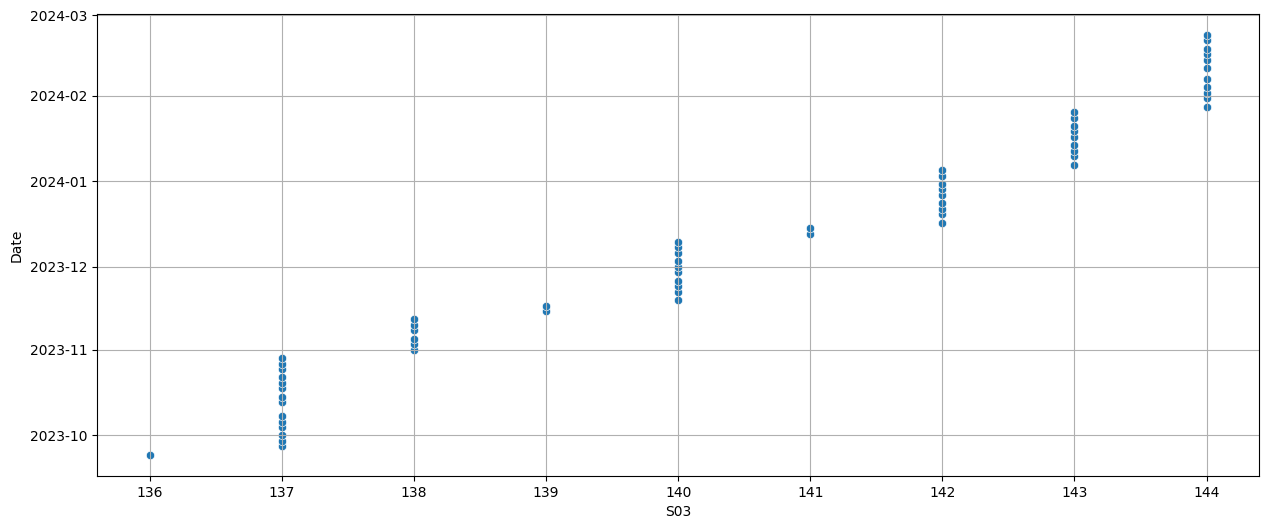

| S03 | 64.0 | 140.484375 | 136.0 | 138.0 | 140.0 | 143.0 | 144.0 | 2.66662 |

| S04 | 64.0 | 166.734375 | 160.0 | 165.0 | 168.0 | 169.0 | 170.0 | 2.691799 |

| S05 | 64.0 | 164.078125 | 159.0 | 162.0 | 164.0 | 167.0 | 168.0 | 2.972384 |

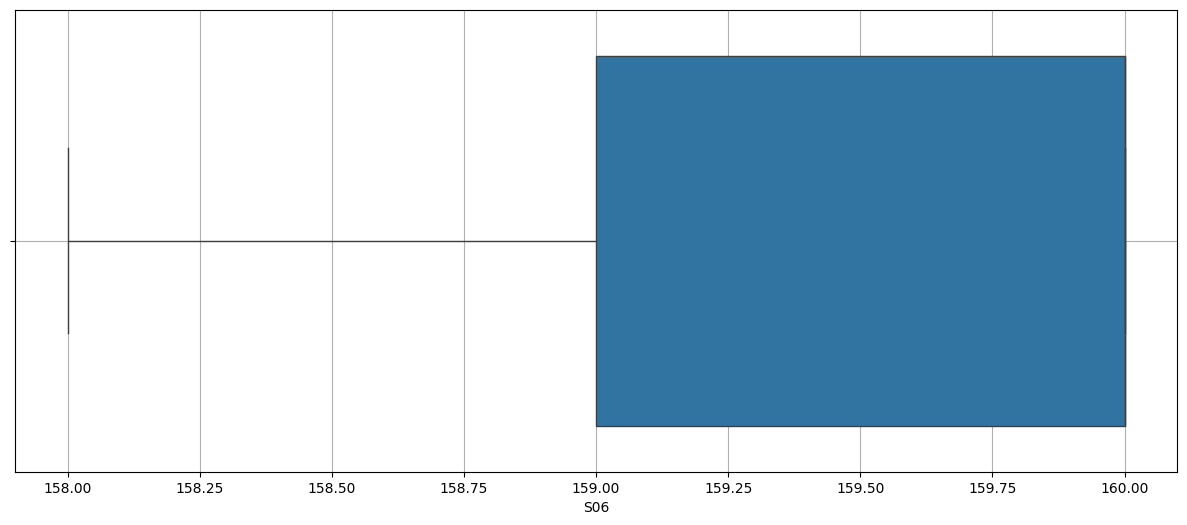

| S06 | 64.0 | 159.46875 | 158.0 | 159.0 | 160.0 | 160.0 | 161.0 | 0.872303 |

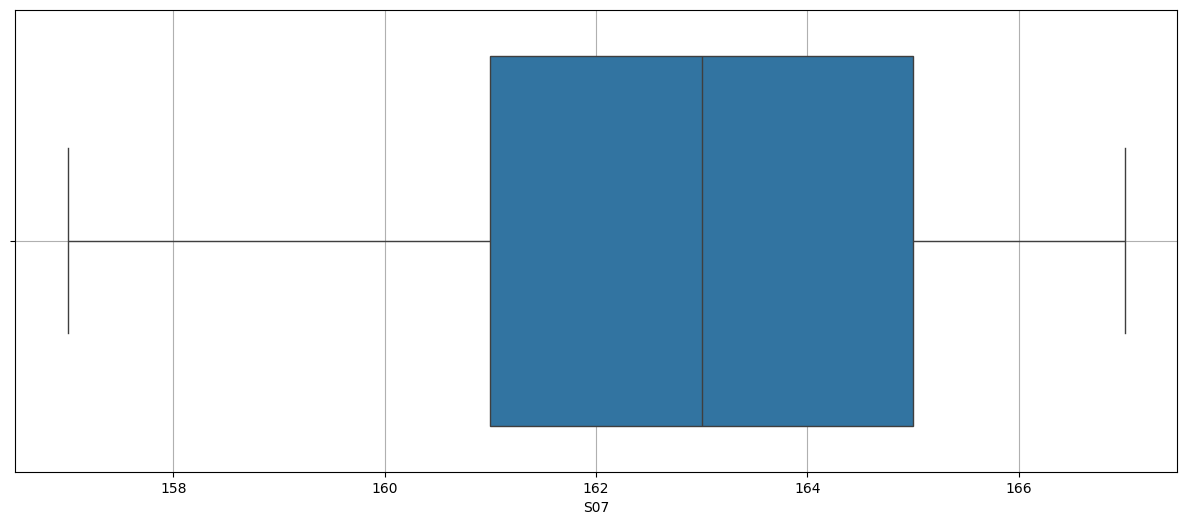

| S07 | 64.0 | 163.078125 | 157.0 | 161.75 | 163.0 | 165.0 | 167.0 | 3.025315 |

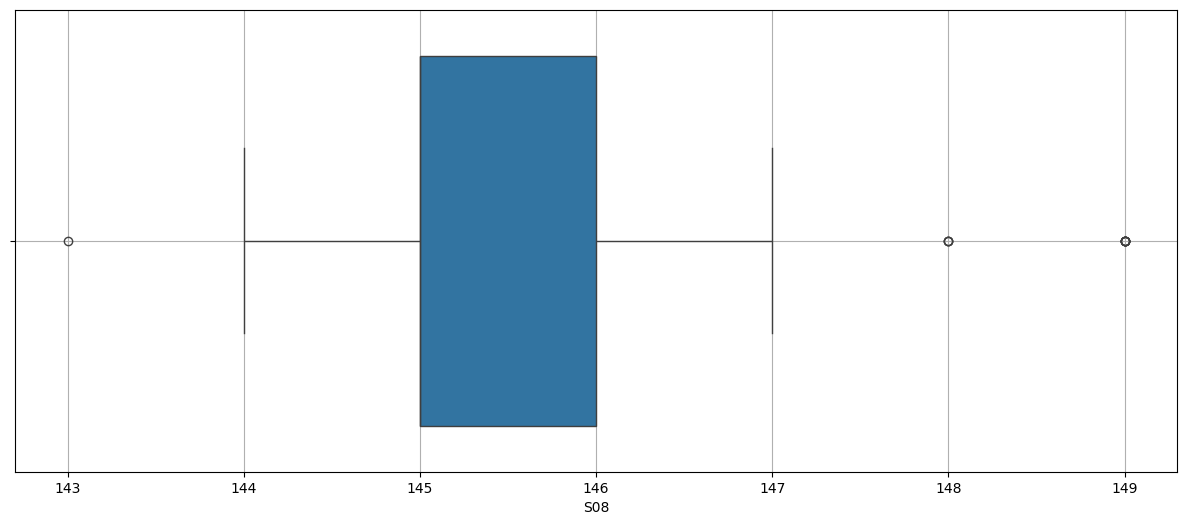

| S08 | 64.0 | 146.140625 | 143.0 | 145.0 | 145.0 | 147.0 | 151.0 | 1.8845 |

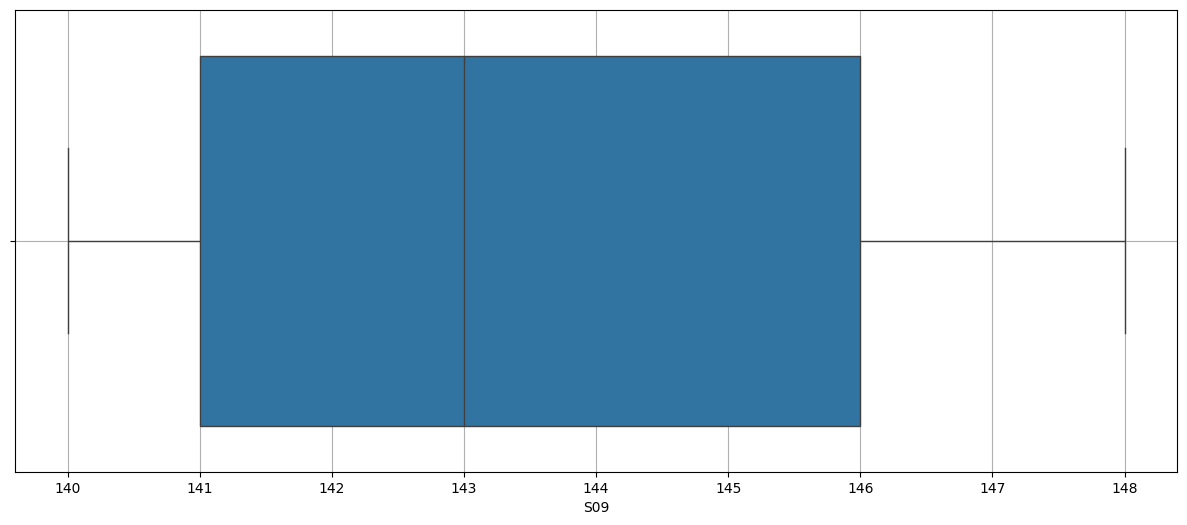

| S09 | 64.0 | 143.734375 | 140.0 | 141.75 | 143.5 | 146.0 | 149.0 | 2.761655 |

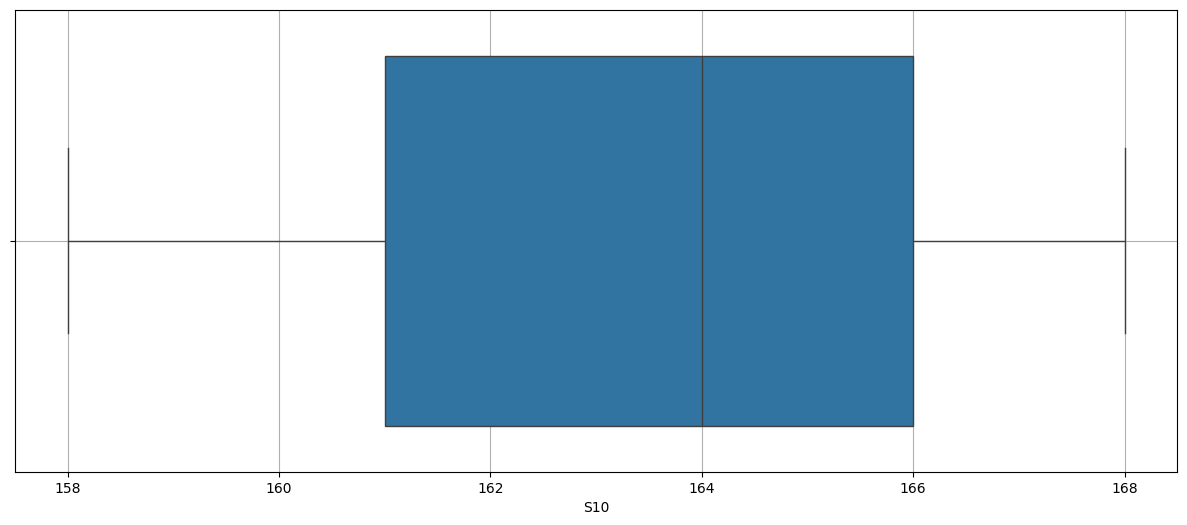

| S10 | 64.0 | 164.078125 | 158.0 | 161.0 | 164.5 | 168.0 | 169.0 | 3.626642 |

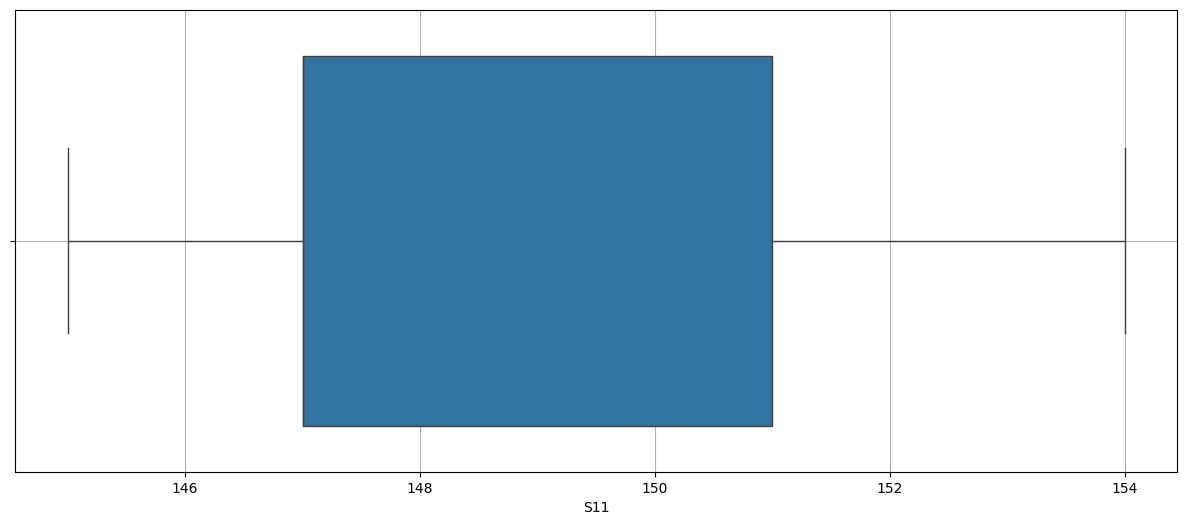

| S11 | 64.0 | 149.546875 | 145.0 | 147.0 | 148.5 | 152.0 | 155.0 | 3.126587 |

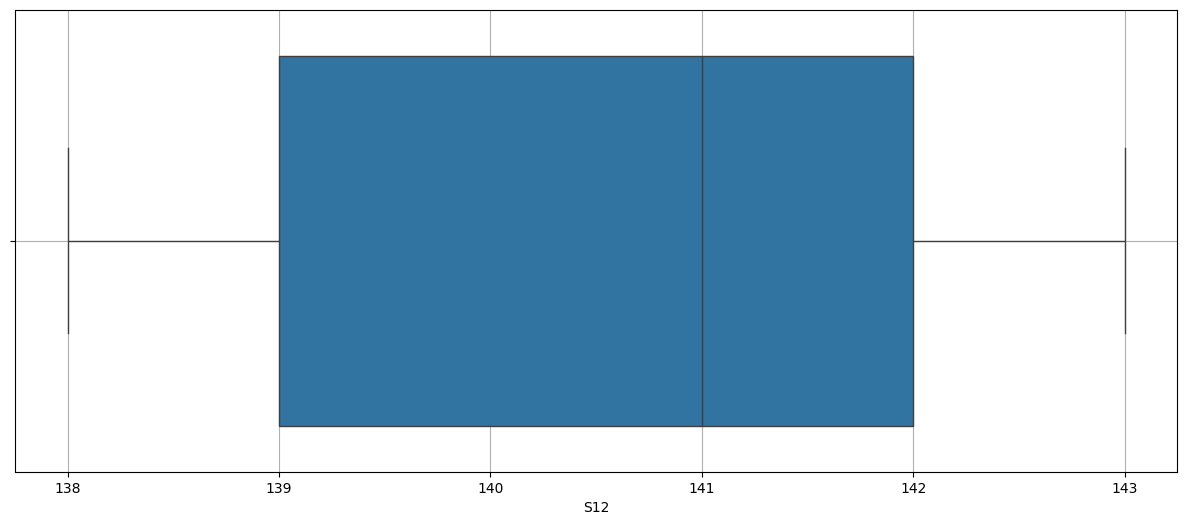

| S12 | 64.0 | 141.0 | 138.0 | 139.0 | 141.0 | 143.0 | 144.0 | 1.80827 |

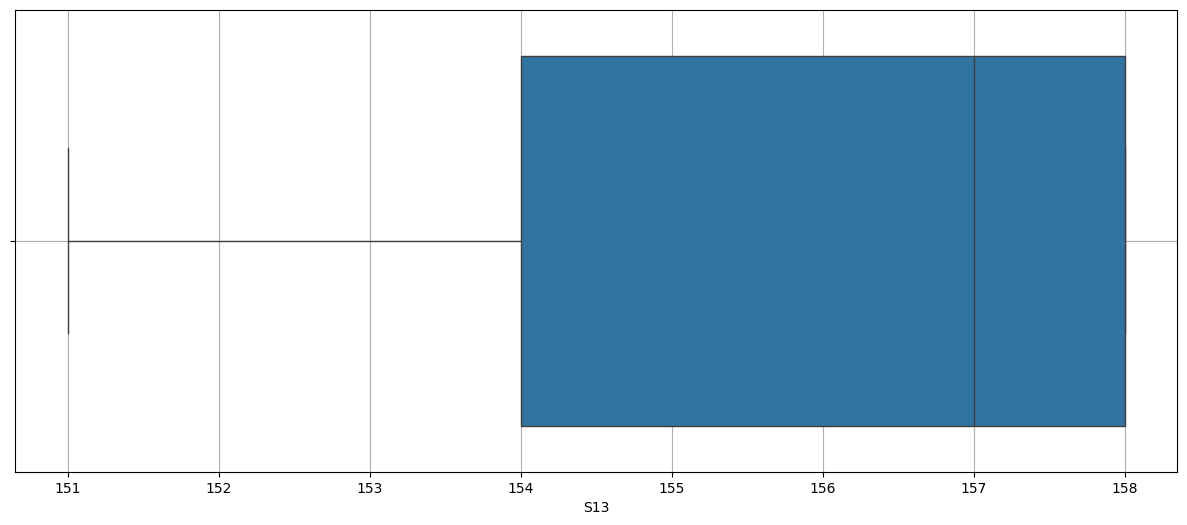

| S13 | 64.0 | 156.140625 | 151.0 | 154.75 | 157.0 | 158.0 | 158.0 | 2.329025 |

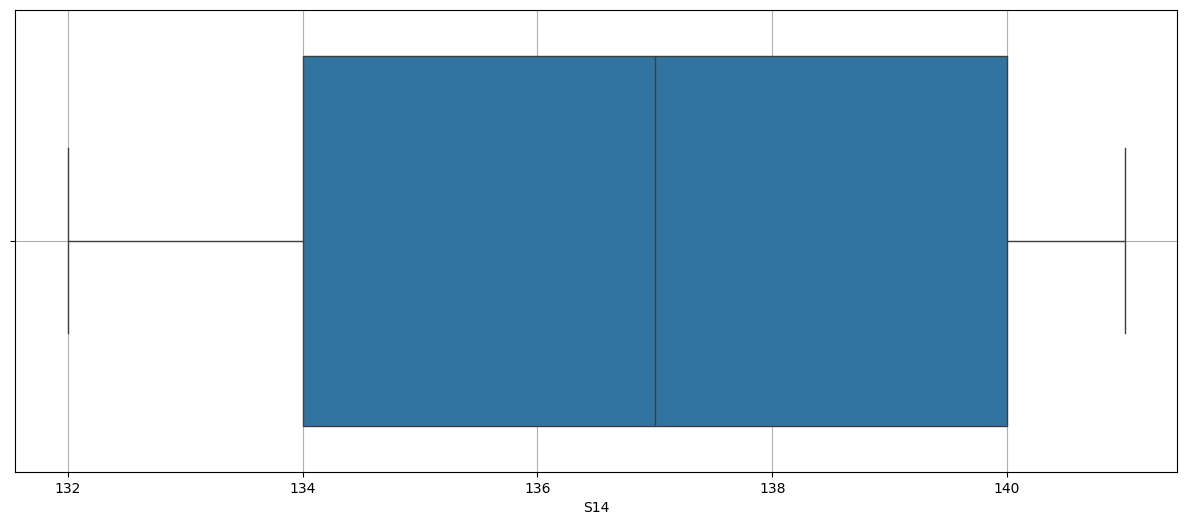

| S14 | 64.0 | 136.84375 | 132.0 | 134.0 | 137.0 | 140.25 | 142.0 | 3.409691 |

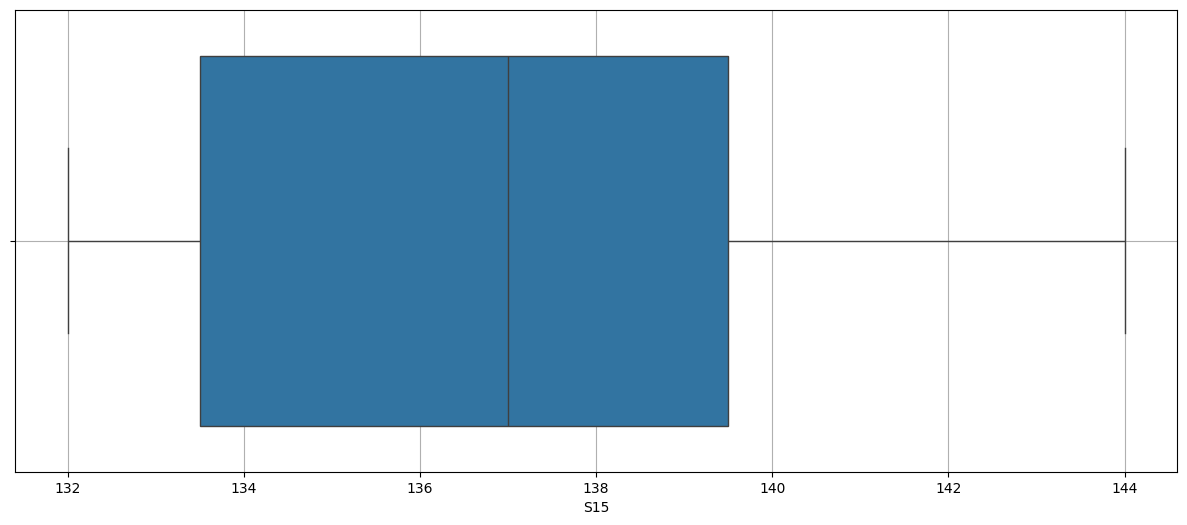

| S15 | 64.0 | 137.375 | 132.0 | 134.0 | 138.0 | 140.0 | 144.0 | 4.053217 |

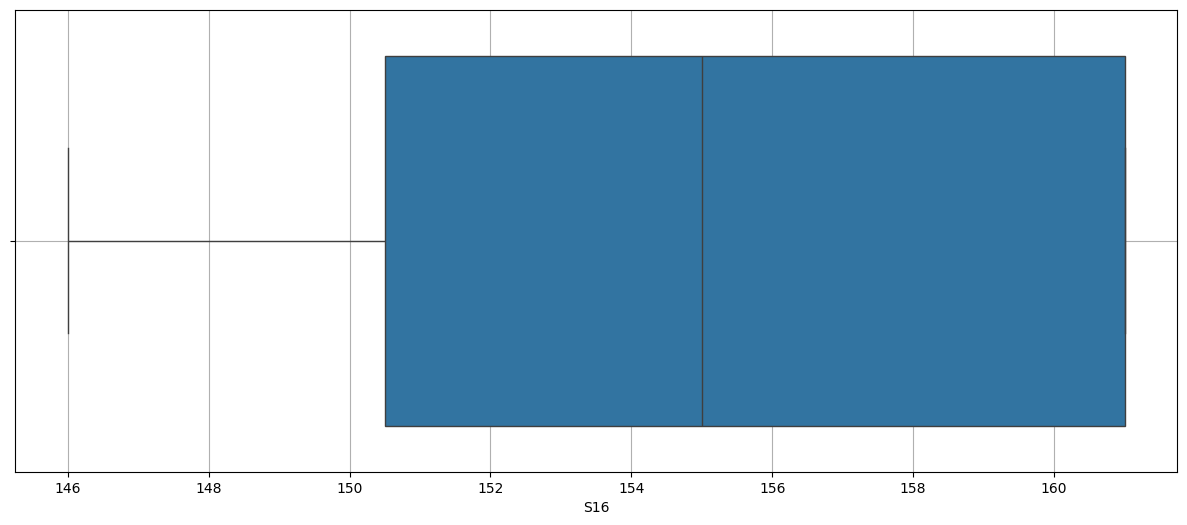

| S16 | 64.0 | 155.5 | 146.0 | 151.0 | 156.0 | 161.0 | 162.0 | 5.203784 |

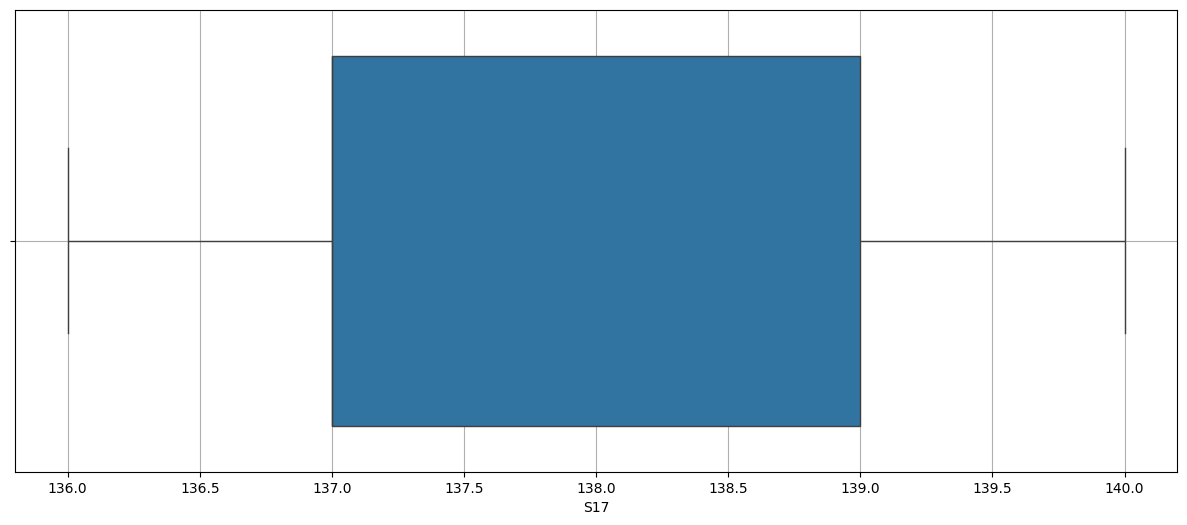

| S17 | 64.0 | 138.078125 | 136.0 | 137.0 | 138.5 | 139.0 | 141.0 | 1.263714 |

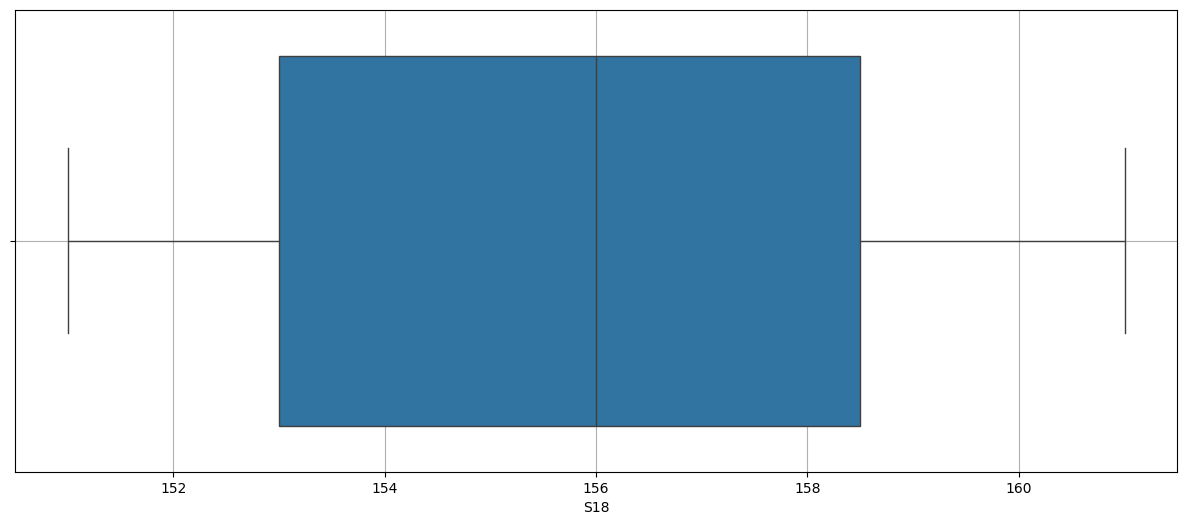

| S18 | 64.0 | 156.4375 | 151.0 | 153.0 | 157.0 | 160.0 | 161.0 | 3.29923 |

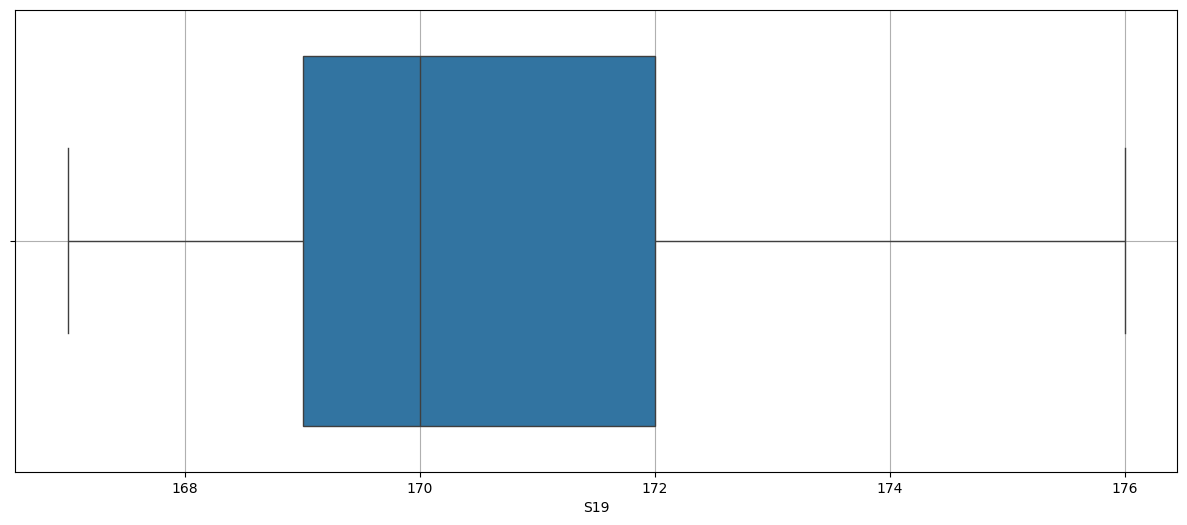

| S19 | 64.0 | 171.359375 | 167.0 | 169.0 | 171.0 | 174.25 | 179.0 | 3.184123 |

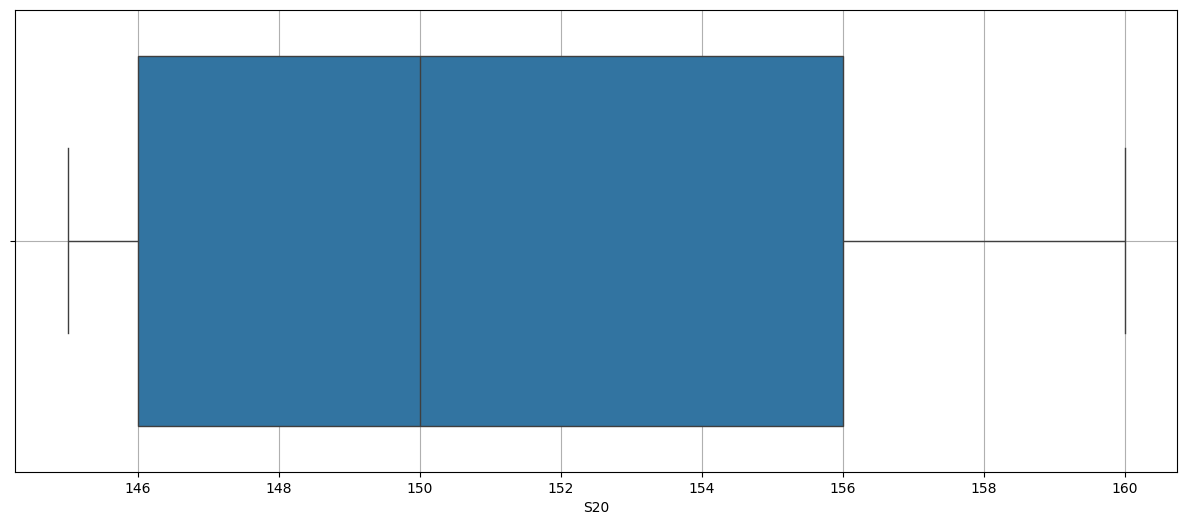

| S20 | 64.0 | 152.265625 | 145.0 | 146.0 | 151.0 | 158.0 | 162.0 | 5.885797 |

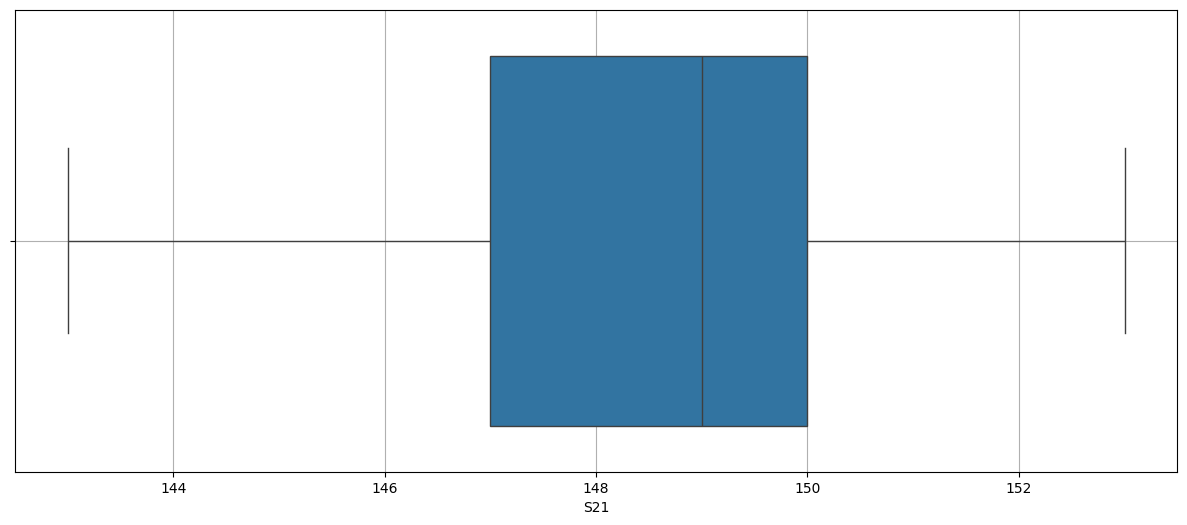

| S21 | 64.0 | 148.4375 | 143.0 | 147.0 | 149.0 | 150.25 | 154.0 | 3.033543 |

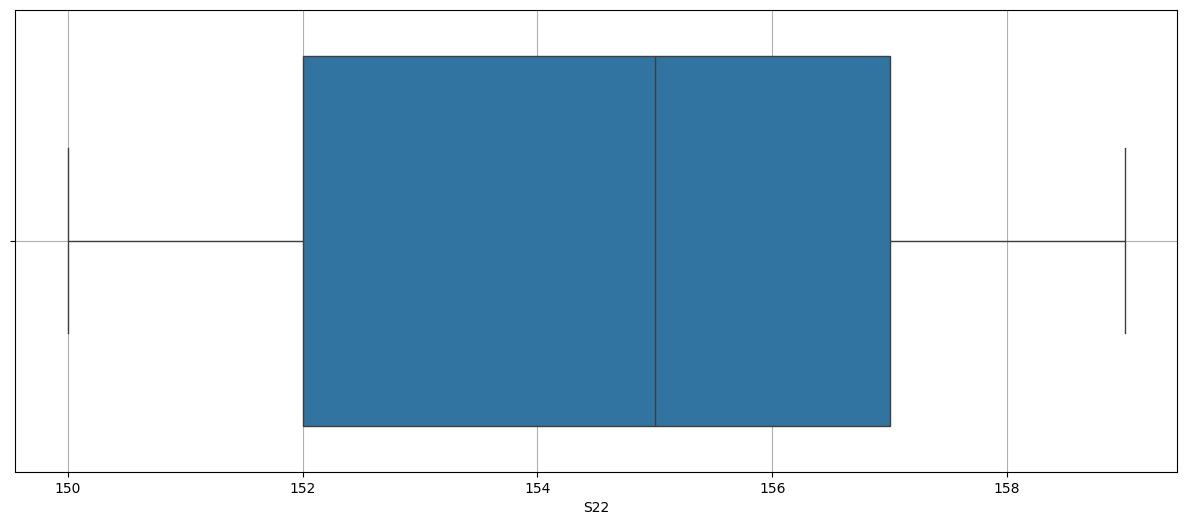

| S22 | 64.0 | 155.046875 | 150.0 | 152.75 | 155.0 | 157.0 | 159.0 | 2.779915 |

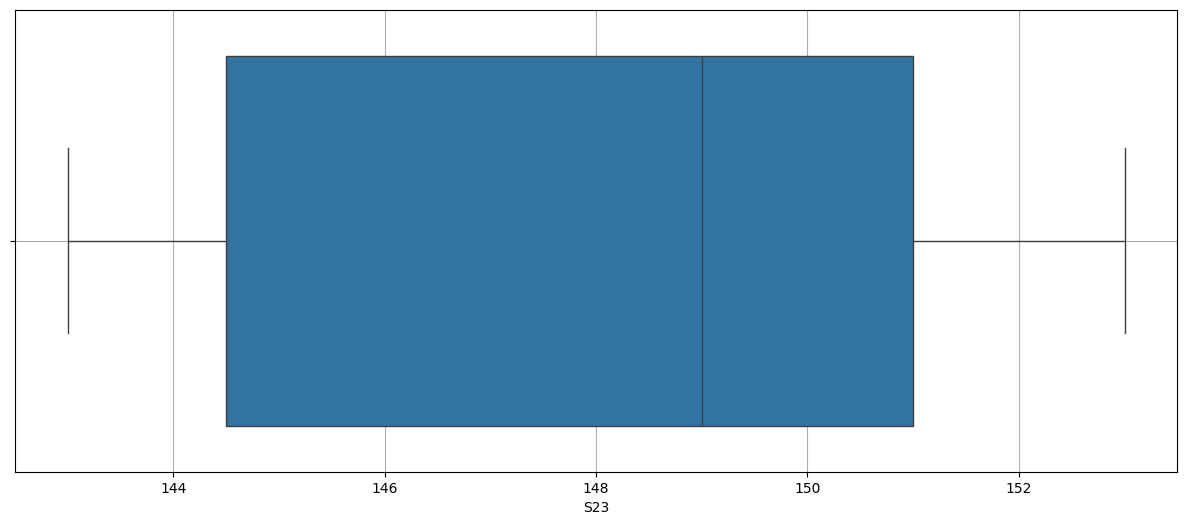

| S23 | 64.0 | 148.5625 | 143.0 | 145.0 | 149.0 | 151.0 | 153.0 | 3.289594 |

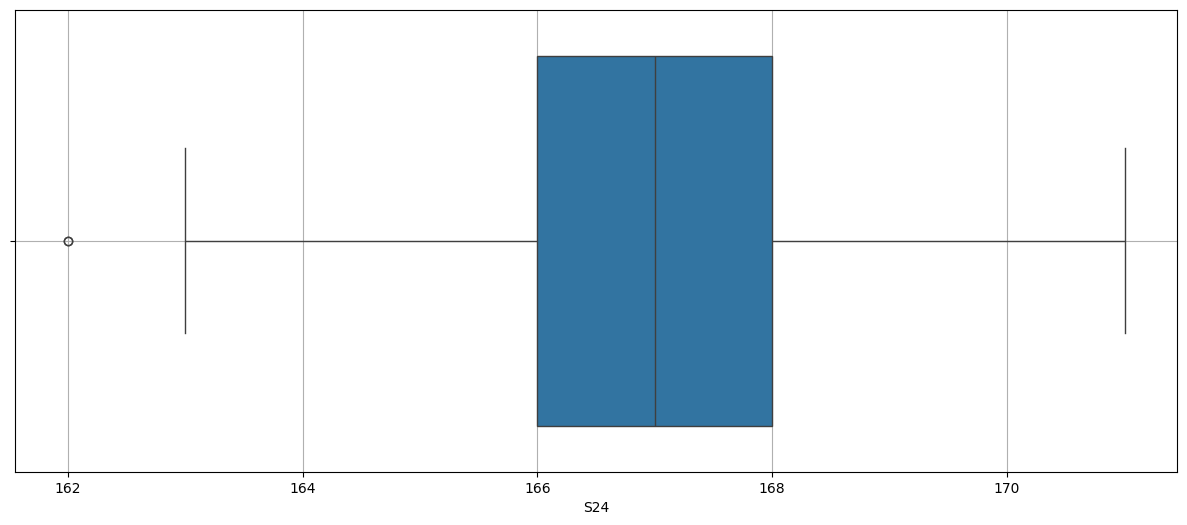

| S24 | 64.0 | 167.265625 | 162.0 | 166.0 | 167.0 | 169.0 | 173.0 | 2.521288 |

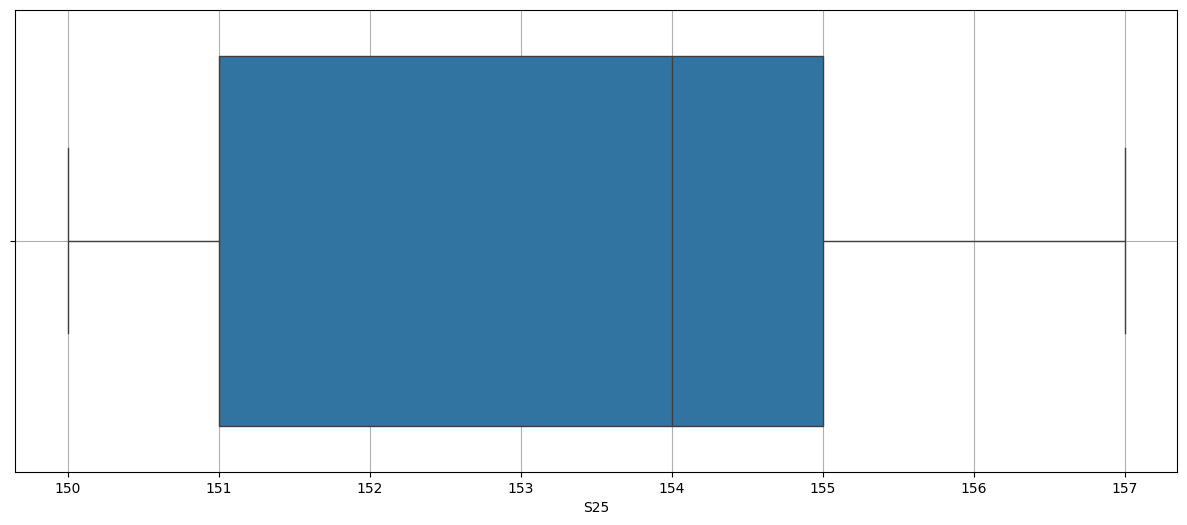

| S25 | 64.0 | 153.4375 | 150.0 | 151.0 | 154.0 | 155.0 | 157.0 | 2.294749 |

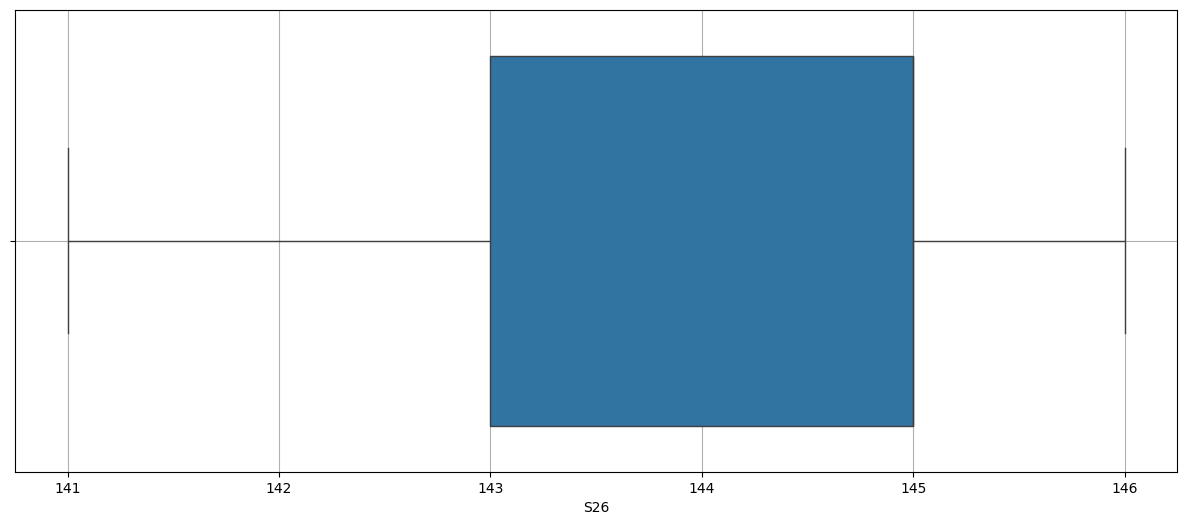

| S26 | 64.0 | 144.15625 | 141.0 | 143.0 | 145.0 | 145.0 | 146.0 | 1.747731 |

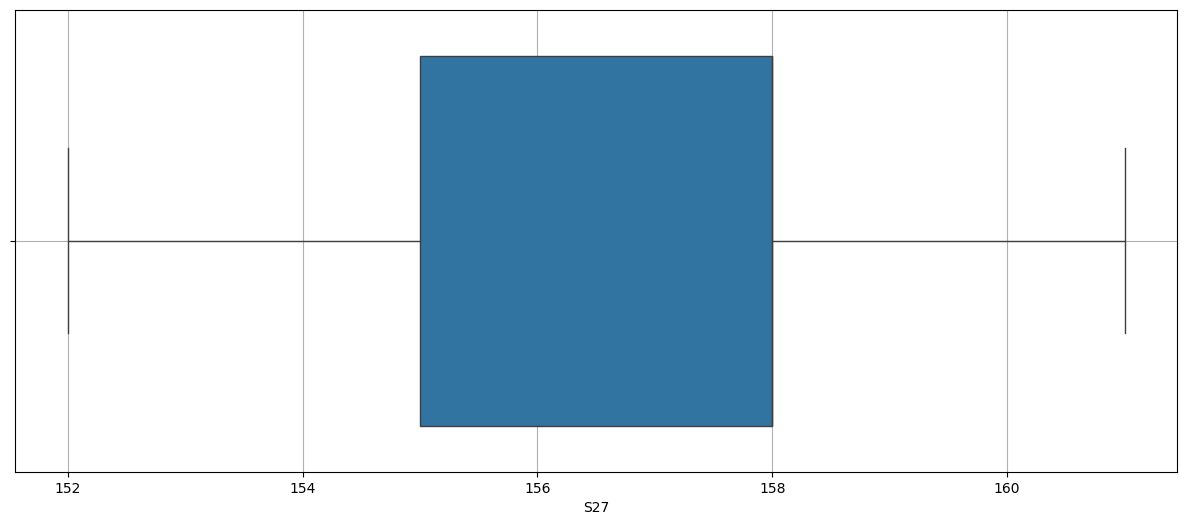

| S27 | 64.0 | 157.484375 | 152.0 | 155.0 | 158.0 | 159.0 | 162.0 | 2.423379 |

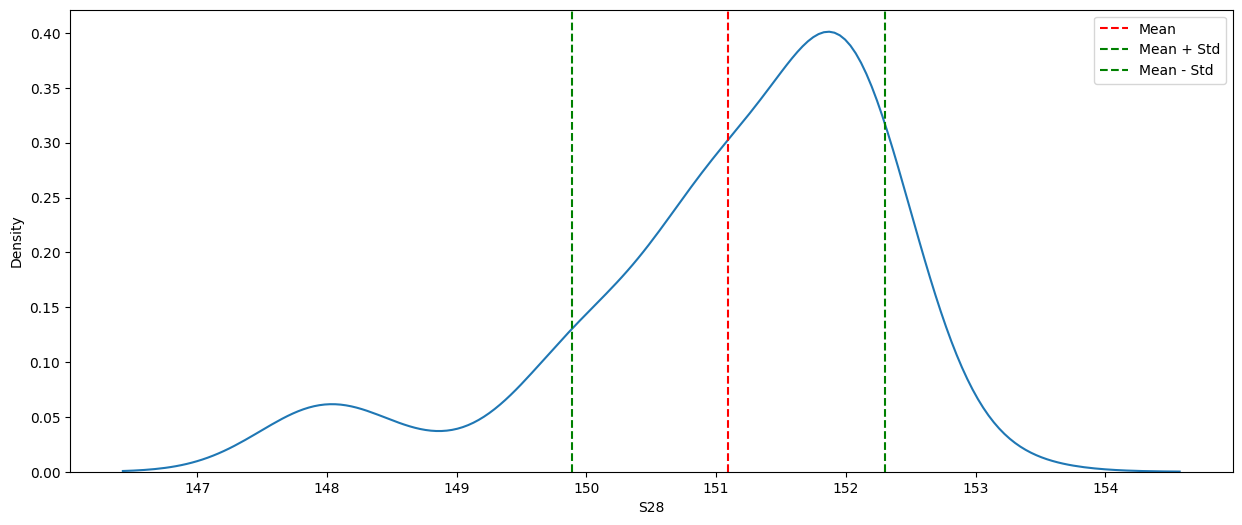

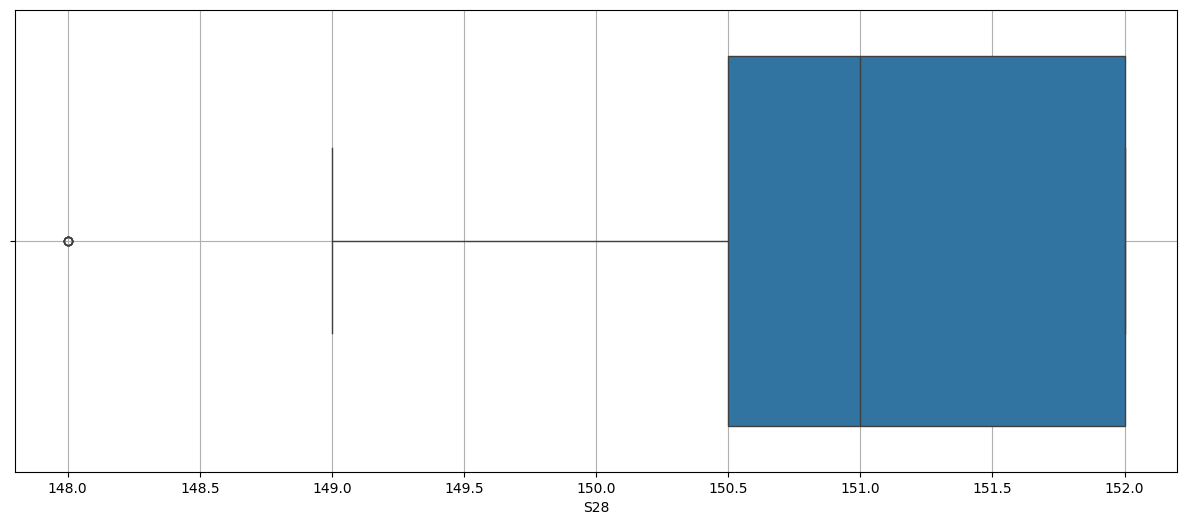

| S28 | 64.0 | 151.09375 | 148.0 | 151.0 | 151.0 | 152.0 | 153.0 | 1.204736 |

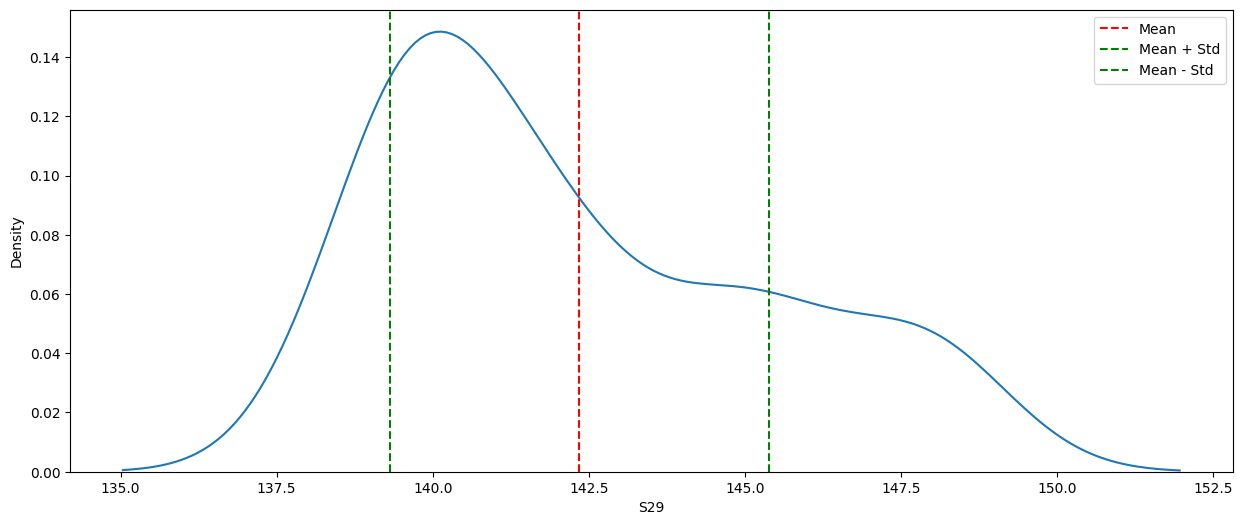

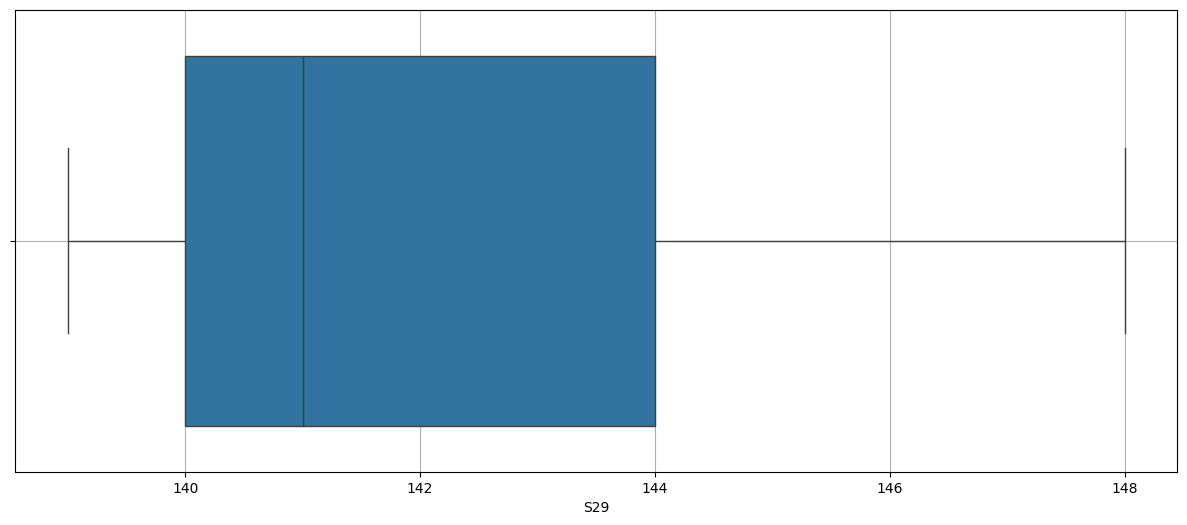

| S29 | 64.0 | 142.34375 | 139.0 | 140.0 | 142.0 | 145.0 | 148.0 | 3.035341 |

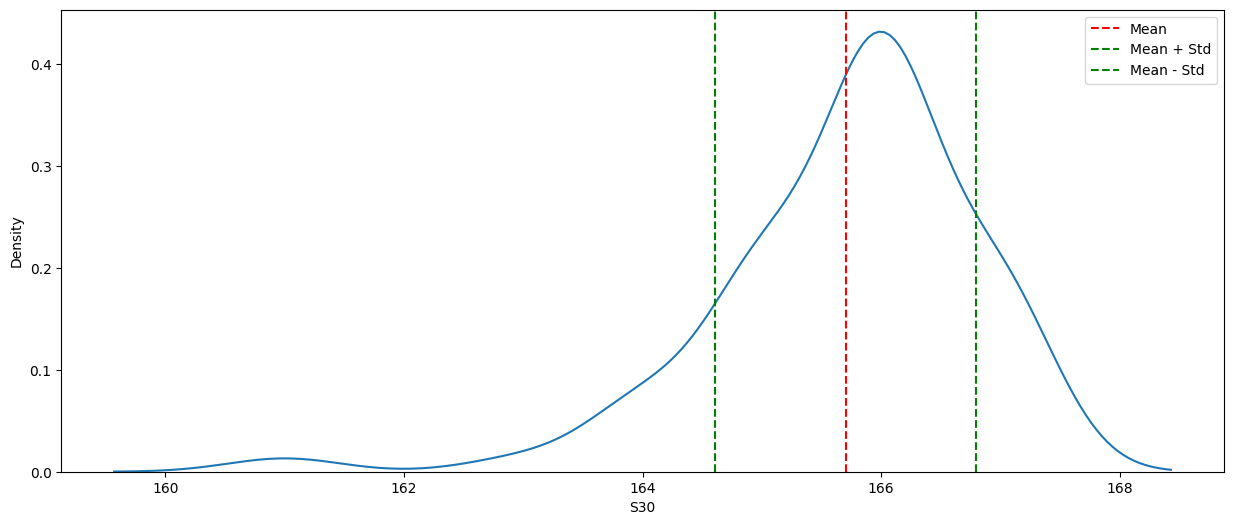

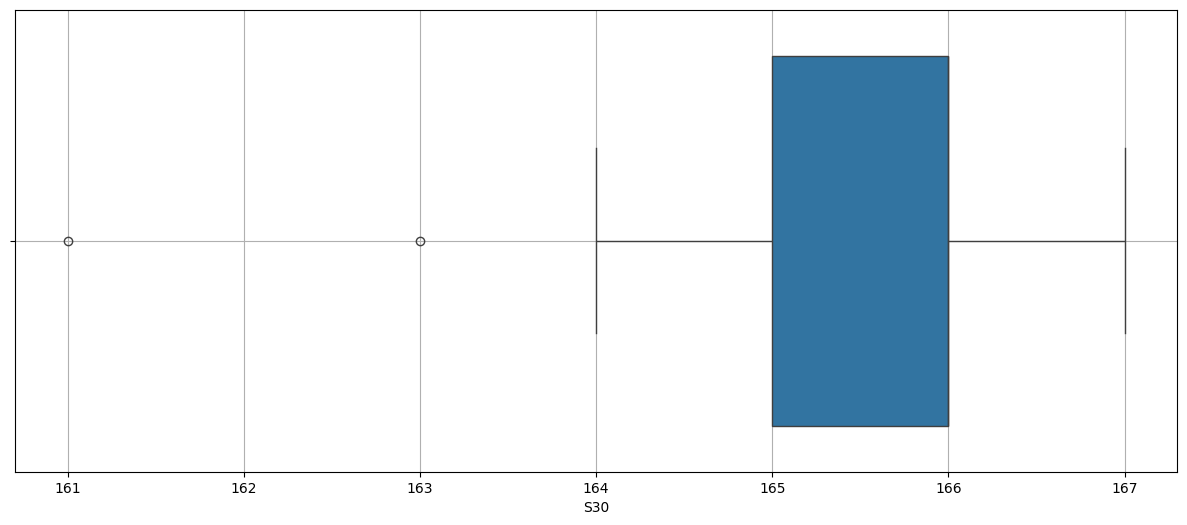

| S30 | 64.0 | 165.703125 | 161.0 | 165.0 | 166.0 | 166.0 | 167.0 | 1.0937 |

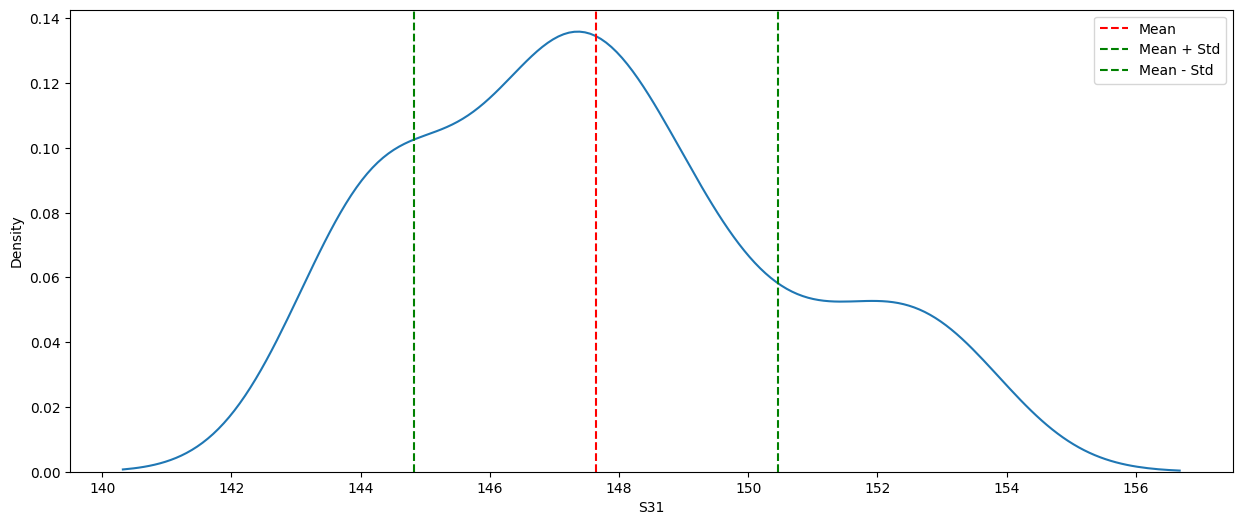

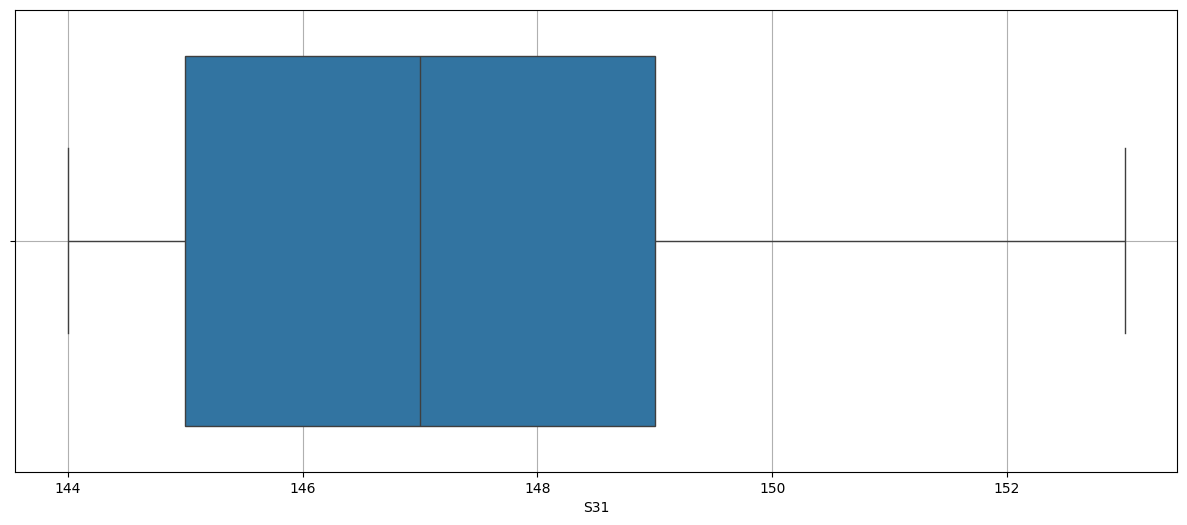

| S31 | 64.0 | 147.640625 | 144.0 | 145.0 | 147.0 | 149.0 | 153.0 | 2.819249 |

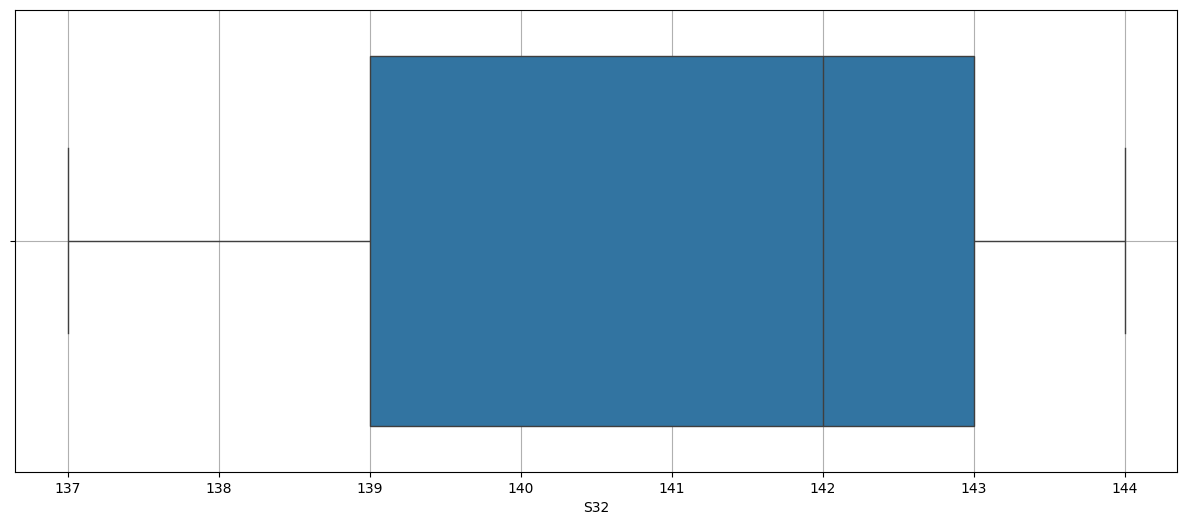

| S32 | 64.0 | 140.984375 | 137.0 | 139.0 | 142.0 | 143.0 | 144.0 | 2.426652 |

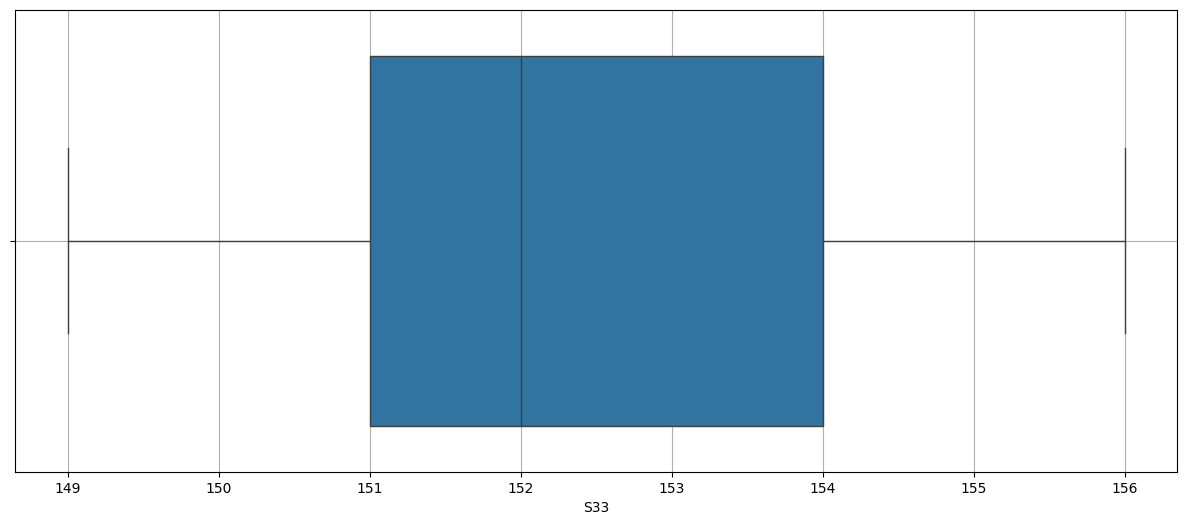

| S33 | 64.0 | 152.546875 | 149.0 | 151.0 | 152.0 | 154.0 | 156.0 | 1.851037 |

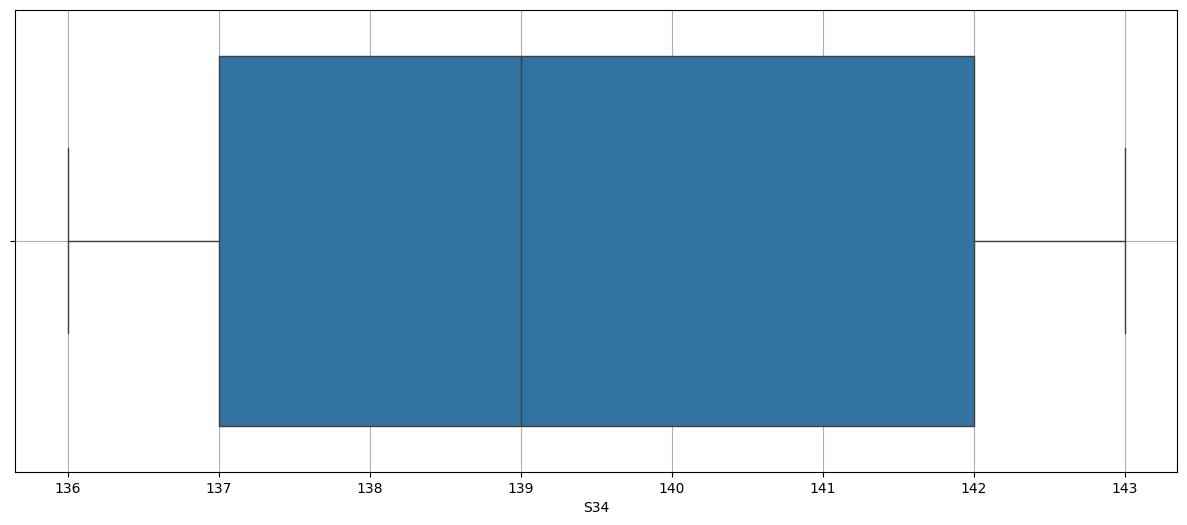

| S34 | 64.0 | 139.4375 | 136.0 | 137.0 | 139.0 | 142.0 | 143.0 | 2.525269 |

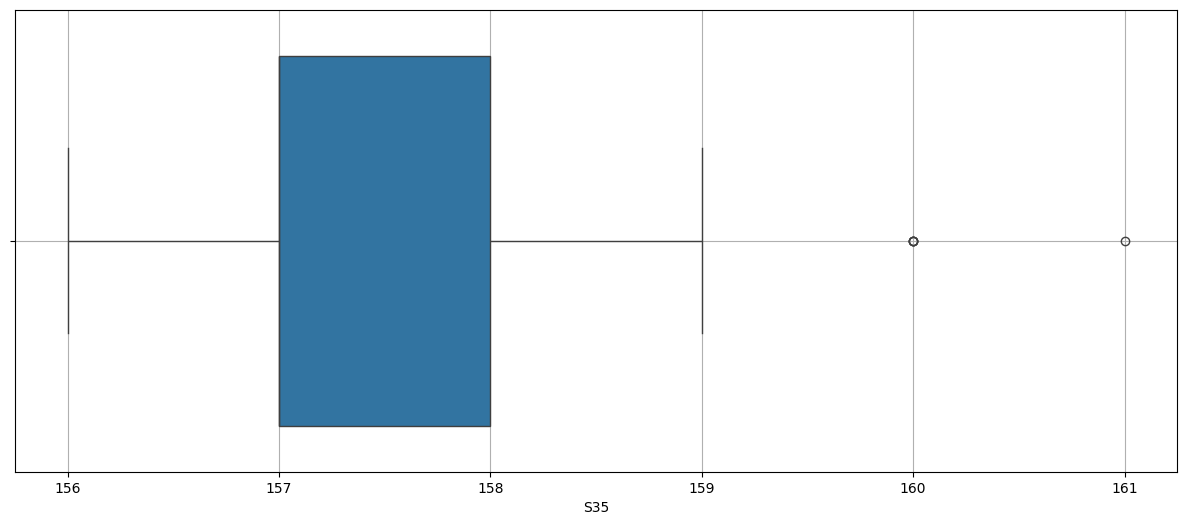

| S35 | 64.0 | 157.640625 | 156.0 | 157.0 | 157.0 | 158.0 | 161.0 | 1.473223 |

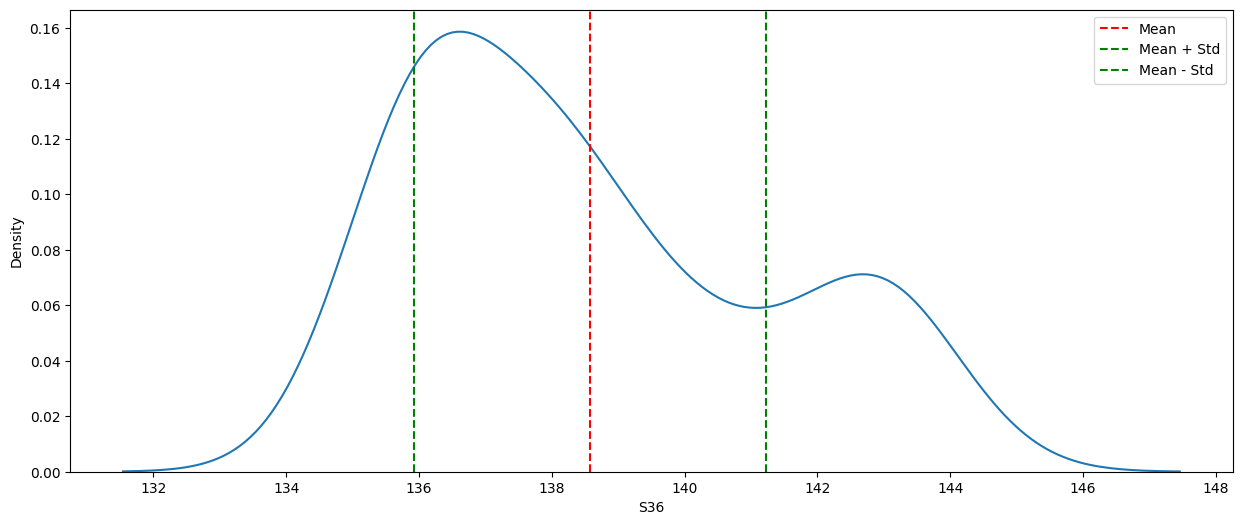

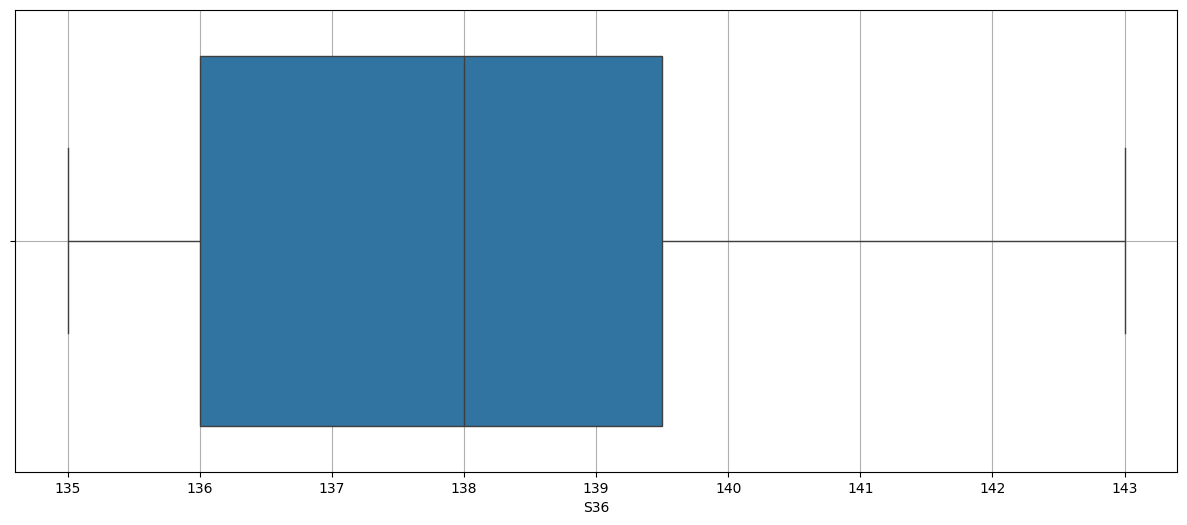

| S36 | 64.0 | 138.578125 | 135.0 | 136.0 | 138.0 | 140.25 | 144.0 | 2.647579 |

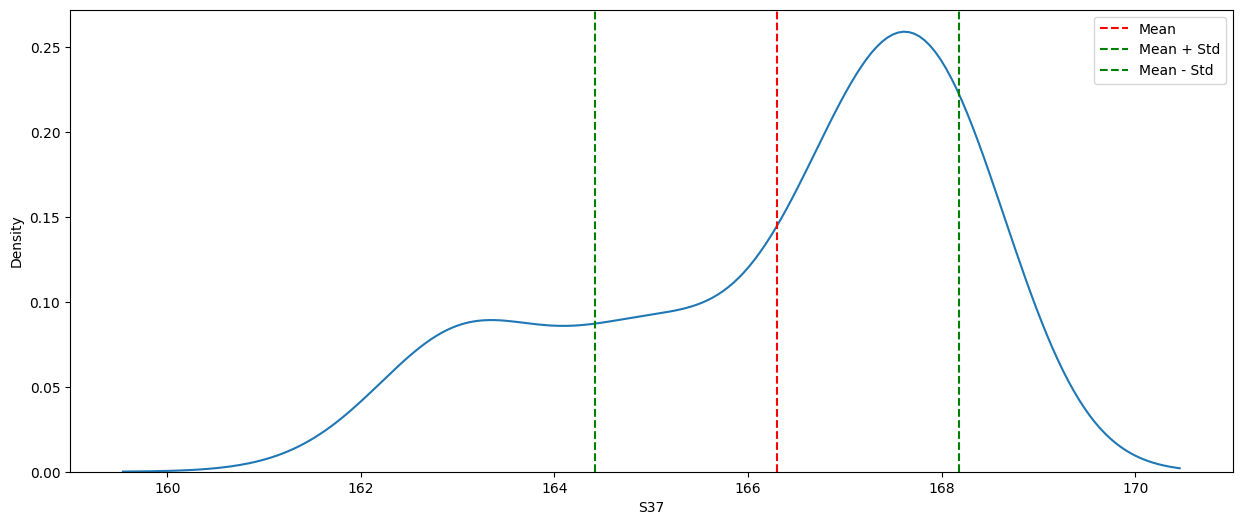

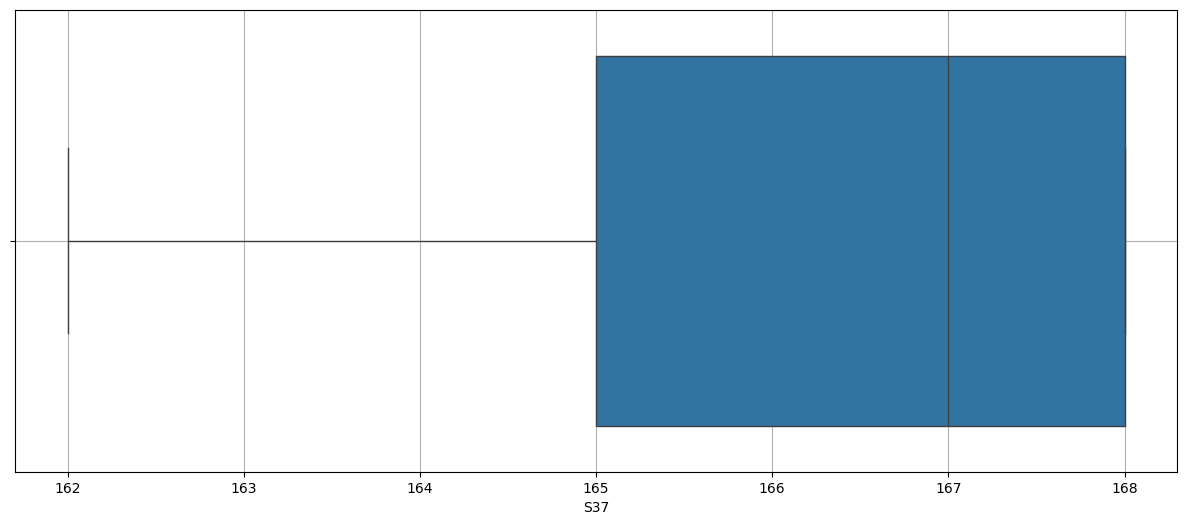

| S37 | 64.0 | 166.296875 | 162.0 | 165.0 | 167.0 | 168.0 | 168.0 | 1.88292 |

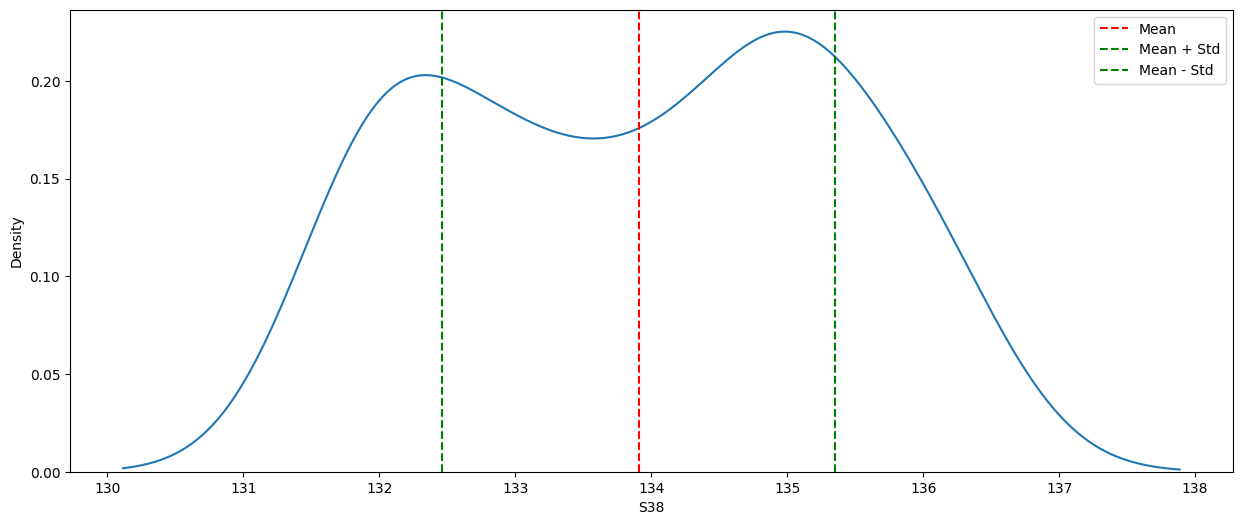

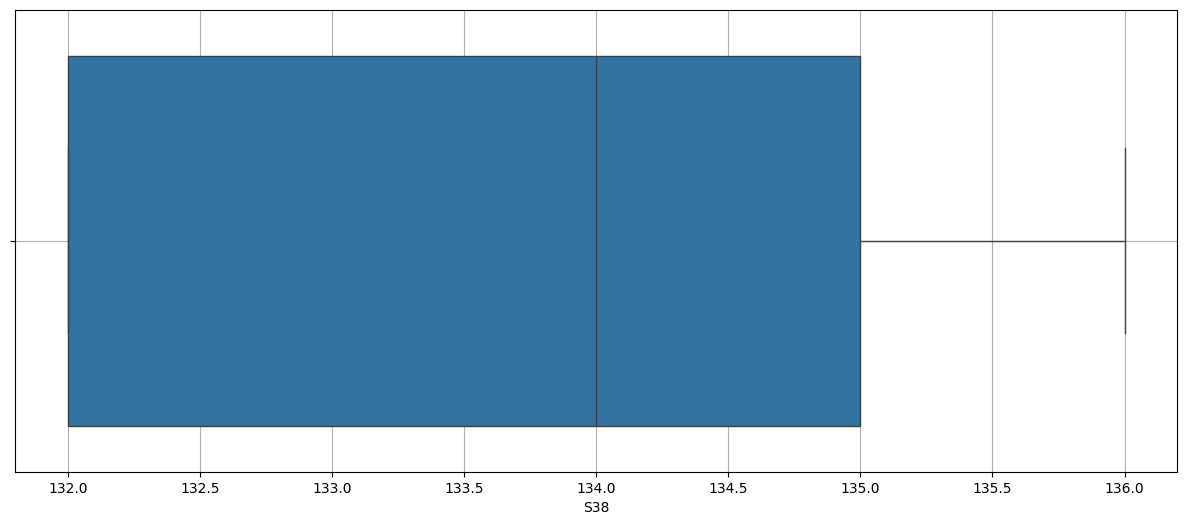

| S38 | 64.0 | 133.90625 | 132.0 | 132.75 | 134.0 | 135.0 | 136.0 | 1.444406 |

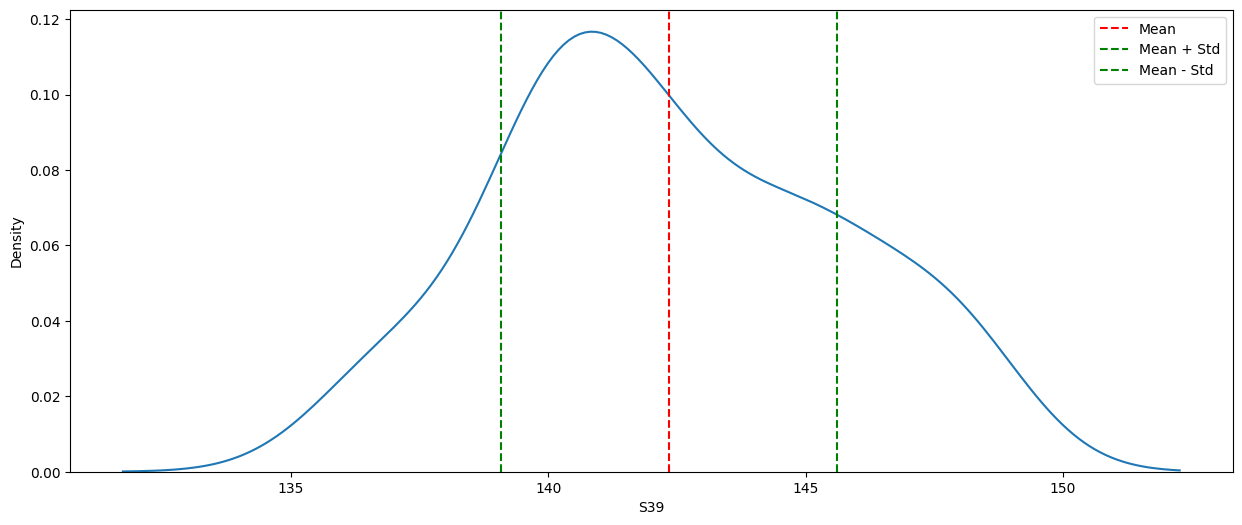

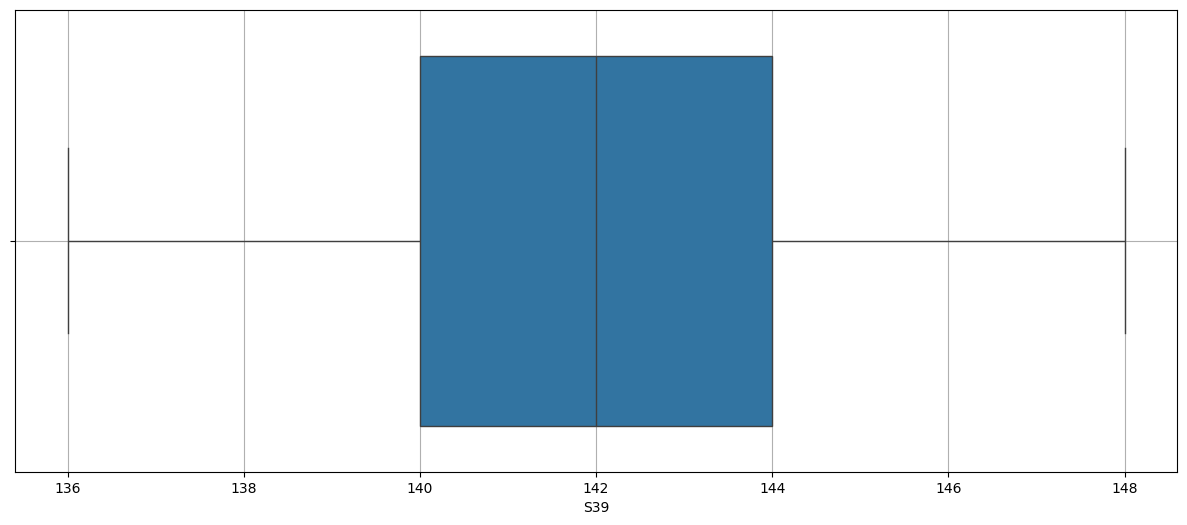

| S39 | 64.0 | 142.34375 | 136.0 | 140.0 | 142.0 | 145.0 | 148.0 | 3.267049 |

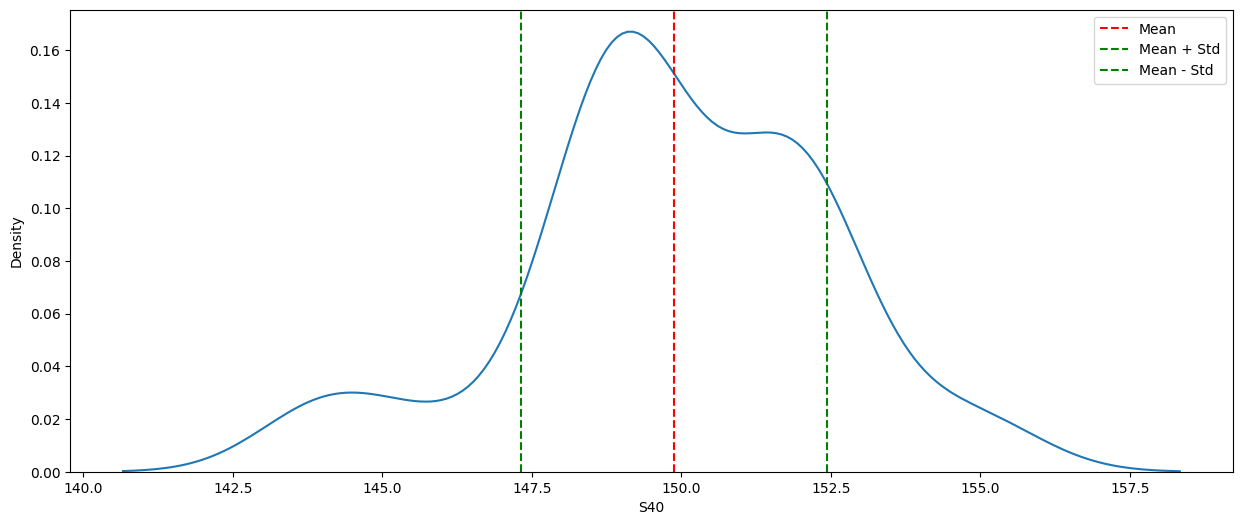

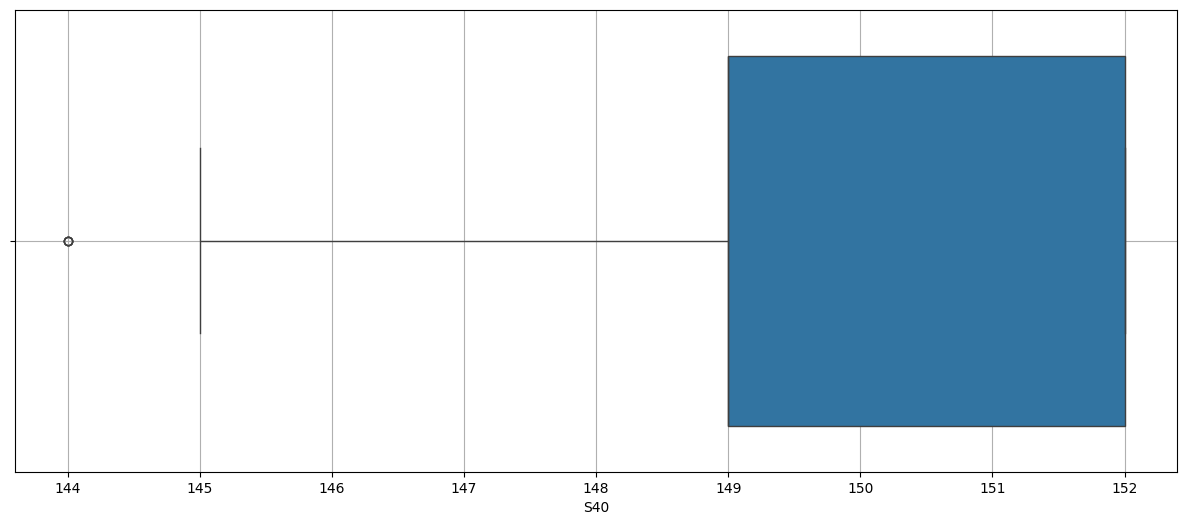

| S40 | 64.0 | 149.875 | 144.0 | 149.0 | 149.0 | 152.0 | 155.0 | 2.554175 |

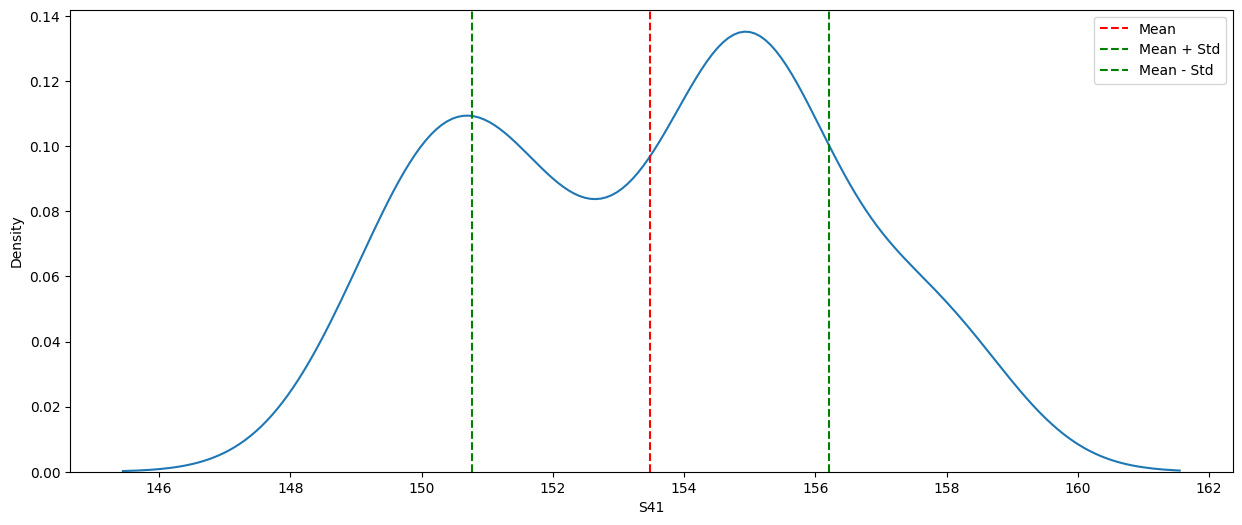

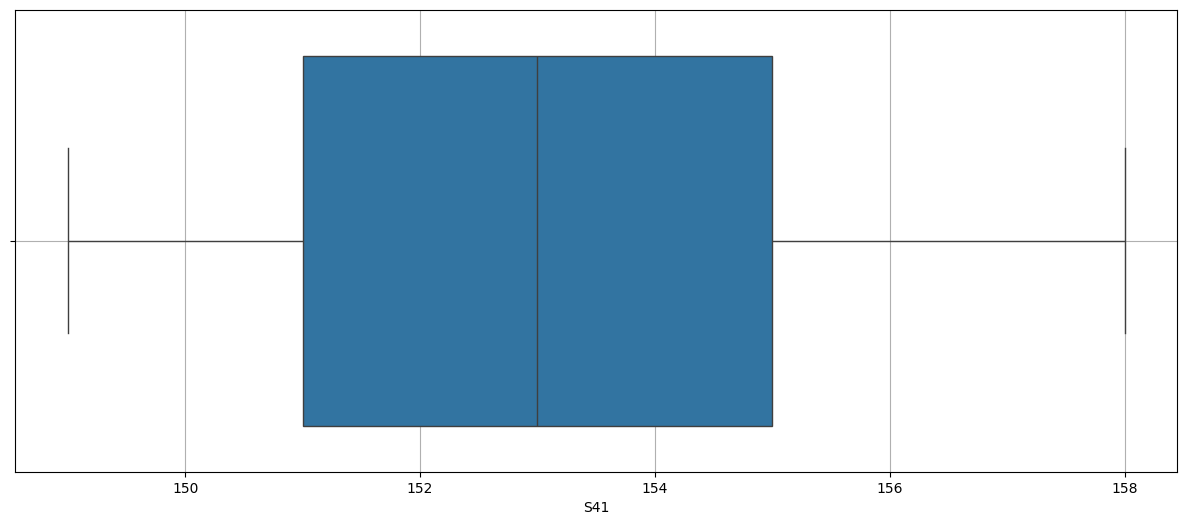

| S41 | 64.0 | 153.484375 | 149.0 | 151.0 | 154.5 | 155.0 | 158.0 | 2.719665 |

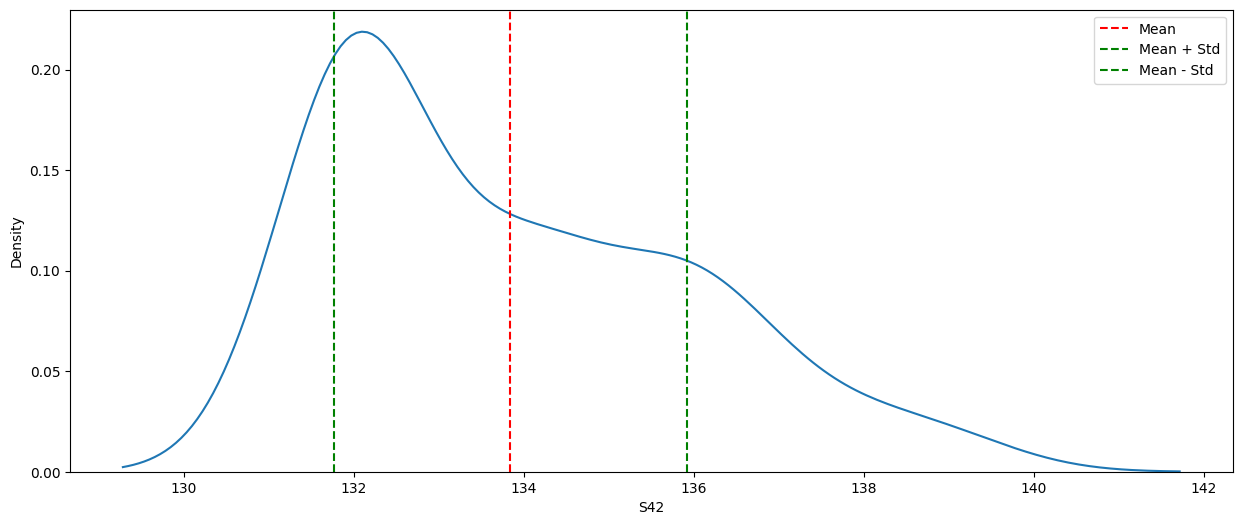

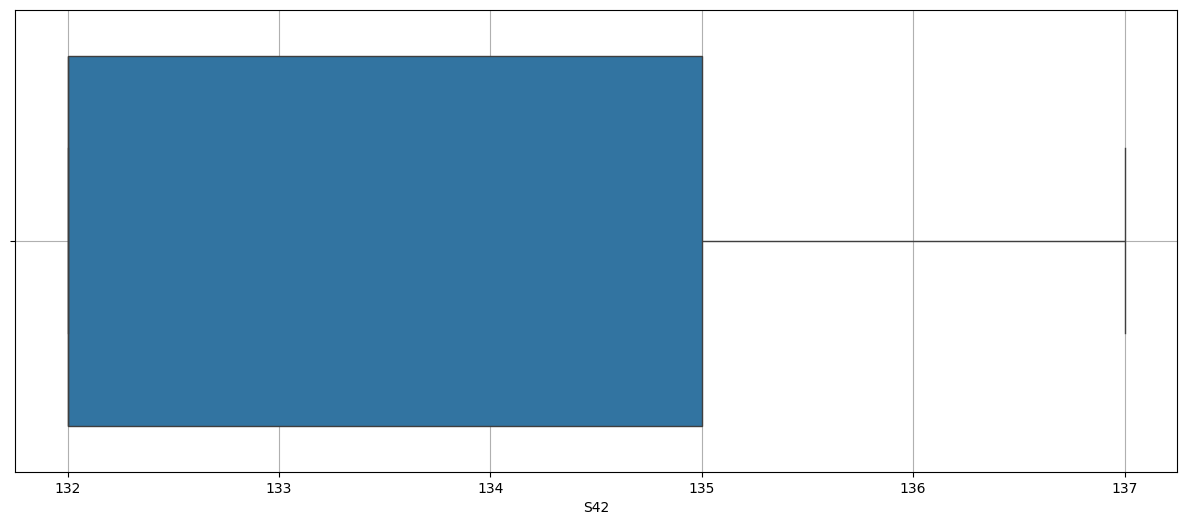

| S42 | 64.0 | 133.84375 | 132.0 | 132.0 | 134.0 | 136.0 | 139.0 | 2.07952 |

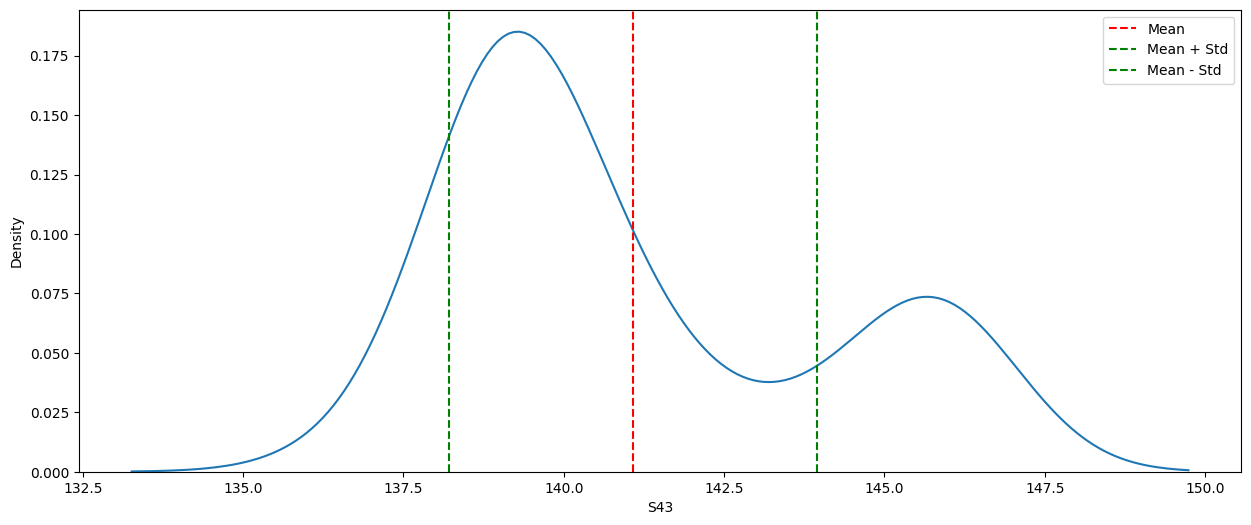

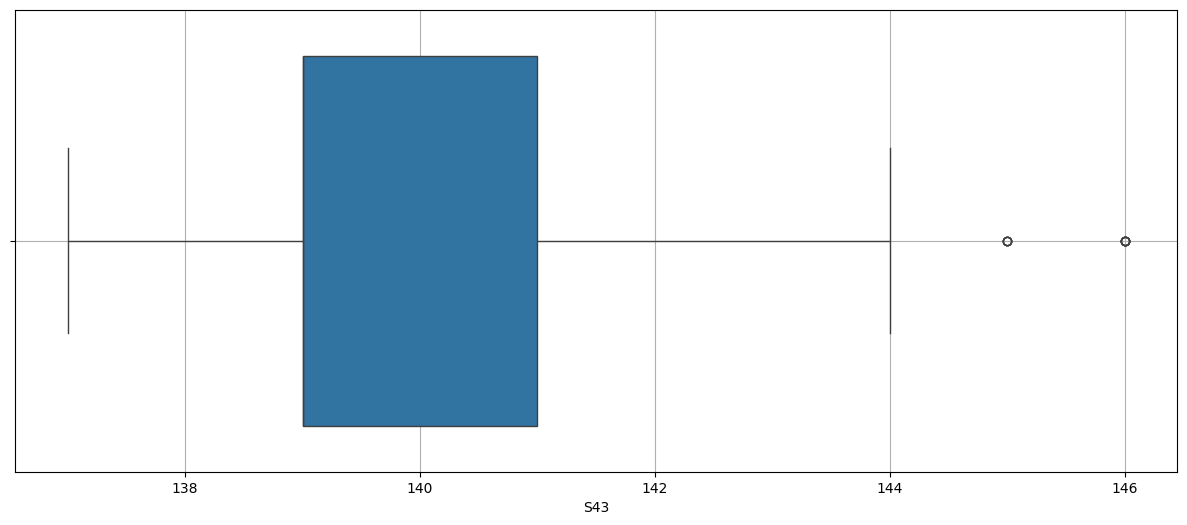

| S43 | 64.0 | 141.078125 | 137.0 | 139.0 | 140.0 | 143.25 | 146.0 | 2.86359 |

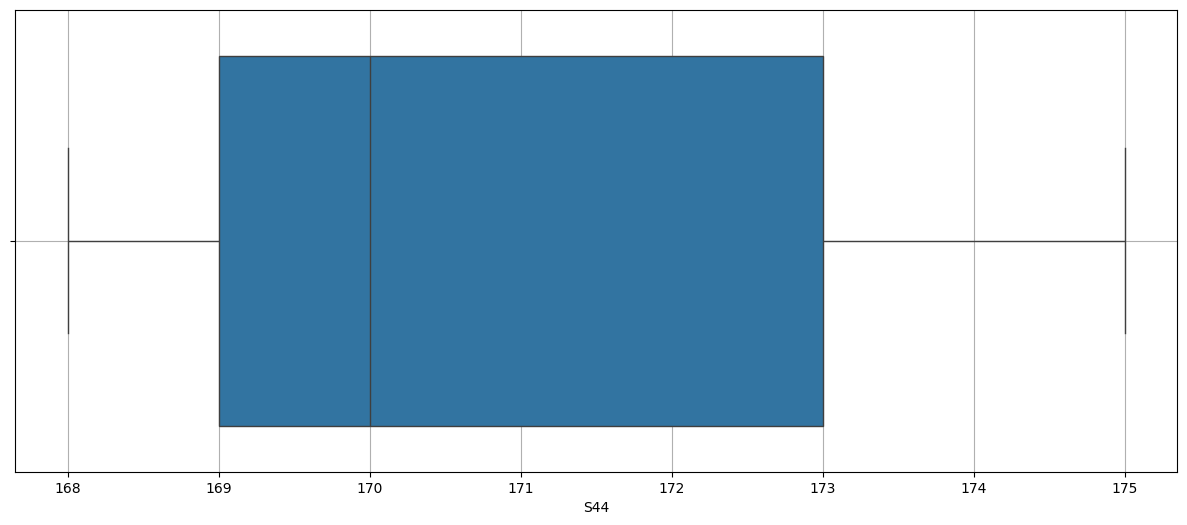

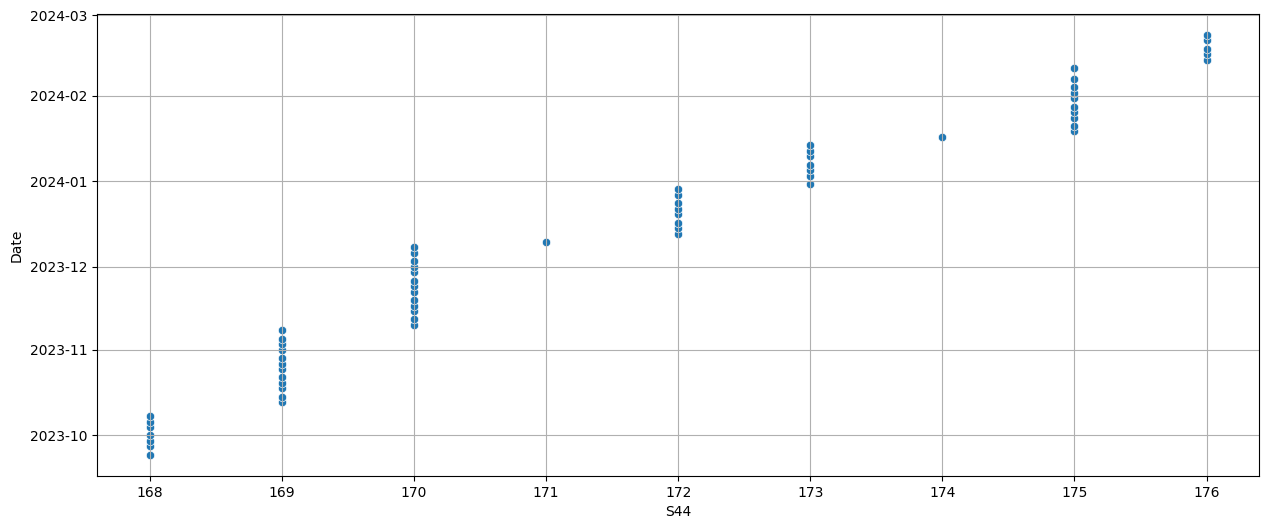

| S44 | 64.0 | 171.5 | 168.0 | 169.0 | 170.5 | 173.25 | 176.0 | 2.636737 |

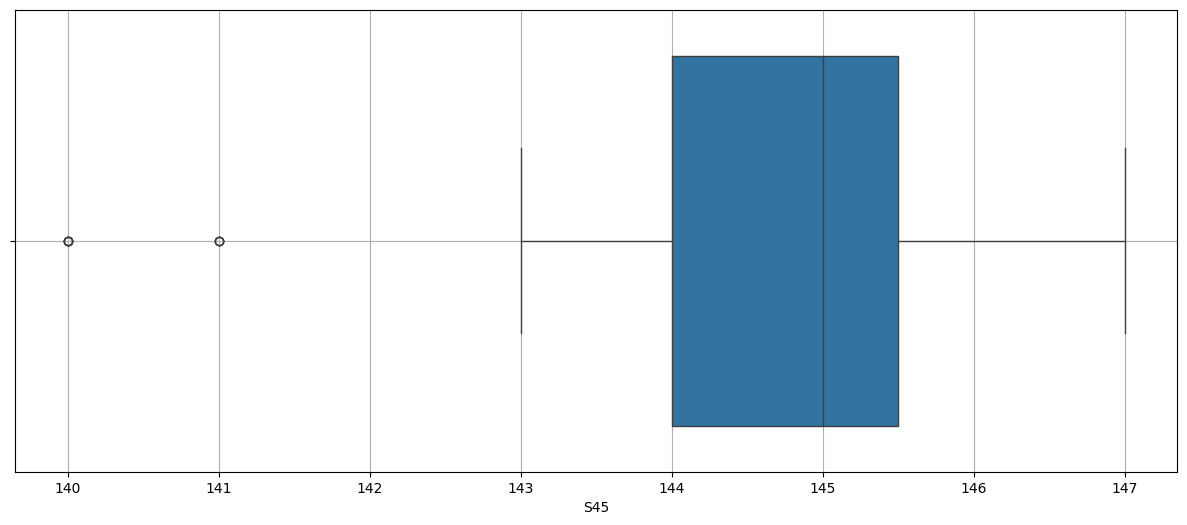

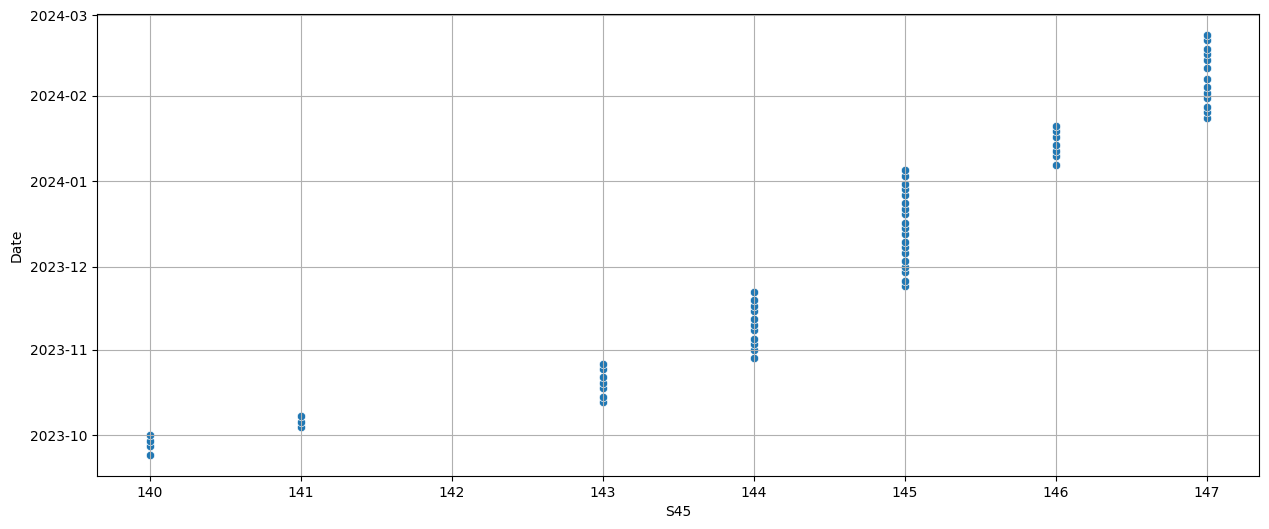

| S45 | 64.0 | 144.625 | 140.0 | 144.0 | 145.0 | 146.0 | 147.0 | 1.939563 |

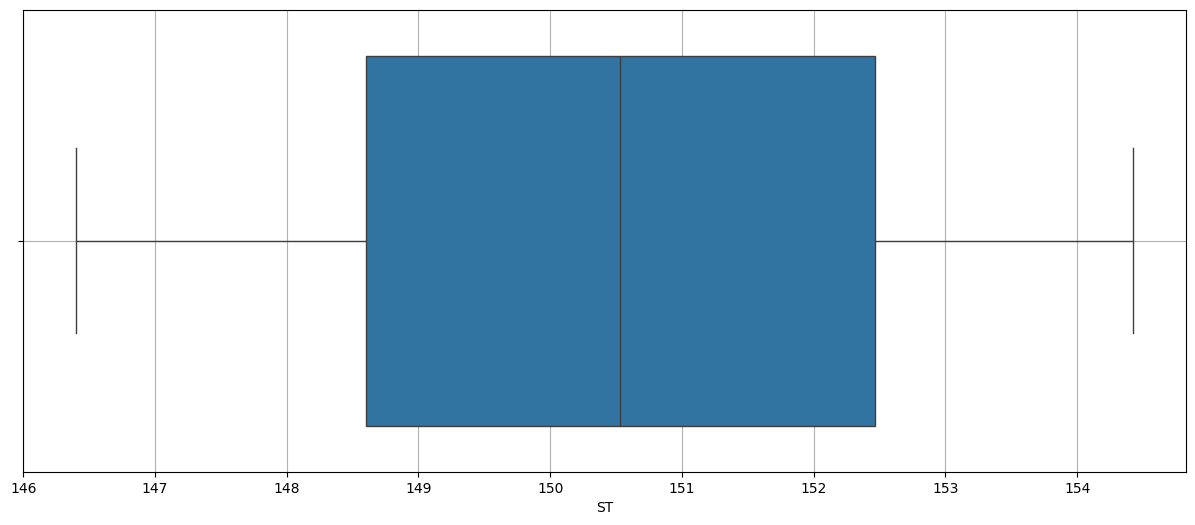

| ST | 64.0 | 150.853819 | 146.4 | 148.7675 | 150.866667 | 152.966667 | 155.088889 | 2.514648 |

df.describe(include="object").dataframe tbody tr th {

vertical-align: top;

}

.dataframe thead th {

text-align: right;

}

| Link | Type | BD | |

|---|---|---|---|

| count | 1 | 1 | 1 |

| unique | 1 | 1 | 1 |

| top | https://vietlott/vn/vi/choi/mega-6-45/thong-ke... | M6B45 | 18/07/2016 |

| freq | 1 | 1 | 1 |

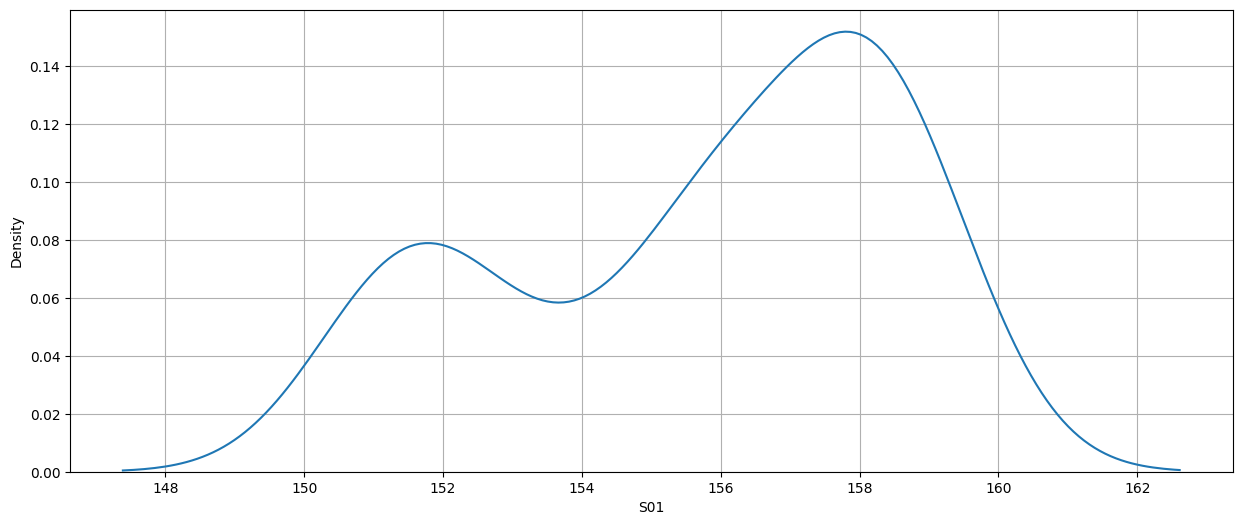

import warnings

warnings.filterwarnings('ignore')

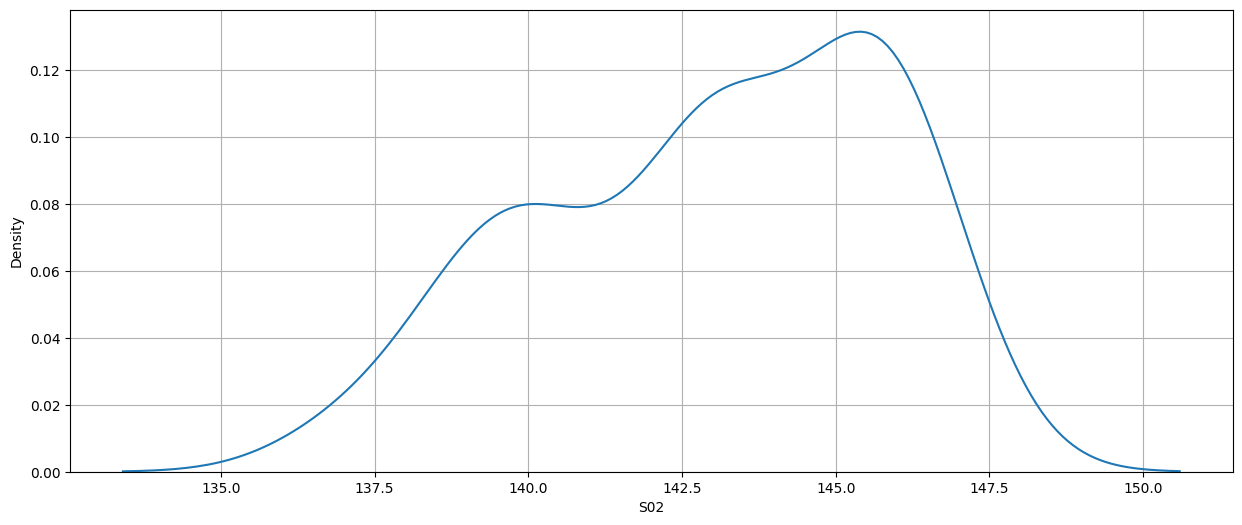

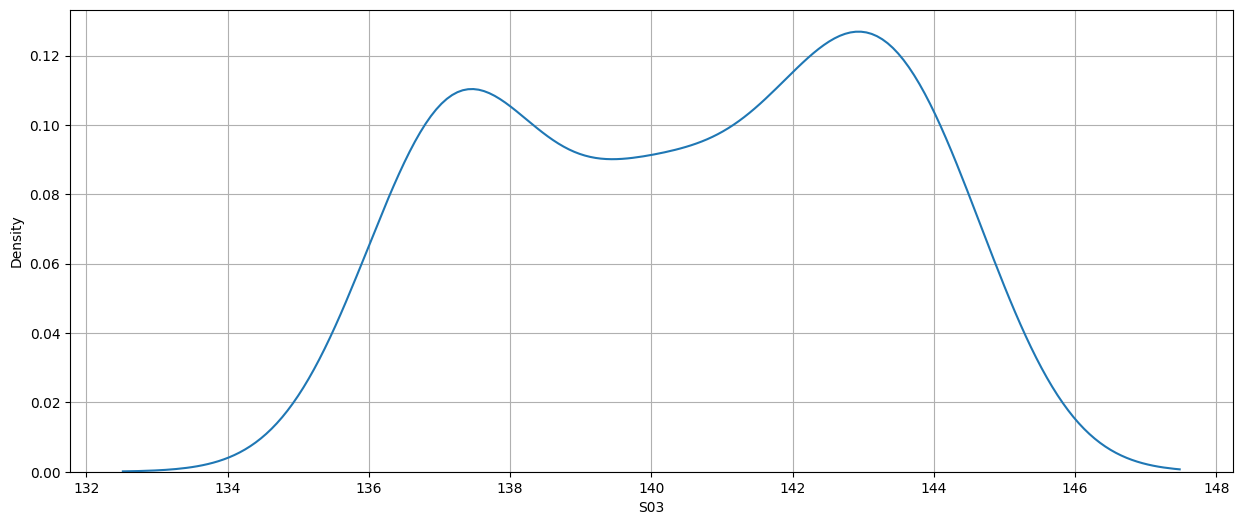

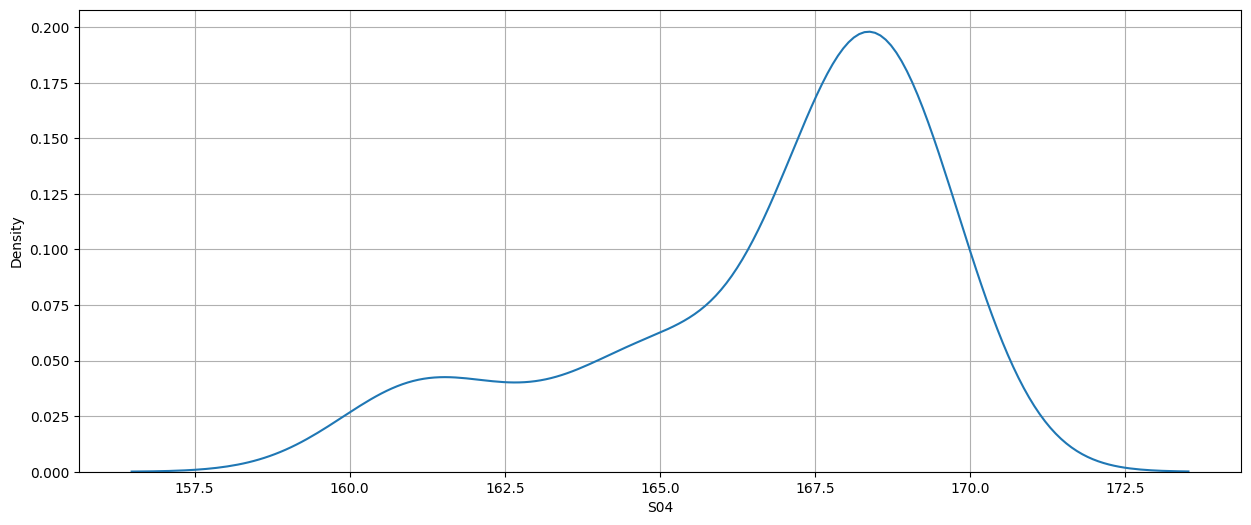

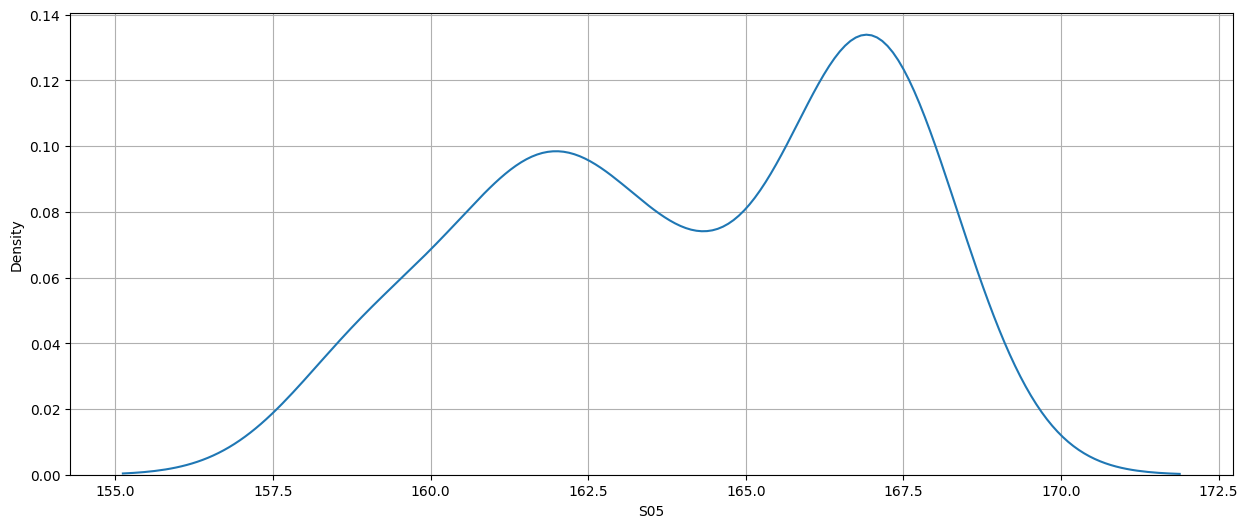

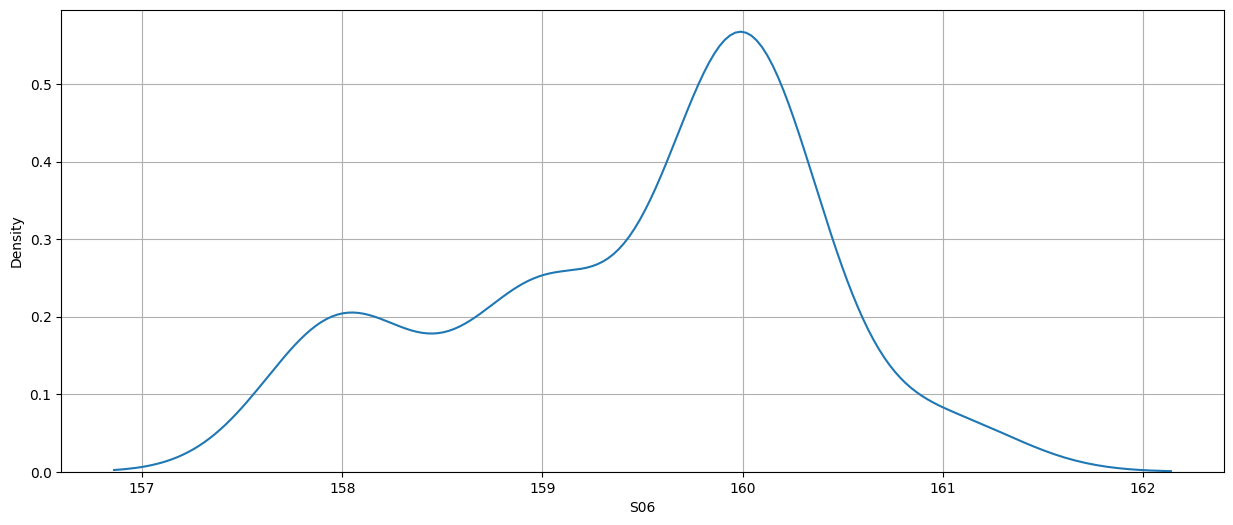

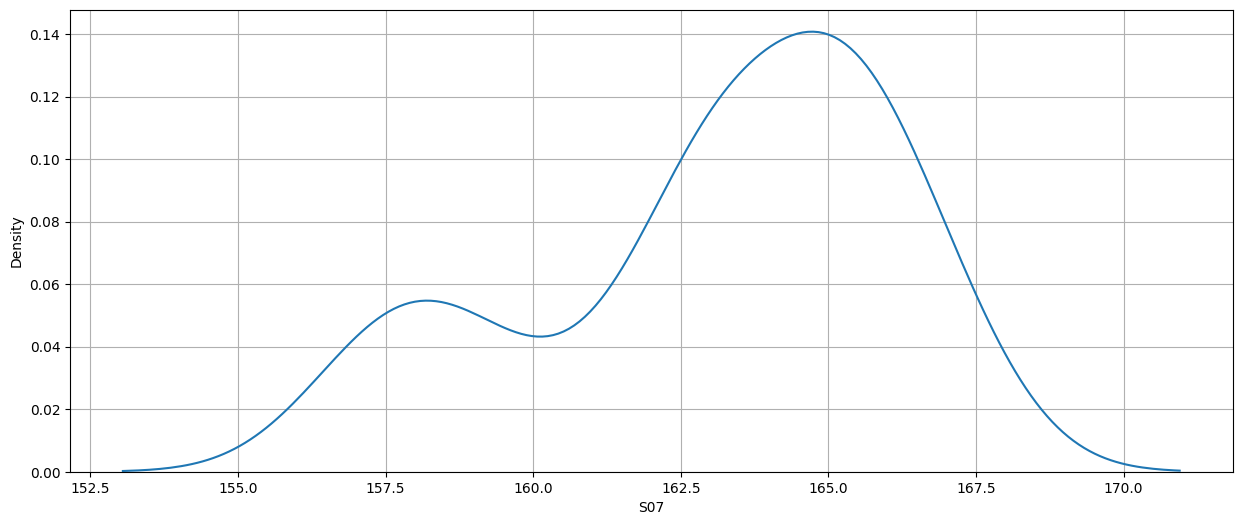

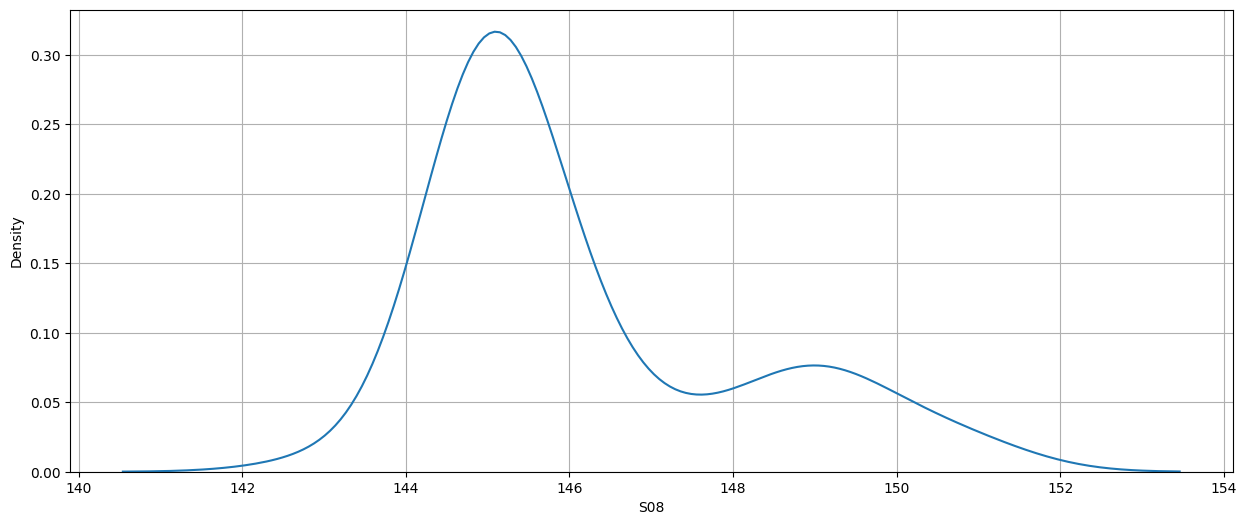

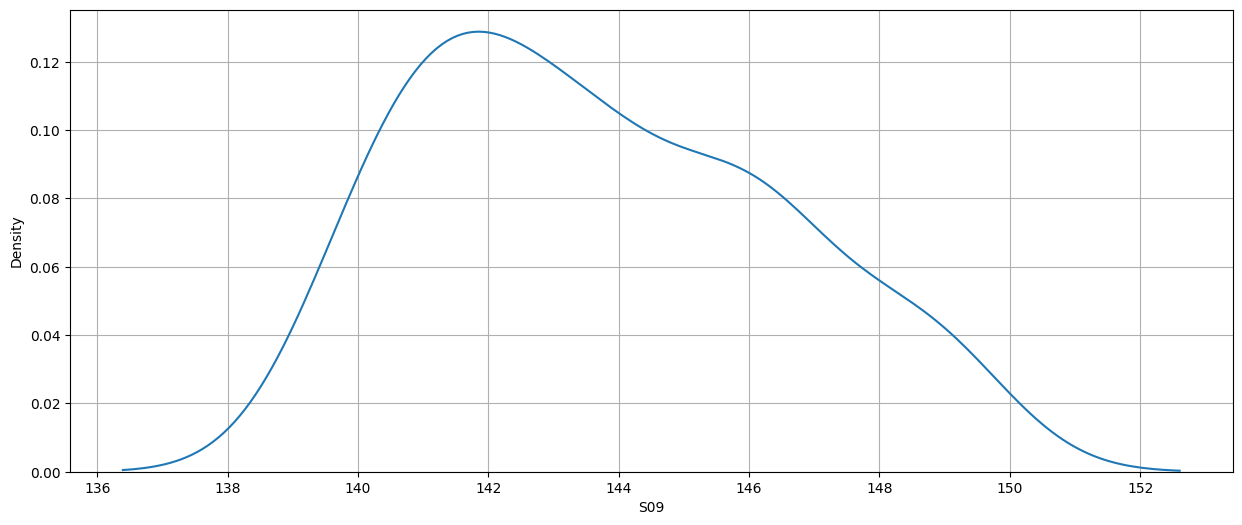

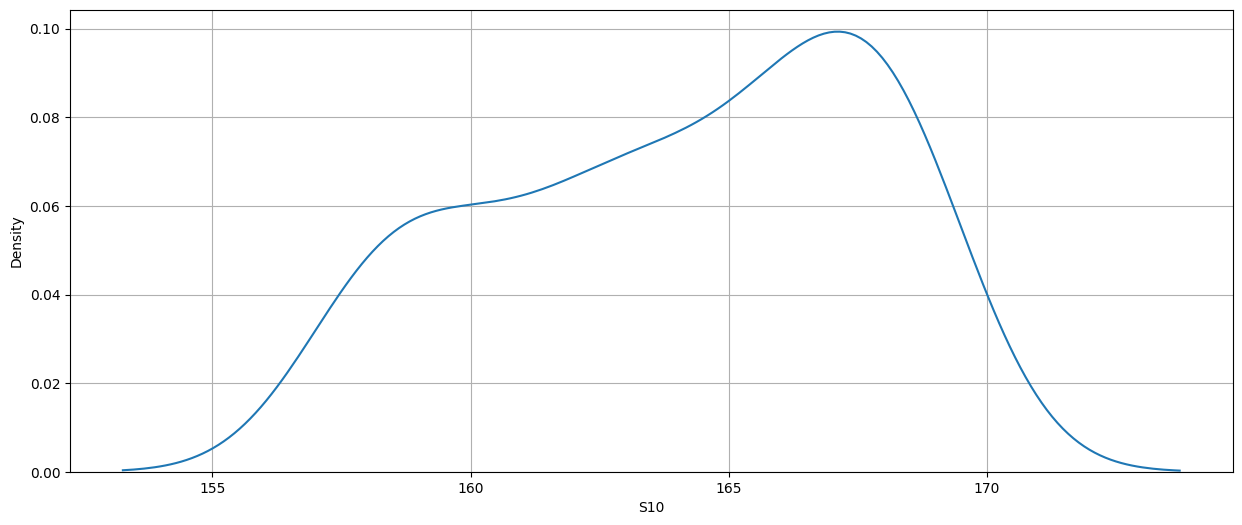

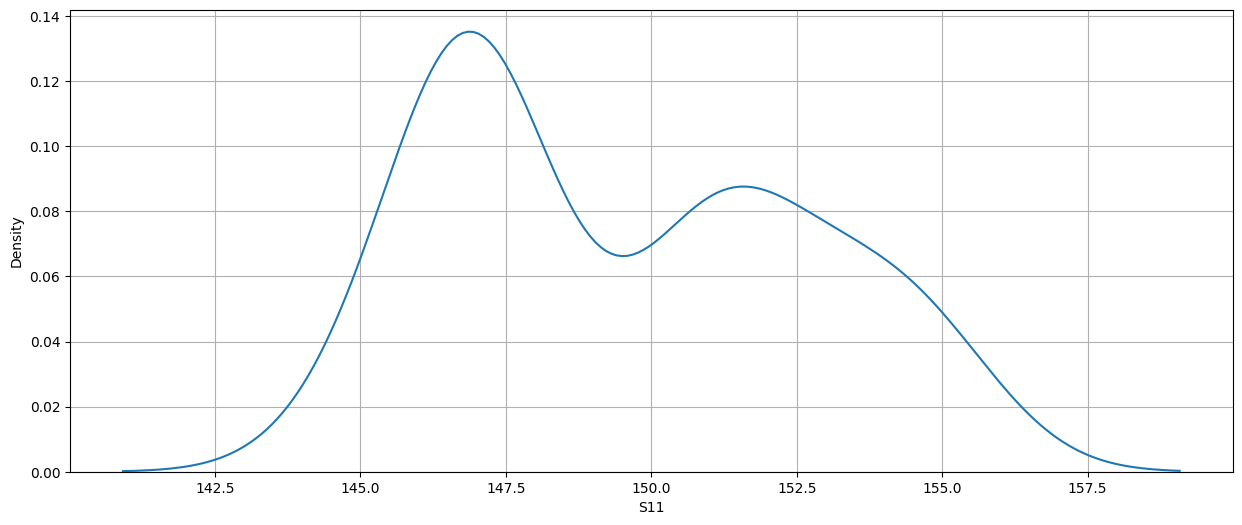

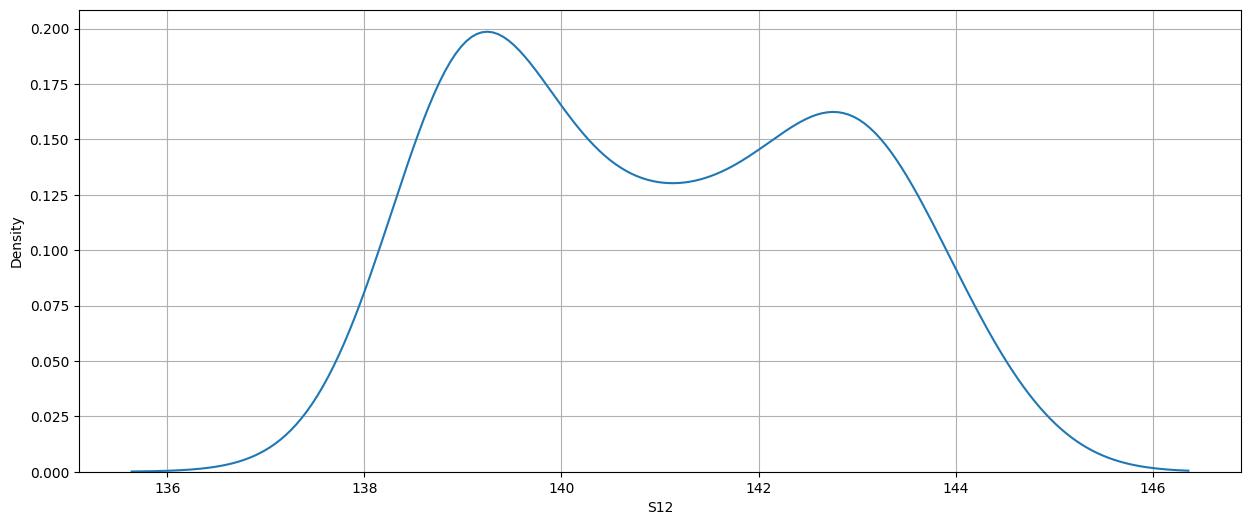

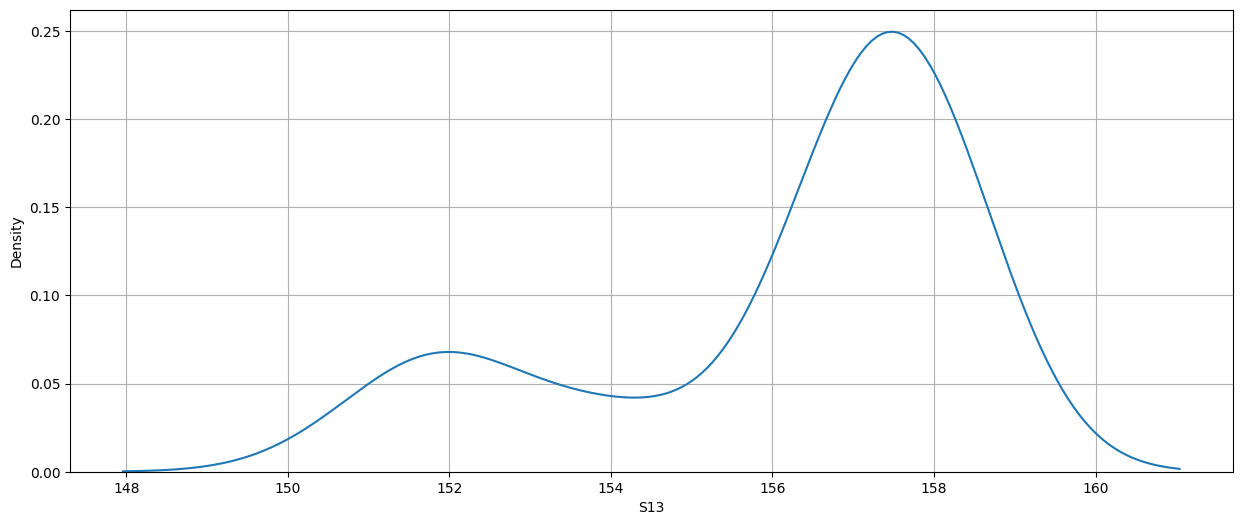

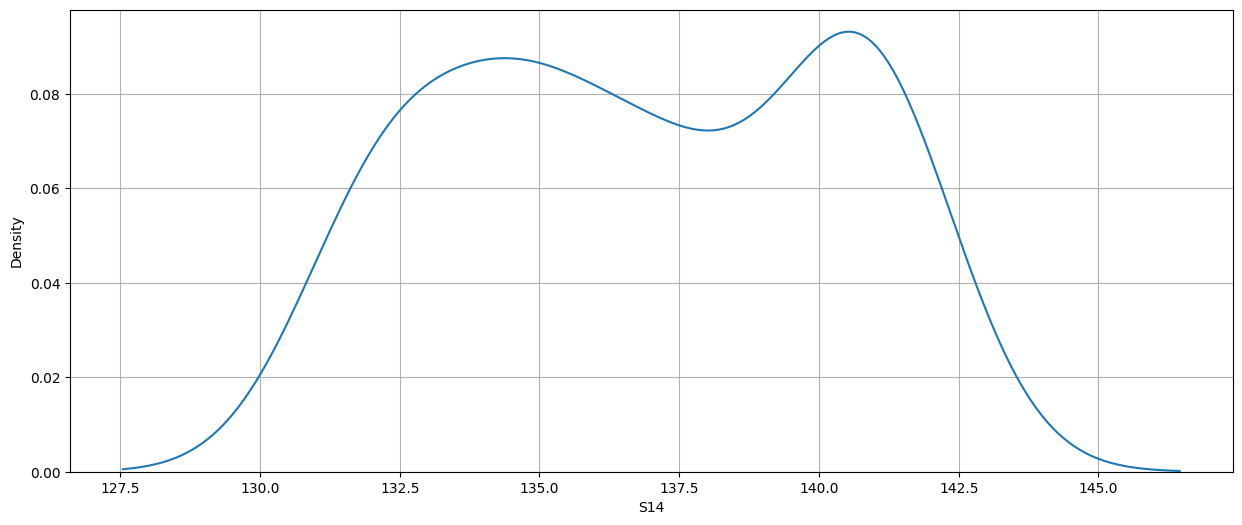

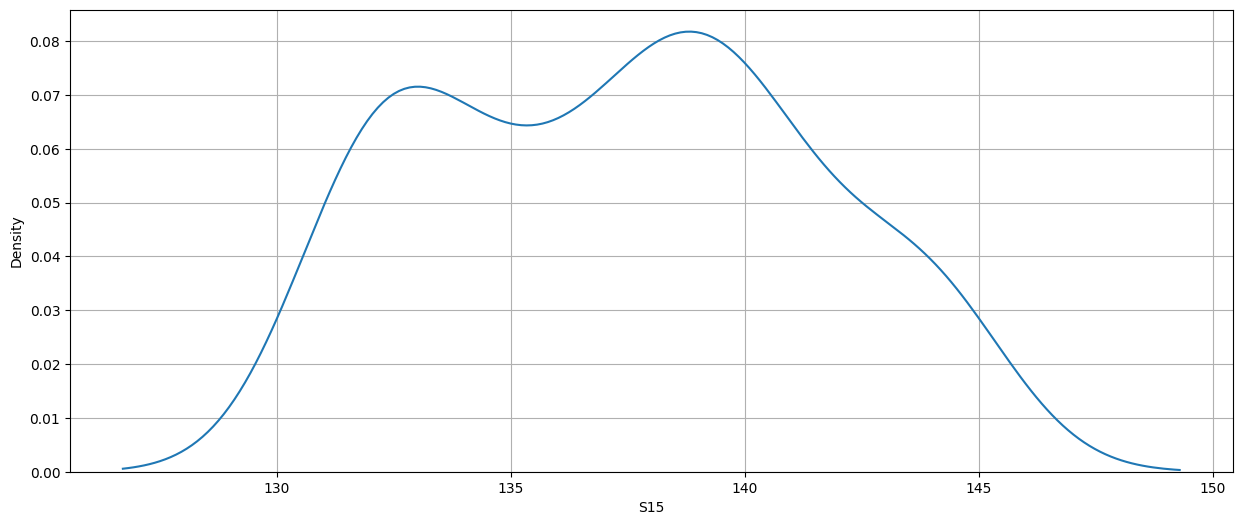

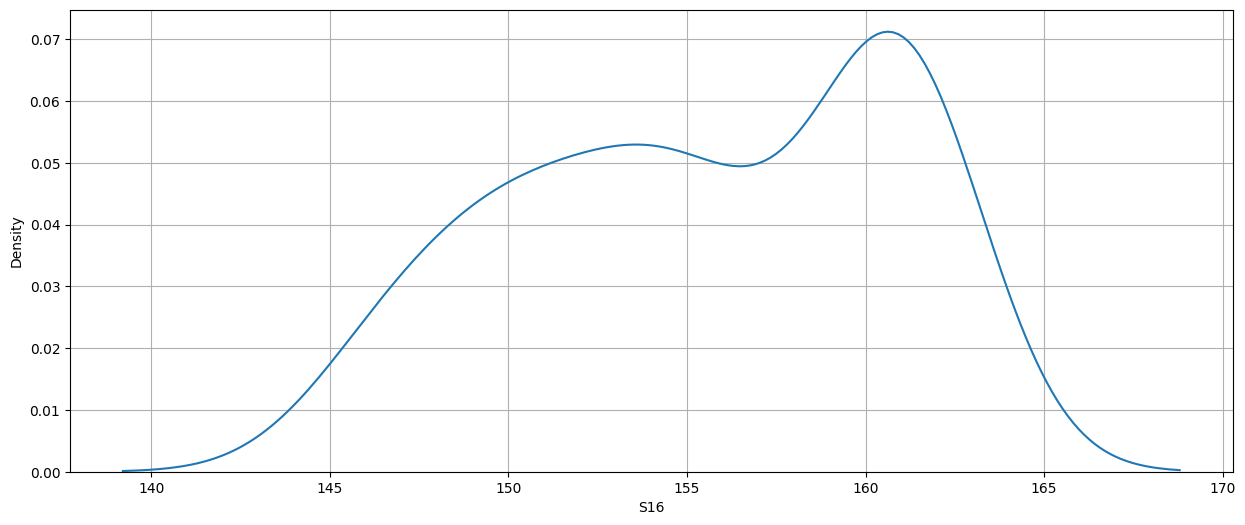

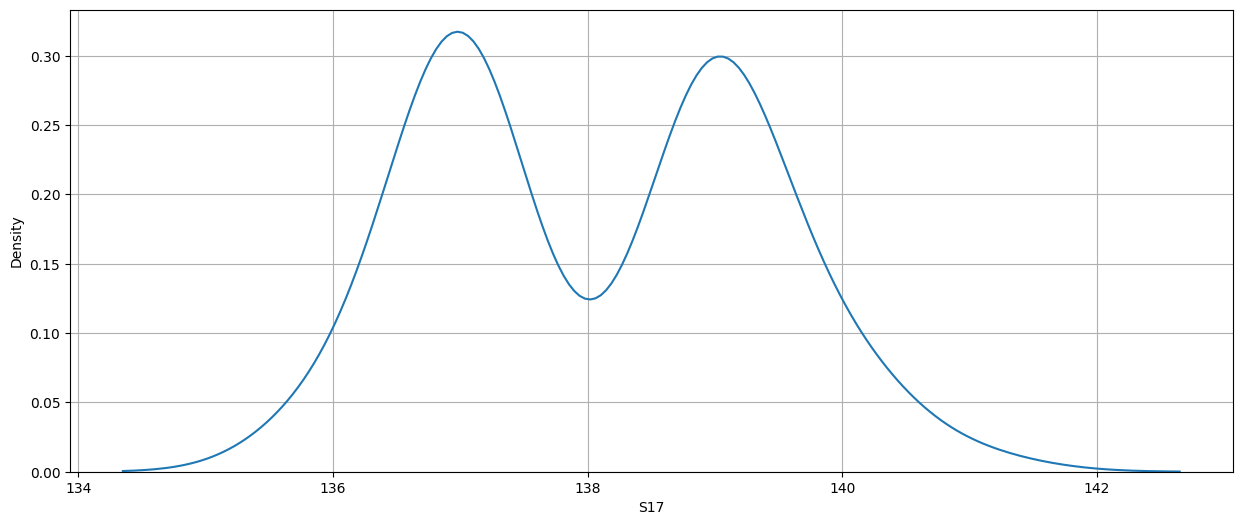

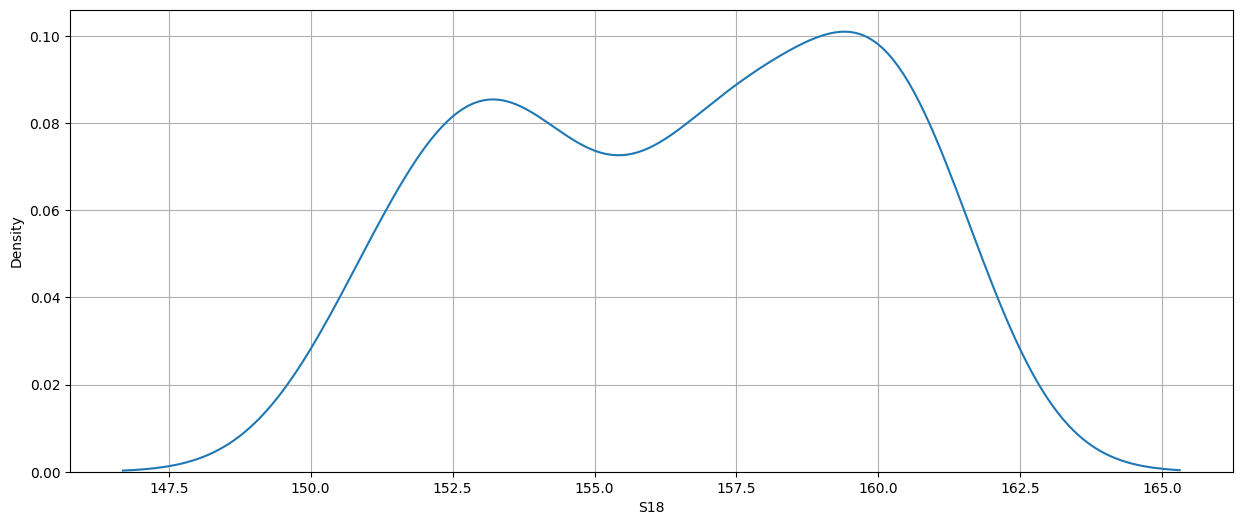

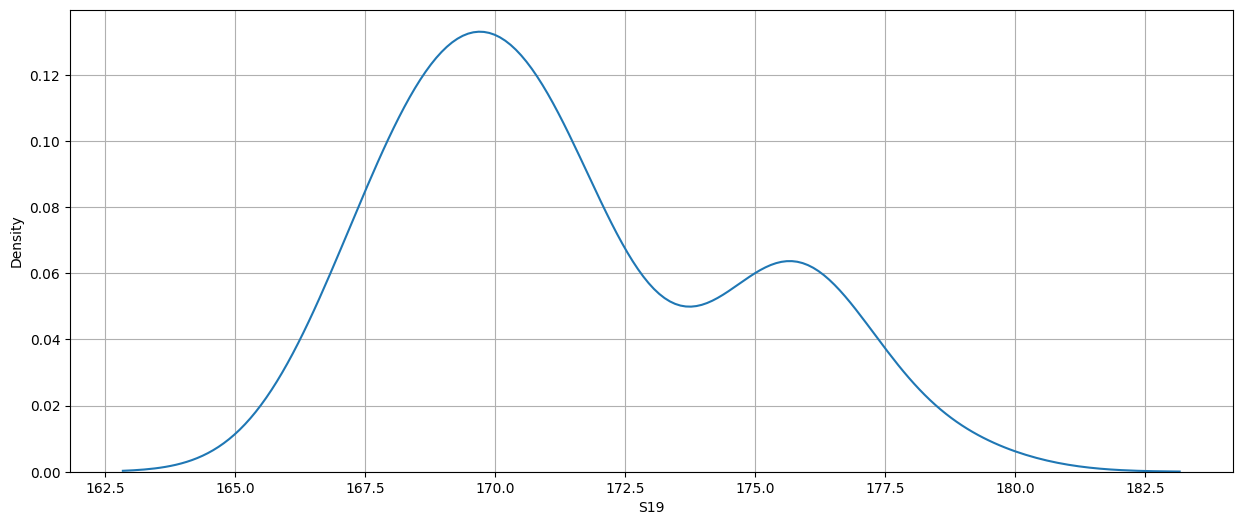

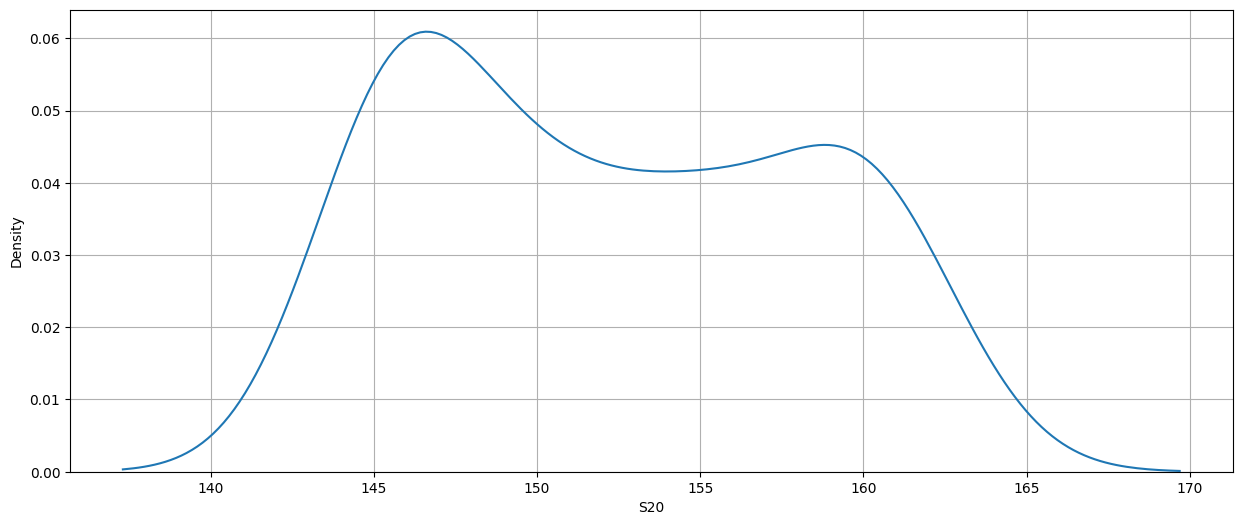

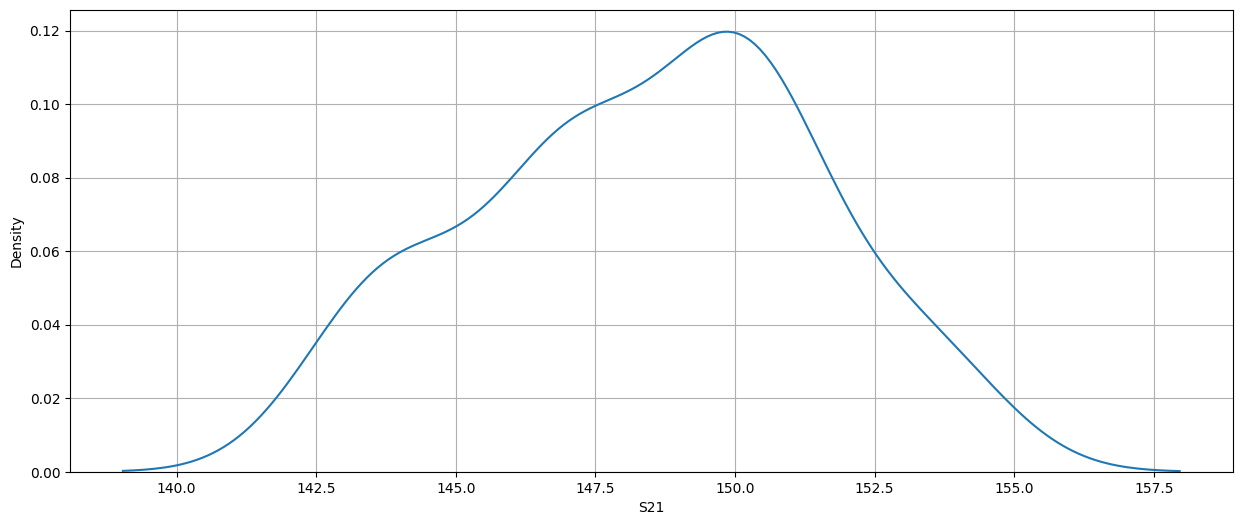

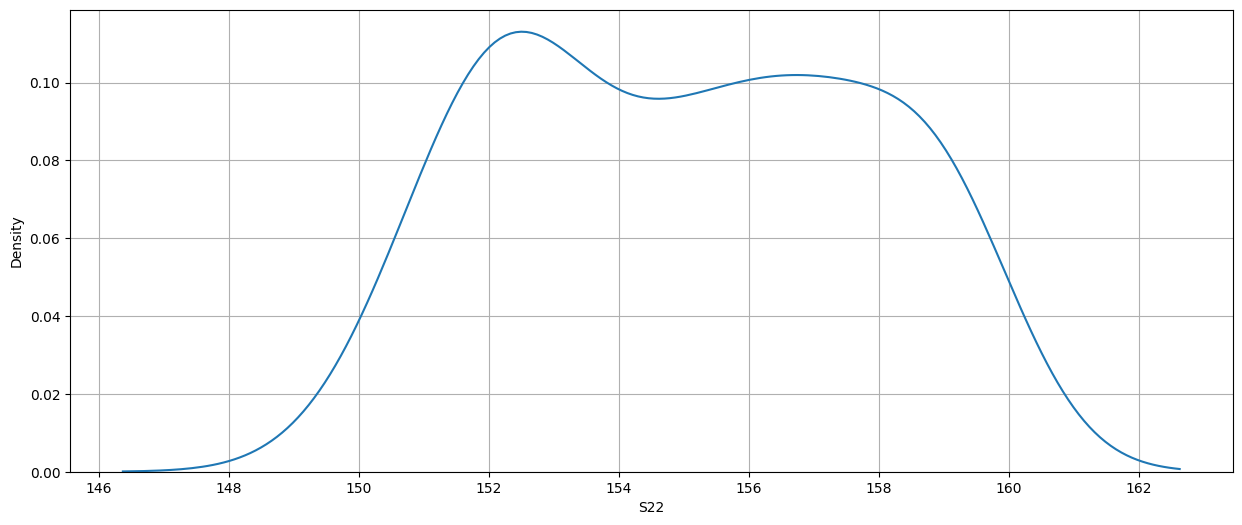

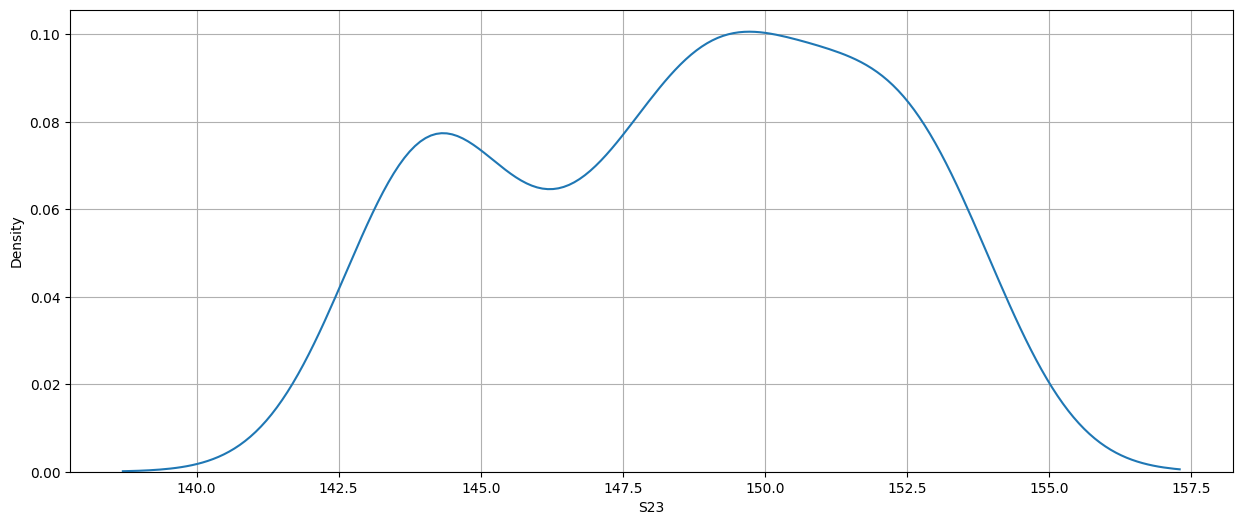

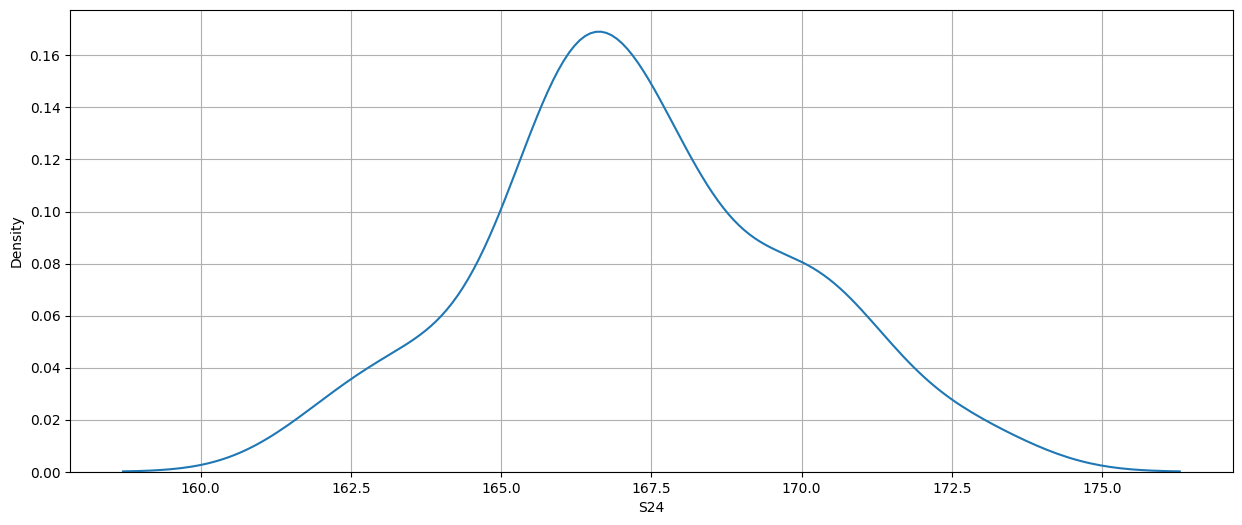

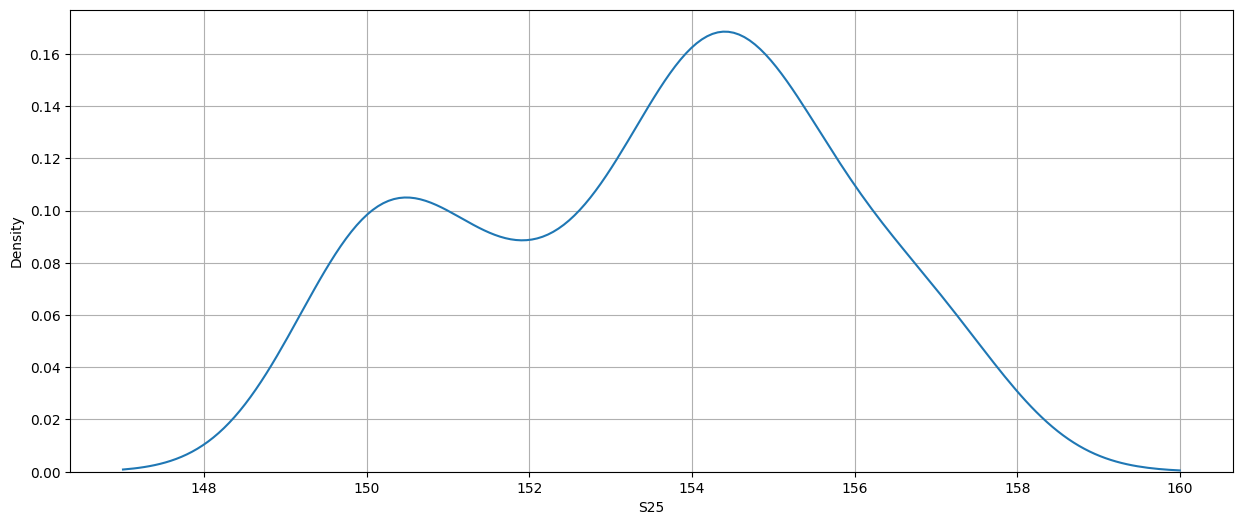

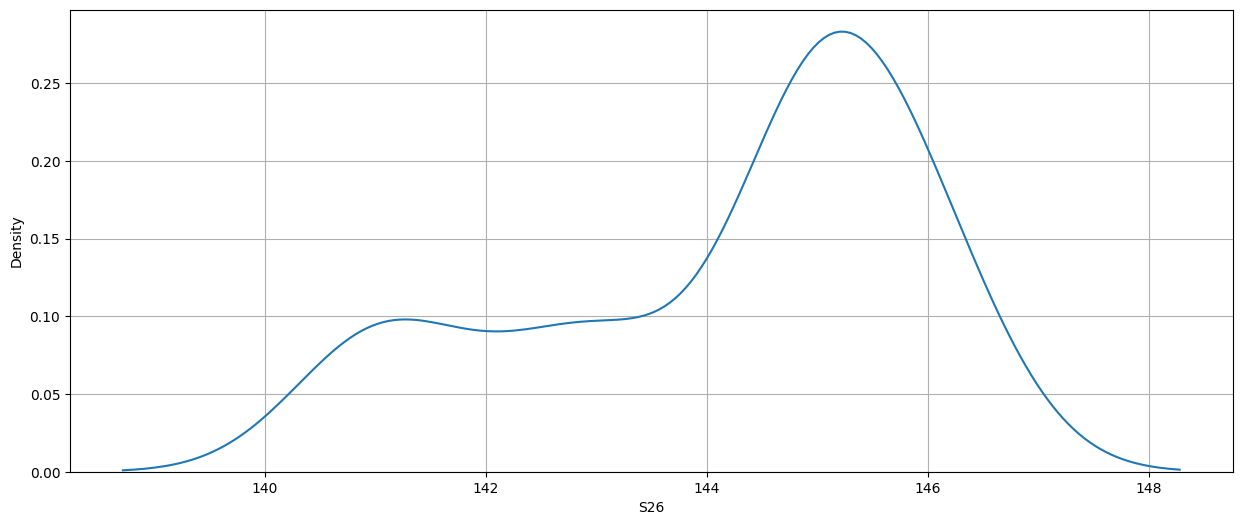

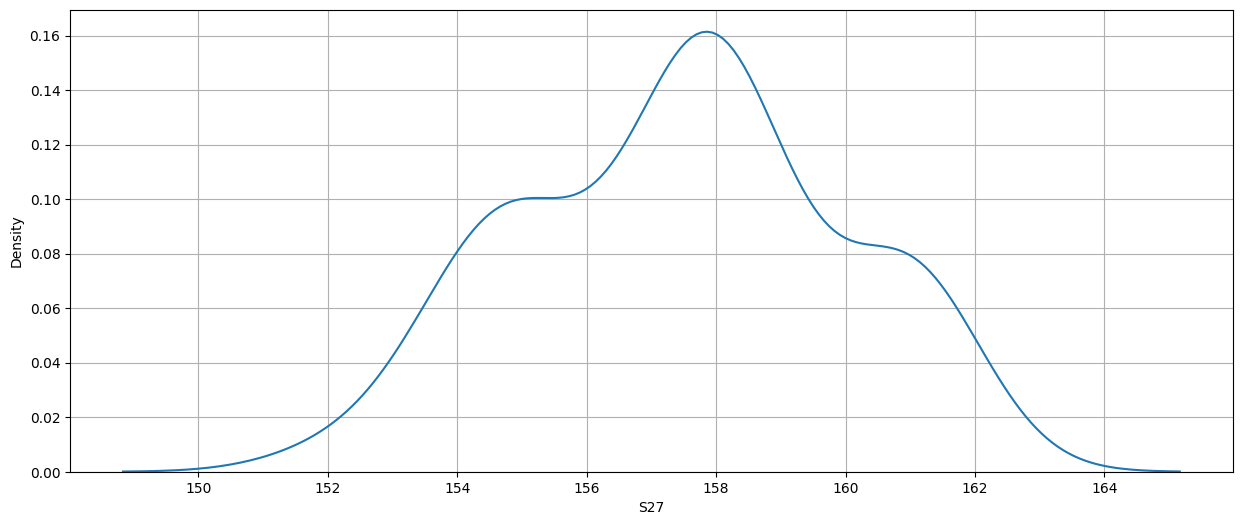

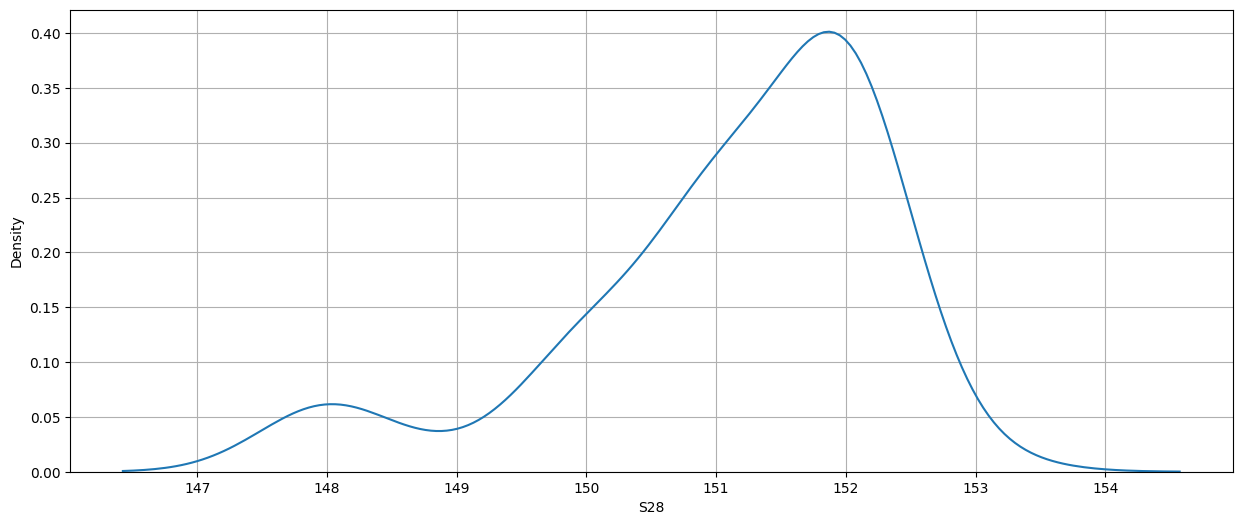

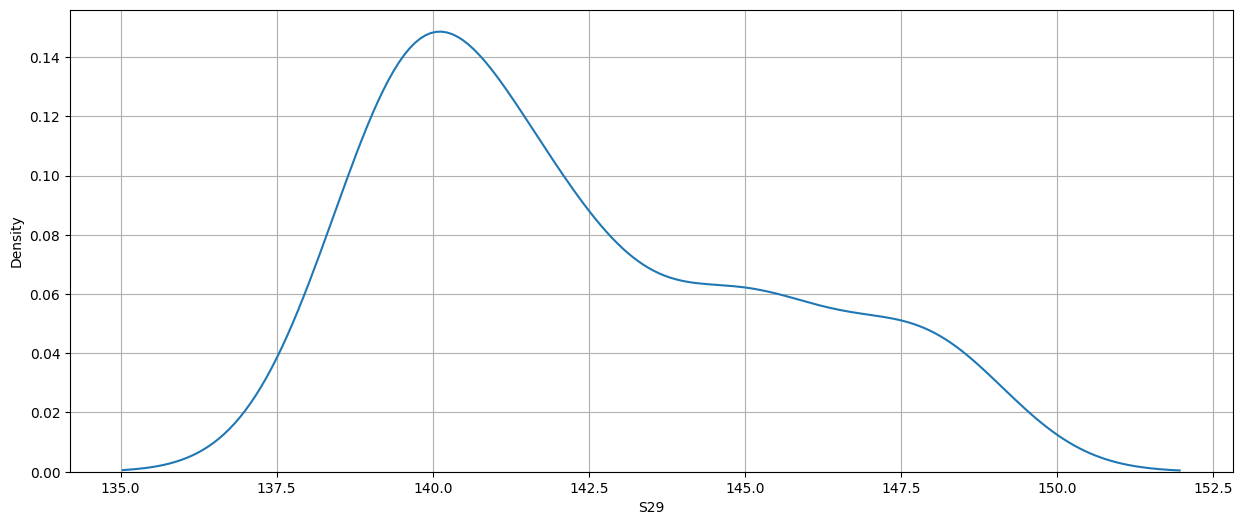

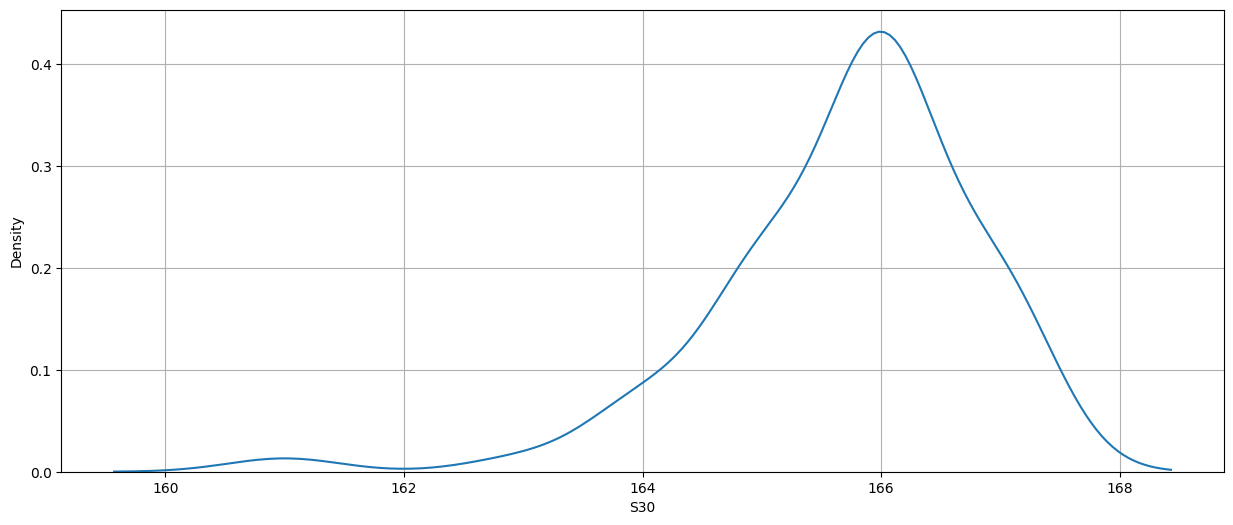

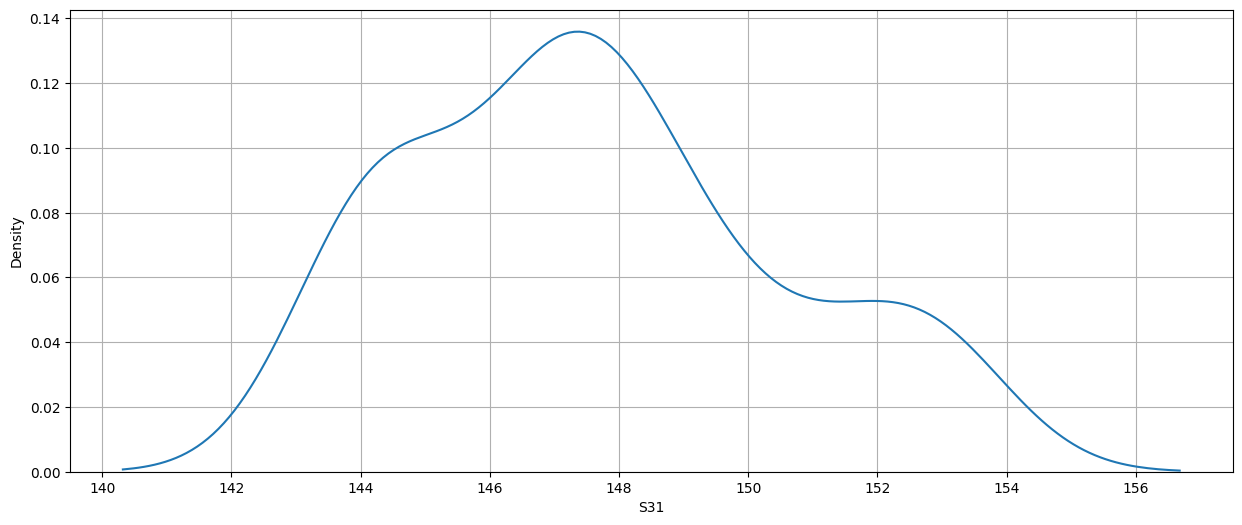

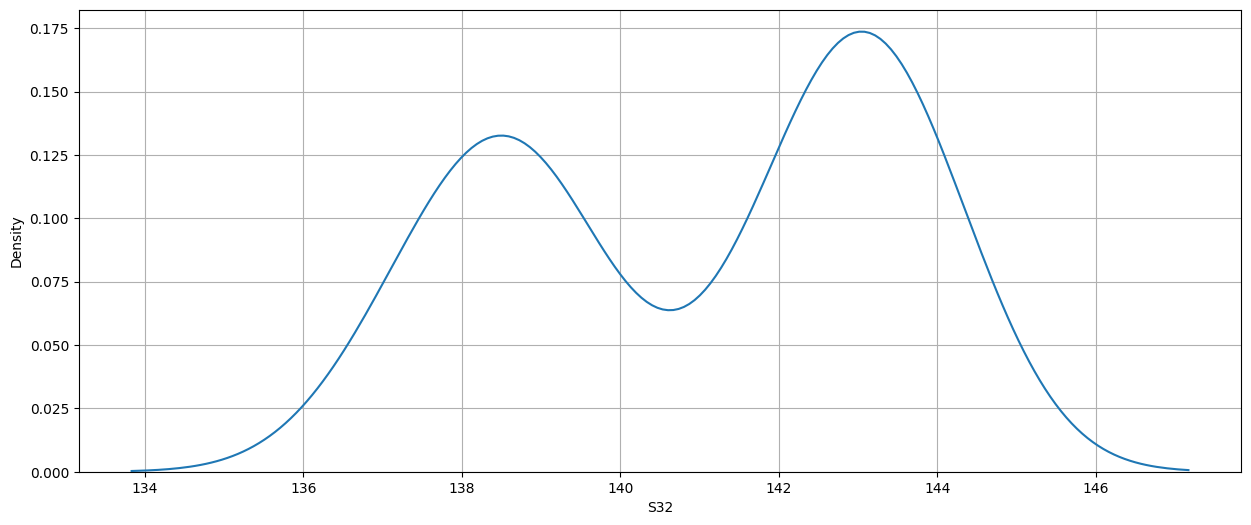

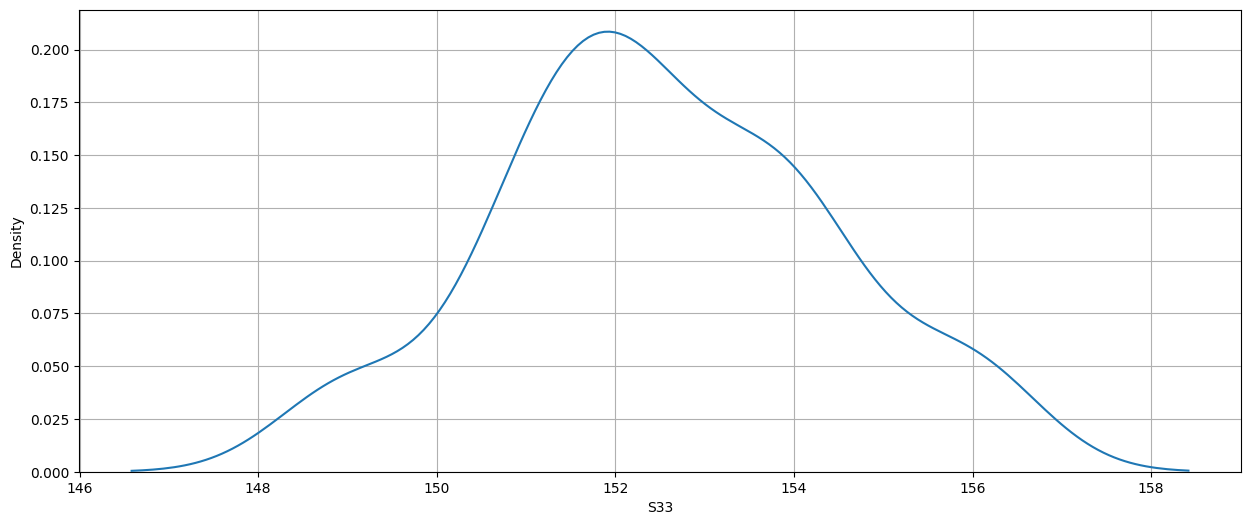

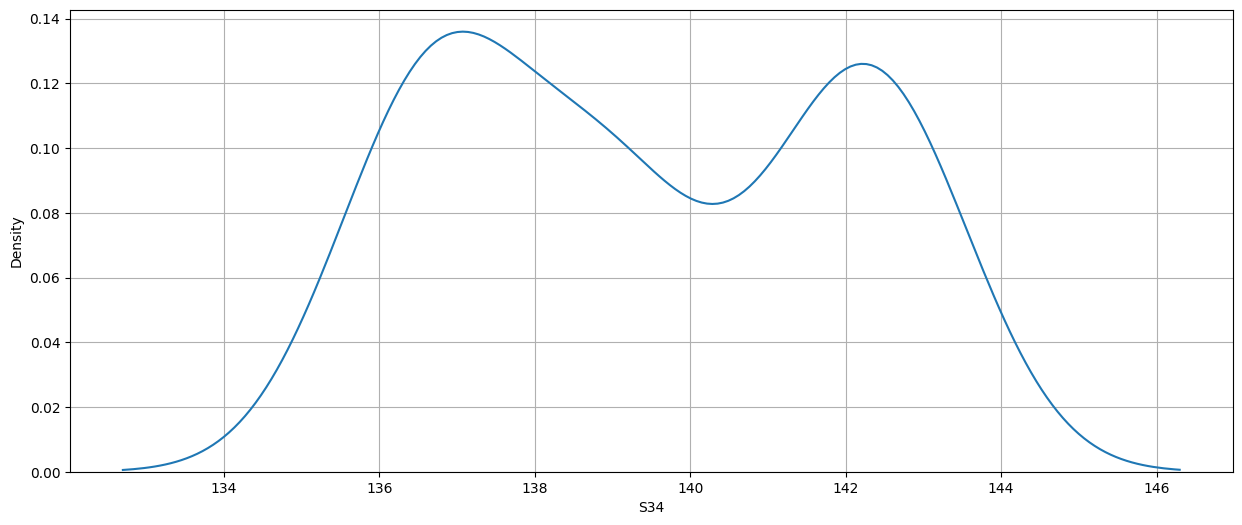

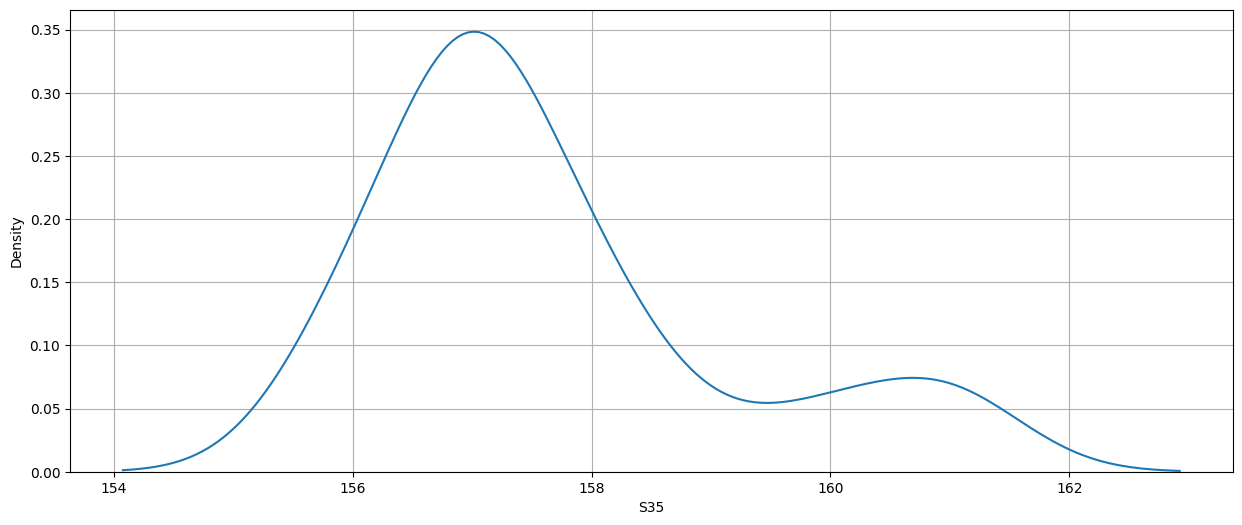

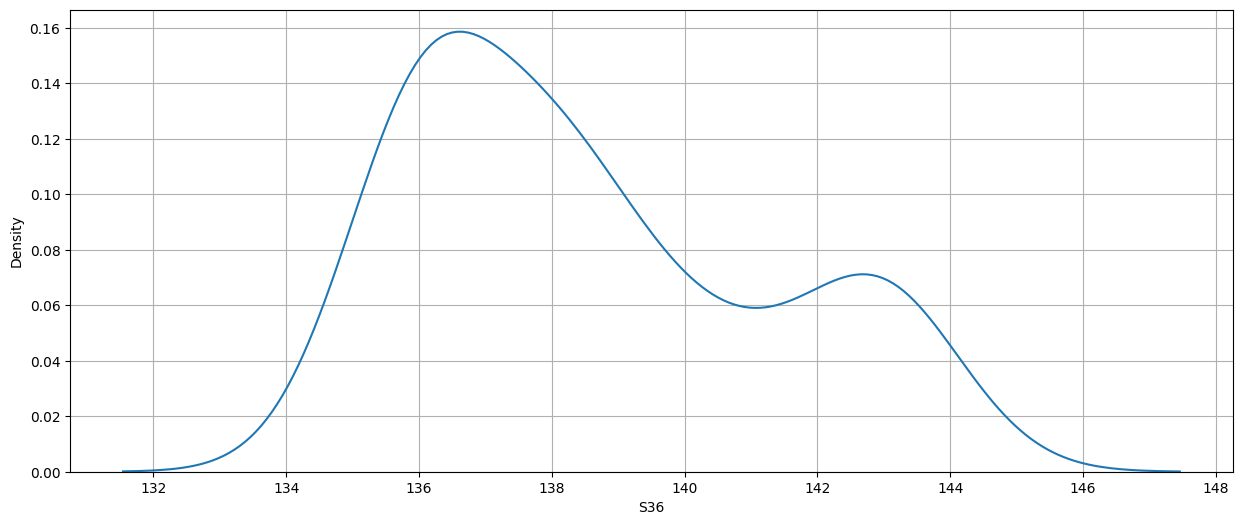

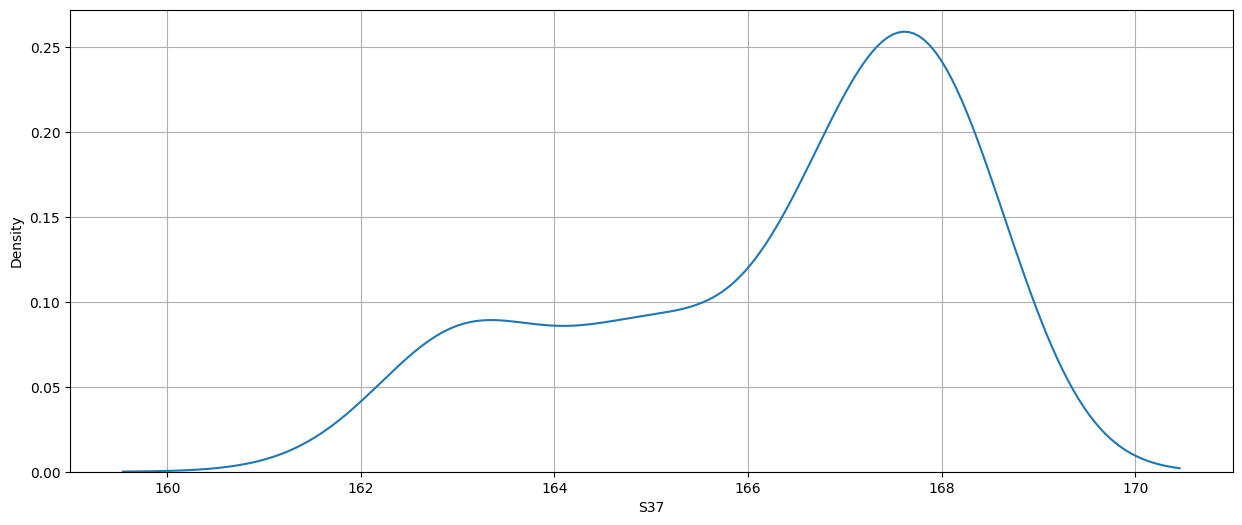

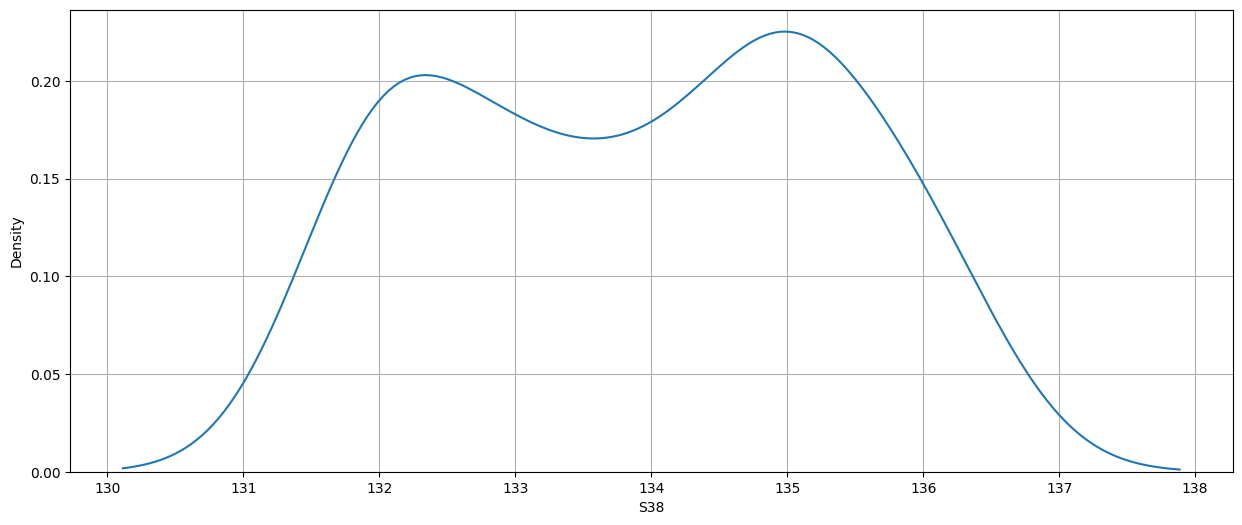

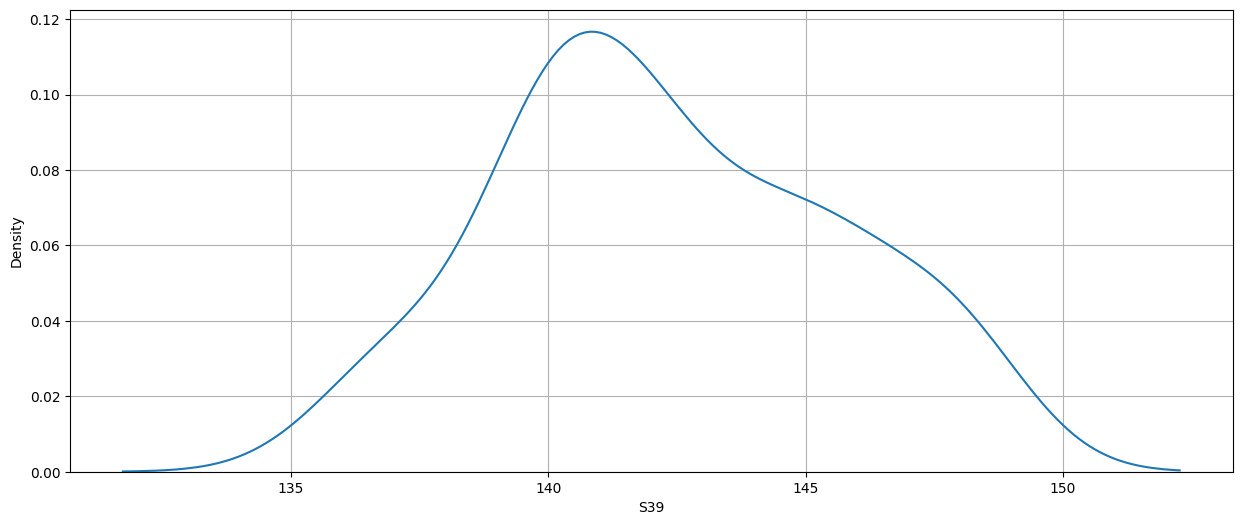

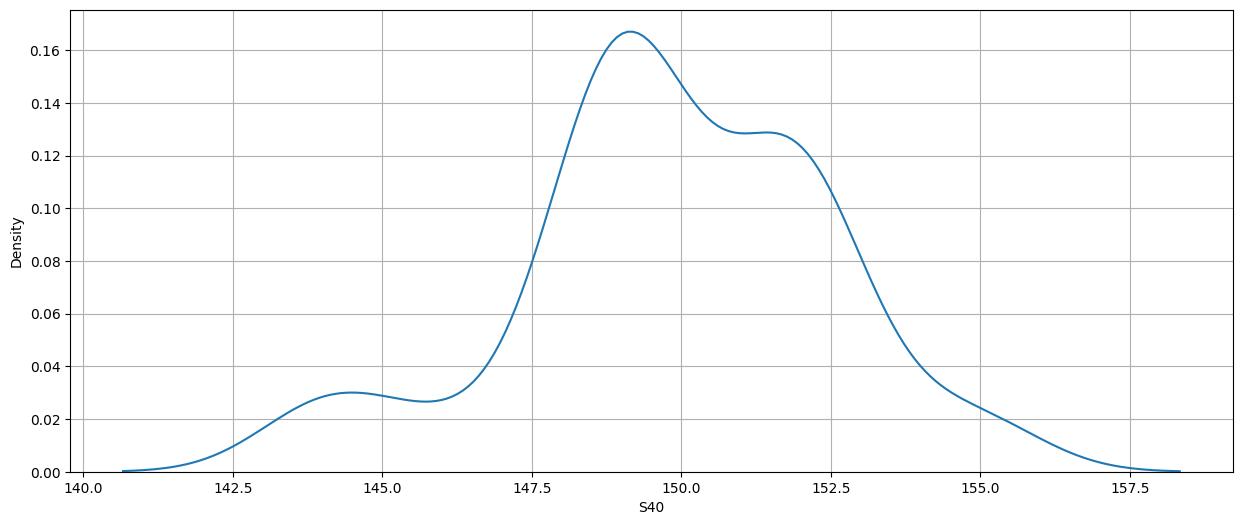

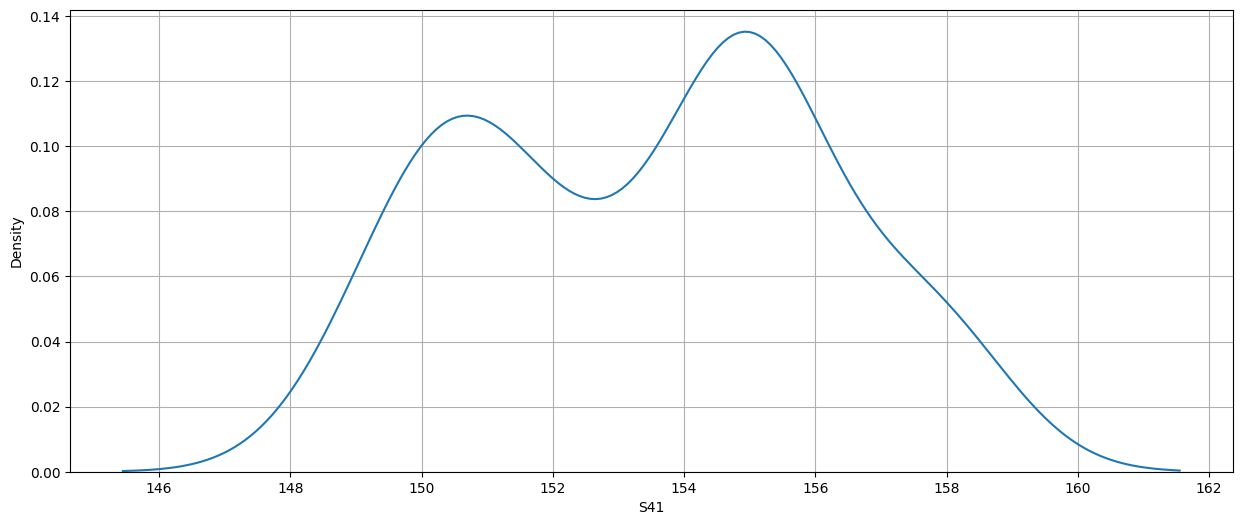

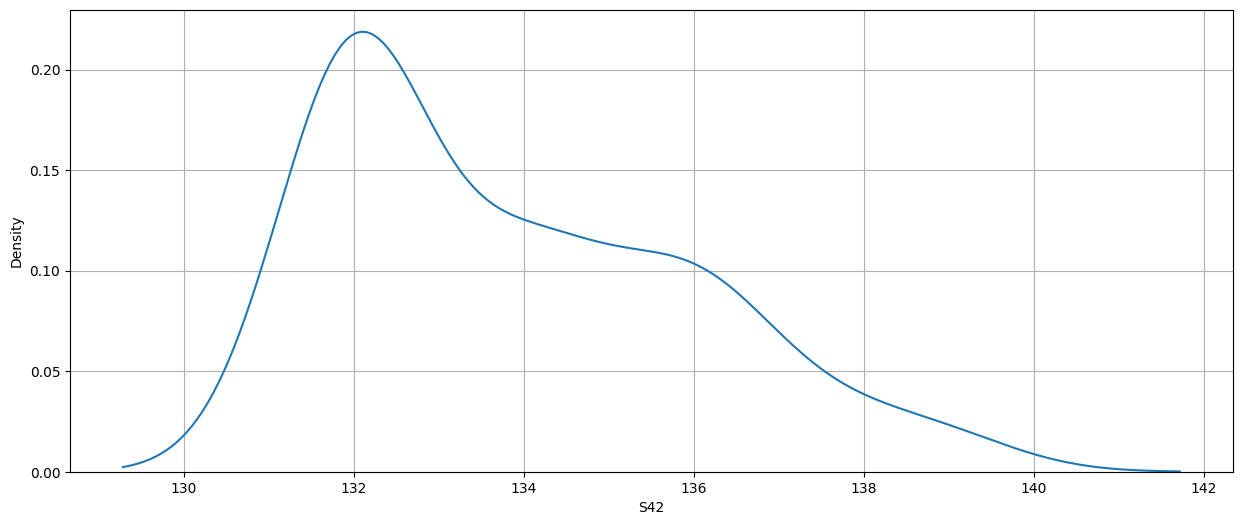

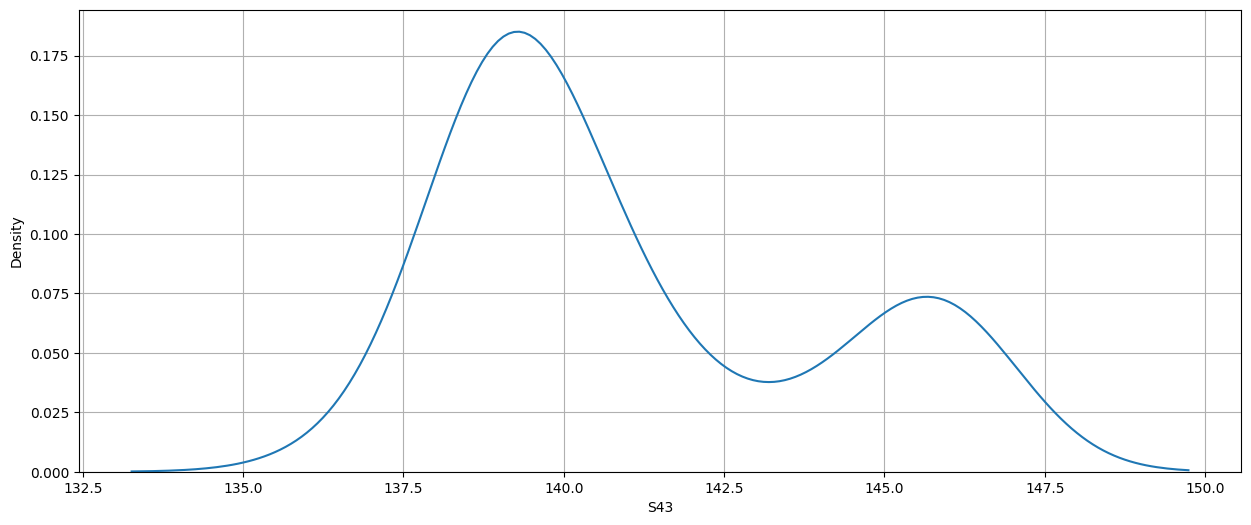

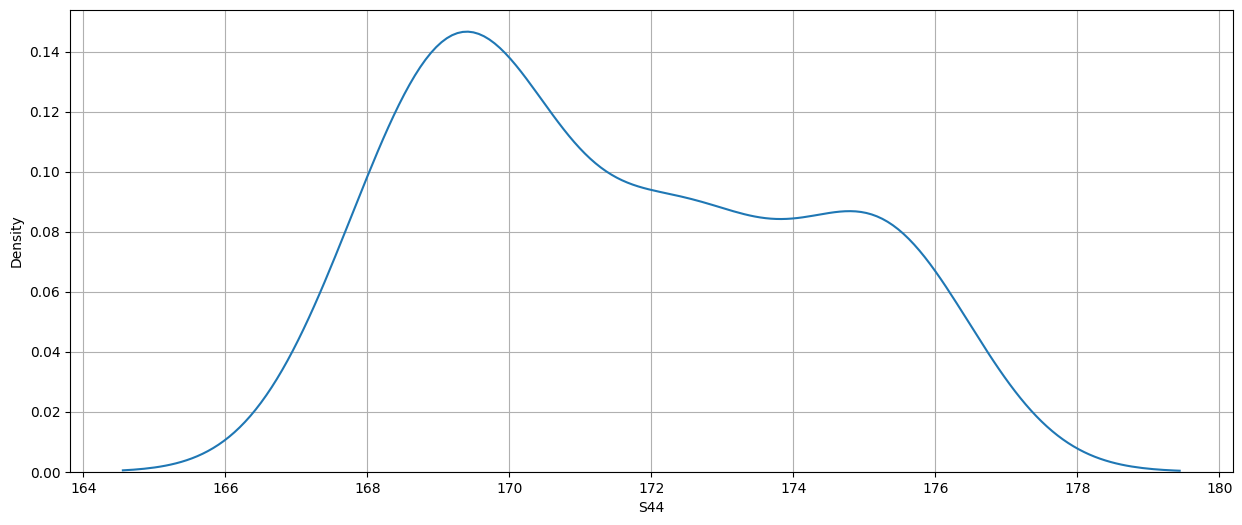

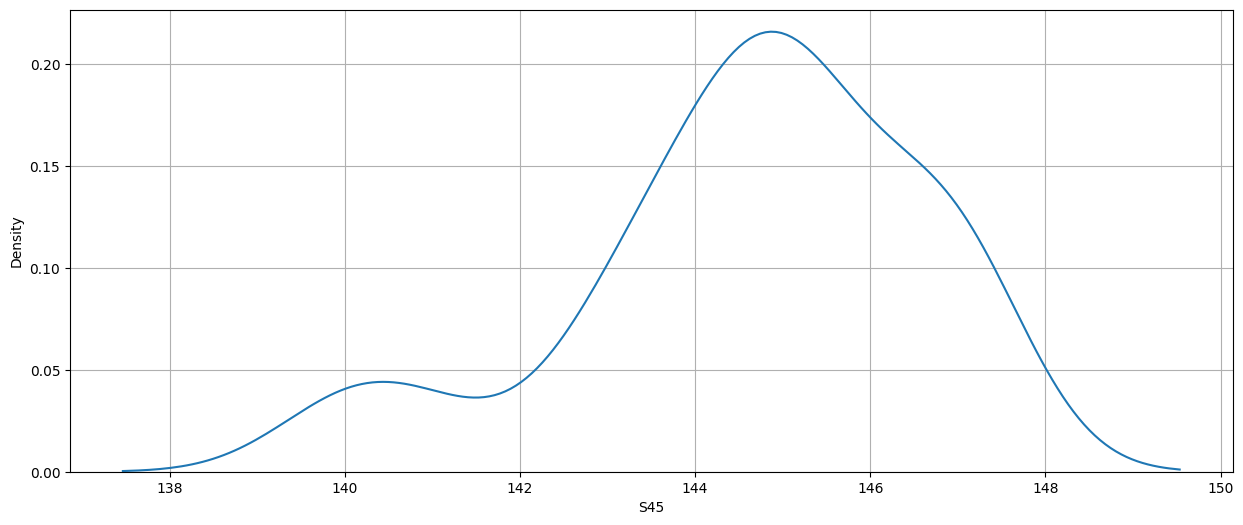

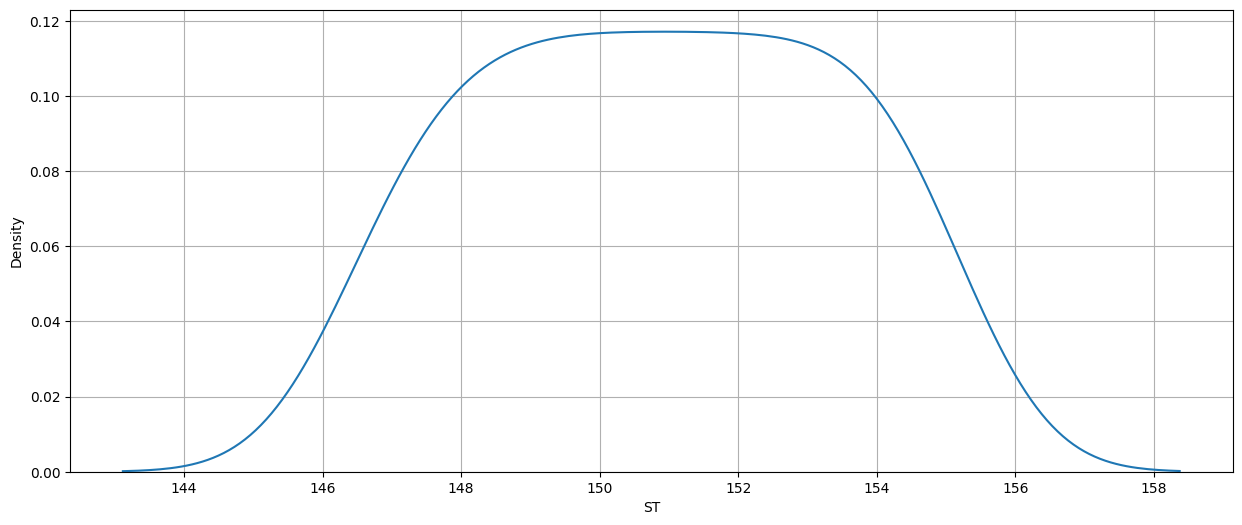

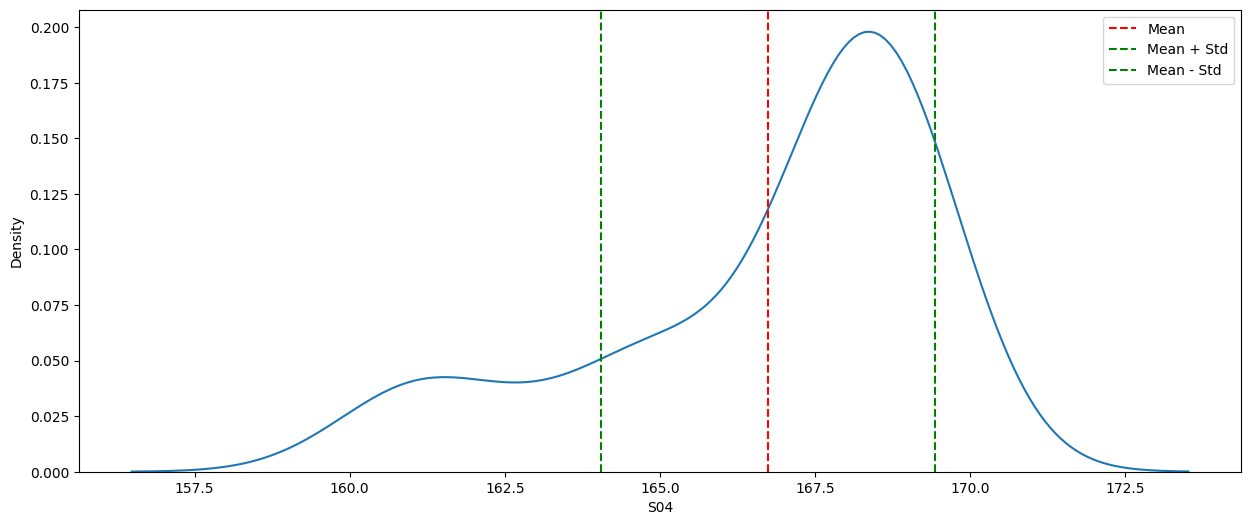

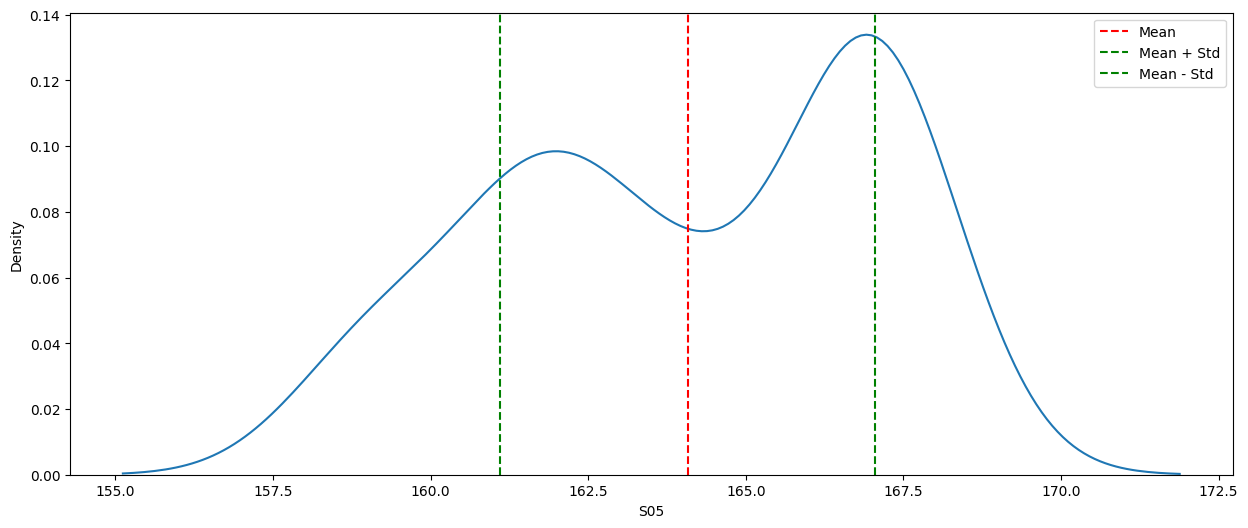

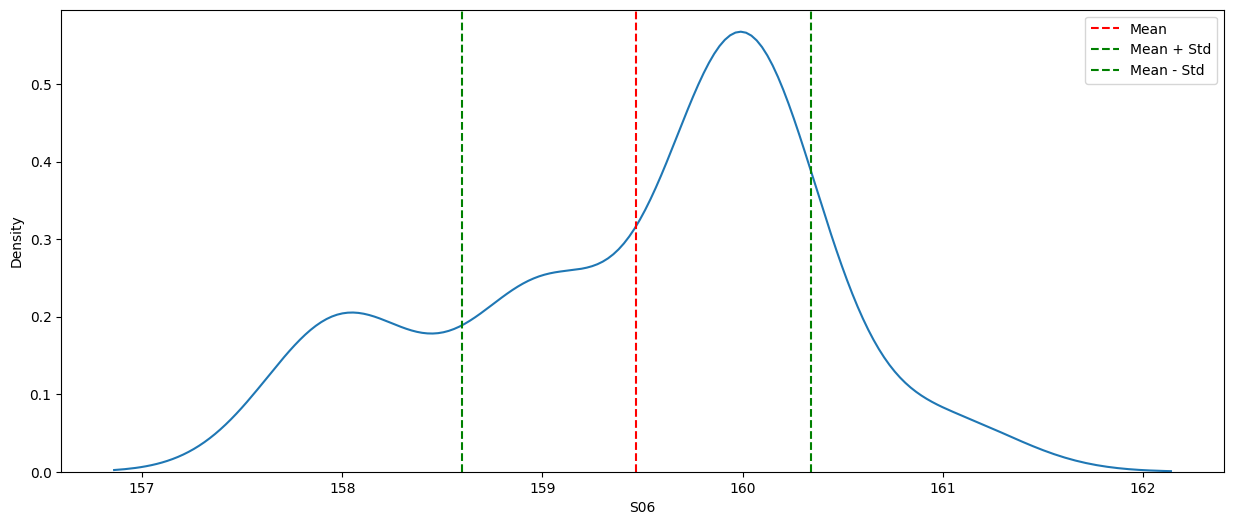

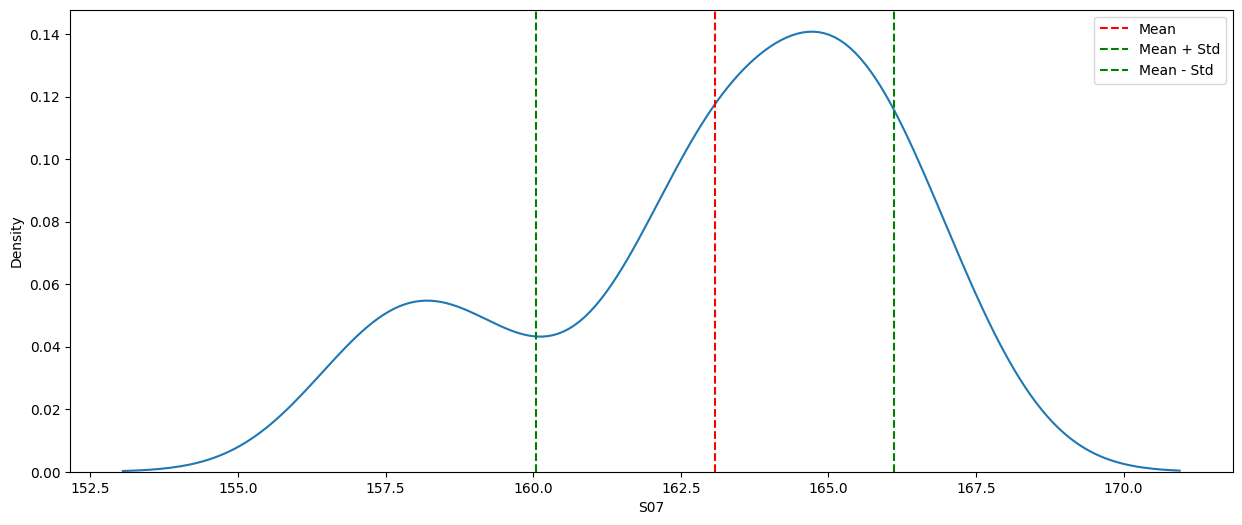

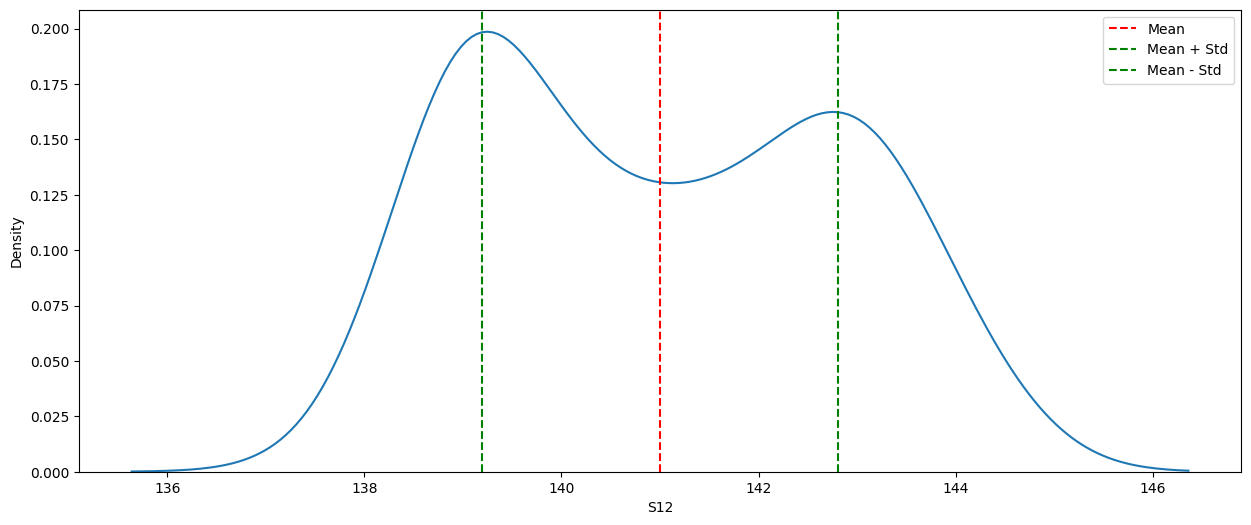

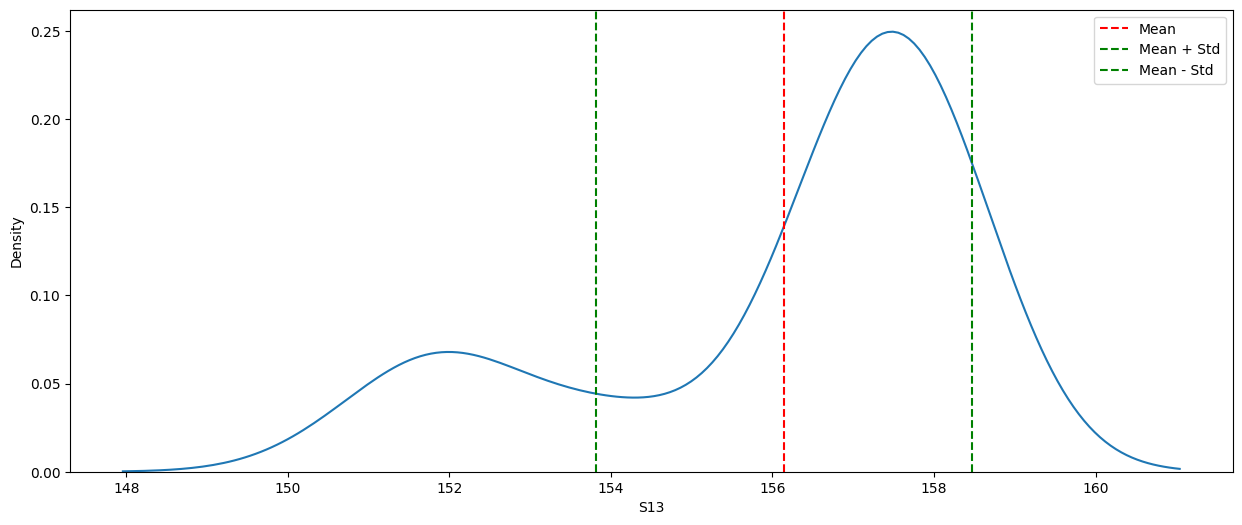

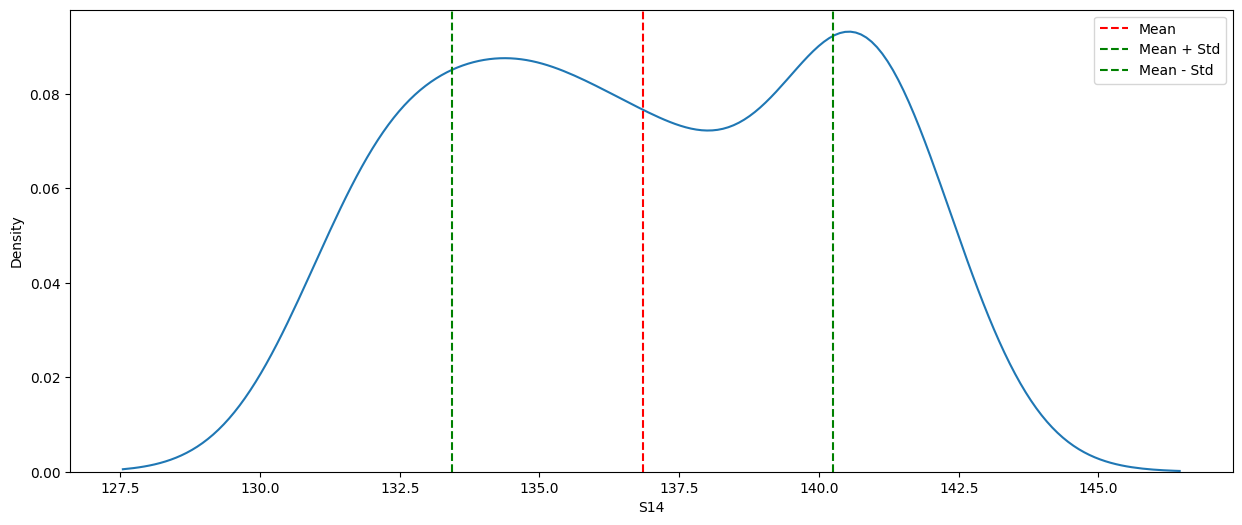

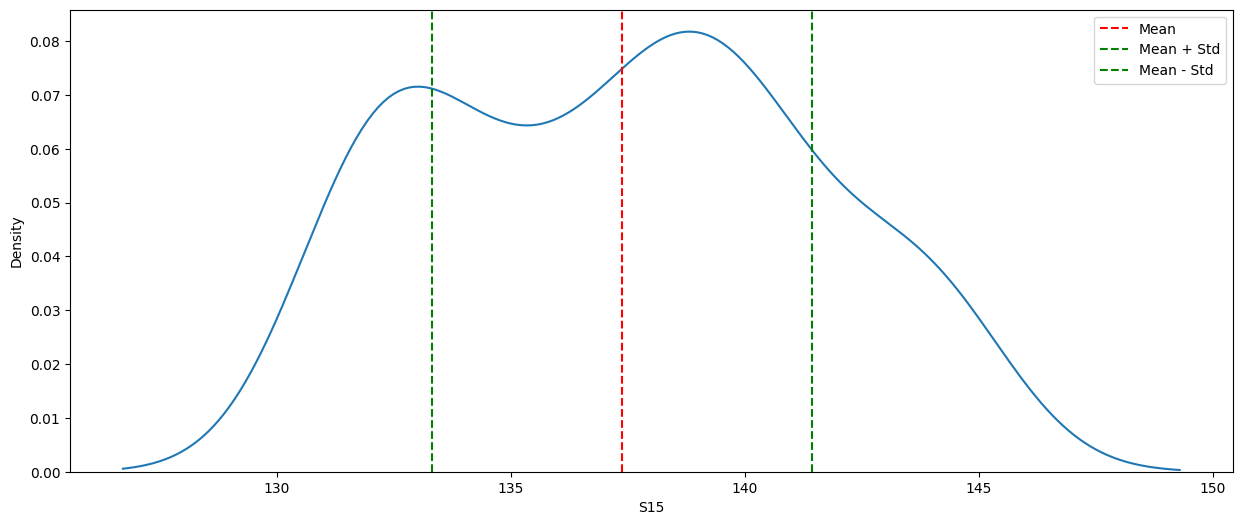

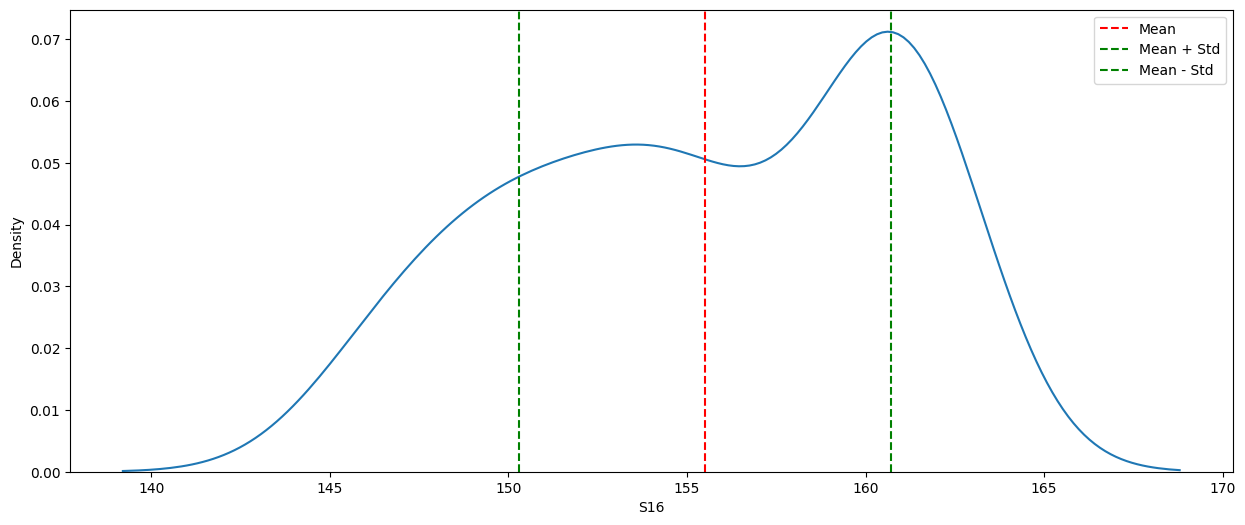

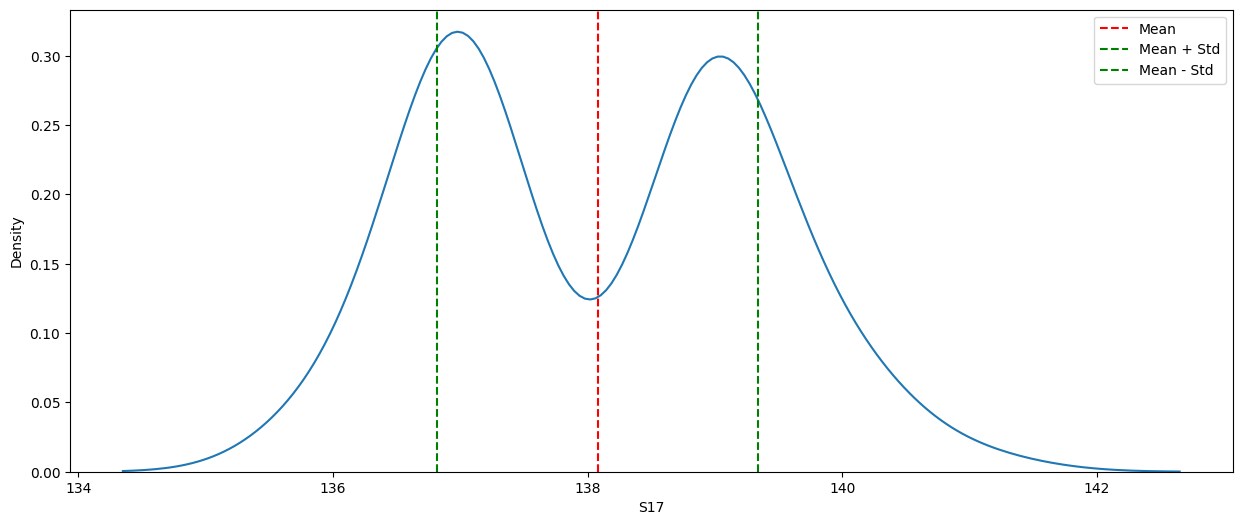

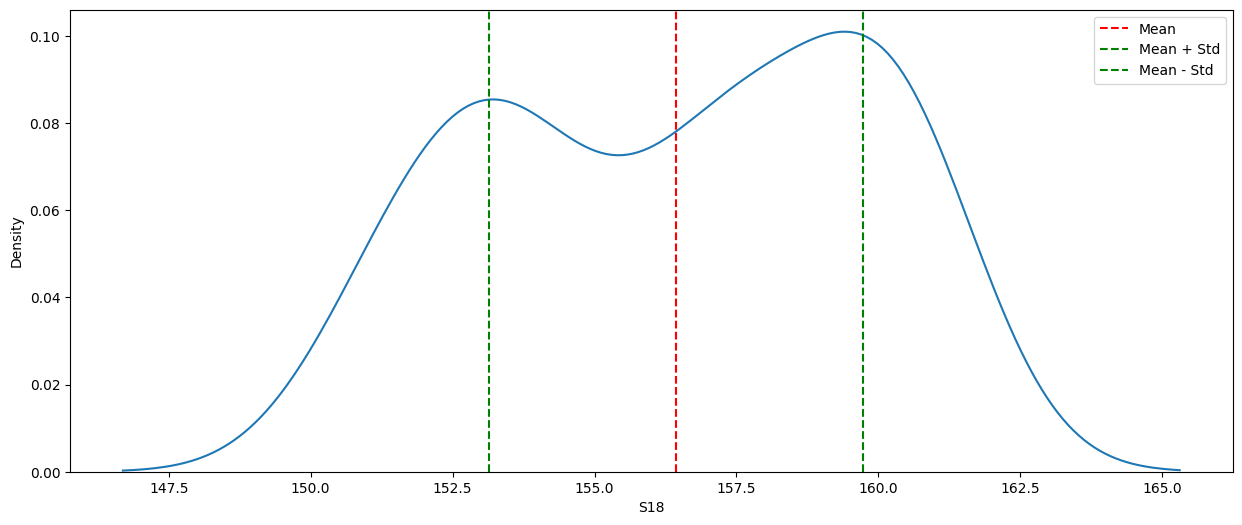

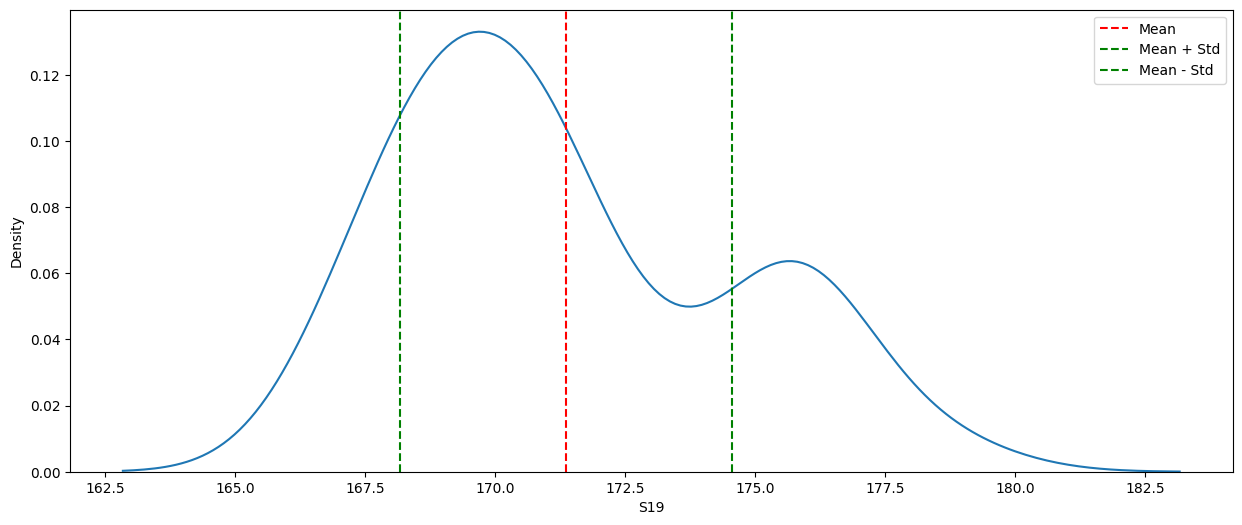

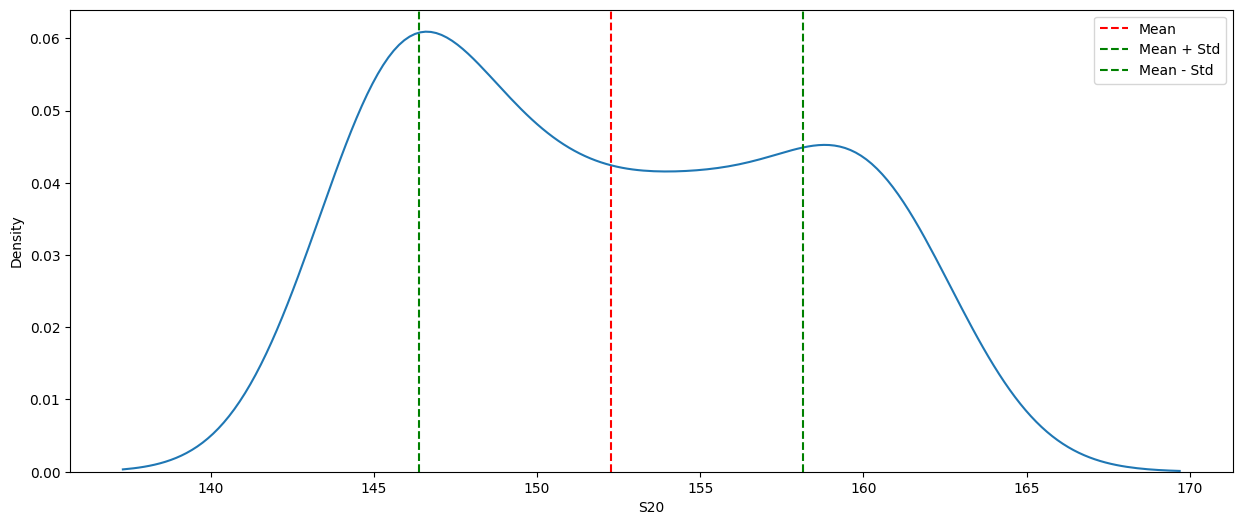

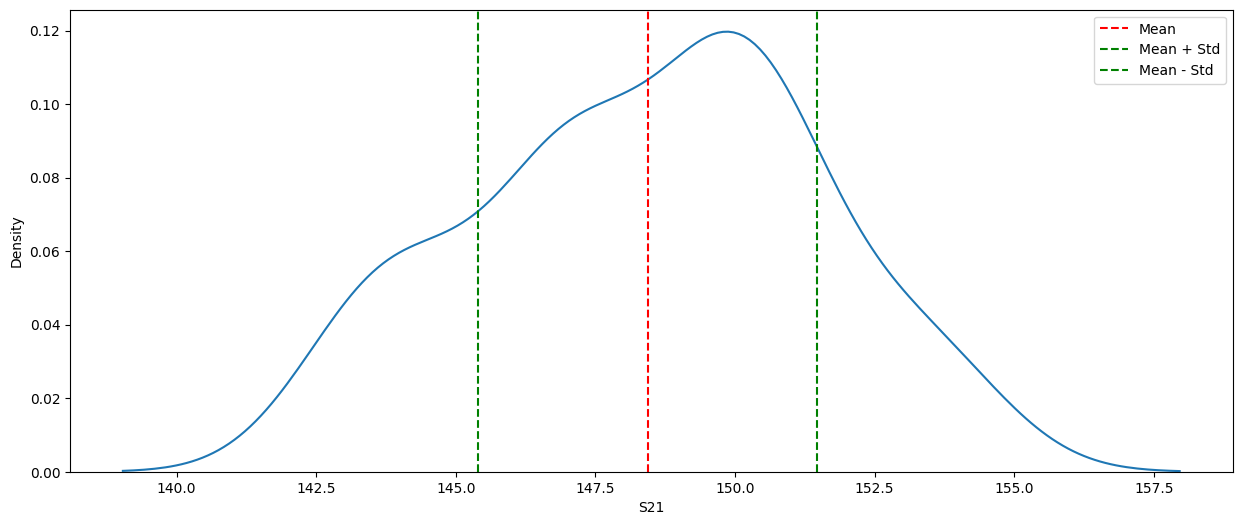

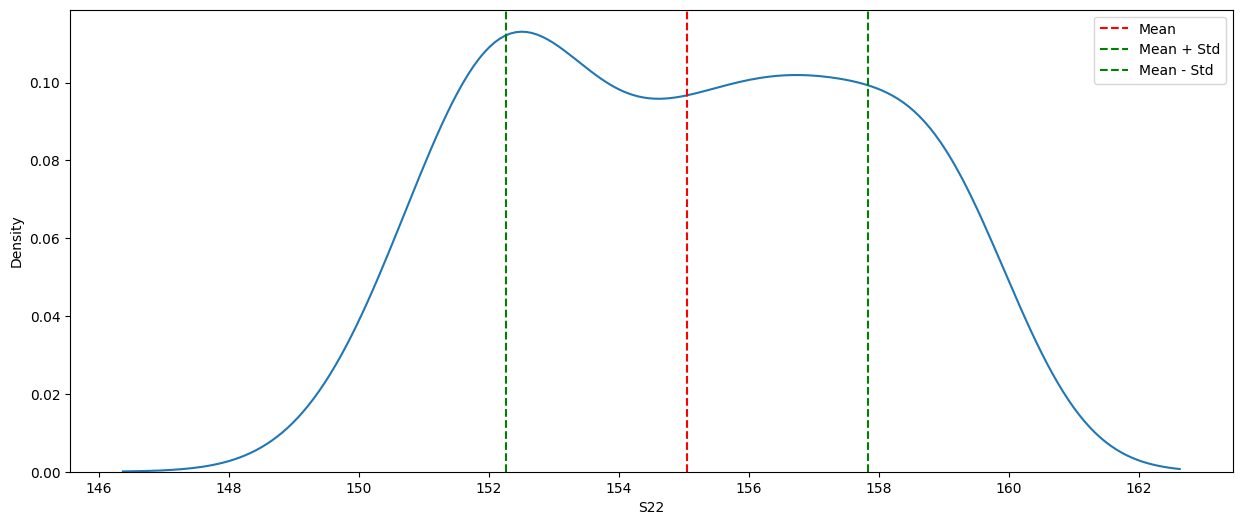

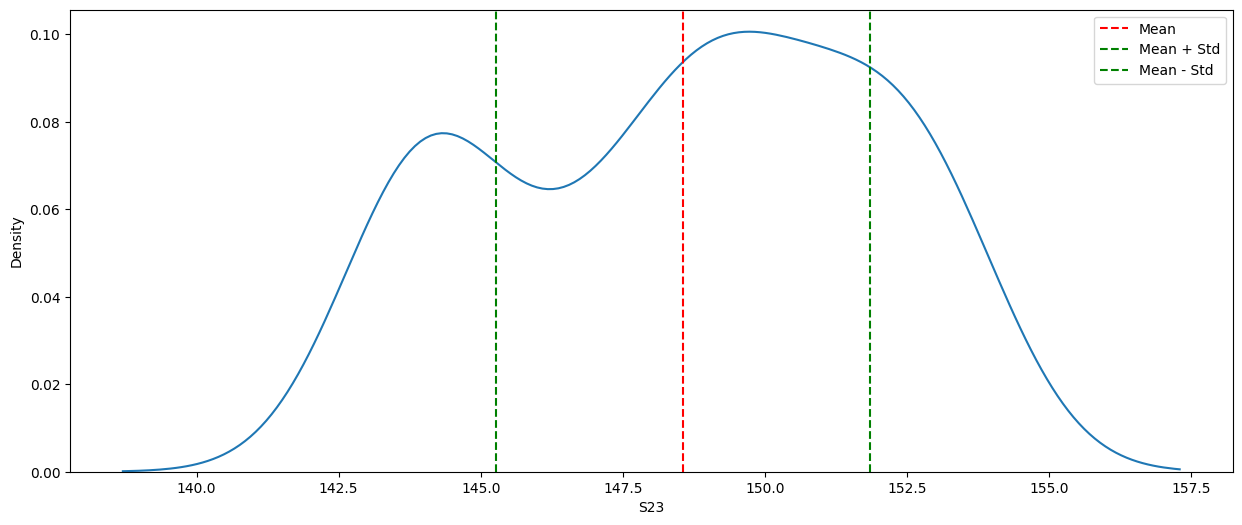

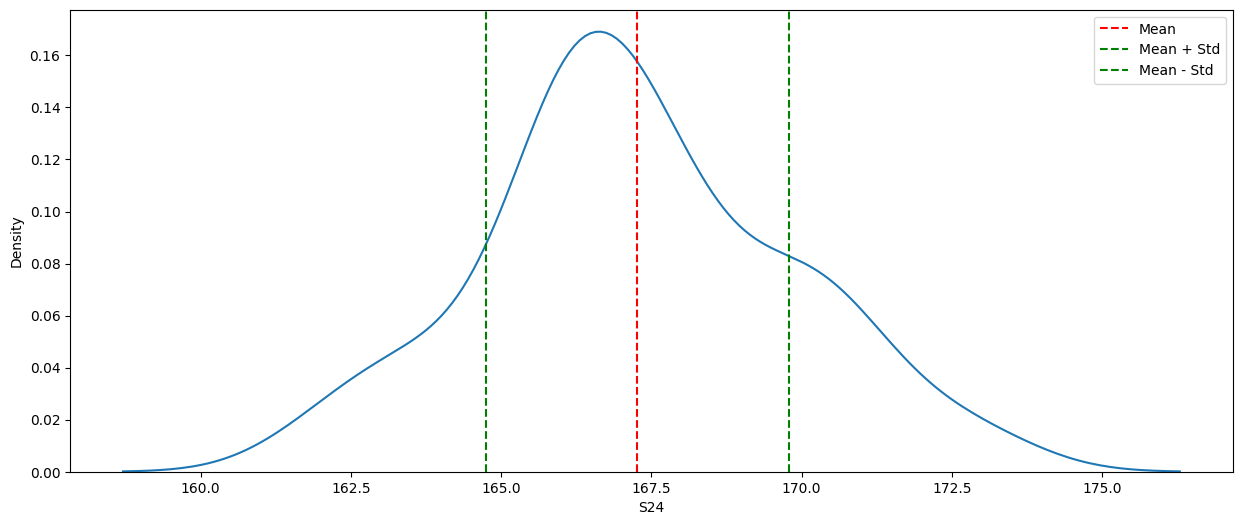

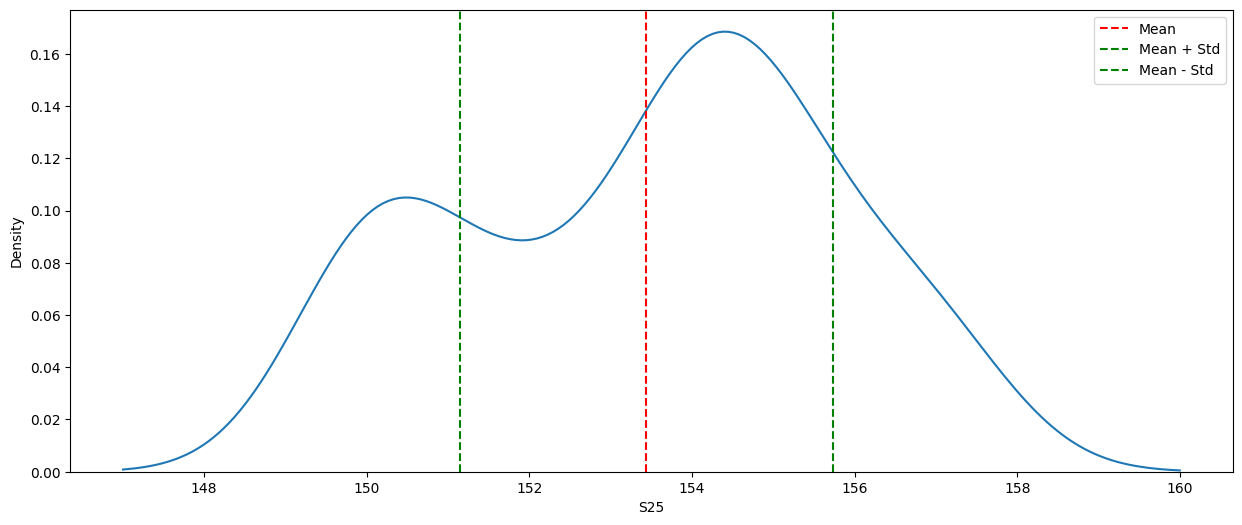

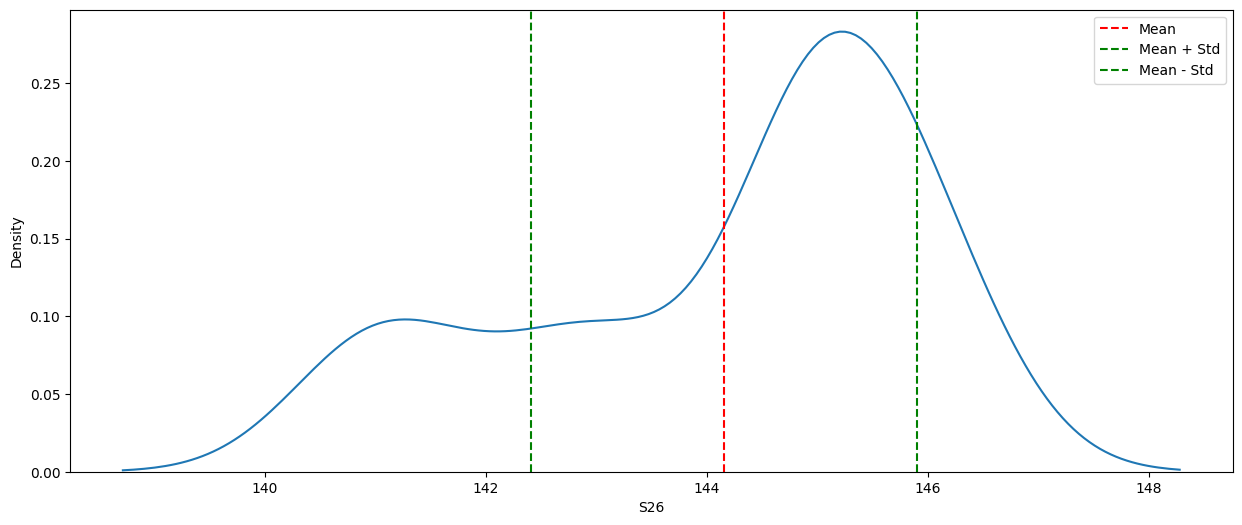

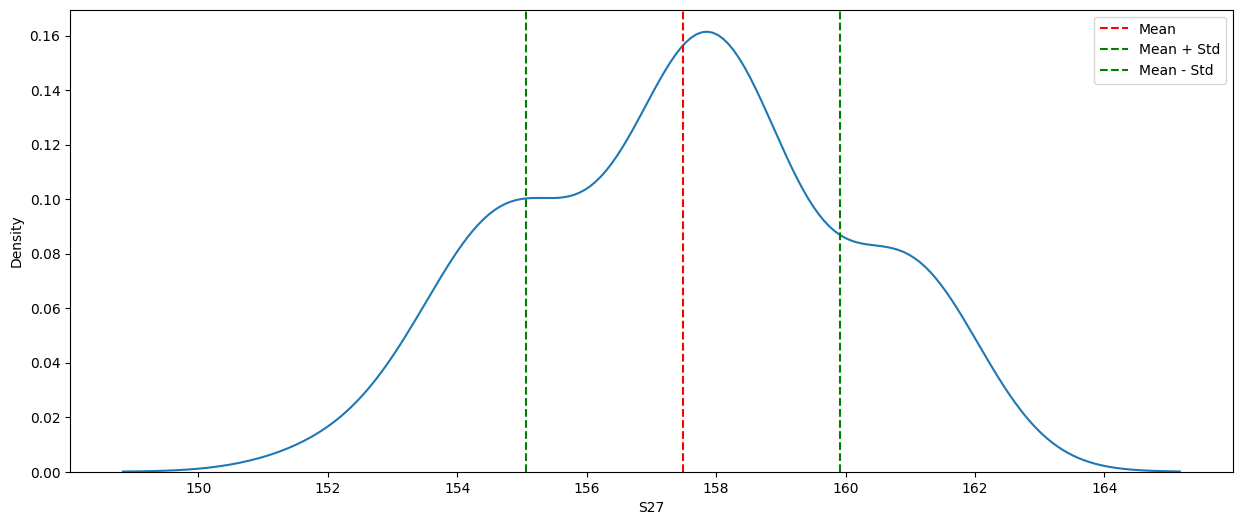

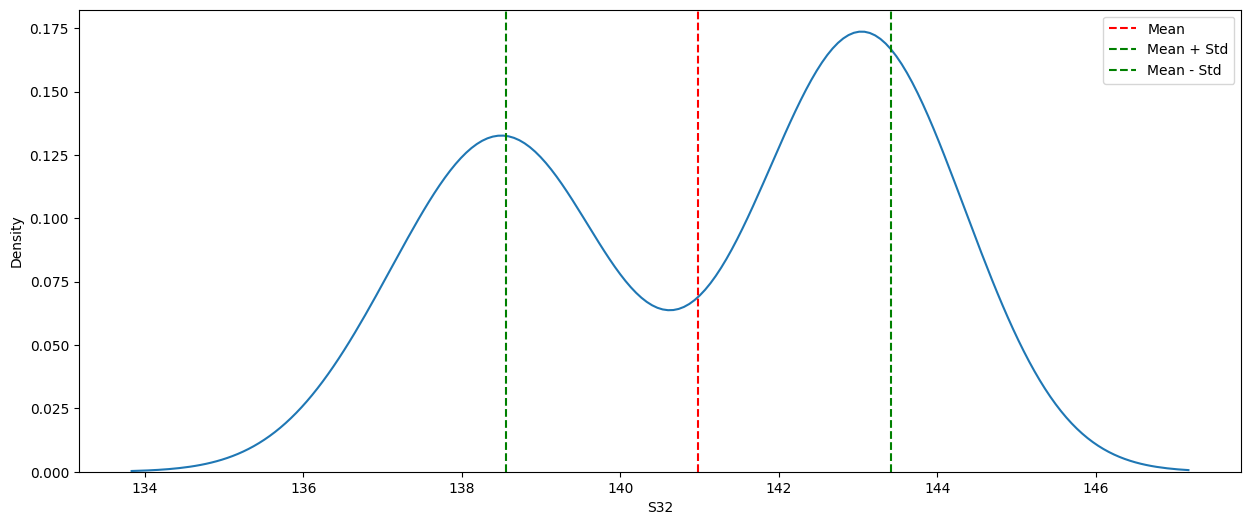

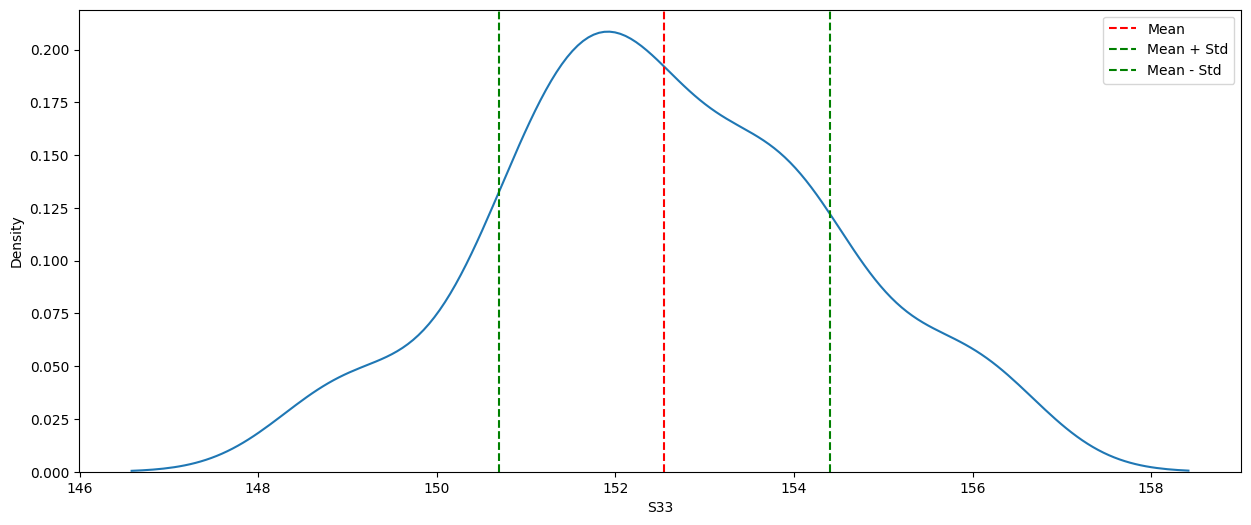

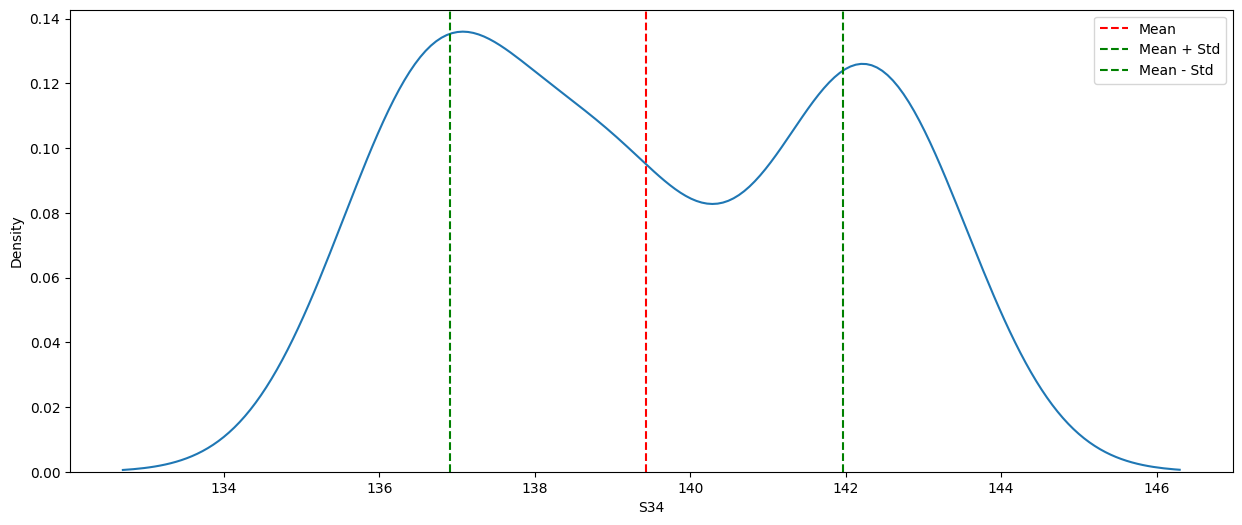

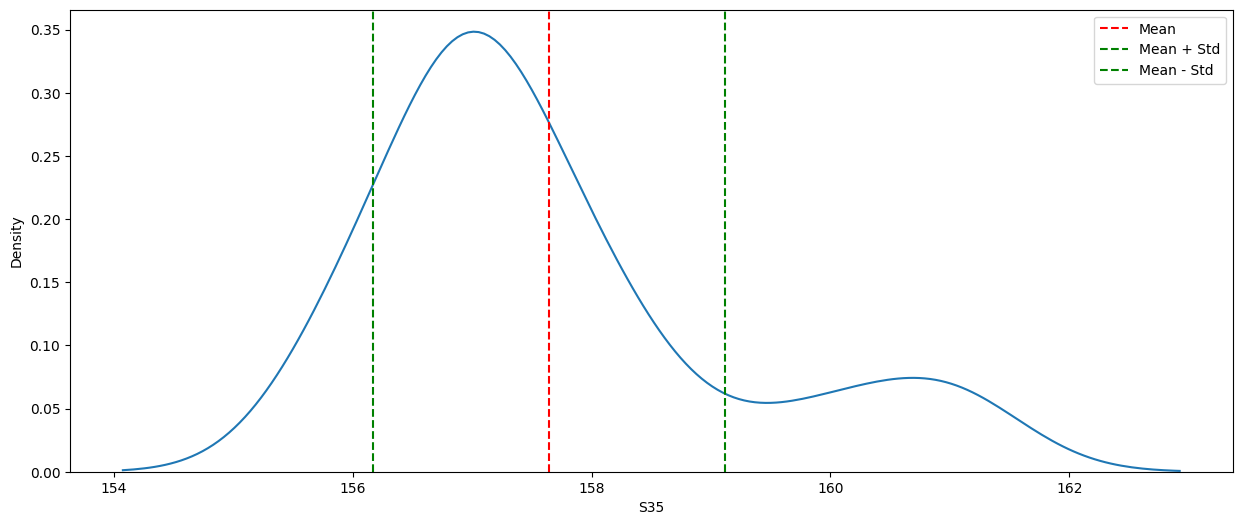

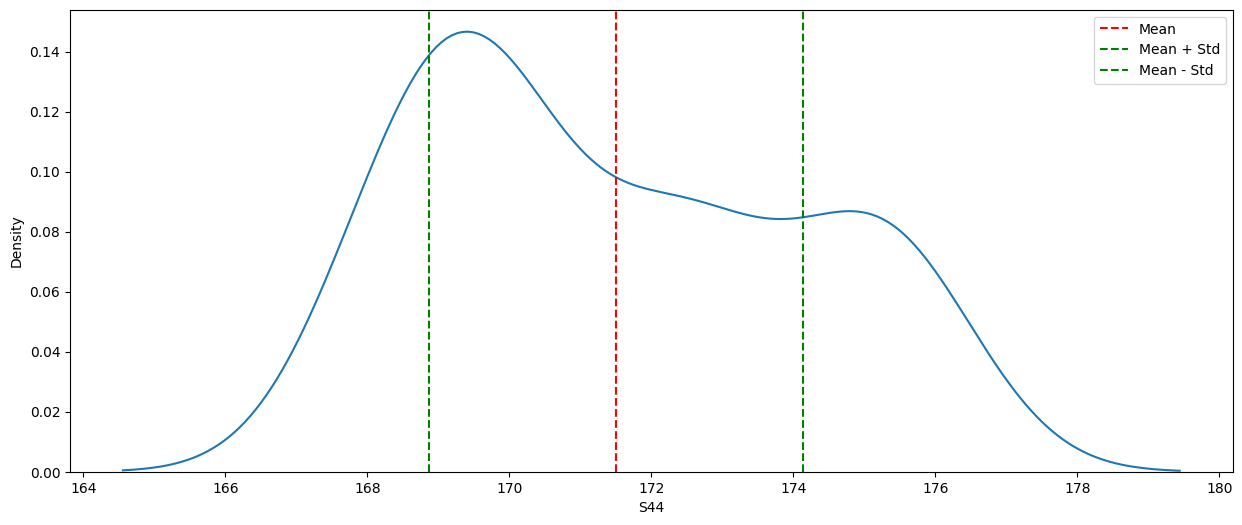

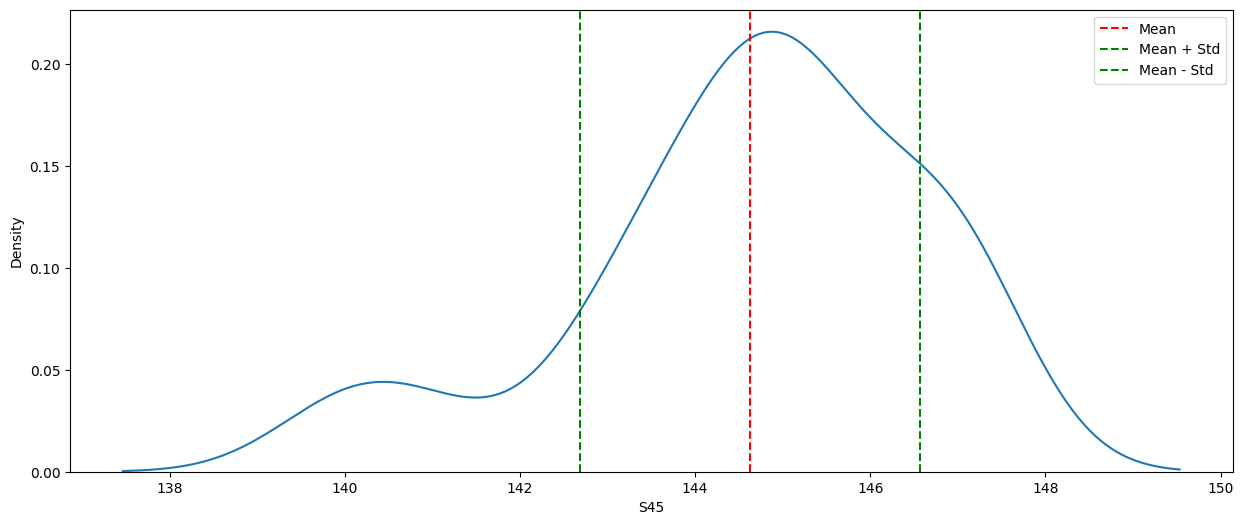

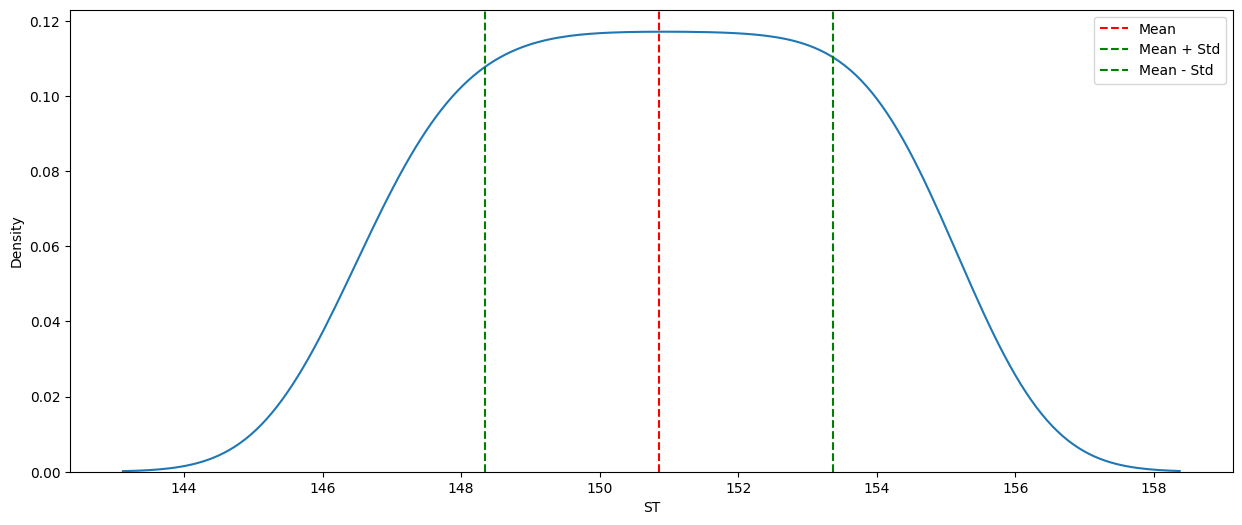

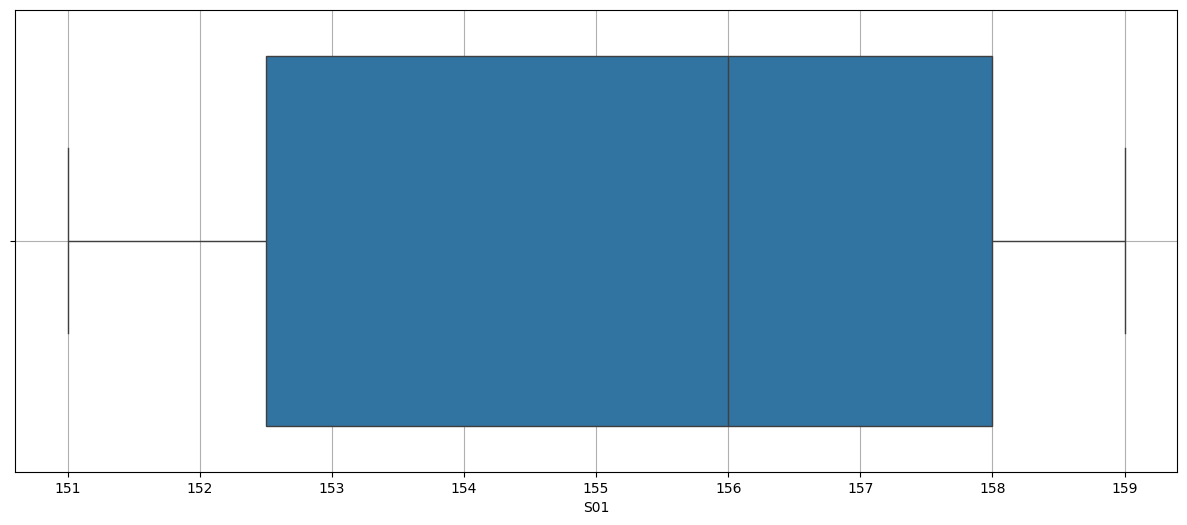

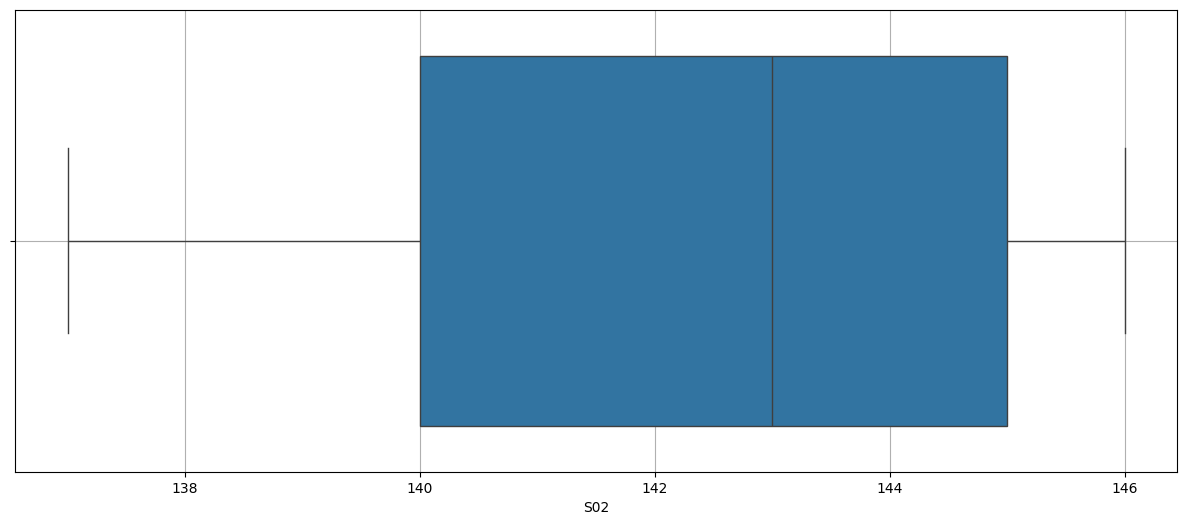

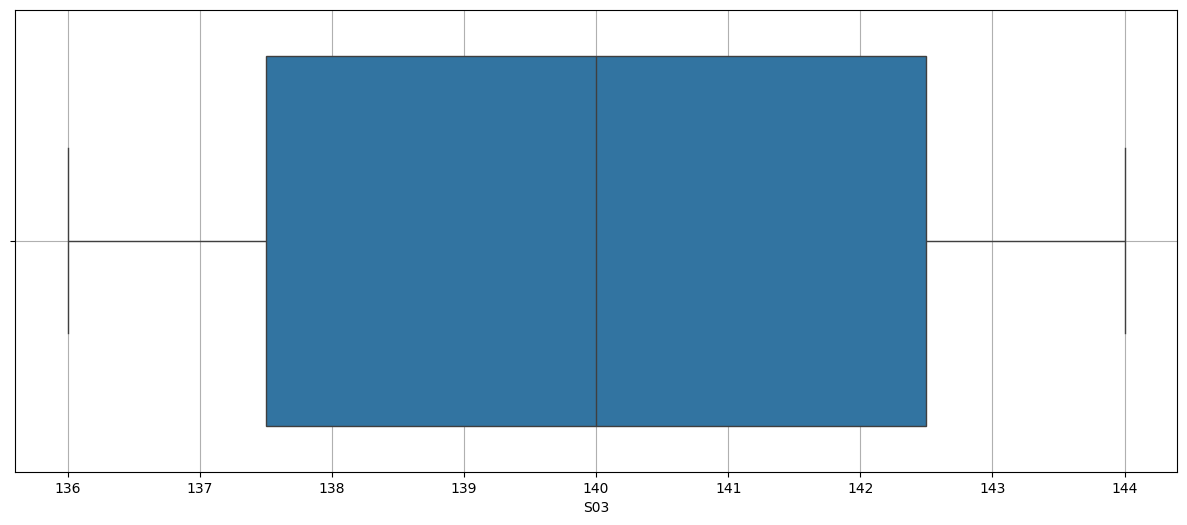

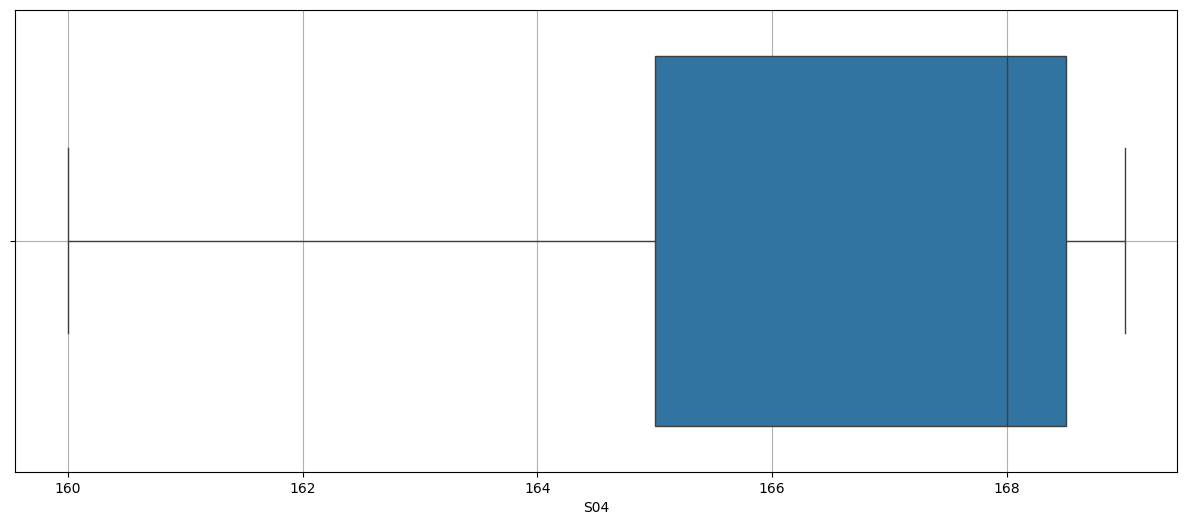

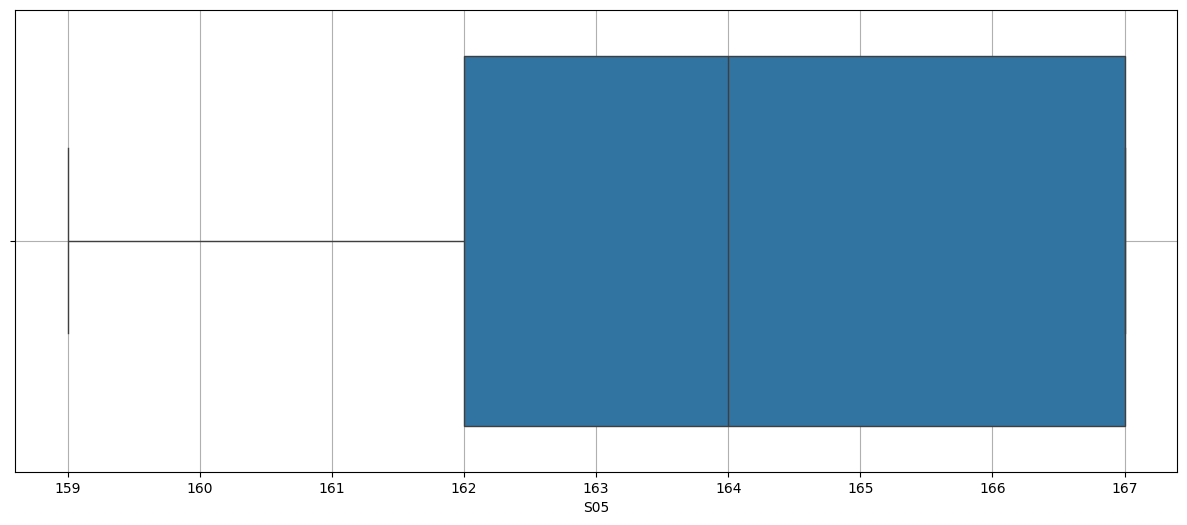

for i in df.select_dtypes(include="number").columns:

plt.figure(figsize=(15,6))

sns.kdeplot(data=df,x=i)

plt.grid()

plt.show()

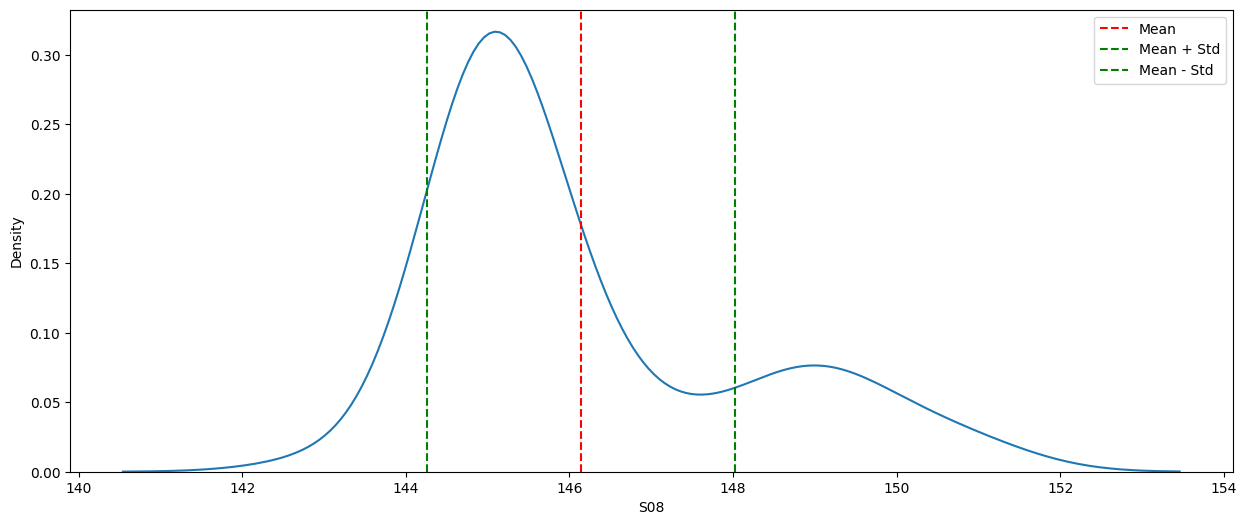

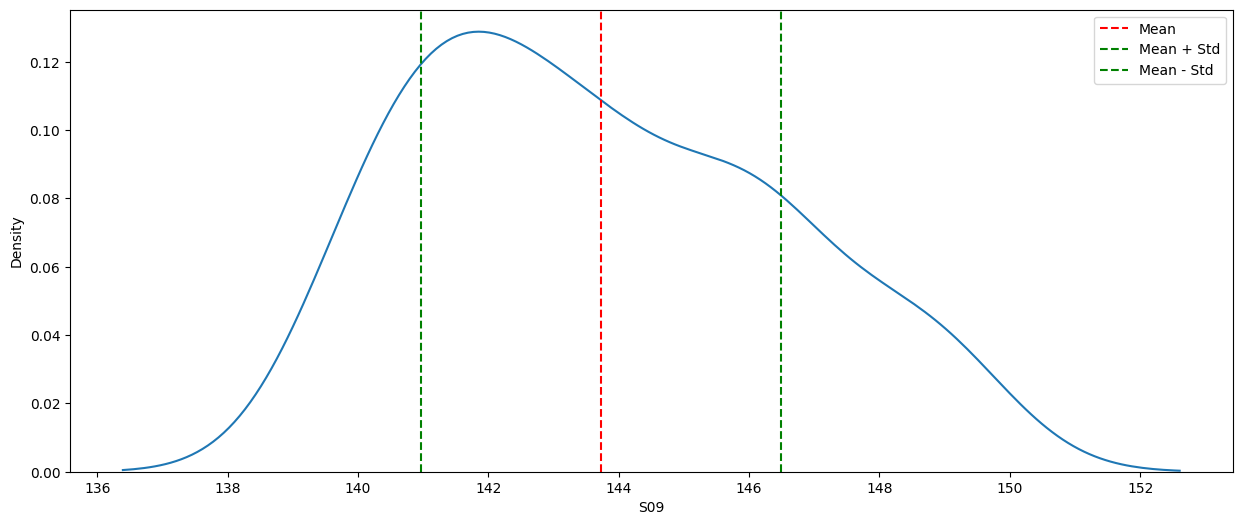

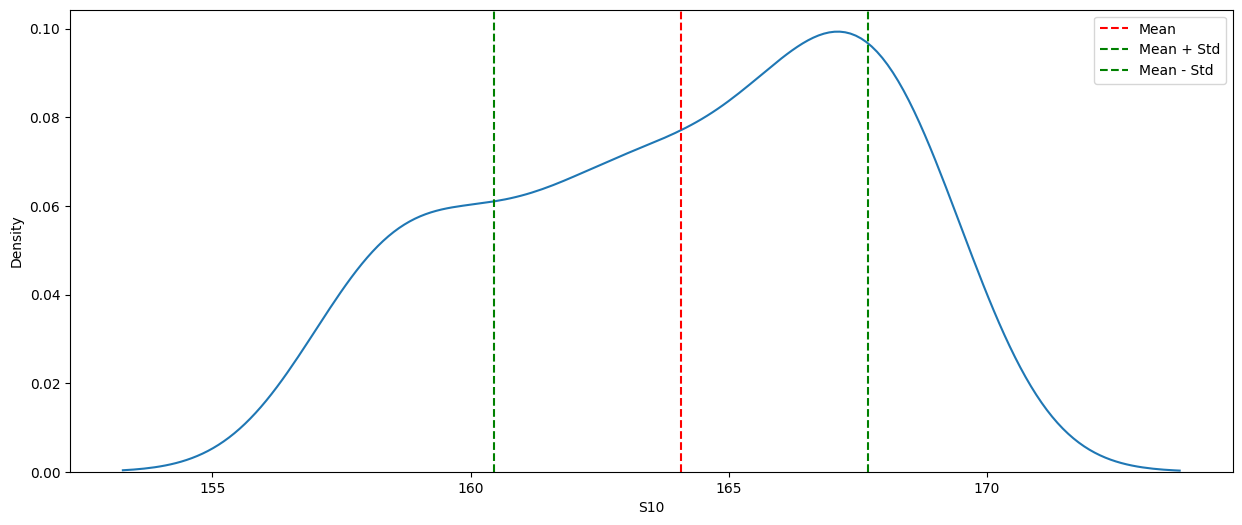

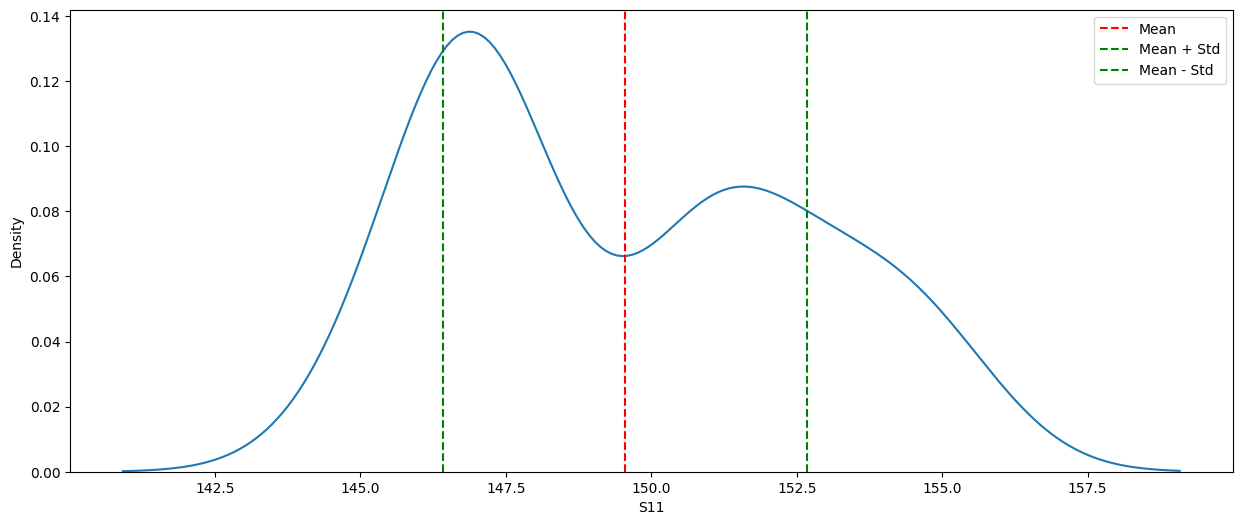

#Liet ke cac so theo mật độ = số lần xuất hiện thay đổi

# lệch phải : 08 --> hầu như không có lần nào thay đổi sau 35 lần gần nhất thống kê.

#Để vẽ đồ thị mật độ (density plot) kèm theo độ lệch chuẩn (standard deviation),

#bạn có thể sử dụng thư viện seaborn và matplotlib trong Python. Dưới đây là một ví dụ về cách thực hiện điều này:

# Trong đoạn mã trên, chúng ta sử dụng vòng lặp để duyệt qua từng cột là kiểu dữ liệu số trong dataframe (df).

#Sau đó, chúng ta vẽ đồ thị mật độ bằng hàm kdeplot từ thư viện seaborn.

#Để xác định độ lệch chuẩn, chúng ta sử dụng hàm mean() để tính giá trị trung bình và hàm std()

#để tính độ lệch chuẩn của cột tương ứng. Cuối cùng, chúng ta sử dụng hàm axvline() từ matplotlib

#để vẽ các đường dọc đại diện cho giá trị trung bình và độ lệch chuẩn.

# Lưu ý rằng đoạn mã trên giả định rằng dữ liệu trong dataframe của bạn đã được đọc và xử lý đúng cách trước đó.

import seaborn as sns

import matplotlib.pyplot as plt

# Vẽ đồ thị mật độ kèm theo độ lệch chuẩn

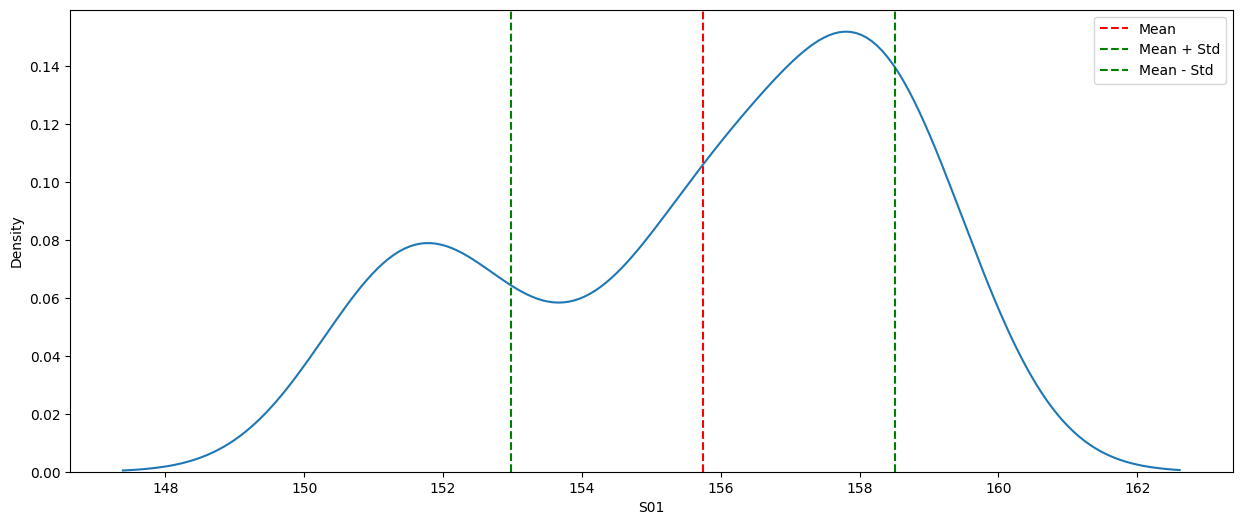

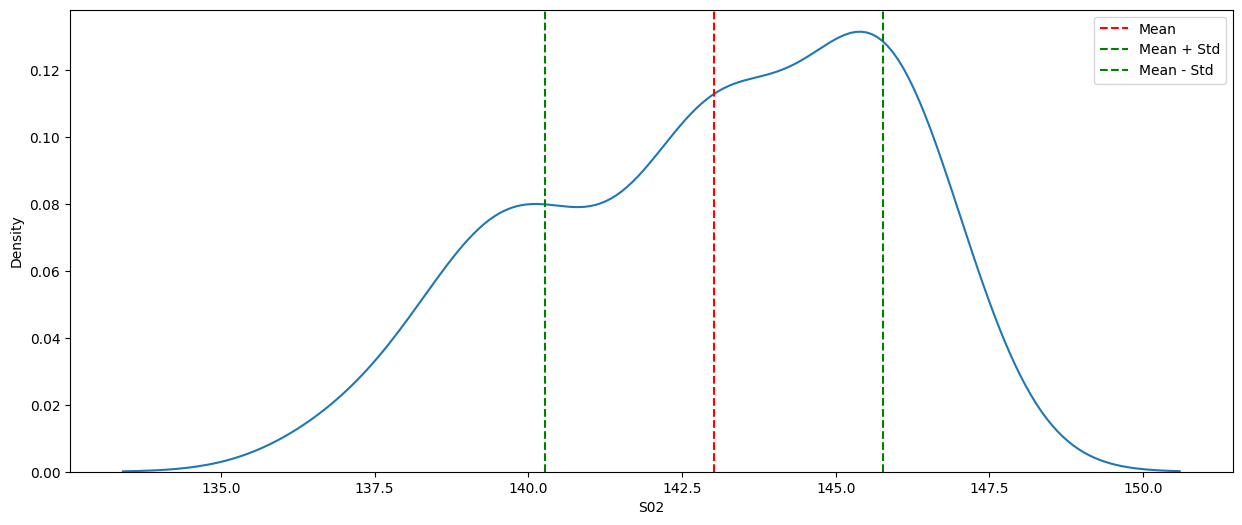

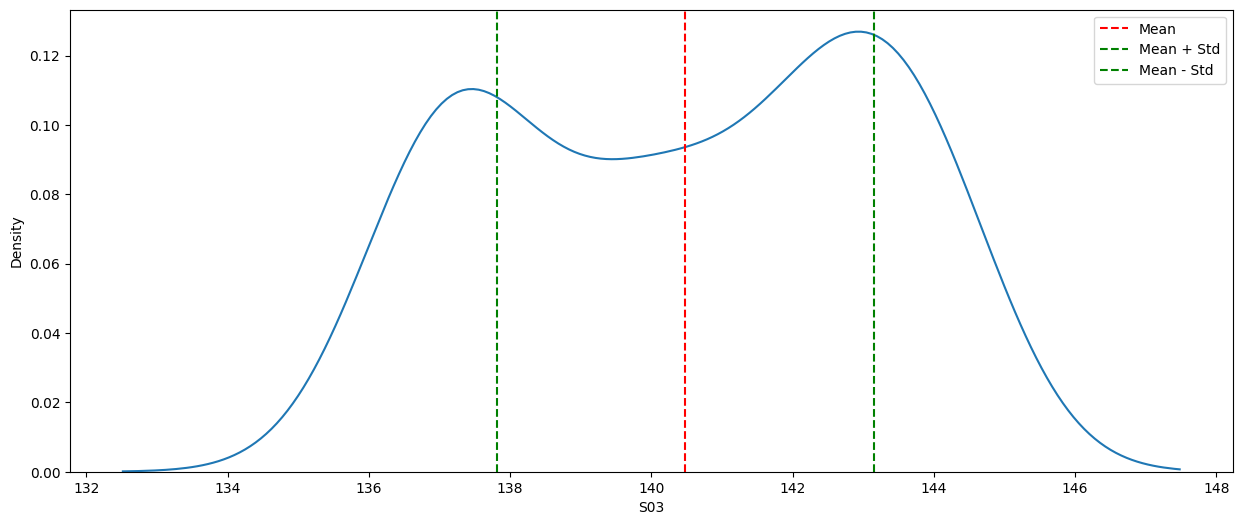

for col in df.select_dtypes(include="number").columns:

plt.figure(figsize=(15, 6))

sns.kdeplot(data=df, x=col)

mean = df[col].mean()

std = df[col].std()

plt.axvline(x=mean, color='r', linestyle='--', label='Mean')

plt.axvline(x=mean + std, color='g', linestyle='--', label='Mean + Std')

plt.axvline(x=mean - std, color='g', linestyle='--', label='Mean - Std')

plt.legend()

plt.show

# Các tình huống trên biểu đồ và các legend được sử dụng để biểu thị giá trị trung bình và độ lệch chuẩn của dữ liệu trong cột tương ứng.

# Legend "Mean" (giá trị trung bình): Đường dọc đại diện cho giá trị trung bình của dữ liệu trong cột.

# Nó giúp xác định giá trị trung bình của phân phối dữ liệu trên biểu đồ.

# Legend "Mean + Std" (giá trị trung bình + độ lệch chuẩn): Đường dọc đại diện cho giá trị trung bình cộng với độ lệch chuẩn của dữ liệu.

# Nó cho thấy phạm vi mà khoảng 68% dữ liệu nằm trong đó (khi giả định dữ liệu tuân theo phân phối chuẩn).

# Legend "Mean - Std" (giá trị trung bình - độ lệch chuẩn): Đường dọc đại diện cho giá trị trung bình trừ đi độ lệch chuẩn của dữ liệu.

# Nó cũng cho thấy phạm vi mà khoảng 68% dữ liệu nằm trong đó (khi giả định dữ liệu tuân theo phân phối chuẩn).

NHẬN XÉT:

df = pd.read_csv(r"C:\Python311\workspaces\m6B45.csv")

pd.set_option("display.max_rows",df.shape[0]+1)

pd.set_option("display.max_columns",60)

df.dataframe tbody tr th {

vertical-align: top;

}

.dataframe thead th {

text-align: right;

}

| Date | S01 | S02 | S03 | S04 | S05 | S06 | S07 | S08 | S09 | S10 | S11 | S12 | S13 | S14 | S15 | S16 | S17 | S18 | S19 | S20 | S21 | S22 | S23 | S24 | S25 | S26 | S27 | S28 | S29 | S30 | S31 | S32 | S33 | S34 | S35 | S36 | S37 | S38 | S39 | S40 | S41 | S42 | S43 | S44 | S45 | ST | Link | Type | BD | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 24/9/2023 | 151 | 137 | 136 | 160 | 159 | 158 | 157 | 143 | 140 | 158 | 145 | 138 | 151 | 132 | 132 | 146 | 136 | 151 | 167 | 145 | 143 | 150 | 143 | 162 | 150 | 141 | 152 | 148 | 139 | 161 | 144 | 137 | 149 | 136 | 156 | 135 | 162 | 132 | 136 | 144 | 149 | 132 | 137 | 168 | 140 | 146.400000 | https://vietlott/vn/vi/choi/mega-6-45/thong-ke... | M6B45 | 18/07/2016 |

| 1 | 27/9/2023 | 151 | 137 | 137 | 161 | 159 | 158 | 157 | 144 | 140 | 158 | 145 | 139 | 151 | 132 | 132 | 146 | 136 | 151 | 167 | 145 | 143 | 151 | 144 | 162 | 150 | 141 | 153 | 148 | 139 | 163 | 144 | 137 | 149 | 136 | 156 | 136 | 163 | 132 | 137 | 144 | 149 | 132 | 137 | 168 | 140 | 146.670000 | NaN | NaN | NaN |

| 2 | 29/9/2023 | 151 | 138 | 137 | 161 | 159 | 158 | 157 | 145 | 140 | 158 | 145 | 139 | 151 | 132 | 132 | 146 | 136 | 151 | 167 | 145 | 143 | 151 | 144 | 163 | 150 | 141 | 154 | 148 | 139 | 164 | 144 | 137 | 149 | 136 | 156 | 136 | 163 | 132 | 137 | 144 | 149 | 132 | 138 | 168 | 140 | 146.800000 | NaN | NaN | NaN |

| 3 | 1/10/2023 | 151 | 139 | 137 | 161 | 159 | 158 | 157 | 145 | 140 | 158 | 146 | 139 | 152 | 132 | 132 | 147 | 136 | 151 | 167 | 145 | 143 | 151 | 144 | 163 | 150 | 141 | 154 | 148 | 139 | 164 | 144 | 137 | 149 | 136 | 156 | 136 | 163 | 132 | 137 | 144 | 150 | 132 | 139 | 168 | 140 | 146.930000 | NaN | NaN | NaN |

| 4 | 4/10/2023 | 151 | 139 | 137 | 161 | 159 | 158 | 158 | 145 | 140 | 158 | 146 | 139 | 152 | 132 | 132 | 147 | 137 | 151 | 167 | 145 | 144 | 151 | 144 | 163 | 150 | 141 | 154 | 148 | 139 | 164 | 144 | 138 | 149 | 136 | 156 | 136 | 163 | 132 | 137 | 145 | 150 | 132 | 139 | 168 | 141 | 147.070000 | NaN | NaN | NaN |

| 5 | 6/10/2023 | 151 | 139 | 137 | 161 | 159 | 158 | 158 | 145 | 140 | 158 | 146 | 139 | 152 | 132 | 132 | 147 | 137 | 152 | 168 | 145 | 144 | 151 | 144 | 164 | 150 | 141 | 154 | 149 | 139 | 164 | 144 | 138 | 150 | 136 | 156 | 136 | 163 | 132 | 137 | 146 | 150 | 132 | 139 | 168 | 141 | 147.200000 | NaN | NaN | NaN |

| 6 | 8/10/2023 | 151 | 139 | 137 | 162 | 159 | 158 | 158 | 145 | 140 | 158 | 146 | 139 | 152 | 132 | 132 | 148 | 137 | 152 | 168 | 145 | 144 | 152 | 144 | 164 | 150 | 141 | 154 | 150 | 139 | 164 | 144 | 138 | 151 | 136 | 156 | 136 | 163 | 132 | 138 | 146 | 150 | 132 | 139 | 168 | 141 | 147.330000 | NaN | NaN | NaN |

| 7 | 13/10/2023 | 152 | 139 | 137 | 162 | 160 | 158 | 158 | 145 | 140 | 159 | 147 | 139 | 152 | 132 | 132 | 149 | 137 | 152 | 168 | 145 | 144 | 152 | 144 | 164 | 150 | 141 | 154 | 150 | 139 | 165 | 144 | 138 | 151 | 136 | 156 | 136 | 163 | 132 | 139 | 148 | 150 | 132 | 139 | 169 | 143 | 147.600000 | NaN | NaN | NaN |

| 8 | 15/10/2023 | 152 | 139 | 137 | 163 | 161 | 158 | 158 | 145 | 141 | 159 | 147 | 139 | 152 | 132 | 132 | 149 | 137 | 152 | 168 | 145 | 144 | 152 | 144 | 164 | 150 | 141 | 155 | 150 | 139 | 165 | 144 | 138 | 151 | 137 | 156 | 136 | 163 | 132 | 140 | 148 | 150 | 132 | 139 | 169 | 143 | 147.730000 | NaN | NaN | NaN |

| 9 | 18/10/2023 | 152 | 140 | 137 | 163 | 161 | 158 | 159 | 145 | 141 | 159 | 147 | 139 | 152 | 132 | 132 | 149 | 137 | 153 | 168 | 146 | 144 | 152 | 144 | 165 | 150 | 141 | 155 | 150 | 140 | 165 | 144 | 138 | 151 | 137 | 156 | 136 | 163 | 132 | 140 | 148 | 150 | 132 | 139 | 169 | 143 | 147.870000 | NaN | NaN | NaN |

| 10 | 20/10/2023 | 152 | 140 | 137 | 164 | 161 | 158 | 159 | 145 | 141 | 159 | 147 | 139 | 152 | 132 | 132 | 150 | 137 | 153 | 168 | 146 | 145 | 152 | 144 | 166 | 150 | 142 | 155 | 150 | 140 | 165 | 144 | 138 | 151 | 137 | 156 | 136 | 164 | 132 | 140 | 148 | 150 | 132 | 139 | 169 | 143 | 148.000000 | NaN | NaN | NaN |

| 11 | 22/10/2023 | 152 | 140 | 137 | 164 | 161 | 158 | 159 | 145 | 141 | 160 | 147 | 139 | 153 | 133 | 132 | 150 | 137 | 153 | 169 | 146 | 145 | 152 | 144 | 166 | 150 | 142 | 155 | 150 | 140 | 165 | 144 | 138 | 151 | 137 | 157 | 136 | 164 | 132 | 140 | 149 | 150 | 132 | 139 | 169 | 143 | 148.130000 | NaN | NaN | NaN |

| 12 | 25/10/2023 | 152 | 140 | 137 | 165 | 161 | 159 | 159 | 145 | 141 | 160 | 147 | 139 | 154 | 133 | 132 | 150 | 137 | 153 | 169 | 146 | 145 | 152 | 144 | 166 | 151 | 142 | 155 | 150 | 140 | 165 | 145 | 138 | 151 | 137 | 157 | 136 | 164 | 132 | 140 | 149 | 151 | 132 | 139 | 169 | 143 | 148.270000 | NaN | NaN | NaN |

| 13 | 27/10/2023 | 152 | 140 | 137 | 165 | 161 | 159 | 160 | 145 | 141 | 161 | 147 | 139 | 154 | 134 | 132 | 150 | 137 | 153 | 169 | 146 | 146 | 152 | 144 | 166 | 151 | 143 | 155 | 150 | 140 | 165 | 145 | 138 | 151 | 137 | 157 | 136 | 165 | 132 | 140 | 149 | 151 | 132 | 139 | 169 | 143 | 148.400000 | NaN | NaN | NaN |

| 14 | 29/10/2023 | 152 | 140 | 137 | 165 | 162 | 159 | 161 | 145 | 141 | 161 | 147 | 139 | 154 | 134 | 133 | 150 | 137 | 153 | 169 | 146 | 147 | 152 | 144 | 166 | 151 | 143 | 155 | 150 | 140 | 165 | 145 | 139 | 151 | 137 | 157 | 136 | 165 | 132 | 140 | 149 | 151 | 132 | 139 | 169 | 144 | 148.530000 | NaN | NaN | NaN |

| 15 | 1/11/2023 | 153 | 140 | 138 | 165 | 162 | 159 | 161 | 145 | 141 | 161 | 147 | 139 | 154 | 134 | 134 | 151 | 137 | 153 | 169 | 146 | 147 | 152 | 145 | 166 | 151 | 143 | 155 | 151 | 140 | 165 | 145 | 139 | 151 | 137 | 157 | 136 | 165 | 132 | 140 | 149 | 151 | 132 | 139 | 169 | 144 | 148.670000 | NaN | NaN | NaN |

| 16 | 3/11/2023 | 153 | 141 | 138 | 165 | 162 | 159 | 162 | 145 | 142 | 161 | 147 | 139 | 155 | 134 | 134 | 151 | 137 | 153 | 169 | 146 | 147 | 153 | 145 | 166 | 151 | 143 | 155 | 151 | 140 | 165 | 145 | 139 | 151 | 137 | 157 | 136 | 165 | 133 | 140 | 149 | 151 | 132 | 139 | 169 | 144 | 148.800000 | NaN | NaN | NaN |

| 17 | 5/11/2023 | 154 | 141 | 138 | 165 | 162 | 159 | 162 | 145 | 142 | 161 | 147 | 139 | 156 | 134 | 134 | 152 | 137 | 154 | 169 | 146 | 147 | 153 | 146 | 166 | 152 | 143 | 155 | 151 | 140 | 165 | 145 | 139 | 151 | 137 | 157 | 136 | 165 | 133 | 140 | 149 | 151 | 132 | 139 | 169 | 144 | 148.933333 | NaN | NaN | NaN |

| 18 | 8/11/2023 | 154 | 141 | 138 | 165 | 162 | 159 | 163 | 145 | 142 | 161 | 147 | 139 | 156 | 134 | 134 | 152 | 137 | 154 | 169 | 147 | 147 | 153 | 147 | 166 | 152 | 143 | 156 | 151 | 140 | 165 | 146 | 139 | 152 | 137 | 157 | 136 | 165 | 133 | 140 | 149 | 151 | 132 | 139 | 169 | 144 | 149.070000 | NaN | NaN | NaN |

| 19 | 10/11/2023 | 155 | 141 | 138 | 166 | 162 | 159 | 163 | 145 | 142 | 162 | 147 | 139 | 157 | 135 | 134 | 152 | 137 | 154 | 169 | 147 | 147 | 153 | 147 | 166 | 152 | 143 | 156 | 151 | 140 | 165 | 146 | 139 | 152 | 137 | 157 | 136 | 165 | 133 | 140 | 149 | 151 | 132 | 139 | 170 | 144 | 149.200000 | NaN | NaN | NaN |

| 20 | 12/11/2023 | 155 | 142 | 138 | 167 | 162 | 159 | 163 | 145 | 142 | 163 | 147 | 139 | 157 | 135 | 135 | 152 | 137 | 154 | 169 | 147 | 147 | 153 | 147 | 166 | 152 | 143 | 157 | 151 | 140 | 165 | 147 | 139 | 152 | 137 | 157 | 136 | 165 | 133 | 140 | 149 | 151 | 132 | 139 | 170 | 144 | 149.330000 | NaN | NaN | NaN |

| 21 | 15/11/2023 | 155 | 143 | 139 | 167 | 162 | 159 | 163 | 145 | 142 | 163 | 147 | 140 | 157 | 135 | 135 | 153 | 137 | 154 | 169 | 147 | 147 | 153 | 147 | 166 | 152 | 143 | 157 | 151 | 140 | 166 | 147 | 139 | 152 | 137 | 157 | 136 | 166 | 133 | 140 | 149 | 151 | 132 | 139 | 170 | 144 | 149.466667 | NaN | NaN | NaN |

| 22 | 17/11/2023 | 155 | 143 | 139 | 167 | 162 | 159 | 163 | 145 | 142 | 163 | 147 | 140 | 157 | 135 | 135 | 154 | 137 | 154 | 169 | 148 | 147 | 153 | 147 | 166 | 153 | 144 | 157 | 151 | 140 | 166 | 147 | 139 | 152 | 137 | 157 | 137 | 166 | 133 | 140 | 149 | 152 | 132 | 139 | 170 | 144 | 149.600000 | NaN | NaN | NaN |

| 23 | 19/11/2023 | 156 | 143 | 140 | 167 | 162 | 159 | 163 | 145 | 142 | 163 | 147 | 140 | 157 | 135 | 135 | 154 | 137 | 154 | 170 | 149 | 147 | 153 | 147 | 166 | 153 | 145 | 157 | 151 | 140 | 166 | 147 | 139 | 152 | 138 | 157 | 137 | 166 | 133 | 140 | 149 | 152 | 132 | 139 | 170 | 144 | 149.733333 | NaN | NaN | NaN |

| 24 | 22/11/2023 | 156 | 143 | 140 | 167 | 162 | 159 | 163 | 145 | 142 | 163 | 147 | 140 | 157 | 135 | 136 | 154 | 137 | 155 | 170 | 150 | 147 | 153 | 148 | 166 | 153 | 145 | 157 | 151 | 140 | 166 | 147 | 139 | 152 | 138 | 157 | 137 | 167 | 133 | 141 | 149 | 152 | 132 | 139 | 170 | 144 | 149.866667 | NaN | NaN | NaN |

| 25 | 24/11/2023 | 156 | 143 | 140 | 167 | 163 | 159 | 163 | 145 | 142 | 163 | 147 | 140 | 157 | 135 | 136 | 154 | 137 | 156 | 170 | 150 | 147 | 154 | 148 | 166 | 153 | 145 | 157 | 151 | 140 | 166 | 147 | 139 | 152 | 139 | 157 | 137 | 167 | 133 | 141 | 149 | 153 | 132 | 139 | 170 | 145 | 150.000000 | NaN | NaN | NaN |

| 26 | 26/11/2023 | 156 | 143 | 140 | 168 | 163 | 160 | 163 | 145 | 142 | 163 | 147 | 140 | 157 | 135 | 137 | 154 | 137 | 156 | 170 | 150 | 147 | 154 | 149 | 166 | 154 | 145 | 157 | 151 | 140 | 166 | 147 | 139 | 152 | 139 | 157 | 138 | 167 | 133 | 141 | 149 | 153 | 132 | 139 | 170 | 145 | 150.133333 | NaN | NaN | NaN |

| 27 | 29/11/2023 | 156 | 143 | 140 | 168 | 163 | 160 | 163 | 145 | 143 | 163 | 147 | 140 | 157 | 135 | 137 | 154 | 137 | 156 | 170 | 150 | 147 | 155 | 149 | 167 | 154 | 145 | 157 | 151 | 140 | 166 | 147 | 140 | 152 | 139 | 157 | 138 | 167 | 134 | 142 | 149 | 153 | 132 | 139 | 170 | 145 | 150.266667 | NaN | NaN | NaN |

| 28 | 1/12/2023 | 156 | 143 | 140 | 168 | 164 | 160 | 163 | 145 | 143 | 164 | 147 | 140 | 157 | 136 | 137 | 154 | 137 | 156 | 170 | 150 | 148 | 155 | 149 | 167 | 154 | 145 | 158 | 151 | 140 | 166 | 147 | 141 | 152 | 139 | 157 | 138 | 167 | 134 | 142 | 149 | 153 | 132 | 139 | 170 | 145 | 150.400000 | NaN | NaN | NaN |

| 29 | 3/12/2023 | 156 | 143 | 140 | 168 | 164 | 160 | 163 | 145 | 143 | 164 | 147 | 141 | 157 | 137 | 137 | 155 | 137 | 156 | 170 | 150 | 149 | 155 | 149 | 167 | 154 | 145 | 158 | 151 | 141 | 166 | 147 | 142 | 152 | 139 | 157 | 138 | 167 | 134 | 142 | 149 | 153 | 132 | 139 | 170 | 145 | 150.533333 | NaN | NaN | NaN |

| 30 | 6/12/2023 | 156 | 143 | 140 | 168 | 164 | 160 | 163 | 145 | 143 | 164 | 147 | 141 | 157 | 137 | 137 | 155 | 137 | 157 | 171 | 151 | 149 | 155 | 149 | 167 | 154 | 145 | 158 | 151 | 142 | 166 | 147 | 142 | 152 | 139 | 157 | 138 | 167 | 134 | 142 | 149 | 154 | 133 | 139 | 170 | 145 | 150.666667 | NaN | NaN | NaN |

| 31 | 8/12/2023 | 156 | 143 | 140 | 168 | 164 | 160 | 163 | 145 | 143 | 164 | 148 | 141 | 157 | 137 | 138 | 156 | 138 | 157 | 171 | 151 | 149 | 155 | 149 | 167 | 154 | 145 | 158 | 151 | 142 | 166 | 147 | 142 | 152 | 139 | 157 | 138 | 167 | 134 | 142 | 149 | 154 | 134 | 140 | 170 | 145 | 150.800000 | NaN | NaN | NaN |

| 32 | 10/12/2023 | 156 | 143 | 140 | 168 | 164 | 160 | 163 | 145 | 144 | 165 | 149 | 141 | 157 | 137 | 138 | 156 | 139 | 157 | 171 | 151 | 149 | 155 | 149 | 167 | 154 | 145 | 158 | 151 | 142 | 166 | 147 | 142 | 152 | 139 | 157 | 138 | 167 | 134 | 142 | 149 | 155 | 134 | 140 | 171 | 145 | 150.933333 | NaN | NaN | NaN |

| 33 | 13/12/2023 | 156 | 143 | 141 | 168 | 164 | 160 | 164 | 145 | 144 | 165 | 150 | 141 | 157 | 137 | 138 | 156 | 139 | 157 | 171 | 152 | 149 | 155 | 149 | 167 | 154 | 145 | 158 | 152 | 142 | 166 | 147 | 142 | 152 | 139 | 157 | 138 | 167 | 134 | 142 | 149 | 155 | 134 | 140 | 172 | 145 | 151.066667 | NaN | NaN | NaN |

| 34 | 15/12/2023 | 157 | 143 | 141 | 168 | 165 | 160 | 164 | 145 | 144 | 166 | 151 | 141 | 157 | 137 | 138 | 156 | 139 | 157 | 171 | 153 | 149 | 155 | 149 | 167 | 154 | 145 | 158 | 152 | 142 | 166 | 147 | 142 | 152 | 139 | 157 | 138 | 167 | 134 | 142 | 150 | 155 | 134 | 140 | 172 | 145 | 151.200000 | NaN | NaN | NaN |

| 35 | 17/12/2023 | 157 | 143 | 142 | 168 | 165 | 160 | 165 | 145 | 144 | 166 | 151 | 141 | 157 | 137 | 138 | 156 | 139 | 158 | 171 | 154 | 149 | 155 | 149 | 167 | 154 | 145 | 158 | 152 | 142 | 166 | 148 | 142 | 153 | 139 | 157 | 138 | 167 | 134 | 142 | 150 | 155 | 134 | 140 | 172 | 145 | 151.333333 | NaN | NaN | NaN |

| 36 | 20/12/2023 | 157 | 143 | 142 | 168 | 166 | 160 | 165 | 145 | 144 | 166 | 151 | 141 | 157 | 137 | 139 | 157 | 139 | 158 | 171 | 154 | 150 | 156 | 149 | 167 | 154 | 145 | 158 | 152 | 142 | 166 | 148 | 143 | 153 | 139 | 157 | 138 | 167 | 134 | 142 | 150 | 155 | 134 | 140 | 172 | 145 | 151.466667 | NaN | NaN | NaN |

| 37 | 22/12/2023 | 157 | 144 | 142 | 168 | 166 | 160 | 165 | 145 | 144 | 166 | 151 | 142 | 157 | 138 | 139 | 158 | 139 | 158 | 171 | 154 | 150 | 156 | 149 | 167 | 154 | 145 | 158 | 152 | 142 | 166 | 148 | 143 | 153 | 140 | 157 | 138 | 167 | 135 | 142 | 150 | 155 | 134 | 140 | 172 | 145 | 151.600000 | NaN | NaN | NaN |

| 38 | 24/12/2023 | 158 | 145 | 142 | 168 | 167 | 160 | 165 | 145 | 144 | 166 | 151 | 142 | 157 | 138 | 139 | 158 | 139 | 158 | 171 | 154 | 150 | 156 | 149 | 168 | 154 | 145 | 158 | 152 | 142 | 166 | 148 | 143 | 153 | 140 | 157 | 138 | 167 | 135 | 142 | 151 | 155 | 134 | 141 | 172 | 145 | 151.733333 | NaN | NaN | NaN |